José Fornari (Tuti) – 31 de julho de 2019

fornari @ unicamp . br

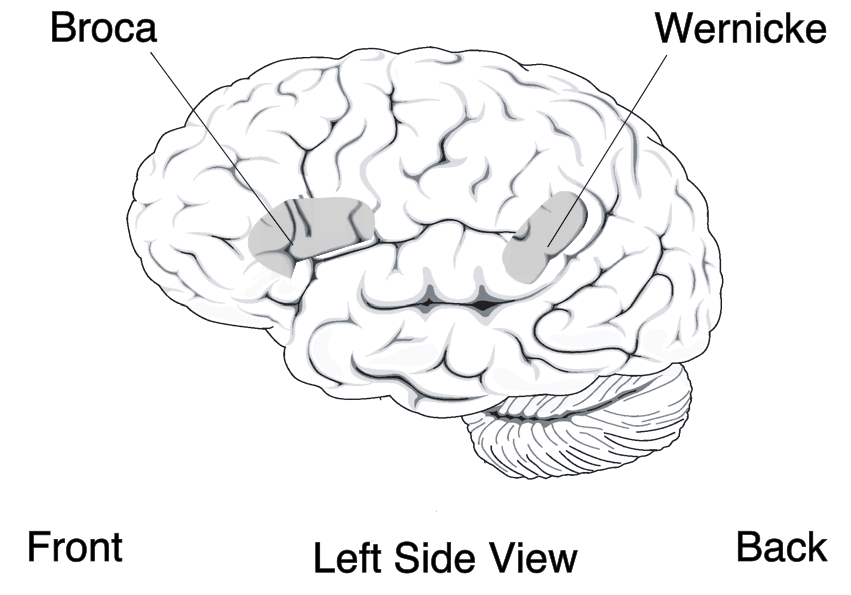

Duas capacidades essencialmente humanas que, apesar de distintas, compartilham recursos do cérebro para o seu processamento, são a linguagem e a música. Não existem registros históricos de comunidades humanas que não tenham apresentado ambas atividades. Duas áreas cerebrais bastante conhecidas (pelo menos desde o século XIX) que sempre estiveram associadas à produção e ao entendimento da linguagem, são as áreas de Broca (relacionada à produção da fala) e Wernicke (relacionada ao entendimento da linguagem). A área de Broca é localizada predominantemente no lobo frontal do hemisfério esquerdo cerebral. Este hemisfério é normalmente associado à produção e ao processamento de informação analítica; o chamado “computador serial”, conforme apelidado pela famosa neurocientista Jill Bolte Taylor, por concentrar diversas atividades cuja informação é organizada em sequências lógicas e ordenadas no tempo, como as habilidades matemáticas, lógicas, dedutivas e a linguagem.

A área de Broca é nomeada em homenagem à Pierre Paul Broca, médico do século XIX que estudou pacientes com lesões nesta área cerebral e que por isso apresentavam incapacidade ou dificuldade de produzir fala ou diversos tipos de sílabas. Já a área de Wernicke recebe o seu nome em homenagem ao neurologista Carl Wernicke, também do século XIX, que realizou diversos estudos com pacientes apresentando “afasia fluente”, ou seja, a incapacidade adquirida de compreender uma linguagem a qual este era fluente antes de lesionar esta área cerebral. Tais pacientes muitas vezes retinham a capacidade de produzir sílabas, palavras e até frases (ou seja, o paciente era capaz de verbalizar uma palavra mas era incapaz de entender o seu significado). A área de Wernicke mais estudada é também localizada no lobo temporal do hemisfério esquerdo. Esta área é relacionada com a capacidade do indivíduo entender o significado direto de uma palavra dentro de um contexto mais explícito e direto (por exemplo, “vir”, como a conjugação do verbo “ir”; como na frase: “sua encomenda deve vir pelo correio”). O correspondente desta área porém no hemisfério direito cerebral (hemisfério este que Jill Bolte Taylor compara a um “computador paralelo” por se relacionar mais com o processamento holístico e não sequencial de informação, como as habilidades artísticas, as capacidades associativas e o raciocínio indutivo) trata da compreensão de significados semânticos ambíguos (por exemplo, “vir”, como a conjugação do verbo “ver”; como na frase: “se você vir ele chegando, me avise”). A área de Broca também possui um correspondente no hemisfério direito cerebral que, apesar de ainda ser pouco estudada, parece estar relacionada a processos onde um paciente, após uma lesão na área de Broca do hemisfério esquerdo, consegue se recuperar da incapacidade de produzir palavras e sílabas (também conhecida como “afasia expressiva”, onde o paciente compreende mas não produz linguagem) através da realocação deste processamento para a área correspondente no hemisfério direito (através do processo conhecido como “neuroplasticidade funcional).

Figura do cérebro humano mostrando as áreas de Broca (produção) e Wernicke (entendimento). Fonte: https://www.nidcd.nih.gov/health/aphasia (https://www.nidcd.nih.gov/sites/default/files/Documents/health/voice/Aphasia6-1-16.pdf

O pesquisador Aniruddh D. Patel (Ani Patel) propôs um modelos teórico de compreensão do processamento cerebral da música e da linguagem, onde estas atividades sonoras, apesar de fundamentalmente distintas, compartilham recursos neurais em seu processamento. Este modelo é conhecido como RSF (Resource Sharing Framework). Neste contexto, as áreas de Broca e Wernicke são utilizadas tanto no processamento da linguagem como no da música. Eu, quando era músico, me lembro que, em muitas ocasiões que estava tocando piano ou teclado, não conseguir falar com facilidade quando alguém queria conversar comigo durante uma performance. Conseguia, com certa facilidade, entender o que a pessoa estava dizendo, mas quase não conseguia responder frases maiores do que “sim” ou “não”. No entanto, é fácil escutarmos música ou linguagem (por exemplo, um comentarista) numa rádio enquanto dirigimos um veículo, sem que isto atrapalhe nossas habilidades ao volante. O mesmo já não ocorre quando se está dirigindo e conversando no celular, o qual, exatamente por este motivo, é proibido em vários países. Ani Patel, com seu modelo RSF, tornou possível o entendimento de dilemas que vinham desafiando pesquisadores sobre a origem e a região do processamento da informação musical no cérebro do ouvinte. O processamento cognitivo de distintas atividades, como o entendimento e a produção de música e linguagem, são realizados pelas mesmas regiões e recursos cerebrais.

Conforme foi tratado anteriormente, no começo da década de 1970, o famoso e renomado maestro e compositor, Leonard Bernstein, apresentou uma série de palestras onde ele tentou explicar a música através de um paralelo que fez com a linguagem, utilizando para isso a gramática universal de Chomsky, onde Bernestein atribui conteúdos semânticos a determinadas estruturas harmônicas e melódicas que agiriam como significante (no sentido semiótico de Saussure). De fato existe um tipo de organização estrutural (ou sintática) na música que, de certa forma, lembra as estruturas gramaticais da linguagem. Os intervalos entre notas ordenadas no tempo (organizados horizontalmente) compõem frases e melodias, bem como os intervalos simultâneos (organizados verticalmente) compõem contrapontos e acordes. No entanto estas estruturas musicais não tem uma atribuição de conteúdo semântico a uma dessas organizações horizontais ou verticais que remeta ao significado de um conceito (objeto), condição (qualidade) ou processo (ação), nem de estruturas em tais organizações que possam ser dispostas sequencialmente de modo recursivo como no caso da linguagem (onde podemos, por exemplo, dizer que “o gato que estava perto do macaco subiu no muro”, onde entendemos sem maiores dificuldades que não foi o macaco mas sim o gato que subiu no muro). A música cumpre outra função na comunicação humana, não tão semântica mas igualmente fundamental, que a meu ver é a de comunicar a expressividade humana, em termos de sentimentos, afetos, emoções e estados de espirito (mood). Tais conceitos expressivos são anteriores à linguagem e fundamentam as estruturas analíticas de entendimento que um indivíduo faz da sua realidade subjetiva e objetiva. Percebemos isso ao vermos processos de polarização social, onde, a partir de um sentimento em comum, uma multidão se alinha numa conclusão intenção similar, mesmo que posteriormente esta se demonstre completamente falsa. Foi assim no fascismo, onde um país como a Alemanha, na época com um dos maiores índices de escolaridade e erudição de sua população, pode convencer milhões de indivíduos a aceitarem e acatarem uma doutrina tão danosa e baseada em fatos tão falaciosos. A música age nesta base estrutural do entendimento humano, na nascente inconsciente do rio de nossos pensamentos conscientes e consequentes ações. Os sentimentos que irão basear e direcionar as conclusões de um indivíduo e de sua sociedade daí vem. É por este motivo que a música, na minha opinião, é tão poderosa, tão sedutora e tão necessária para a humanidade.

Referências:

Jill Bolte Taylor. “My Stroke of Insight: A Brain Scientist’s Personal Journey”. 2006

Harpaz Y, Levkovitz Y, Lavidor M (October 2009). “Lexical ambiguity resolution in Wernicke’s area and its right homologue”. Cortex. 45 (9): 1097–103. doi:10.1016/j.cortex.2009.01.002. PMID 19251255.

Aniruddh D. Patel. “Language, music, and the brain: a resource-sharing framework”. DOI:10.1093/acprof:oso/9780199553426.003.0022. Capítulo do livro: “Language and Music as Cognitive Systems” organizado por Patrick Rebuschat, Martin Rohmeier, John A. Hawkins, e Ian Cross. Print publication date: 2011. Print ISBN-13: 9780199553426. Published to Oxford Scholarship Online: January 2012

Comunicação e semiótica. Signo, significante e significado. http://uegsemiotica.blogspot.com/2013/03/signo-significante-e-significado.html

Como citar este artigo:

José Fornari. “O compartilhamento de recursos cerebrais entre música e linguagem”. Blogs de Ciência da Universidade Estadual de Campinas. ISSN 2526-6187. Data da publicação: 31 de julho de 2019. Link: https://www.blogs.unicamp.br/musicologia/2019/07/31/28/

Recursos cerebrales compartidos entre música y lenguaje

Valeria Tubert (Traductora)

e-mail: valetubert @ gmail . com

13/11/2019

Dos capacidades esencialmente humanas que, a pesar de ser distintas, comparten recursos cerebrales para su procesamiento, son el lenguaje y la música. No existen registros históricos de comunidades humanas sin ambas actividades. Dos áreas cerebrales bastante conocidas que siempre estuvieron asociadas a la producción y al entendimiento del lenguaje,por lo menos desde el siglo XIX, son el área de Broca (relacionada a la producción del habla) y el área Wernicke (relacionada al entendimiento del lenguaje). El área de Broca está predominantemente localizada en el lóbulo frontal del hemisferio cerebral izquierdo. Este hemisferio es normalmente asociado con la producción y el procesamiento de información analítica; es llamado como “computador serial”, según la famosa neurocientífica Jill Bolte Taylor, por concentrar diversas actividades cuya información es organizada en secuencias lógicas y ordenadas en el tiempo, como las habilidades matemáticas, lógicas, deductivas y el lenguaje.

El área de Broca es nombrada así en homenaje a Pierre Paul Broca, médico del siglo XIX que estudió pacientes con lesiones en este área cerebral y que presentaban dificultades o incapacidades a la hora de producir diversos tipos de sílabas o el habla en general. Del mismo modo, el área de Wernicke recibe su nombre en homenaje al neurólogo Carl Wernicke, también del siglo XIX, quien realizó diversos estudios con pacientes que presentaban “afasia fluente”, o sea, una incapacidad adquirida de comprender el lenguaje en el cual se desenvolvían con fluidez antes de lesionarse este área cerebral. Tales pacientes muchas veces retenían la capacidad de producir sílabas, palabras y hasta frases (es decir, eran capaces de verbalizar una palabra), pero habían perdido la capacidad de entender su significado. El área de Wernicke más estudiada también está localizada en el lóbulo temporal del hemisferio izquierdo.

Este área está relacionada con la capacidad del individuo de entender el significado directo de una palabra dentro de un contexto explícito y carente de ambigüedad.

Por otro lado, el correspondiente de ésta área en el hemisferio cerebral derecho (hemisferio que Jill Bolte Taylor compara con un “computador paralelo” por estar relacionado con el procesamiento holístico y no secuencial de información, como las habilidades artísticas, las capacidades asociativas y el raciocinio inductivo) trata de la comprensión de significados semánticos ambiguos.

El área de Broca también posee una región correspondiente en el hemisferio cerebral derecho que, a pesar de aún haber sido poco estudiada, parece estar relacionada con procesos donde un paciente, después de una lesión en el área de Broca (hemisferio izquierdo), consigue recuperarse de la incapacidad de producir palabras y sílabas (también conocida como “afasia expresiva”, ya que el paciente comprende pero no produce lenguaje) a través de la reubicación de este procesamiento para el área correspondiente del hemisferio derecho (proceso conocido como “neuroplasticidad funcional”).

El investigador Aniruddh D. Patel (Ani Patel) propuso un modelo teórico de comprensión del procesamiento cerebral de la música y del lenguaje, donde estas actividades sonoras, a pesar de ser fundamentalmente distintas, comparten recursos neurales en su procesamiento. Este modelo es conocido como RSF (Resource Sharing Framework). En este contexto, las áreas de Broca y de Wernicke son utilizadas tanto en el procesamiento del lenguaje como de la música. Cuando era músico, recuerdo que en muchas ocasiones cuando estaba tocando el piano o el teclado, no lograba hablar con facilidad con alguien durante la performance. Podía, con cierta facilidad, entender lo que la persona estaba diciendo, pero casi que no conseguía responder frases mayores a “si” o “no”. Sin embargo, es fácil escuchar música o lenguaje (por ejemplo, un comentarista) en una radio cuando estamos manejando un vehículo, sin que eso interfiera demasiado en nuestras habilidades al volante. Esto no ocurre cuando se está manejando y conversando por el celular, el cual, exactamente por este motivo, está prohibido en varios países. Ani Patel, con su modelo RSF, hizo posible el entendimiento de dilemas que venían desafiando a los investigadores, siendo éstos el origen y la región del procesamiento de la información musical en el cerebro del oyente. El procesamiento cognitivo de distintas actividades, como el entendimiento y la producción de música y de lenguaje, son realizados por las mismas regiones y recursos cerebrales.

Como fue tratado anteriormente, en el comienzo de la década de 1970, el famoso y renombrado maestro y compositor, Leonard Bernstein, dio una serie de charlas donde intentaba explicar la música a través de un paralelismo con el lenguaje, utilizando para eso la gramática universal de Chomsky, donde Bernstein atribuía contenidos semánticos a determinadas estructuras armónicas y melódicas que actuarían como significante (en el sentido semiótico de Saussure). De hecho, existe un tipo de organización estructural (o sintáctica) en la música que, de cierta forma, hace recordar a las estructuras gramaticales del lenguaje. Los intervalos entre notas ordenadas en el tiempo (organizados horizontalmente) componen frases y melodías, así como los intervalos simultáneos (organizados verticalmente) componen contrapuntos y acordes. Sin embargo, estas estructuras musicales no tienen atribuido un contenido semántico en esas organizaciones horizontales o verticales que remita al significado de un concepto (objeto), condición (cualidad) o proceso (acción), ni existen estructuras en tales organizaciones que puedas ser dispuestas secuencialmente de modo recursivo como en el caso del lenguaje (donde podemos, por ejemplo, decir que “el gato que estaba cerca del mono trepó el muro”, donde entendemos sin mayores dificultades que no fue el mono sino el gato quien trepó el muro).

La música cumple otra función en la comunicación humana, no tan semántica pero igualmente fundamental, que a mi parecer es la de comunicar la expresividad humana, en términos de sentimientos, afectos, emociones y estados del espíritu (“mood”). Tales conceptos expresivos son anteriores al lenguaje y fundamentan las estructuras analíticas del entendimiento que un individuo hace sobre su realidad subjetiva y objetiva. Nos damos cuenta de eso cuando vemos procesos de polarización social, donde, a partir de un sentimiento en común, una multitud se alínea en una conclusión de intención similar, incluso si posteriormente ésta se demuestra completamente falsa.

Fue así durante el fascismo, donde un país como Alemania, que en la época tenía uno de los mayores índices de escolarización y erudición de su población, pudo convencer a millones de individuos de aceptar y acatar una doctrina tan dañina y basada en hechos completamente falaces. La música actúa en esta base estructural del entendimiento humano, en la primavera inconsistente del río de nuestros pensamientos conscientes y consecuentes acciones. Los sentimientos que irán siendo la base y dirección de las conclusiones de un individuo y de su sociedad vienen de ahí. Es por este motivo que la música, en mi opinión, es tan poderosa, tan seductora y tan necesaria para la humanidad.