Pensamento Computacional e gênero

Algumas semanas atrás fui desafiado pelo professor Mauricio Rosa, da Faculdade de Educação da Universidade Federal do Rio Grande do Sul, a enxergar na Matemática como um canal para a não-exclusão (sim, foi uma palestra um tanto atípica mas enriquecedora).

Um aspecto que aprendi e vale muito a pena compartilhar, é que a não-exclusão não seja sinônimo de inclusão. Visto que a inclusão só é necessária em ambientes que excluem, enquanto a ideia da não-exclusão é que o ambiente não exclua, não sendo necessário assim um movimento de inclusão.

Podemos pensar no ambiente das partidas de Xadrez online como um local de não-exclusão. Não sabemos quase nada contra quem estamos jogando, no máximo o nickname, a nacionalidade informada e o índice de vitórias do participante. Neste ambiente talvez o principal fator de exclusão seja a habilidade de jogar xadrez, mas até isto parece ocorrer de maneira sutil, já que as partidas geralmente são alocadas contra oponentes com índices de vitórias próximos. Ainda assim, há fatores de inclusão quanto a habilidade de jogar xadrez, já que é possível conferir algumas vantagens aos jogadores com menor índice de vitórias afim de equilibrar o desafio da partida a ambos.

Enfim, respondendo ao desafio do professor Mauricio Rosa, decidi escrever este post sobre Pensamento Computacional e gênero.

Quando estudamos o Pensamento Computacional na visão de Jeannette Wing, entendemos que se refere à forma como Cientistas da Computação procuram resolver seus problemas tendo recursos computacionais à sua disposição. Envolve entender que há ações das quais o ser humano realiza melhor que o computador, mas também, ações das quais o computador realiza melhor que o ser humano. Basta pensarmos na dificuldade de um computador manter um diálogo coerente em um simples chat bot, se comparado a dificuldade de um ser humano operacionalizar uma planilha com milhares de células. Deste modo, a combinação das capacidades do ser humano com o uso adequado de recursos computacionais, corresponderia a melhor maneira de resolver uma ampla gama de problemas.

Há de termos em mente que administrar quanto da tarefa será designada aos seres humanos e quanto será designada aos computadores, é o Pensar Computacionalmente. Assim, vamos a um aplicativo que a poucos meses estava viral na internet, o FaceApp.

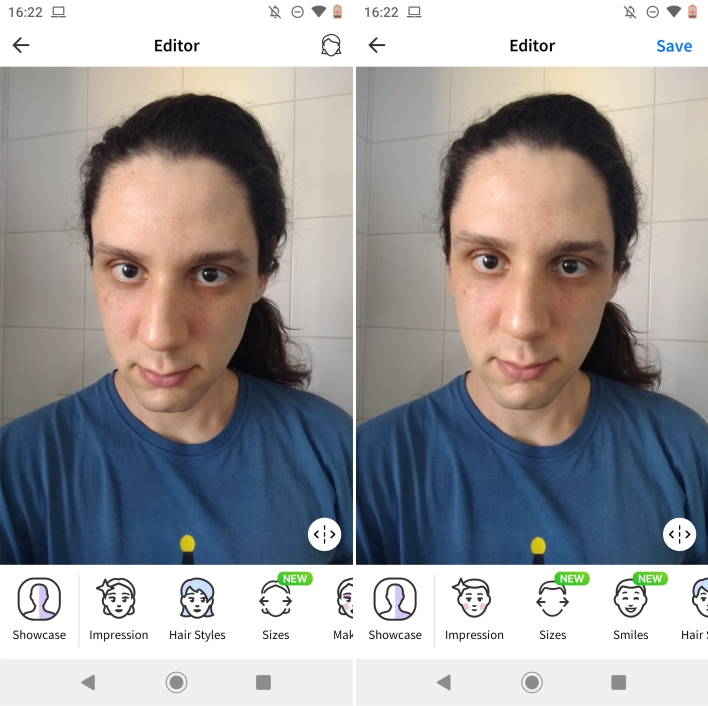

Ele é um aplicativo legal para pensarmos em cortes de cabelo, se tingimos o cabelo, se deixamos a barba crescer, permite facilmente e com razoável qualidade, alterarmos fotos para pré-visualizarmos algumas mudanças. Mas é claro, o aplicativo não é perfeito e nem deveria ser. Digo que em algums fotos pode sequer detectar a presença de uma pessoa, ou em outras, junto com seu cabelo, arrancar parte da sua cabeça. Enfim, alguns contratempos que não valeriam em termos de complexidade de software, corrigí-los, dado que na maioria das vezes gera um resultado satisfatório.

Contudo, dentro desta ideia de resultado satisfatório, há uma característica do aplicativo. Assim que uma foto é carregada, o software procura decidir com base em características da imagem, se a paleta de funcionalidades inicialmente estará com o perfil masculino ou feminino. Uma função que talvez a maioria dos usuários utilize sem sequer pensar em que se baseou esta decisão. Afinal, não nos foi dada uma opção para marcar com nossas habilidades de ser humano, qual perfil de ferramentas achamos apropriado para editar esta imagem.

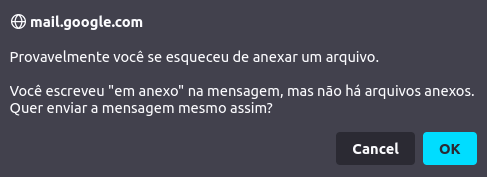

Provavelmente durante a fase de desenvolvimento, imaginaram que esta falta de opção seria menos prejudicial do que o excesso de opções. Ou seja, que mais usuários prefeririam que o software tomasse esta decisão automaticamente todas as vezes, do que terem um botão a mais para apertar antes de começarem a editar a foto. É até que natural pensarmos assim, o próprio Gmail nos avisa sem pedirmos, caso tenha no corpo do e-mail a expressão “segue em anexo”, e não ter nenhum anexo inserido.

Enfim, talvez a maioria das pessoas que escreva um e-mail dizendo “em anexo” mas que não anexaram arquivo nenhum, realmente queiram anexar um arquivo, mas tenham se esquecido. Logo, a pequena parcela da população que envia e-mails dizendo “em anexo” sem que realmente queiram anexar nada, precisarão ter o envio do e-mail consultado por esta caixa de diálogo. O computador neste caso está fazendo o que parecia ser a melhor decisão para a maioria dos usuários.

Daí chegamos na questão de gênero, voltando para o software FaceApp, ele inicialmente apresenta a interface de ferramentas com perfil masculino ou feminino automaticamente. Com base em aspectos bem sutis da foto. Mas tão sutis que desafio a quem está lendo, ver as duas fotos minhas logo abaixo e responder, em que o software decidiu exibir para a foto da esquerda o perfil feminino e para a da direita o perfil masculino?

No caso, precisamos entender como que o software sabe avaliar as pessoas. O mais provável neste caso, é que ele utilize uma técnica de inteligência artificial de Aprendizagem de Máquina. Assim, o software desenvolvido inicialmente pegaria um grande número de características da imagem e tenta identificar o que seria o nariz, olhos, boca… a partir dessas referências ao que seria um rosto, toma as outras medidas observáveis, mas ainda não faz nenhuma avaliação.

Para avaliar se atribui o status da foto como feminina ou masculina, o software precisa entender o significado destas duas palavras. Mas estas já são palavras complexas até para os seres humanos conseguirem explicar com clareza e objetividade, quem diria explicá-las para um software. A ideia neste caso mais provável, é que o software tenha sido calibrado a partir de uma grande base de dados com fotos de pessoas já rotuladas como femininas ou masculinas. Neste processo, o software tenta aprender como relacionar estas medidas observadas do rosto com os rótulos das fotos. De modo, que ao final deste treinamento, o software sabe de maneira satisfatória usar as medidas observadas dos rostos das pessoas para acertar se atribui a ela o rótulo feminino ou masculino.

Mas tenhamos em mente que o software não sabe o que são estes dois rótulos, ele apenas entende que após um certo valor deve atribuir um rótulo específico. Esse processo de verificar as medidas e dar os rótulos, o computador faz de maneira exímia e impecável! O problema entretando está nas fotos que não faziam parte do banco de dados inicial.

O software neste caso, está se baseando naquilo que aprendeu durante seu treinamento, e procura da melhor maneira acertar os rótulos como foi programado para fazer. Mas o que separa uma medida de outra? Como avaliar as medidas próximas da divisória entre os rótulos? Se separarmos pessoas por altas e baixas, seria correto dizer que alguém de 1,50 m é baixa enquanto outra pessao de 2,00 m é alta. Mas e os valores intermediários? 1,69 m é baixa? 1,70 é alta? Qual é a linha tênue que separa estes dois rótulos? Não há sentido dizer que 1 cm separa uma pessoa alta de uma pessoa baixa. O ideal seria criarmos categorias intermediárias. Assim, com o aumento das categorias de altura passa a ter mais sentido dizer que alguns centímetros separam uma categoria da outra, ainda que tenhamos o mesmo problema caso reduçamos a diferença para 1 mm.

Com isso, podemos ver que mesmo para altura, que nos parece uma medida clara do ser humano, já é subjetivo criarmos rótulos.

No caso do software, ele separa as pessoas em feminino e masculino a partir de medidas, e precisa tomar esta decisão mesmo quando as diferenças entre categorias é mínima, como ocorre nas minhas duas fotos mostradas anteriormente.

Enfim, a razão do software ter duas categorias provém de um conjunto de ferramentas para editar a imagem ter sido calibrada inicialmente para apenas duas categorias.

Bom, agora que entendemos um pouco do funcionamento do aplicativo FaceApp quando carregamos uma nova foto, podemos perceber que a “escolha automática” entre feminino e masculino é um elemento de exclusão das minorias. Pois assim como no Gmail, não esperam que os usuários enviem e-mails dizendo “em anexo” mas intencionalmente sem anexo, neste aplicativo esperam que os usuários na maioria das vezes se sintam representados por esta escolha automática.

Uma questão que poderia ser minimizada com uma opção inicial para o usuário escolher entre a opção feminino ou masculino logo após subir uma foto. Mas isto ainda não resolveria o problema de exclusão das minorias, dado que restringe a pessoa a escolher uma das duas opções, ignorando outras. Neste sentido podemos pensar que a restrição de opções tenha como razão o melhor ajuste das fotos, dentro das modificações que o software realiza baseado naquele imenso banco de dados utilizado para aprender como mexer com rostos humanos.

Para concluir, veja que a exclusão proporcionada pelo software pode ser minimizada com a simples pergunta sobre qual opção o usuário deseja para aquela foto. Uma situação que se assemelha muito ao nosso dia a dia como seres humanos, que ao conhecermos uma nova pessoa usualmente economizamos a pergunta “prefere que eu me refira a você com qual pronome?”.

Apesar de simples, isto evita que façamos todo um processo de avaliação baseado em aspectos visuais para determinar qual rótulo daremos para a pessoa, ao mesmo tempo que também deixa de excluir a quem nos referimos visto que não somos tão restritos como as ferramentas de um software.

Espero que tenha gostado deste post 🙂 e que a reflexão possa de algum modo favorecer o uso da Matemática como um canal para a não-exclusão.

Créditos da imagem de capa à Gerd Altmann por Pixabay

Como referenciar este conteúdo em formato ABNT (baseado na norma NBR 6023/2018):

SILVA, Marcos Henrique de Paula Dias da. Pensamento Computacional e gênero. In: UNIVERSIDADE ESTADUAL DE CAMPINAS. Zero – Blog de Ciência da Unicamp. Volume 6. Ed. 1. 2º semestre de 2021. Campinas, 04 nov. 2021. Disponível em: https://www.blogs.unicamp.br/zero/3542/. Acesso em: <data-de-hoje>.

Marcos, estou honradíssimo com este post. Sabe quando você recebe um presente maravilhoso de surpresa? Assim que estou me sentindo. Sua reflexão é excelente. Por favor, me envie um email, quero lhe fazer um convite. Parabéns pela excelente reflexão e avanço.

Boa noite professor, fico muito feliz que tenha gostado dessa “resposta” à sua palestra.

Eu que me senti honrado com a discussão e de certo modo inquieto com o desafio 🙂

Já lhe enviei um e-mail, vamos conversando

Muito boa a provocação Marcos, talvez o FaceApp (para não sairmos do campo de softwares e gêneros) poderia adotar uma medida não-excludente apenas não levando em conta qual o gênero a pessoa se identifica, perguntando somente qual gênero ela quer ver sua foto “transformada”.

Assim, seria necessário as demais opções de gêneros para a “transformação” e com isso um banco de dados maior para “deduzir as medidas” de cada gênero.

Porém, quem define que determinado gênero tem uma “medida x”? Só porque talvez uma maioria tem semelhanças isso define e rotula todes?

Belezas e medidas relacionadas ao gênero são construções sociais. Como desconstruir isso usando um app que “pensa” computacionalmente?

Apesar disso, o app “viralizou”, talvez os criadores tenham atingido seus objetivos, até porque a criação de um app costuma ter um viés mercantilista, mas isso é outra discussão (ou não).

As respostas eu não tenho, venho trazer o debate.

Mais uma vez, excelente texto. Obrigado!

Boa noite Artur, o reconhecimento automático do FaceApp não tem a função de transformar o rosto, há uma opção específica do FaceApp com a função “trocar o gênero” (embora o nome não seja apropriado, atinge os objetivos de explicar sua função para a maioria dos usuários).

O fato de reconhecimento automático é inerente à foto que você suba. No caso, posso pegar uma foto de terceiros e subir no aplicativo. Deste modo não há uma questão de “como você se identifica” já que podemos ter fotos que não sejam apenas suas.

Sobre o atendimento à todos os gêneros quanto ao aplicativo, sinto que caímos num problema de determinar perfis minoritários na sociedade, que justamente por serem minoritários, seria então mais difícil formar uma base de dados inicial (por exemplo, o conjunto dos homens cis que tiveram ruptura labiopalatal).

Sobre a desconstrução da construção social possível através do aplicativo, enxergo que ao disponibilizar os “kits de ferramentas” para a escolha do usuário, permita que a pessoa determine qual ela deseja utilizar. Por exemplo, no boliche, você que escolhe entre uma bola 12 ou 13, depende de qual vc se sente melhor jogando… mas por outro lado, aumentar o número de escolhas dos usuários afetaria também a complexidade de uso, o que poderia levar o aplicativo a não ser viral.

É uma negociação complexa quando pensamos no viés mercantilista. Tão somente a pergunta “entre as ferramentas da pessoa de cabelo curto (masculino) e de cabelo comprido (feminino), qual você prefere utilizar?” já seria ao meu ver, um redutor de não-exclusão.

A ideia principal que tentei trazer neste texto, é como este tema é bastante complexo de ser corrigido no viés de um software, enquanto que no viés das interações humanas é bastante simples de ser inquerido e respeitado ao início de um diálogo.

Olá Marcos!

Gostei bastante de ler seu post… bem bacana a reflexão.

Fiquei imaginando, especialmente por ser (neste momento) uma mulher de cabelo curto, se oferecer a opção do “tipo de cabelo” ao invés de “trocar gênero” não seria mais adequada ao pensarmos em não-exclusão. Em diversas situações que geram exclusão, sinto que a questão surge ao oferecer opções para “diferenças” que não são de fato relevantes e que excluem. Sei que aqui estamos falando de um app que quer fazer sucesso, mas não interessa seu gênero, interessa o tipo de cabelo que você quer testar!

Sinto que essa percepção seria benéfica em diversas situações. Enfim, só queria parabenizar e manter a conversa!

Bom dia Rita, realmente sua colocação é bem interessante.

Envolveria no caso “conhecermos” quais foram os aspectos considerados na hora de calibrar o App. Talvez o mais adequado pensando na não-exclusão, fosse associar as características comuns para N fotos sem antes atribuir nenhum rótulo, e a partir daí fazer uma análise fatorial para determinar quais elementos melhor se ajustam em cada foto. Daí fazer uma interpretação do que estes dados representam… por exemplo:

Variáveis A, B e C estão ligados à largura do rosto // Rótulo atribuído: cara de trakinas!

Enfim, conhecendo melhor o que o software considera para fazer suas modificações e a forma como foi treinado, poderíamos dizer com maior clareza o peso que o “cabelo comprido” ou o “cabelo curto” tem na decisão tomada.

Gostei do post, sir 🙂

Acho que isso está relacionado à questão maior que é a tendência que temos de colocar tudo em categorias, mesmo que a variação seja contínua. Altura é algo que varia continuamente, e qualquer classificação vai ser arbitrária, a não ser que diga respeito a um fim específico. Por exemplo, uma comissária de bordo talvez precise ter uma altura mínima que lhe permita abrir e fechar os compartimentos de bagagem, e também não deva exceder uma altura máxima para poder andar confortavelmente pelo avião, sem precisar se abaixar ou se curvar. Neste caso, existe um critério claro: o limite de altura para alcançar os compartimentos e para não precisar se curvar, definido pelas características estruturais do avião. Mas fora deste contexto, a operacionalização de “baixo” e “alto” já não funciona.

Similarmente, acho que gênero é algo não necessariamente categorizável, e também é algo multidimensional. Existem pessoas que se enquadram bem nas características consideradas típicas de um gênero, mas outras pessoas não; e pensando biologicamente – mesmo que a presença de um cromossomo Y é algo categórico (existe ou não existe), as outras características fisiológicas, tais como, sei lá, produção de testosterona variam continuamente.

E me faz pensar se precisamos mesmo categorizar sempre. Qual é a necessidade de saber o gênero de uma pessoa? Depende do contexto. Por exemplo, em uma avaliação institucional de participação em programas de iniciação científica, pode ser interessante para, por exemplo, detectar a exclusão de pessoas de um gênero de tais atividades. Em outros casos, talvez não seja algo tão relevante. E em alguns casos, talvez a simples pergunta gere algum tipo de exclusão e possa ser evitada – por exemplo quando uma pessoa não se sente confortável com seu gênero ou por algum motivo não queira responder isso e ser classificada em “homem” ou “mulher”).

(E me faz pensar também em produtos como… Capacete feminino. Faixa de cabelo feminina. Não acho que a estrutura craniana difira suficientemente entre os sexos pra ter essa categorização 🙂 )

Realmente sir, colocar em categorias tem suas importâncias e definir limites tem propósitos. Quando não há uma distinção ou um objetivo para esta categorização, ela realmente se faz desnecessária ou opcional, a depender da pessoa querer ser ou não categorizada. Definir pessoas dentro de categorias nos parece tão usual, mas somos seres humanos, lidamos bem com padrões variados e subjetivos… diferente do computador que precisa ser programado e treinado dentro de métricas (logo, categorias).

Vejo que a pergunta sobre “prefere que eu me refira a você com qual pronome?” acho que não chega a ser excludente. Pois a pessoa pode escolher o pronome (mesmo que a outra pessoa não saiba conjugar os verbos neste pronome não-binário … mas ai é um outro problema).

No sentido de identificar exclusões a partir de categorizações, acho totalmente válido o uso de quaisquer categorias para este fim. Inclusive a questão de altura, peso, número de sapato, mês do aniversário… se alguma categorização permite identificar um elemento que está excluindo as pessoas, podemos pensar em estratégias para que esta exclusão deixe de ocorrer ou ao menos diminua.

Quanto a questão de lógica comercial, isso não tem regras… tipo, o dia que perceberem que objetos com estampa de abacate e que fazem um assobio quando você se aproxima vendem mais, vc verá capacetes e faixas de cabelo com estampas de abacates e que assobiam quando você se aproxima 🙂

Parabéns pela reflexão Marcos. Excelentes apontamentos.

Obrigado Valdinei 🙂