Além do Mito da Neutralidade: A Sócio Tecnicidade da Inteligência Artificial

Por José Victor Rodrigues Catalano

José Victor Rodrigues Catalano possui graduação em Administração e mestrado em Ciência, Tecnologia e Sociedade (UFSCar). Atualmente, está cursando doutorado em Economia na UNESP, no qual desenvolve uma pesquisa focada na inteligência artificial e nos desafios relacionados à governança tecnológica.A Inteligência Artificial (IA) constitui um campo voltado à simulação de capacidades humanas por meio de sistemas tecnológicos (Luger, 2025). Profissionais de diversas áreas são responsáveis por projetar algoritmos e desenvolver infraestruturas capazes de processar grandes volumes de dados — big data — ampliando as fronteiras da automação e da tomada de decisão computacional (Mitchell, 2019).

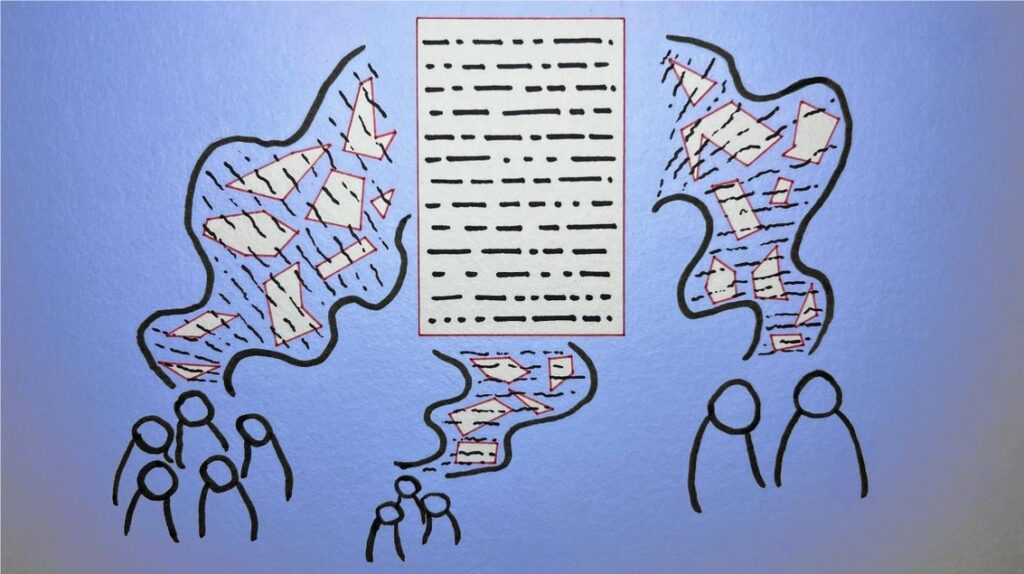

Embora frequentemente apresentada sob uma ótica técnica e neutra, a IA resulta de arranjos sociotécnicos complexos que desafiam visões deterministas e lineares de progresso tecnológico (Catalano, 2023). Sua construção envolve decisões humanas opacas permeadas por interesses, valores e disputas, revelando uma escolha sociotécnica — sujeita à crítica, à contestação e à reorientação.

A IA embora apresentada como neutra e técnica, é fruto de decisões humanas imersas em contextos sociais e políticos, enquanto seus processos internos permanecem opacos, tornando invisíveis as escolhas que moldam suas saídas.

A (des)construção da objetividade científica e tecnológica

Daston e Galison (2007) demonstram que o ideal de objetividade científica foi construído ao longo dos séculos como um padrão epistemológico orientado à exclusão de julgamentos subjetivos e vieses pessoais nos processos de produção do conhecimento. Esse ideal foi, posteriormente, transferido ao campo tecnológico, originando uma “estética da neutralidade” que confere aos artefatos técnicos a aparência de imparcialidade e confiabilidade.

No âmbito da IA, essa estética atua como uma retórica poderosa de legitimação de decisões automatizadas, apresentadas como desprovidas de valores ou interesses humanos, o que contribui para a naturalização e aceitação social desses sistemas. A crença na racionalidade e objetividade dos sistemas de IA consolidou-se, assim, como um mito institucional que orienta decisões organizacionais e políticas públicas frequentemente dissociadas de avaliações críticas quanto aos seus impactos sociais e distributivos (Rudko et al., 2025).

Essa mitificação não resulta apenas de desconhecimento técnico, mas também de uma estratégia discursiva que, ao atribuir neutralidade às tecnologias, naturaliza a adoção de sistemas que viabilizam práticas como a coleta massiva de dados, a apropriação do trabalho implícito dos usuários e a automação em larga escala de decisões (Catalano, 2023), gerando impactos diretos sobre a criação de valor econômico e o controle informacional por parte de corporações e instituições.

A lente crítica dos Estudos de Ciência, Tecnologia e Sociedade

Nesse contexto, a perspectiva dos Estudos de Ciência, Tecnologia e Sociedade (CTS) oferece uma lente crítica essencial para desmistificar o mito da “neutralidade algorítmica da IA”. Latour (2012) desenvolve o conceito de híbridos sociotécnicos para caracterizar os sistemas tecnológicos como artefatos resultantes da articulação inseparável entre elementos humanos e não humanos, dissolvendo a dicotomia entre o técnico e o social.

Assim, a IA não pode ser compreendida como entidade autônoma ou neutra, mas como produto de redes complexas — sociotécnicas — que envolvem desenvolvedores, usuários, dados, infraestruturas, normas e instituições, nas quais decisões são tomadas à luz de interesses, valores e disputas normativas (Catalano, 2023). Essa abordagem evidencia que algoritmos são construções políticas e sociais, imersas em redes de poder e conhecimento, cuja aparente objetividade mascara processos contínuos de negociação e conflito.

A mitificação da autonomia algorítmica sustenta a ilusão de que os sistemas de IA operam como entidades autossuficientes, capazes de tomar decisões objetivas e desvinculadas dos contextos institucionais e sociais. Na prática, tais algoritmos resultam de escolhas técnicas e políticas, baseados em dados historicamente situados e continuamente ajustados por atores humanos (Catalano, 2023).

Empresas e instituições, nesse cenário, frequentemente adotam soluções algorítmicas não com base em sua eficácia comprovada, mas como forma de sinalizar inovação, modernização ou conformidade com expectativas externas e regulatórias (Rudko et al., 2025). Essa lógica é intensificada pela centralidade das grandes empresas de tecnologia, que moldam padrões técnicos e normativos em escala transnacional (Zuboff, 2019).

Consequentemente, a difusão dessas tecnologias é impulsionada por pressões reputacionais e de conformidade, em detrimento de análises críticas de seus efeitos sociais, éticos e distributivos. A partir da óptica dos CTS, esse processo evidencia como o discurso da objetividade tecnológica opera como instrumento de poder, legitimando práticas de exploração e despolitizando os processos de desenvolvimento e governança tecnológica.

A IA não é neutra nem autônoma: sob a aparência de objetividade, esconde escolhas historicamente situadas, interesses institucionais e relações de poder.

Autores dos CTS (Latour, 2000; Suchman, 2006; Collins e Pinch, 2014) destacam que os valores orientadores do “fazer” científico e tecnológico não são universais, mas resultados de disputas entre grupos sociais, culturais e geopolíticos diversos. A partir de uma análise interseccional, torna-se evidente que os sistemas algorítmicos frequentemente reproduzem e amplificam desigualdades estruturais e sociais.

O’Neil (2016) demonstra que algoritmos baseados em big data reforçam desigualdades pré-existentes ao estabelecer ciclos de retroalimentação que perpetuam disparidades em decisões automatizadas. De forma complementar, Benjamin (2019) revela que a suposta neutralidade técnica desses sistemas encobre a incorporação desses vieses nas arquiteturas algorítmicas. Noble (2018), por sua vez, evidencia o papel desses algoritmos na reprodução de estereótipos e práticas discriminatórias, enquanto Aumüller-Wagner (2019) demonstra como as decisões automatizadas internalizam esses vieses estruturais.

Na mesma direção, Buolamwini (2023) mostra que o desenvolvimento e a implementação da IA frequentemente refletem preconceitos sistêmicos, contribuindo para a exclusão de grupos historicamente marginalizados. De maneira convergente, Eubanks (2018) revela como ferramentas tecnológicas avançadas segmentam, policiam e penalizam populações vulneráveis, aprofundando desigualdades socioeconômicas já existentes.

Coletivamente, essas contribuições sublinham a urgência de abordagens críticas e inclusivas capazes de confrontar os múltiplos vieses presentes nas tecnologias algorítmicas, promovendo soluções mais justas e equitativas.Além dos vieses interseccionais, outro desafio relevante diz respeito à forma como tais sistemas são governados e auditados. O fortalecimento dos regimes de governança algorítmica intensificou dificuldades relacionadas à responsabilização e transparência. Ananny e Crawford (2018) identificam uma “lógica da opacidade” nos sistemas automatizados, que dificulta o rastreamento das decisões e a identificação de seus responsáveis.

Essa opacidade possui dimensões técnicas e políticas, envolvendo desde decisões de projeto até estruturas de poder e interesses corporativos que limitam o escrutínio público (Crawford, 2021). A governança algorítmica, portanto, não deve ser concebida apenas como um desafio técnico, mas como uma questão democrática central em sociedades cada vez mais mediadas por sistemas digitais.

As tecnologias algorítmicas, sob a fachada da neutralidade, reproduzem antigos regimes de poder e exclusão; quem tece o código também define quem é desfeito por ele.

A importância à crítica da neutralidade

À luz dessas perspectivas, torna-se evidente que a IA não deve ser abordada como força autônoma que impõe transformações à sociedade, mas como fenômeno sociotécnico (Catalano, 2023). Isso implica reconhecer os múltiplos atores implicados em sua concepção e implementação, bem como os conflitos e interesses que moldam suas trajetórias, usos e consequências.

A crítica dos CTS revela os fundamentos sociopolíticos que estruturam os sistemas algorítmicos, oferecendo instrumentos teóricos e metodológicos para reconfigurar os marcos normativos que orientam sua concepção, operação e regulação. Essa abordagem desloca o foco analítico das propriedades técnicas dos artefatos para os contextos em que são produzidos e legitimados, rompendo a dicotomia entre técnica e sociedade, e evidenciando que toda decisão tecnológica é atravessada por valores, interesses e disputas normativas.

As abordagens interdisciplinares discutidas ao longo do texto sustentam que a concepção e a governança da IA devem estar ancoradas na deliberação democrática, na pluralidade epistêmica e na participação ativa de diversos atores sociais. Princípios como justiça social, equidade epistêmica e diversidade cultural não devem ser considerados complementares, mas sim centrais em todas as etapas do ciclo de desenvolvimento e regulação dessas tecnologias.

Sob essa perspectiva, a crítica à neutralidade algorítmica não se limita a uma demanda ética ou acadêmica — ela assume o caráter de uma exigência democrática fundamental, à medida que a IA se consolida como vetor de reconfiguração das estruturas sociotécnicas de poder, das formas de cidadania e dos arranjos institucionais que moldam a vida social contemporânea.

Referências

ANANNY, Mike.; CRAWFORD, Kate. Seeing without knowing: Limitations of the transparency ideal and its application to algorithmic accountability. New Media & Society, v. 20, n. 3, p. 973–989, 2016. Disponível em: https://doi.org/10.1177/1461444816676645.

AUMÜLLER-WAGNER, Sophia. Encoded Bias in Recruitment Algorithms: A practical, intersectional approach to fairness in Machine Learning Algorithms. Excellent Student Paper Series: STS Encounters, [s. l.], 2019. Disponível em: https://www.dasts.dk/wp-content/uploads/Sophia-Aumueller-Wagner_2019.pdf.

BENJAMIN, Ruha. Race After Technology: Abolitionist Tools for the New Jim Code. Cambridge: Polity Press, 2019.

BUOLAMWINI, Joy. Unmasking AI: My Mission to Protect What Is Human in a World of Machines. Nova Iorque: Random House, 2023.

CATALANO, José V. R. Inteligência Artificial e Teoria Ator-Rede em diálogo: analisando atores e associações. 2023. Dissertação (Mestrado em Ciência, Tecnologia e Sociedade) – Universidade Federal de São Carlos, São Carlos, 2023. Disponível em: https://repositorio.ufscar.br/handle/20.500.14289/18866.

CRAWFORD, Kate. Atlas of AI: Power, Politics, and the Planetary Costs of Artificial Intelligence. New Haven: Yale University Press, 2021

COLLINS, Harry M.; PINCH, Trevor. The Golem at Large: What You Should Know about Technology. Cambridge: Cambridge University Press, 2014.

DASTON, L.; GALISON, P. Objectivity. Nova Iorque: Zone Books, 2007.

LATOUR, Bruno.; Ciência em Ação: Como seguir cientistas e engenheiros sociedade afora. São Paulo: Editora UNESP, 2000.

LATOUR, Bruno. Reagregando o Social: uma introdução à Teoria do Ator-Rede. Bauru: EDUSC, 2012.

LUGER, George. F. Artificial Intelligence: Principles and Practice. Cham: Springer Nature, 2025.

MITCHELL, Melanie. Artificial Intelligence: A Guide for Thinking Humans. Nova Iorque: Farrar, Straus and Giroux, 2019.

NOBLE, Safiya U. Algorithms of Oppression: How Search Engines Reinforce Racism. Nova Iorque: New York University Press, 2018.

O’NEIL, Cathy. Weapons of Math Destruction: How Big Data Increases Inequality and Threatens Democracy. Nova Iorque: Crown, 2016.

RUDKO, Ihor; BONAB, Aysan B.; FEDELE, Maria; FORMISANO, Anna V. New institutional theory and AI: toward rethinking of artificial intelligence in organizations. Journal of Management History, v. 31, n. 2, p. 261-284, 2025. Disponível em: https://biopen.bi.no/bi-xmlui/handle/11250/3129186.

SUCHMAN, Lucy. Human-Machine Reconfigurations: Plans and Situated Actions. Cambridge: Cambridge University Press, 2006.

EUBANKS, Virginia. Automating Inequality: How High-Tech Tools Profile, Police, and Punish the Poor. Nova Iorque: St. Martin’s Press, 2018.

ZUBOFF, Shoshana. A Era do Capitalismo de Vigilância: A Luta por um Futuro Humano na Nova Fronteira do Poder. Rio de Janeiro: Editora Intrínseca, 2019.

0 comentário