O que faz um artigo científico ser um bom artigo científico?

Assim, um bom artigo científico é aquele que, presumivelmente: a) apresenta uma proposta ousada, inovadora, inédita e de grande importância; b) faz uso de metodologias experimentais muito bem aceitas e que comprovadamente podem fornecer evidências contundentes se tal proposta é válida ou não, e; c) se a proposta em questão foi verificada.

Quando o artigo “Self-Sustained Replication of an RNA Enzyme” foi publicado na revista Science há pouco mais de 1 ano (27 de fevereiro de 2009), causou um enorme alarde na comunidade científica do mundo todo e foi amplamente divulgado na World Wide Web (internet).

Qual a proposta do artigo? Segundo os autores

A long-standing research goal has been to devise a nonbiological system that undergoes replication in a self-sustained manner, brought about by enzymatic machinery that is part of the system being replicated. One way to realize this goal, inspired by the notion of primitive RNA-based life, would be for an RNA enzyme to catalyze the replication of RNA molecules, including the RNA enzyme itself.

This has now been achieved in a cross-catalytic system involving two RNA enzymes that catalyze each other’s synthesis from a total of four component substrates.

(Traduzindo: Um objetivo científico há muito tempo buscado seria de se constituir um sistema não-biológico que realiza replicação de maneira auto-sustentada, formado por um maquinário enzimático que é parte do sistema sendo replicado. Uma maneira de atingir este objetivo, tendo como inspiração o conceito de vida primitiva baseada em RNA [ácido ribonucléico], seria uma enzima do tipo RNA que catalisasse a replicação de moléculas de RNA, incluindo a replicação da própria enzima.

Isso foi realizado em um sistema catalítico cruzado com duas enzimas de RNA que catalisam a síntese uma da outra a partir de quatro substratos diferentes.)

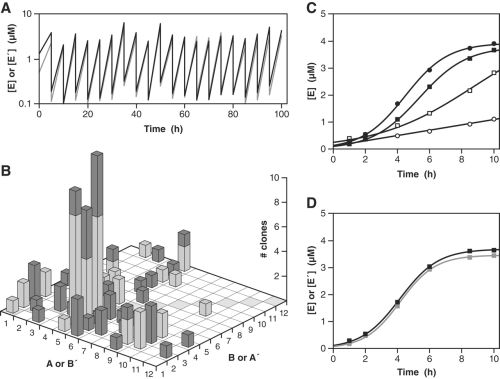

Os autores utilizaram uma enzima RNA chamada de R3C e, após formar um complexo enzimático cruzado, estabeleceram as condições para que as enzimas se auto-replicassem sem qualquer interferência externa. Após o consumo inicial das unidades que constituem o RNA (citidina-guanosina, adenosina-uridina), as enzimas formadas foram transferidas para um novo meio reacional contendo quantidades adicionais das suas unidades formadoras. Tal procedimento foi repetido várias vezes, de maneira seqüencial. Assim, as enzimas RNA continuaram a crescer e adquirir sequências de pares C-G, U-A cada vez maiores. Porém, o mais interessante é que as enzimas formadas não se formam na mesma proporção. Algumas sequências são formadas mais rapidamente e crescem mais, dando origem a fragmentos mais longos, e, portanto, são enzimas de RNA mais complexas geradas a partir da ação inicial da R3C.

Ou seja, os autores conseguiram provar sua proposta (hipótese) de formação de um sistema auto-catalítico auto-sustentado. O mais interessante é que o sistema como um todo evolui, e dá origem a poucos fragmentos maiores e mais complexos de RNA, que são mais estáveis. Ou seja, o sistema sofre seleção em função da estabilidade dos produtos formados.

Ver o artigo original para a explicação destes gráficos. O gráfico B indica a população relativa de diferentes enzimas RNA formadas.

As conclusões finais dos autores são que

Populations of cross-replicating RNA enzymes can serve as a simplified experimental model of a genetic system with, at present, two genetic loci and 12 alleles per locus. (…) In order to support much greater complexity, it will be necessary to constrain the set of substrates, for example, by using the population of newly formed enzymes to generate a daughter population of substrates. An important challenge for an artificial RNA-based genetic system is to support a broad range of encoded functions, well beyond replication itself.

(Populações de enzimas RNA de replicação cruzada podem servir como modelos experimentais simplificados de um sistema genético com, até agora, 2 loci genéticos e 12 alelos por locus [biólogos e/ou geneticistas: ajuda nestas definições são bem-vindas!]. (…) De forma a suportar uma complexidade muito maior, será necessário restringir o conjunto de substratos, utilizando, por exemplo, a população de enzimas recém-formadas para gerar uma população de substratos “prole”. Um desafio importante para um sistema genético artificial baseado em RNA é apresentar uma ampla variedade de funções codificadas, muito além da simples replicação.)

Em pouco mais de 1 ano, este artigo foi citado por 40 outros artigos científicos (resultados de busca no Institute for Scientific Information – Web of Science), e deu origem a quase 2.000 “entradas” no Google (utilizando a expressão “Self-Sustained Replication of an RNA Enzyme”, com as aspas. Desta maneira a busca no Google é feita com a expressão completa, na ordem especificada). Poderia-se pensar que tais menções pudessem ser a respeito do total absurdo, ou conclusões errôneas, publicado pelos autores. Muito pelo contrário. O artigo de Lincoln e Joyce serviu não somente de base experimental para outros trabalhos, mas também de suporte para a inferência sobre a real pertinência de formação de sistemas biológicos primitivos formados a partir de RNA (o assim chamado “RNA-world”).

Grande sacada dos pesquisadores do Scripps Research Institute (California, EUA). Um bom artigo não passa despercebido.

Muito pelo contrário. Um artigo, um único artigo científico, extremamente ousado e original, com idéias realmente revolucionárias, pode levar ao inesperado: o Prêmio Nobel. Keinichi Fukui e Roald Hoffmann dividiram o Prêmio Nobel de Química de 1981 pela publicação de um único artigo cada um. O de Fukui, originalmente publicado em 1952, foi extremamente criticado à época. O de Hofmann foi publicado em conjunto com Robert B. Woodward (em 3 versões, é verdade, mas que na essência são o mesmo trabalho): “The Conservation of Orbital Symmetry”, originalmente na revista Accounts of Chemical Research em 1968. A versão expandida foi publicada no ano seguinte, com o mesmo título, na revista Angewandte Chemie International Edition. O mesmo artigo foi publicado de maneira bastante sumarizada, com o título “Orbital Symmetry Control of Chemical Reactions”, no ano seguinte na revista Science. Esta teoria, denominada “Teoria dos Orbitais Moleculares de Fronteira” (Frontier Molecular Orbitals Theory), literalmente revolucionou o entendimento da química orgânica, e hoje é ensinada em livros-texto adotados em salas de aula no mundo todo. Woodward também ganhou o Prêmio Nobel de Química, por suas inúmeras contribuições ao desenvolvimento da síntese de substâncias orgânicas.

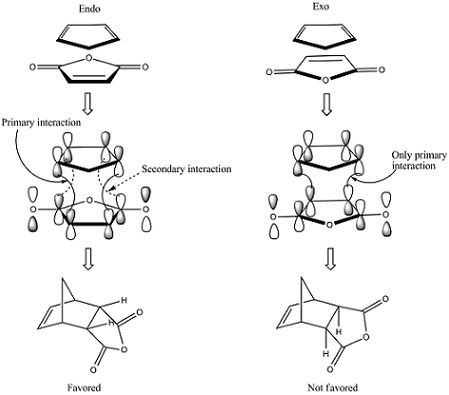

A Teoria dos Orbitais Moleculares de Fronteira é razoavelmente complicada para ser explicada de maneira simples, mas pode ilustrada de maneira extremamente simplista. Os elétrons em volta dos átomos ocupam regiões chamadas de orbitais. A formação de ligações químicas entre átomos resulta da combinação destes orbitais atômicos, formando orbitais moleculares. A maneira como os orbitais atômicos se combinam para formar orbitais moleculares foi inicialmente explicada pela teoria da mecânica quântica (que consegue explicar a formação de ligações em moléculas extremamente simples, como o gás hidrogênio, H2). Hoffmann e Fukui elaboraram um modelo, de certa forma pictórico, que explica como ocorrem reações químicas orgânicas entre moléculas muito mais complexas do que o H2.

Reação concertada entre um dieno e um dienófilo, que obedece às regras de Woodwad-Hoffmann, de acordo com a Teoria dos Orbitais Moleculares de Fronteira.

Bingo!

Grandes sacadas científicas -> bons artigos científicos -> eventualmente o Prêmio Nobel.

Fukui, K., Yonezawa, T., & Shingu, H. (1952). A Molecular Orbital Theory of Reactivity in Aromatic Hydrocarbons The Journal of Chemical Physics, 20 (4) DOI: 10.1063/1.1700523

Fukui, K., Yonezawa, T., & Shingu, H. (1952). A Molecular Orbital Theory of Reactivity in Aromatic Hydrocarbons The Journal of Chemical Physics, 20 (4) DOI: 10.1063/1.1700523 Lincoln, T., & Joyce, G. (2009). Self-Sustained Replication of an RNA Enzyme Science, 323 (5918), 1229-1232 DOI: 10.1126/science.1167856

Lincoln, T., & Joyce, G. (2009). Self-Sustained Replication of an RNA Enzyme Science, 323 (5918), 1229-1232 DOI: 10.1126/science.1167856 Hoffmann, R., & Woodward, R. (1968). Conservation of orbital symmetry Accounts of Chemical Research, 1 (1), 17-22 DOI: 10.1021/ar50001a003

Hoffmann, R., & Woodward, R. (1968). Conservation of orbital symmetry Accounts of Chemical Research, 1 (1), 17-22 DOI: 10.1021/ar50001a003 Woodward, R., & Hoffmann, R. (1969). The Conservation of Orbital Symmetry Angewandte Chemie International Edition in English, 8 (11), 781-853 DOI: 10.1002/anie.196907811

Woodward, R., & Hoffmann, R. (1969). The Conservation of Orbital Symmetry Angewandte Chemie International Edition in English, 8 (11), 781-853 DOI: 10.1002/anie.196907811 Hoffmann, R., & Woodward, R. (1970). Orbital Symmetry Control of Chemical Reactions Science, 167 (3919), 825-831 DOI: 10.1126/science.167.3919.825

Hoffmann, R., & Woodward, R. (1970). Orbital Symmetry Control of Chemical Reactions Science, 167 (3919), 825-831 DOI: 10.1126/science.167.3919.825

Pinte o 7, com RMN-MOUSE

Mas, então, qual é o princípio da análise por RMN? Como ela funciona?

Como o próprio nome diz, a técnica se fundamenta no uso das propriedades magnéticas dos núcleos dos átomos. Mas não de qualquer átomo. Não são todos os átomos que podem ser detectados por RMN, apenas alguns. Todos aqueles que não apresentam a massa atômica de número par e número atômico também de número par. Por exemplo, o isótopo 12 do carbono (massa atômica = 12; número atômico = 6) e o isótopo 16 do oxigênio (número de massa = 16; número atômico = 8) não podem ser detectados por RMN. Porquê? Porque os seus núcleos não se comportam como ímãs sub-atômicos.

Ímãs sub-atômicos? Exatamente. Ímãs sub-atômicos, pois são os NÚCLEOS de outros átomos, que não têm número de massa par e número atômico também par, que se comportam como ímãs. Por exemplo, o hidrogênio (massa atômica = 1; número atômico = 1), o isótopo de massa 13 do carbono (massa atômica = 13; número atômico = 6), o deutério (massa atômica = 2; número atômico = 1), o nitrogênio 14 (massa atômica = 14; número atômico = 7), e muitos outros. Comportando-se como ímãs, estes núcleos apresentam um determinado campo magnético. Ora, leitor, você já experimentou colocar um ímã perto de outro? Os dois ímãs “se sentem” mutuamente, em uma relação recíproca.

Não é uma nave espacial, e sim um aparelho de RMN de 900 MHz

Bom, e daí? E daí que nós humanos temos cerca de 70% de água no nosso corpo. E água tem hidrogênio (H2O). Logo, aparelhos de RMN detectam água. O diagnóstico por RMN é feito observando-se o padrão de distribuição de água nos tecidos do corpo. Se o padrão de distribuição estiver “anormal”, alguma coisa está errada.

A descoberta do fenômeno de RMN literalmente revolucionou a ciência. Esta descoberta foi feita independentemente por Bloch e Purcell, que dividiram o prêmio Nobel de Física de 1952. Richard Ernst e Kurt Wütrich também ganharam o prêmio Nobel em 1991 e 2002 por terem se dedicado ao desenvolvimento e utilização da técnica de RMN na geração de imagens, em análises químicas, físicas, biológicas, geoquímicas, em química de materiais e em outros ramos do conhecimento. Atualmente qualquer universidade do mundo que realiza pesquisa em química e/ou em física possui pelo menos um aparelho de RMN. São aparelhos sofisticados, grandes e caros, em contínuo aprimoramento. Praticamente a cada 2 anos são lançados novos modelos, extremamente versáteis, de aparelhos de RMN. Os campos magnéticos utilizados nos aparelhos de RMN são gerados por magnetos supercondutores que devem ser resfriados por hélio líquido (a cerca de -269 graus Celsius), cujo reservatório deve ser resfriado com nitrogênio líquido (cerca de -200 graus Celsius).

Até recentemente a utilização de aparelhos de RMN estava limitada à localização destes em institutos acadêmicos, ou institutos de pesquisa especializados, em centrais de análises ou ainda em instituições médicas. Porém, já nos anos 80 pesquisadores começaram a desenvolver aparelhos de RMN portáteis, os quais foram colocados em uso em 1996, e atualmente estão sendo cada vez mais utilizados para os mais diversos fins: análise de asfalto de ruas e estradas, de estruturas de pontes e análises de solo. Denominados aparelhos de RMN de varredura (Stray-Field NMR), são aparelhos de RMN em miniatura. São colocados muito próximos à superfície do material que se pretende analisar, de maneira que a geração de um campo magnético pelo aparelho permite que os núcleos dos átomos de hidrogênio no material sob análise sejam detectados. Em geral, analisa-se o padrão de distribuição de água. Mas também de gordura, ou de proteínas.

O aparelho de RMN portátil foi batizado, muito apropriadamente, de RMN-MOUSE (MObile Universal Surface Explorer). Tem o tamanho de um aparelho de telefone celular grande, ou um palm, e é empregado movendo-se um campo magnético que não varia. O aparelho é colocado próximo à superfície que se deseja analisar. O sinal registrado é transmitido para um computador através de um cabo, obtendo-se imagens tanto da superfície como de camadas próximas à superfície, para que se possa conhecer a constituição do material sob análise. A resolução da imagem gerada pode chegar a 2,3 um. Uma das aplicações mais interessantes do RMN-MOUSE é na análise de obras de arte e de construções históricas, de grande valor cultural.

aparelho de RMN-mouse

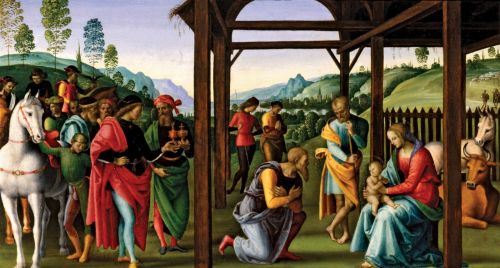

Adoração de Magi, de Pietro Parugino

Pala Albergotti, de Giorgio Vasari

documentos antigos, uma vez que papel é feito com celulose e lignina, que apresentam tanto “água aprisionada” como “água livre” na sua estrutura. No caso de papel e madeira danificados, a quantidade de água e a crsitalinidade da celulose sofrem modificações, e podem ser detectadas. Assim, é possível se saber qual a extensão do comprometimento de documentos antigos de acordo com o teor de água que estes apresentam. Também se observou efeito corrosivo de tinta utilizada na escrita, feita de ferro e taninos (iron gall ink), em documentos do Codex Major da Collectio Altaemsiana.

tinta de ferro e taninos (iron gall ink)

A técnica de RMN-MOUSE já foi utilizada na análise da madeira de violinos Stradivarius. Em alguns casos, foi possível saber quantas camadas de verniz foram aplicadas na madeira da confecção dos instrumentos. Também foi possível se verificar que os violinos mais antigos foram fabricados com madeiras mais densas, e que a densidade da madeira influencia diretamente na qualidade do som produzido pelo instrumento. Tal técnica também pode ser empregada na distinção de violinos verdadeiramente antigos daqueles que são falsificados.

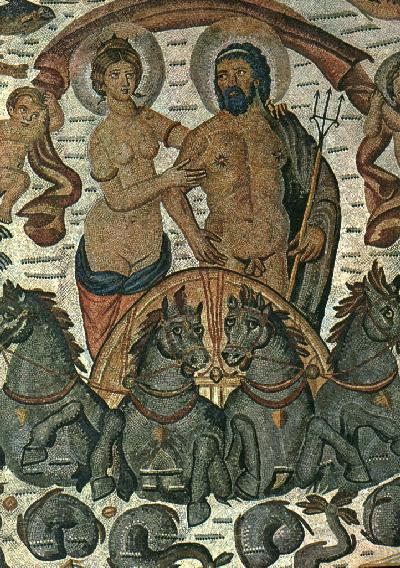

A RMN-MOUSE é empregada para se analisar o teor de água em paredes de prédios e monumentos históricos, de maneira a que os restauradores possam utilizar o material mais adequado na restauração de tais construções. A análise dos afrescos pintados por Pelledrino degli Aretusi na Capela Serra da Igreja da Nossa Senhora do Sagrado Coração, em Roma, indicou que estes estão sujeitos à umidade que se inflitra a partir do solo. A análise detalhada da distribuição de água nos afrescos indicou em que locais este se encontra mais afetado e deve ser restaurado. O teor de água no mosaico Netuno e Amphitrite foi analisado por RMN-MOUSE, e apresentou grandes diferenças de umidade dependendo da área do mosaico.

Netuno e Amphitrite, Herculaneum

Além disso, a análise de monumentos históricos e obras de arte por RMN-MOUSE são extremamente úteis para se indicar quais materiais são mais indicados para sua restauração, dependendo do teor de água, da porosidade do material a ser restaurado e como o emprego de diferentes substâncias na restauração pode afetar a obra a ser restaurada.

Aparelhos de RMN móveis são extremamente versáteis e úteis para se analisar pinturas, madeira, papel, bem como materiais de construção. Atualmente a técnica está sendo aprimorada, para que sua sensibilidade seja aumentada e possa ser facilmente utilizada. Outros núcleos diferentes de hidrogênio também poderão ser analisados em um futuro próximo, como Alumínio-29, presente em vidros e cerâmicas. O futuro é extremamente promissor para a utilização de RMN, nas mais variadas aplicações.

Blümich, B., Casanova, F., Perlo, J., Presciutti, F., Anselmi, C., & Doherty, B. (2010). Noninvasive Testing of Art and Cultural Heritage by Mobile NMR, Accounts of Chemical Research DOI: 10.1021/ar900277h

Blümich, B., Casanova, F., Perlo, J., Presciutti, F., Anselmi, C., & Doherty, B. (2010). Noninvasive Testing of Art and Cultural Heritage by Mobile NMR, Accounts of Chemical Research DOI: 10.1021/ar900277h

Darwin e Deus, Deus e Darwin

A ciência busca evidências para confirmar hipótese ou propostas, tendo por base a coleta anterior de informações que levam à formulação de tais hipóteses ou propostas. Uma vez encontradas, tais evidências servirão para estabelecer uma maneira de como pode se entender um determinado fenômeno, ou um conjunto deles. Quanto mais evidências são encontradas para se confirmar a existência ou a compreensão de determinados fenômenos, tanto melhor estes poderão ser explicados. Ao conjunto de evidências, e suas inter-relações, que explicam um determinado conjunto de fenômenos dá-se o nome de teoria.

No decorrer da história da humanidade, teorias surgiram e foram sendo substituídas. À medida que se verificava que uma determinada teoria, utilizada para explicar um conjunto de fenômenos, não conseguia os explicar adequadamente, buscou-se novas idéias para formar novas teorias. Assim foi, por exemplo, o processo de conhecimento da constituição da matéria. O filósofo grego Demócrito (cerca de 460 a.C.) foi o primeiro a formular a idéia de átomo, como unidade indivisível que constitui a matéria. Na sua essência, as idéias de Demócrito sofreram poucas modificações até o século XVIII, quando John Dalton (1766-1844) as aprimorou, dizendo que existiam diferentes tipos de átomos, e que estes podiam se combinar formando diferentes substâncias. Além disso, Dalton afirmou que os átomos não podiam ser destruídos e que quando formavam substâncias, os átomos se combinavam em proporções bem definidas. Já no século XIX, J. J. Thomson (1856-1940) descobriu que os átomos eram constituídos por elétrons, muito menores, e sugeriu que os diferentes tipos de átomos teriam uma estrutura de um “pudim de ameixas”, onde as ameixas seriam os elétrons.

Entre o fim do século XIX e o início do século XX, Ernest Rutherford (1871-1937) estudou o comportamento dos átomos com experimentos de radiação e verificou que os átomos também possuíam partículas positivas, os prótons, e partículas neutras, os nêutrons. Além disso, seus experimentos permitiram afirmar que os prótons e os nêutrons seriam “responsáveis” por praticamente toda a massa de cada átomo. Assim, por exemplo, o átomo de hidrogênio mostrou ter um único próton e uma massa correspondente de 1 u.m.a. (unidade de massa atômica, que corresponde à massa em gramas de 6,02 . 1023 átomos de um determinado tipo). O oxigênio mostrou ter massa de 16 u.m.a., o nitrogênio de 14 u.m.a. Rutherford também afirmou que os prótons e os nêutrons estariam localizados no centro dos átomos, que teria uma carga positiva, e que os elétrons estariam em órbitas em volta do núcleo. O problema da teoria de Rutherford é que se os átomos comportam-se como pequenos “sistemas solares”, com elétrons girando em torno dos núcleos (de forma que a força centrífuga de movimento dos elétrons compensaria a atração eletrostática dos prótons), de acordo com a teoria da mecânica clássica de Newton os elétrons deveriam emitir energia radiante, perdendo energia e coalescendo com os núcleos, o que não foi observado. Logo, a teoria de Rutherford estava furada. Mesmo assim, Rutherford recebeu o Prêmio Nobel de Química em 1908, por suas investigações sobre a desintegração dos elementos e a química das substâncias radioativas.

Niels Bohr (1885-1962) deu continuidade aos estudos de Rutherford, e desenvolveu um modelo físico-matemático para explicar o comportamento dos elétrons. De acordo com a teoria de Bohr os elétrons se situariam em regiões bem específicas dos átomos, chamadas de orbitais atômicos. Uma vez que estavam situados nestas regiões, os elétrons apresentariam quantidades bem definidas de energia. Além disso, Bohr propôs que os elétrons apresentariam movimento em torno de seu próprio eixo, definido como momento angular, e também que os elétrons se comportariam como ondas se propagando em torno do núcleo do átomo em que se situam, sem perder energia e sem coalescer com o núcleo. A teoria de Bohr foi denominada de teoria da mecânica quântica, e teve como base as idéias de Max Planck (1858-1947). A teoria de Bohr permitiu explicar a decomposição da luz de determinados tipos de lâmpadas, e Bohr ganhou o Prêmio Nobel de Física em 1922.

Erwin Schröndinger (1887-1961) aprimorou a teoria de Bohr, estabelecendo um modelo que explicava o comportamento dos elétrons em termos de números quânticos, que justificariam não somente o comportamento dos elétrons, mas também das ligações químicas entre átomos. Recebeu o prêmio Nobel de Física em 1933.

Ao longo da história, as pesquisas e contribuições de Lavoisier, John Dalton, Avogadro, Gay-Lussac, Berzelius, Cannizaro, Berthelot, Kekulé, Mendeleev, Boltzmann, Le Bel, Van’t Hoff, Thomson, Planck, Rutherford, Bohr, Schrondinger, de Broglie, Einstein e Heisenberg permitiram o acúmulo de evidências e a formulação de modelos que explicam o comportamento da matéria, e chegar a um consenso muito bem aceito sobre a estrutura da matéria. Assim, faz parte da formação de todo estudante do ensino médio conhecer as idéias básicas da teoria que explica a estrutura e o comportamento da matéria.

A história da teoria da evolução não é diferente. De maneira bastante simplista, nasceu com Aristóteles, Anaximander e Empedocles, foi posteriormente desenvolvida pelo biólogo afro-árabe Al-Jahiz, o filósofo persa Ibn Miskawayh, o filósofo chinês Zhuangzi, aprimorada por Pierre Maupertuis, Erasmus Darwin, John Ray, Lineu, Buffon, amadurecida por Lamarck, chegando à sua formulação geral mais aceita por Charles Darwin e Wallace. Porém foi bastante aperfeiçoada durante os últimos 150 anos, principalmente depois do surgimento da genética, da ecologia, da simbiose, e outras derivações biológicas, que levaram à formulação da Síntese Evolucionária Moderna por Julian Huxley, R. A. Fisher, Theodosius Dobzhansky, J.B.S. Haldane, Sewall Wright, E.B. Ford, Ernst Mayr, Bernhard Rensch, Sergei Chetverikov, George Gaylord Simpson e G. Ledyard Stebbins.

A teoria da evolução tem o mesmo status científico da teoria da estrutura da matéria, ou da teoria da mecânica quântica, e da teoria da relatividade de Einstein.

Esta longa introdução tem por objetivo mostrar que as teorias científicas se constroem de maneira extremamente consistente, sendo continuamente questionadas, testadas e verificadas, de maneira a confirmar sua consistência, seu caráter geral e sua falseabilidade.

Por isso, quando o editorial (3/4/2010) de um jornal como a Folha de São Paulo afirma que

“Brasileiros parecem ter discernimento intuitivo de que questões de ciência não competem com convicção religiosa”,

deve-se analisar tal afirmação de maneira a se entender se esta faz sentido ou não.

Faz sentido pensar se “questões de ciência competem com convicção religiosa”? Não, não faz simplesmente porque as religiões nunca foram objeto de estudo das ciências naturais (mas foram da filosofia, da história, da psicologia, da sociologia, da educação, etc.). A ciência não compete com a religião. Não é objetivo das ciências naturais verificar se Deus existe ou não, ou se as religiões fazem sentido ou não.

O editorial do jornal diz ainda que

“a maioria dos brasileiros (59%) combina a aceitação do processo darw

iniano com a fé na condução e supervisão divina, situadas num plano superior ao da natureza. Embora inverossímil aos olhos de quem for ateu, essa conciliação de crenças [o grifo é meu] não é absurda. Sugere, ao contrário, um discernimento intuitivo de que questões de ciência não competem com questões de convicção religiosa. São campos que correspondem a dimensões diferentes da consciência humana.”

Crença? A Teoria da Evolução não é uma crença. É um fato. Comprovado, dezenas, centenas de vezes, ao longo de 150 anos desde que Darwin e Wallace a propuseram. O discernimento intuitivo de parcela significativa da população brasileira parece ser bastante razoável, uma vez que, segundo o jornal, consegue fazer uma distinção entre ciência (evolução) e crença (Deus). Porém, o editorial do jornal não faz esta distinção. Seria cômico, se não fosse trágico.

O jornal também estabelece uma relação direta entre ciência e ateísmo, quando diz que

“UMA APAIXONADA predileção por besouros.” Essa foi a resposta de J.B.S. Haldane (1892-1964) quando lhe perguntaram o que a teoria da seleção natural revelava a respeito dos desígnios de Deus. O biólogo britânico, que era ateu, aludia de forma irônica à fantástica abundância de insetos coleópteros na natureza.

Pesquisa Datafolha publicada ontem revelou que apenas 8% dos brasileiros endossariam Haldane, ao concordar que os seres vivos são produto de lentíssima evolução na qual variações fortuitas, mas vantajosas à sobrevivência e reprodução, se disseminam e acabam por dar origem a novas espécies, mais adaptadas a seu ambiente. Seriam os darwinistas “puros”.

O fato do editorial iniciar com esta narrativa traz em sua mensagem o fato de Haldane ser ateu e o relacionar ao “darwinismo puro” (termo criado pelo jornal). Tal relação não existe. Ser ateu ou acreditar em Deus é uma questão de foro íntimo, de cada pessoa. A validade de teorias científicas independe de acreditarmos nelas ou não. Como o próprio editorial afirma, a ciência e a crença “são campos que correspondem a dimensões diferentes da consciência humana.” Logo, não podem ser considerados em um mesmo contexto.

Porém, a distinção “percebida intuitivamente” pela população não parece ser considerada em seu inverso, ou seja, “Brasileiros parecem ter discernimento intuitivo de que questões religiosas não competem com teorias científicas”. Seria esta afirmativa verdadeira? Aparentemente, não. Se 59% da população acredita que Deus interfere no processo evolutivo, fica evidente que não há uma distinção clara e perceptível de que a ciência se constrói com base no método científico e a crença é variável, de pessoa para pessoa, de acordo com seus valores, sua história pessoal e sua inserção social. São dois contextos bem diferentes.

Embora o “sincretismo brasileiro” entre a Teoria da Evolução e a crença religiosa à que se refere a Folha possa fazer sentido para muitos, este revela a falta de conhecimento por parcela significativa da população, que mistura, talvez inconscientemente, ciência e religião para satisfazer questões de foro íntimo. Se, por um lado, tal “sincretismo” possa se revelar positivo no sentido de mostrar que a população conhece a Teoria de Evolução, por outro lado tal parcela da população não percebe que esta, no seu âmago, dispensa completamente a noção do sobrenatural, de um ser ou uma energia que direcione ou organize o processo evolutivo. Sendo assim, existe um claro paradoxo de conceituação e compatibilidade entre uma concepção de mundo e uma teoria científica, evidente pela falta de conhecimento sobre esta distinção. Como bem disse Sandro José de Souza, em texto publicado no dia anterior (2/4/2010) no mesmo jornal

“Esta corrente do criacionismo, o evolucionismo teísta, é a mais moderada, no sentido que aceita todas as evidências científicas, mas mantém Deus como agente causal. O evolucionismo teísta, no entanto, não pode ser tratado como ciência devido à sua natureza metafísica. A existência ou não de Deus não pode ser testada e por isso não é científica, e sua aceitação depende de um estado da mente chamado de fé. A evolução, por outro lado, é fato corroborado por evidências científicas acumuladas nos últimos 150 anos.”

Aonde está o problema?

Na educação formal, escolar. A educação escolar é a base para o indivíduo adquirir conhecimento em todas as esferas, bem como espírito de análise, crítico e de distinção. É importante para, justamente, perceber que temas de discussão e questionamento pertencem a diferentes esferas. Com este objetivo, o Conselho do Parlamento Europeu publicou em outubro de 2007 uma resolução do porquê o ensino de criacionismo deve ser restrito às aulas de religião, ao mesmo tempo em que se reforça a necessidade de um ensino de ciências aprofundado, como indicado no artigo 19 da resolução, transcrito a seguir:

The Parliamentary Assembly therefore urges the member states, and especially their education authorities to:

19.1. defend and promote scientific knowledge;

19.2. strengthen the teaching of the foundations of science, its history, its epistemology and its methods alongside the teaching of objective scientific knowledge;

19.3. make science more comprehensible, more attractive and closer to the realities of the contemporary world;

19.4. firmly oppose the teaching of creationism as a scientific discipline on an equal footing with the theory of evolution and in general the presentation of creationist ideas in any discipline other than religion;

19.5. promote the teaching of evolution as a fundamental scientific theory in the school curriculums.

Ainda citando Sandro J. de Souza, da mesma reportagem de 2/4

“(…) a predominância de uma visão teísta na população brasileira gera um risco de que assuntos da fé sobreponham-se a assuntos da ciência. Aulas de ciência devem se ater à ciência.

Temos visto figuras públicas manifestarem-se a favor da equiparação entre evolucionismo e criacionismo. Escolas brasileiras já ensinam criacionismo em aulas de ciência. Tal absurdo coloca em risco a formação de milhões de brasileiros.”

A falta de conhecimento para se distinguir método científico e teoria da evolução da crença religiosa é demonstrada pelos resultados da pesquisa realizada pelo Datafolha, publicados em reportagem do dia anterior (sexta feira, 2/4/2010). Segundo o jornal, os dados indicam que, dentre os ateus, “7% também se classificam como criacionistas da Terra jovem e 23% como partidários da evolução comandada por Deus.” Por definição, ateus não acreditam em Deus. Ou seja, existe até desconhecimento do que seja ser ateu.

Tal desconhecimento chega à beira de seu limite quando o criacionista Michelson Borges assinala em seu artigo (“Teoria é mal compreendida”), publicado na mesma página, da mesma edição, que

“Segundo o criacionismo, Deus criou os tipos básicos de seres vivos e eles sofreram modificações, dentro de limites preestabelecidos. Dizer que elas descendem de um mesmo ancestral unicelular comum é extrapolação.”

Se parte da Teoria da Evolução estivesse errada, por assumir que seres vivos não descendem de tipos básicos e que não sofrem modificações dentro de limites pré-estabelecidos, teria que ser imediatamente abandonada. Sem dó nem piedade. Não poderia mais ser aceita para explicar a biodiversidade do planeta Terra. Não poderia mais ser adotada para entender o processo de surgimento de viroses, de resistência bacteriana, de novas espécies de organismos vivos. Não poderia ser ensinada nas escolas.

O método científico é rigoroso, e se fundamenta em um questionamento constante, em contínua elab

oração e aperfeiçoamento, de maneira a trazer à luz o conhecimento sem que este tenha que se fundamentar em hipóteses mal formuladas, em justificativas parciais ou em idéias pré-concebidas. O método científico resulta de mais de 2000 anos de história da humanidade associado à história da cultura, da geração do conhecimento e busca do entendimento dos fenômenos naturais. Querendo ou não, é de longe a melhor forma de fornecer explicações sobre a validade (ou não) de conceitos, tais como os indicados por Michelson Borges: “informação complexa, aperiódica e específica” e “códigos zipados, encriptados, compartimentados e com uma lógica algorítmica”.

A distinção entre ciência e religião nos mostra que “uma coisa é uma coisa, e outra coisa é outra coisa”, pois têm em sua essência pressupostos diferentes. Uma se fundamenta em experimentação, observação e verificação, e a outra em fé. O fato de cientistas serem católicos, muçulmanos, ateus ou budistas não interefere, em absoluto, na validade da ciência e do método científico. São duas concepções distintas, uma de visão de mundo pessoal a outra de geração de conhecimento e conhecimento de como os processos naturais funcionam. Por isso, uma educação de qualidade, que permita formar cidadãos esclarecidos, é absolutamente imprescindível para o bom entendimento do que é ciência e do que é religião.

Medite

Porém, Yoga e Tai Chi Chuan têm, cada vez mais, chamado a atenção de médicos, fisioterapeutas, e agora de neurofisiologistas, uma vez que tanto uma como outra são, no fundo, práticas de meditação. E, considerando-se a enorme popularidade que a meditação vem recebendo por conta dos benefícios que traz àqueles que a praticam, muita pesquisa têm sido desenvolvida para se entender como funcionam os efeitos da meditação no cérebro.

Estudos coordenados por Jim Lagopoulos, e realizados por sua equipe da Sidney University (Australia) e pesquisadores da Norwegian University of Science and Technology, tiveram justamente este objetivo: observar mudanças nos padrões elétricos durante exercícios de meditação.

Mesmo dormindo, ou descansando, nosso cérebro sempre apresenta níveis de atividade elétrica. Por isso, a atividade cerebral pode ser monitorada por eletroencefalografia, colocando-se eletrodos em posições bem determinadas do crânio, utilizando-se uma espécie de capuz para fixar os eletrodos. Os voluntários deste estudo realizaram duas diferentes atividades: descansar durante 20 minutos e meditar durante 20 minutos, de maneira aleatória entre os participantes. Os pesquisadores analisaram os padrões de ondas cerebrais elétricas do tipo alfa, beta, delta e teta.

Durante os exercícios de meditação, os pesquisadores observaram uma maior intensidade de ondas teta nas regiões frontal e central do cérebro. Segundo os pesquisadores, tais ondas se originam a partir de uma atenção relaxada que monitora nossas “experiências interiores”. Uma diferença significativa entre simplesmente relaxar e meditar. Estudos anteriores indicaram que ondas teta indicam uma profunda capacidade de relaxamento e ocorrem com mais freqüência em praticantes experientes de meditação. A origem de tais ondas é na região frontal do cérebro, associada com o monitoramento de determinados processos mentais. Quando se mede a calma mental, estas regiões ativam as partes mais baixas do cérebro, induzindo um relaxamento físico em resposta aos exercícios de meditação.

Já ondas alfa são mais pronunciadas na região posterior do cérebro durante a meditação do que simplesmente durante um relaxamento. Indicam um descanso alerta. Tal tipo de comportamento cerebral é um sinal universal de relaxamento durante a meditação e outros tipos de relaxamento. A quantidade de ondas alfa aumenta quando o cérebro relaxa após atividades direcionadas. É um sinal de relaxamento profundo – mas não significa que a mente está vazia.

Análises de imagens neuronais realizadas pela equipe de Malia F. Mason do Dartmouth College indicam que o estágio de descanso normal do cérebro é uma corrente silenciosa de pensamentos, imagens e memórias, que não são provocadas por estímulos sensoriais ou racionais, mas que emergem espontaneamente do interior da mente. A tomada de consciência interior é algo que se percebe cada vez mais quando se pratica meditação. É uma atividade cerebral padrão, mas que é totalmente subestimada. Provavelmente representa um tipo de processamento mental que permite a conexão entre vários “resíduos” de experiências e emoções, colocando-os em perspectiva, deixando de lado a atividade mental ordinária.

Já durante o sono, as ondas delta são as mais freqüentes. Os pesquisadores observaram baixa intensidade de ondas delta durante relaxamento e meditação, fato que confirmou que a meditação não-direcionada é totalmente diferente do sono. As ondas beta surgem quando o cérebro está ativo, trabalhando, com tarefas objetivas. Tais ondas praticamente desaparecem durante as práticas de meditação e relaxamento. Ou seja, quando se relaxa e medita, pode-se, realmente, deixar os problemas de lado.

Os estudos indicaram que a melhor forma de meditação é aquela que leva ao “esvaziamento da mente”, sem a realização de exercícios direcionados, como tentando visualizar imagens, ou mentalizando sons (como o “AUM”). As técnicas de esvaziamento da mente foram principalmente desenvolvidas pelos zen-budistas, que buscam atingir o estado de consciência máxima através do “pensar em nada”. Utilizando-se desta técnica de meditação, os praticantes não buscam um objetivo em particular ou um estado da mente. Simplesmente esperam, pacientemente, os pensamentos fluírem e irem embora.

Tai práticas são conhecidas há milênios. Atualmente diversos pesquisadores do mundo todo estão comprovando que meditar faz muito bem à saúde. Qual é o segredo da boa meditação? Infelizmente, encontrar um bom professor. Alguém que tenha tido uma boa formação nas práticas de yoga ou tai chi chuan. Os exercícios de yoga e tai chi chuan ajudam muito a relaxar o corpo e preparar a mente para as práticas de meditação. Leva tempo para se conseguir um estado de relaxamento alerta, sem dormir. Meses. Às vezes anos. Como dizia meu professor de yoga, Frederico: “Perseverança, persistência, mas nunca desistência”.

Lagopoulos, J., Xu, J., Rasmussen, I., Vik, A., Malhi, G., Eliassen, C., Arntsen, I., Sæther, J., Hollup, S., Holen, A., Davanger, S., & Ellingsen, �. (2009). Increased Theta and Alpha EEG Activity During Nondirective Meditation The Journal of Alternative and Complementary Medicine, 15 (11), 1187-1192 DOI: 10.1089/acm.2009.0113

Lagopoulos, J., Xu, J., Rasmussen, I., Vik, A., Malhi, G., Eliassen, C., Arntsen, I., Sæther, J., Hollup, S., Holen, A., Davanger, S., & Ellingsen, �. (2009). Increased Theta and Alpha EEG Activity During Nondirective Meditation The Journal of Alternative and Complementary Medicine, 15 (11), 1187-1192 DOI: 10.1089/acm.2009.0113

Bismuto – mais amigo, impossível

O Bismuto-209 é considerado como sendo o átomo estável de maior massa atômica, levemente radioativo. Seu tempo de meia-vida (o tempo de meia vida de um elemento é o tempo necessário para que metade uma determinada quantidade deste elemento decaia para outro isótopo do mesmo elemento, ou de outro elemento) é de aproximadamente 190.000.000.000.000.000.000 de anos. Para se ter uma idéia como este tempo é longo, estima-se que a idade do universo seja de 14.000.000.000 de anos.

Apesar de ser um metal pesado, os sais de bismuto são incrivelmente não-tóxicos. Menos tóxicos do que o sal de cozinha, cloreto de sódio (NaCl). Por isso, sais de bismuto apresentam inúmeras aplicações, como na indústria de cosméticos, na medicina e na preparação de medicamentos (sais de bismuto são notoriamente utilizados no tratamento de azias e mal-estar estomacal).

Sais de bismuto são algumas das poucas substâncias que sofrem expansão quando se solidificam (como a água, por exemplo; quem já colocou uma garrafa fechada cheia de água no congelador sabe disso). Por isso, sais de bismuto são utilizados em soldas e na fabricação de ligas para a indústria de impressão (isso mesmo: para fazer aquelas letras de metais de impressoras antigas).

Sais de bismuto também são bons substitutos do chumbo, que é altamente tóxico, na fabricação de balas de espingardas para a caça de aves e animais silvestres (pobres animais; mas em muitos países do hemisfério norte a temporada de caça é totalmente regulamentada, até mesmo com animais “selvagens” criados em cativeiro, como javalis).

Sais de bismuto também são altamente diamagnéticos – ou seja, são repelidos, e não atraídos, por um campo magnético. Por isso, entram na composição das ligas metálicas de trens ultra-rápidos que funcionam por levitação magnética.

Devido à sua baixa toxicidade, sais de Bismuto com estado de oxidação +3 são utilizados como catalizadores eficazes e de baixa toxicidade em diversas reações químicas – sendo assim considerados sais de “química verde” (“amigos” do meio-ambiente).

No laboratório de Química Orgânica de Produtos Naturais do Instituto de Química de São Carlos, utilizamos sub-nitrato básico de bismuto, 4BiNO3(OH)2.BiO(OH), na preparação do revelador de Dragendorff (o sal de bismuto + ácido acético + iodeto de potássio), que reage com substâncias nitrogenadas de natureza básica fornecendo manchas de coloração alaranjada em placas de cromatografia em camada delgada.

Viva o Bismuto!

Mohan, R. (2010). Green bismuth Nature Chemistry, 2 (4), 336-336 DOI: 10.1038/nchem.609

Mohan, R. (2010). Green bismuth Nature Chemistry, 2 (4), 336-336 DOI: 10.1038/nchem.609

Vespas exploram actinobactérias em proveito próprio

A simbiose entre microrganismos e organismos superiores é considerada por alguns pesquisadores como sendo a chave para o sucesso da evolução biológica (Margulis e Fester, 1991). Tais relações estão amplamente distribuídas em todos os ambientes da Terra. Em particular, relações de simbiose entre insetos e microrganismos são importantes para a nutrição dos insetos bem como para a proteção dos alimentos dos insetos.

Uma espécie específica de vespa, Philanthus sp., estabelece relação de simbiose com uma actinobactéria (Candidatus Streptomyces philanthi) que protege tanto a vespa como seus ovos da infecção por patógenos. As fêmeas da vespa “cultivam” estas bactérias em suas antenas, e depositam uma secreção contendo estas bactérias nas células que darão origem a seus ovos. As larvas dos ovos incorporam tais bactérias em seus casulos, e as espalham pela superfície do casulo enquanto estes são formados, girando o casulo no local em que se encontram.

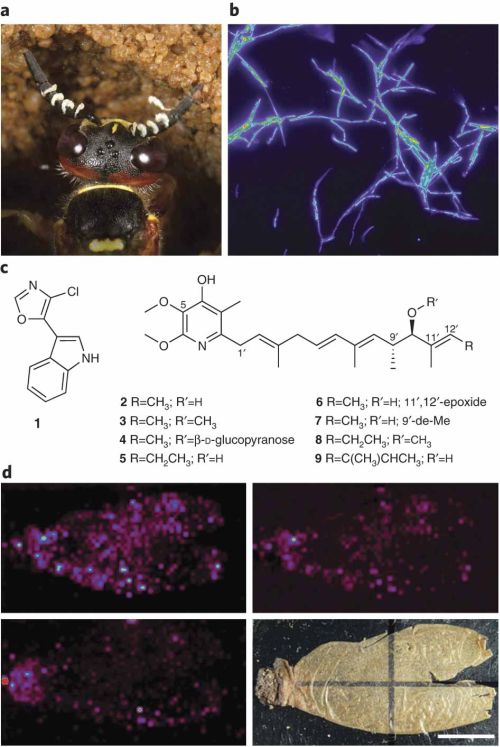

Uma vez isoladas, as actinobactérias dos casulos foram crescidas em meio de cultura em laboratório, para que, depois de crescidas suficientemente, fornecessem quantidade adequada de meio de cultura para o isolamento dos antibióticos que produzem. Estes foram identificados como sendo a estreptoclorina (1), a piericidina A1 (2), a piericidina B1 (3), a glucopiericidina A (4), a piericidina A5 (5), a piericidina C1 (6), a 9’-desmetil-piericidina A1 (7), a piericidina B5 (8) e a piericidina IT-143-B (8). Tais antibióticos já eram conhecidos e já haviam sido isolados de outras linhagens de actinobactérias, mas nunca todas estas substâncias juntas.

Após a remoção das actinobactérias da superfície dos casulos, nenhum dos antibióticos pôde ser detectado nestes. Os autores utilizaram uma técnica recentemente desenvolvida, chamada de espectrometria de massas de geração de imagens por dessorpção/ionização a laser acoplada a um analisador por tempo de vôo [(LDI)-TOF/MS imaging]. Esta técnica permite a visualização de substâncias em uma superfície. Desta maneira, conseguiram, literalmente, observar (ou não) a presença das substâncias na superfície dos casulos das larvas de Philanthus sp. A técnica permitiu detectar a piericidina A1 como sendo a substância majoritária presente na superfície dos casulos, além das substâncias piericidina B1 a estreptoclorina, com uma distribuição bastante uniforme destes três antibióticos em toda a superfície dos casulos. Porém, estas substâncias ocorrem em muito menor concentração no interior do casulo. A quantidade total média de todos os antibióticos em cada casulo pôde ser estabelecida: 130,5 +/- 209,7 µg.

(a) Fêmea da vespa Philanthus sp. secretando actinobactérias (listras brancas da antena); (b) micrografia de fluorescência por hibridização in situ das actinobactérias simbiontes de Philanthus sp.; (c) estruturas das substâncias químicas isoladas do meio de cultura da actinobactéria: estreptoclorina (1) e piericidinas (2-9); análise por LDI-TOF/MS da superfície do casulo de Philanthus sp. Mapas de intensidade de íons das substâncias piericidina A1 (figura d superior à esquerda), piericidina B1 (figura d superior à direita), estreptoclorina (inferior à esquerda). A figura d inferior à direita se refere ao casulo da vespa Philanthus sp. A intensidade dos íons de cada substância é indicada com pontos coloridos: pontos negros correspondem a 0 íons e pontos vermelhos correspondem a 255 íons.

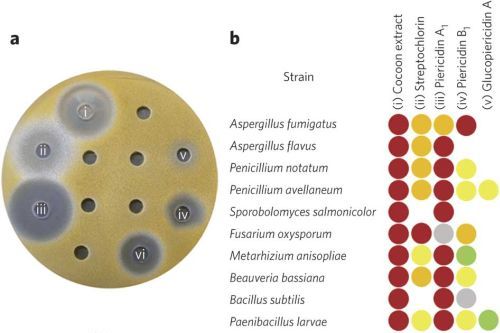

Tanto o extrato bruto de metanol do casulo, como as substâncias individuais 1, 2, 3 e 4 , foram testadas contra uma série de microrganismos patogênicos (Figura 2b). O extrato do casulo apresentou atividade antibiótica contra todas as linhagens testadas (detalhe: Metarhizium anisopliae e Beauveria bassiana são fungos entomopatogênicos, ou seja, patógenos de insetos). Dentre as substâncias puras testadas, a piericidina A1 demosntrou ser o antibiótico de mais amplo espectro. As concentrações de atividade biológica para todos os antibióticos isolados da actinobactéria situaram-se na faixa de 0,24 a 24 nmol (1 nmol = 0,0000000001 mol).

As actinobactérias simbiontes “cultivadas” nas antenas da fêmea da vespa Philanthus sp. produzem um “coquetel de antibióticos” que protege o casulo d

as larvas da vespa contra agentes infeciosos (fungos e bactérias patogênicos). A localização dos antibióticos na superfície do casulo permite estabelecer a sua real função e o significado ecológico das substâncias produzidas pela actinobactéria. A proteção por antibióticos confere às larvas da vespa uma vantagem adaptativa, uma vez que vespas são insetos solitários, desprovidos de formas de defesa adquiridas por insetos sociais.

Atividade biológica das substâncias produzidas pela actinobactéria isolada de Philanthus sp. (a) Placa de Petri do fungo Penicillium avellaneum sobre o qual foram aplicados o extrato metanólico do casulo (i) e as substâncias estreptoclorina (ii), piericidina A1 (iii), piericidina B1 (iv), e glucopiericidina A1 (v). (b) Padrão de inibição de vários micro-organismos patogênicos pelas substâncias isoladas da actinobactéria simbionte de Philanthus sp. Círculos vermelhos indicam o máximo de inibição de crescimento microbiano; círculos laranja indicam 76 a 99% de inibição do crescimento microbiano; círculos amarelos, 51 a 75% de inibição do crescimento microbiano; círculos verdes indicam 26 a 50% de inibição do crescimento microbiano; círculos verdes indicam 1 a 25% de inibição do crescimento microbiano.

A “terapia de antibióticos” produzida pela actinobactéria e utilizada pela vespa corresponde à utilização de coquetéis de antibióticos ou de antivirais, cada vez mais utilizada em medicina. Tal forma de tratamento explora a ação sinergística que vários compostos juntos podem apresentar, e resulta em uma maior eficácia contra um maior número de agentes patogênicos, fazendo com que estes não desenvolvam mecanismos de resistência aos antibióticos. Tal “modelo de tratamento” é extremamente importante para a larva da vespa Philanthus, que pode ficar em estágio de transformação ovo-larva-pupa-adulto por até 9 meses, e exposta a diversos tipos de micro-organismos. A estratégia adquirida pelas vespas da espécie Philanthus sp. representa uma “inovação adaptativa” de um mecanismo de ação de defesa efetivo que atua a longo prazo. Certamente tal estratégia deve ser utilizada por outros macro-organismos, uma vez que este mundo é dominado por seres invisíveis, os micro-organismos.

Referências

Margulis, L. e Fester, R. (1991) Symbiosis as a source of evolutionary innovation, The MIT Press (ISBN 0-262-13269-9).

Kroiss, J., Kaltenpoth, M., Schneider, B., Schwinger, M., Hertweck, C., Maddula, R., Strohm, E., & Svatoš, A. (2010). Symbiotic streptomycetes provide antibiotic combination prophylaxis for wasp offspring Nature Chemical Biology, 6 (4), 261-263 DOI: 10.1038/nchembio.331

Kroiss, J., Kaltenpoth, M., Schneider, B., Schwinger, M., Hertweck, C., Maddula, R., Strohm, E., & Svatoš, A. (2010). Symbiotic streptomycetes provide antibiotic combination prophylaxis for wasp offspring Nature Chemical Biology, 6 (4), 261-263 DOI: 10.1038/nchembio.331

As figuras foram obtidas com autorização do Grupo de Publicações Nature (NGP).

Biodiversidade marinha e terrestre

Fato surpreendente é o relato recente que a biodiversidade marinha é muito menor do que a biodiversidade terrestre, quando se considera o número de espécies nos dois ambientes. O levantamento mostra que de cada 10 espécies biológicas, 9 situam-se em ambiente terrestre, segundo Richard Grosberg e Geerat Vermeij, da University of California em Davis. Os pesquisadores assinalam que tal distribuição é relativamente recente, uma vez que há 400 milhões de anos, no período Devoniano, a predominância era de espécies marinhas. Contudo, há cerca de 110 milhões de anos as plantas terrestres começaram a sofrer um intenso processo de especiação, e, em paralelo, seus respectivos agentes polinizadores, micro-organismos associados (os assim chamados micro-organismos endofíticos) e predadores herbívoros. Em conseqüência, o número de espécies biológicas terrestres sofreu um enorme incremento, deixando a biodiversidade marinha muito aquém em número de espécies.

Mas tal observação não é nova. Já em 1994, Robert May da University of Oxford (Inglaterra) observou que 85% das espécies macroscópicas situam-se em terra firme, utilizando um levantamento feito com base no registro de espécies até então catalogadas. A disparidade do número de espécies entre ambiente terrestre e marinho é detectável até mesmo em áreas de alta densidade biológica, como em florestas tropicais X recifes de corais: no primeiro caso, pode-se chegar a 475 espécies vegetais e 25.000 espécies de insetos em um hectare de terra, mas em um hectare de recife de coral observa-se “apenas” 300 espécies de corais, 600 espécies de peixes e 200 espécies de algas.

Vários fatores podem, aparentemente, ter influenciado esta diferença, como a muito maior densidade da água quando comparada com a do ar, fazendo com que larvas e sinalizadores químicos sejam transportados com muito mais dificuldade no meio marinho do que no terrestre. Além disso, o maior calor específico da água (quantidade de calor para aumentar de 1 grau Celsius a quantidade de 1 g de água. No caso, 1 caloria) pode tornar os organismos marinhos menos funcionais quando do aumento da temperatura da água, uma vez que a possibilidade de dispersar o excesso de calor torna-se muito mais difícil. Desta forma, o ambiente terrestre seria muito mais propício para os processos adaptativos que regem o processo de evolução através da seleção natural.

Mas os fatores físicos são apenas algumas das justificativas que explicam o porquê da riqueza da biodiversidade terrestre ser tão maior do que a marinha. Com a “explosão” das plantas floríferas há cerca de 110 milhões de anos atrás, estas ocuparam praticamente todos os ambientes terrestres onde podiam se desenvolver. E, em paralelo, as espécies associadas a estas plantas, como de insetos, herbívoros e micro-organismos. Como a dispersão das espécies pelo ar é muito mais rápida e pode atingir longas distâncias, o surgimento de um número excepcional de espécies terrestres foi muito favorecido. Como a dispersão no meio marinho é muito mais difícil, as espécies marinhas tendem a viver de forma aglutinada, formando comunidades de alta densidade populacional – os recifes de corais. Nesta situação, as espécies que vivem intimamente associadas em recifes de corais se tornam particularmente vulneráveis a doenças, predação e fatores ambientais como aquecimento e ocorrência de desastres como maremotos e furacões. Tais fatos já foram extensivamente observados nos corais da região caribenha e das Bahamas, pois estão continuamente expostos a enormes furacões que movimentam as águas oceânicas de maneira extremamente agressiva, deixando um enorme rastro de destruição de corais e suas espécies associadas. São necessárias décadas para que tais recifes voltem a apresentar suas características originais. O mesmo vale para corais da Grande Barreira de Corais da Austrália, que sofrem particularmente com efeito de branqueamento dos corais (morte de zooxantelas e outras cianobactérias) em decorrência de mudanças na temperatura da água bem como nas taxas de dissolução de CO2 na água do mar.

Outro fator que pode ter contribuído para um aumento significativo na biodiversidade terrestre é o aumento significativo na vascularização das plantas superiores com o passar dos anos. Tal fator levou a um aumento importante na biomassa das plantas, e pode ter contribuído para a ocupação de nichos ecológicos ainda disponíveis.

Porém, o quadro geral de distribuição de espécies terrestres e marinhas é um quadro aproximado. Isso porque ainda não se conhece praticamente nada sobre as espécies biológicas que habitam os oceanos profundos. Descobertas recentes indicam uma enorme diversidade de espécies únicas destes habitats inóspitos. Além disso, a importância em melhor se conhecer a distribuição das espécies na Terra se deve não somente para o conhecimento em geral. Muitas espécies apresentam características fisiológicas e anatômicas únicas, que possibilitam conhecer melhor o “sistema vivo” dos organismos, além de podermos esclarecer como a vida surgiu e evoluiu no nosso planeta.

Marton-Lefevre, J. (2010). Biodiversity Is Our Life Science, 327 (5970), 1179-1179 DOI: 10.1126/science.1188424

Marton-Lefevre, J. (2010). Biodiversity Is Our Life Science, 327 (5970), 1179-1179 DOI: 10.1126/science.1188424

Pennisi, E. (2010). On Rarity and Richness Science, 327 (5971), 1318-1319 DOI: 10.1126/science.327.5971.1318

Pennisi, E. (2010). On Rarity and Richness Science, 327 (5971), 1318-1319 DOI: 10.1126/science.327.5971.1318

MAY, R. (1988). How Many Species Are There on Earth? Science, 241 (4872), 1441-1449 DOI: 10.1126/science.241.4872.1441

MAY, R. (1988). How Many Species Are There on Earth? Science, 241 (4872), 1441-1449 DOI: 10.1126/science.241.4872.1441

Hassell, M., Comins, H., & May, R. (1994). Species coexistence and self-organizing spatial dynamics Nature, 370 (6487), 290-292 DOI: 10.1038/370290a0

Hassell, M., Comins, H., & May, R. (1994). Species coexistence and self-organizing spatial dynamics Nature, 370 (6487), 290-292 DOI: 10.1038/370290a0

O desenvolvimento sustentado é possível?

O têrmo “desenvolvimento sustentado” engloba vários conceitos sobre a relação entre a governabilidade e a sociedade e natureza. Constitui em se estabelecer formas de planejamento e modos de atuação valorosos e virtuosos, quase como um movimento social. Sendo assim, o “desenvolvimento sustentado” atraiu a atenção tanto de revolucionários como de reacionários, que atuam de forma divergente, sem que, contudo, se manifestem abertamente contra a sustentabilidade. A forma de se questionar a sustentabilidade se baseia, fundamentalmente, em questionar se mudanças são ou não realmente necessárias. O conhecimento destas táticas conservadoras permite sua análise e também conhecer o potencial de certas iniciativas de governabilidade, gestão e convivência em ambientes sociais, e também como o emprego de tais argumentos contribuem para reforçar barreiras de comunicação entre grupos com visões sociais distintas.

Qual a importância da sustentabilidade e do desenvolvimento sustentado? Principalmente em criar formas diferentes de se resolver problemas e de diálogo entre “partes” aparentemente opostas, que incluem diversos setores da sociedade e do governo. A sustentabilidade traz consigo uma reorganização dos poderes e das instituições administrativas, com ênfase em abordagens participativas e integrativas. De tal forma que a análise dos prospectos de sustentabilidade deve ser muito cuidadosa, de maneira a não ser corrompida por falsas premissas básicas, que buscam apenas a atender determinados setores sociais ou interesses de grupos segmentados.

Uma maneira muito questionável de se analisar os preceitos e as maneiras de se promover a sustentabilidade é de acordo com a filosofia pragmática, a qual, na verdade, deve ser muito mais uma forma de se implementar ações do que de análise. A adoção do pragmatismo como base de análise torna muito difícil de discernir quais pontos são realmente verdadeiros para se avaliar a sustentabilidade, bem como o que é realmente bom e possui valor moral neste contexto. Sendo assim, é absolutamente necessário se deixar o pragmatismo de lado e se ampliar o escopo da análise de processos de sustentabilidade, com membros da sociedade aptos a promover tais questionamentos e trazer à luz o conhecimento aliado a tais questionamentos. A adoção de uma “filosofia pragmática” pode ser questionável por sempre trazer a suspeita de que “há sempre algo suspeito sob o sol”, quando tal discussão é trazida por um número crescente de participantes aptos a apresentarem seus diferentes pontos de vista sobre o desenvolvimento sustentado.

A sustentabilidade por si só deve ser um conceito pragmático se for para se implementar mudanças para a reorientação das práticas sociais futuras. O problema é que o conceito “sustentabilidade” apresenta uma relação ambígua com o conceito “mudança”. Até há pouco tempo, o conceito de sustentabilidade estava um unicamente relacionado à conservação de recursos naturais. O problema é que esta maneira de pensar implica em se criar formas de manter os recursos naturais intocados e inexplorados, para que não sejam “danificados”. Ora, tal forma de se considerar o desenvolvimento sustentado vai contra a sua essência, que é a da experimentação, do aprendizado, da restauração e da melhoria das relações, muito mais do que de simplesmente se “manter inalterado e intocado” o acesso e utilização racional dos recursos naturais. Um dos maiores desafios da sustentabilidade é de se promover o “pensamento social”, de maneira a se minimizar interesses individuais e de certos setores em favor daqueles de caráter muito mais amplo para a sociedade. Os argumentos conservadores objetivam simplesmente deixar de lado tal forma de se criar maneiras integradas para proposições para a sustentabilidade.

Assim, setores sociais conservadores fazem uso de argumentos perversos, fúteis e de ameaças para descaracterizar a necessidade de mudança para promover o desenvolvimento sustentado.

Argumentos de perversidade são aqueles que são empregados para dizer que tudo pode apenas piorar e, no contexto da sustentabilidade, apenas tornar todo o processo ainda mais insustentável. Os argumentos de perversidade sustentam que a maneira de se promover a sustentabilidade é contra o desenvolvimento e apresenta perigo para o neoliberalismo. Setores conservadores fazem amplo uso de argumentos com a lógica da perversidade, em favor da governabilidade. Assim, por exemplo, dizer que a sustentabilidade pode ser o principal entrave para o desenvolvimento é um argumento perverso, uma vez que bloqueia qualquer outra possibilidade de se promover desenvolvimento. Porém, pelo contrário. As abordagens de governabilidade sustentada que se baseiam em parcerias tornam mais efetivas a utilização de diferentes recursos, formas de conhecimento e de entendimento, de maneira a encontrar novas soluções para capacitar aqueles que buscam o desenvolvimento sustentado como verdadeiros experimentadores. Somente desta maneira é possível se conhecer novas idéias, valorizar estas idéias e modelar novas práticas conforme tal abordagem integrativa, e não em normas regulatórias.

Ao argumentar em termos de “governabilidade”, a abordagem perversa pode atingir seu extremo. Esta estratégia objetiva aumentar a efevitidade e o escopo regulatório, impingindo regras, leis e conformidades, com a proposta de defender “os interesses púbicos”. Assim, em vez de promover a integração entre os interesses públicos e cívicos em longo prazo, o resultado é que os diferentes setores sociais são levados a agir como corporações para defender seus próprios interesses. Perde-se a essência da relação governo-cidadão, e tal relação é reduzida a seu mínimo denominador comum. Embora nefasto, o argumento da perversidade pode eventualmente levar a algumas ações de sustentabilidade positivas, como aquelas identificadas pelos movimentos NIMBY (Not In My Backyard – não no meu quintal), LULU (Locally Unwanted Land Uses – Usos da terra localmente indesejados) e BANANA (Build Absolutely Nothing Anywhere Near Anything – Não construir nada em local nenhum perto de qualquer coisa). Tais ações são de confrontação, teatrais e às vezes litigiosas. Por isso, é melhor que as propostas de projetos de sustentabilidade sejam apresentadas de maneira explícita, enfatizando novas parcerias e formas de consenso, de maneira a que a governabilidade não perca uma forma efetiva e confiável de mudança.

O argumento da futilidade se baseia na assertiva francesa de que “plus ça change, plus c’est la même chose” (quanto mais se muda, mais tudo fica do mesmo jeito). O argumento da futilidade sustenta que a participação social não têm o menor impacto nas decisões a serem tomadas. Que inovações nos modos de participação social no govern

o são inefetivas, pois não conseguem romper as barreiras entre diferentes grupos, e que só servem para reforçar tais desigualdades e limitações de pensamento e comportamentos, bem como as diferenças nas trocas de experiência e de percepções da realidade. Ou seja, que a participação têm eficácia limitada na mudança de diretrizes. E, ainda, que promover estudos e avanços em agendas específicas são fúteis porque os governos não conseguem incorporar tais mudanças e transferi-las em estratégias e ações efetivas de sustentabilidade.

Na verdade, a lógica de futilidade é que é fútil, por considerar que a sustentabilidade só é válida de resultar na mudança de regras, leis e diretrizes. Tentar estabelecer listas de prioridades, áreas e maneiras específicas de atuação sustentada é, de acordo com o próprio princípio da futilidade, uma estratégia ingênua, dúbia e limitante. A resposta para o problema da sustentabilidade como um todo deve ser considerada de maneira integrativa e incrementativa, sem limites definidos. Portanto, o argumento da futilidade apenas tenta reforçar que estamos andando, sem sair do lugar.

O argumento da ameaça, ou do perigo, tenta mostrar que a emergência de um novo paradigma de uma forma de desenvolvimento sustentável é verdadeiramente diabólica. Tenta mostrar que se caminharmos para maneiras holísticas e integrativas de sociedade sustentada poderemos perder tudo o que conquistamos até aqui. O argumento da ameaça tem por objetivo mostrar que a ênfase no holismo e integração do desenvolvimento sustentado é um caminho para se evitar o aprofundamento das formas de proteção necessárias para a preservação ambiental.Tal argumento se baseia no princípio de que a mesma quantidade de capital (econômico, social, cultural, etc) deve ser transferida de geração para geração, e que é absolutamente ingênuo se pensar que a atividade econômica não deve nunca prejudicar o meio ambiente. Não leva em consideração que a natureza deste capital está sob constante mudança, e que não pode ser substituída. Que deve permanecer constante, de maneira a preserva a riqueza e proteção, para se evitar perturbações no status quo e no sistema vigentes.

O argumento da ameaça sustenta que uma sustentabilidade forte ainda deve ser desenvolvida do ponto de vista político para se tornar palatável. Que uma sustentabilidade fraca é a única maneira de se adotar princípios de sustentabilidade em um mundo de compromissos políticos. E que uma sustentabilidade forte pode levar à destruição aqueles elementos sociais sobre os quais tudo deve se manter. Ainda, tenta questionar se realmente sabemos como nos planejar e agir de maneira integrativa para que nunca tenhamos perdas. Ou seja, que em um modelo de sociedade sustentável possamos sempre satisfazer nossas vontades, tanto do ponto de vista financeiro como social e ambiental. Um modelo sustentável seria apenas válido se fosse aplicado a pequenos ajustes de desempenho financeiro. Tal é o modelo de sustentabilidade adotado pela China – só pode ser aplicado se for sem perdas econômicas e financeiras.

O problema em querer se implementar tal forma de sustentabilidade fraca, que atende às necessidades de mercado, é que é praticamente impossível se estabelecer uma justa medida entre grupos econômicos, grupos sociais, entre nações. Não é possível que todos os elementos sociais possam ter sempre todas suas necessidades atendidas, em seu mais alto nível. Tentar se estabelecer, arbitrariamente, uma “justa medida de satisfação e felicidade” para se promover o progresso, apenas reforça a identidade do “Grande Irmão”, e de formas de controle. A engenharia social servirá sempre para atender apenas aos interesses daqueles que estão no poder, mas nunca para promover uma real integração dos diversos setores sociais.

Cientistas sociais devem se debruçar sobre as questões que envolvem modelos de desenvolvimento sustentado, de maneira a conhecer e disseminar conhecimento das formas como relações culturais e sociais podem ser utilizadas para melhor se aproveitar os recursos naturais. Embora a natureza possa prescindir totalmente da existência da espécie humana, é a humanidade que determina os caminhos do verdadeiro desenvolvimento sustentado. É imperativo que os diversos setores sociais possam atuar de maneira determinante, junto ao governo e aos órgãos governamentais, de maneira a contribuir para a construção de tal modelo. Se não investirmos esforços consideráveis nesta direção, os esforços em busca de melhor qualidade e condições de vida correrão sérios riscos de serem perdidos e, consequentemente, de todas as implicações em que tais esforços resultam: instituições democráticas, filosofia de paz e tolerância, o real sentido de justiça social, reparação e reconcialiação, e o reconhecimento dos direitos de grupos sociais marginalizados.

A tomada do conhecimento dos argumentos de perversidade, futilidade e de ameaça de setores sociais conservadores não deve levar à animosidade, e sim ao questionamento contínuo sobre o real valor de tais argumentos. Afinal, o conceito de sustentabilidade não pode ser erigido em pseudo-concepções idealistas, tais como de ecotopias e sociedades ideais, e sim em princípios de diversidade e mudança. Uma análise interdisciplinar efetiva sobre um modelo de sustentabilidade deve levar em conta os prós e contras argumentos de viabilidade de vários ideais, bem como uma crítica fundamentada de visões de mundo muitas vezes opostas, que considere com seriedade a ausência de um cenário que seja necessariamente melhor ou a única saída para a resolução de inúmeros impasses atuais.

O argumento da futilidade deve ser continuamente identificado e combatido, por promover uma falsa visão de que, se problemas atuais não podem ser resolvidos de maneira eficaz, efetiva e rápida de acordo com um modelo de sustentabilidade, logo tal modelo deve ser abandonado. Sobretudo, o desenvolvimento de um modelo de sustentabilidade deve se basear no aprendizado contínuo de como pode ser construído, uma vez que até hoje nunca foi real objeto de consideração por parte dos governos e da sociedade. Já “a ameaça” pode resultar da implementação de mudanças por demais radicais. Etapas já conquistadas devem ser valorizadas, e incluem inclusive o aprendizado social de práticas de sustentabilidade.

Uma verdadeira filosofia de sustentabilidade implica em uma contínua ação unificadora. Porém, como a diversidade de abordagens de sustentabilidade, de acordo com o contexto social, político e econômico em que se inserem, pode levar a um quadro de análise complexo, é absolutamente necessário que se reforcem estudos e pesquisas sobre tais abordagens. Uma abordagem de sustentabilidade pragmática deve mostrar as claras distinções entre possíveis caminhos para a realização de mudanças e a simples manutenção do status quo. E, o que é muito mais difícil, indicar formas de distinguir a qualidade da mudança ou de preservação que está implícita nas diferentes estratégias de sustentabilidade.

Considerando-se que a solução para os defeitos da democracia é mais democracia, a promoção da educação, do esclarecimento, da verdadeira troca de idéias prospectiva leva unicamente ao reforço do conhecimento sobre a verdadeira democracia, que deve estar sobre um processo de crítica constante, bem como de renovação de suas manifestações políticas.

Esta é uma tradução livre e apreciação do artigo citado abaixo. Muito bom.

Holden, M. (2010). The Rhetoric of Sustainability: Perversity, Futility, Jeopardy? Sustainability, 2 (2), 645-659 DOI: 10.3390/su2020645

Somente para viciados

Descobrir onde tomar um bom café, em viagens por este mundo sem fim, pode ser um bom desafio. No ano passado, em Fortaleza, durante a Reunião Anual da Sociedade Brasileira de Química, por exemplo, havia um bom café expresso dentro de uma sorveteria. Virou ponto antes de ir assistir às apresentações do congresso. Nos EUA também não é fácil. O café do Starbucks não é fantástico (mas me disseram que as lojas de São Paulo tiveram que melhorar a forma de tirar café, para se adaptar aos paulistanos, exigentes tomadores de café). Há 11 anos, Vancouver (Canadá) tinha uma loja do Second Cup no campus da UBC com um excelente expresso duplo.

Café vicia? Acho que sim. E o consumo exagerado pode causar inúmeros problemas. O verbete da Wikipédia em inglês sobre a cafeína é bastante extenso e completo. Mas a melhor estória que conheço sobre café é de uma menina que vivia na Alemanha, nos idos de 1600-1700, e adorava café. Seu pai, muito preocupado com o hábito da filha, prometeu-lhe um casamento, desde que parasse de tomar a bebida. A menina, mais esperta que o pai, aceitou a proposta. Mas assim que conheceu seu pretendente, disse a ele que só se casaria se ele, o noivo, a deixasse tomar café depois que casassem. Uma trapaceira. Mas no fim todos concordam, filha, pai e noivo: café é uma bebida que, uma vez que se começa a tomar, é impossível de parar. Esta é a história da Cantata do Café, composta por Johann Sebastian Bach entre 1734 e 1735. Incluí a seguir a ária “Heute noch, lieber Vater” (“Ainda hoje, meu pai querido”), que infelizmente não é a melhor interpretação que já ouvi, pois a cantora canta ligeiramente atrasada com relação à orquestra. Em seguida, o coro final da cantata, “Die Katze läbt das Mausen nicht”, uma versão muito divertida que encontrei do YouTube.

A cantora Christiane Oelze, soprano, é a intérprete da Ária, com a Bach-Collegium Stuttgart sob a regência de Helmuth Rilling. O coro final é interpretado pela Freiburg Baroque Orchestra.

Gingko biloba: remédio?

Esta planta é amplamente utilizada na medicina oriental (Japão e China), onde foi e é empregada para o tratamento de tosse, asma bronquial e até bebedeira pesada. Fitofármacos (medicamentos que têm extratos vegetais por base) à base de G. biloba são dos mais utilizados no mundo, inclusive no Brasil, para o tratamento de insuficiência do fluxo sanguíneo, insuficiência cerebral, depressão, vertigens e tonturas, dores de cabeça, déficit intelectual. Porém, testes clínicos realizados com G. biloba, apesar de serem numerosos, são controversos. Ensaios realizados com idosos com sintomas da doença de Alzheimer não apresentaram resultados evidentes. O chá de G. biloba também é bastante utilizado, apesar de conter concentrações de ácidos ginkgólicos 80 vezes maiores do que as recomendadas. E muito provavelmente também contém a gingkotoxina.

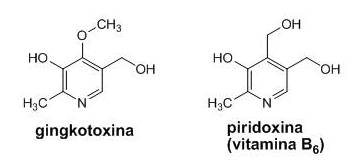

A gingkotoxina é formada na planta através de uma via bioquímica muito parecida com aquela que leva à formação da piridoxina, também conhecida por vitamina B6. Sendo assim, quando consumida em excesso, a gingkotoxina atua como um competidor da vitamina B6, uma vitamina essencial para o metabolismo dos aminoácidos. Indivíduos com carência de vitamina B6 apresentam dermatite (inflamação da pele), anemia, gengivite, feridas na boca e na língua, náusea e nervosismo.

No Japão, as sementes de G. biloba são consumidas como alimento, mas podem causar intoxicação com sintomas característicos. Tais intoxicações já foram registradas 70 vezes, das quais 27% levaram à morte. Foram particularmente freqüentes durante a 2ª Guerra Mundial, quando houve escassez de alimentos no Japão. Pacientes que ingeriram sementes de G. biloba apresentaram quadro convulsivo, com vômitos e falta de consciência. Outras plantas que também contém gingkotoxina, como espécies do gênero Albizzia, são responsáveis por inúmeros casos de intoxicação de gado na África.

Devido à sua similaridade com a vitamina B6, esta última é utilizada como antídoto em casos de intoxicação por gingkotoxina, que está presente não somente nas sementes, mas também nas folhas de G. biloba, muito utilizadas em fitoterapia. Além disso, vários medicamentos contém quantidades de gingkotoxina entre 11,4 e 58,5 mg, sendo que a quantidade máxima reocomendada para ingestão diária é de entre 0,09 e 11,9 mg. A ingestão continuada de medicamentos contendo gingkotoxina pode levar ao surgimento de quadros clínicos convulsivos de natureza epiléptica. A presença de gingkotoxina em fitomedicamentos e medicamentos comprovadamente atua em detrimento da saúde dos pacientes.

Desta forma, órgãos reguladores de saúde na Europa recentemente estabeleceram restrições na utilização, bem como obrigatoriedade de advertência na bula e na embalagem, de medicamentos à base de G. biloba. No Brasil e no mundo o consumo de fitomedicamentos contendo G. biloba é extremamente elevado. Talvez por desconhecimento dos potenciais danos à saúde que eventualmente o consumo desta planta pode causar.

Referências

L. C. Baratto, J. C. Rodighero e C. A. de Moraes Santos: “Ginkgo biloba: o chá das folhas é seguro?”. (revista Ciência Hoje)

Entrevista com Luís Carlos Marques, especialista em Fitoterapia, mestre em Botânica e doutor em Ciências. Professor do Departamento de Farmácia e Farmacologia da Universidade Estadual de Maringá.

Leistner, E., & Drewke, C. (2010). Gingko biloba and Ginkgotoxin, Journal of Natural Products, 73 (1), 86-92 DOI: 10.1021/np9005019

Leistner, E., & Drewke, C. (2010). Gingko biloba and Ginkgotoxin, Journal of Natural Products, 73 (1), 86-92 DOI: 10.1021/np9005019