O Universo nas últimas semanas

Na última semana de 2011, a colaboração Double Chooz, que estuda os antineutrinos do elétron emitidos pela usina nuclear francesa de Chooz e conta com participação brasileira, publicou online os resultados de sua medida do “ângulo de mistura θ13“, uma quantidade relacionada com o fenômeno chamado de oscilação, pelo qual os neutrinos de diferentes tipos podem se transformar em outros. O fato dos dados de Double Chooz, bem como de outros experimentos, o T2K e o MINOS, indicarem que esse ângulo e os demais são diferentes de zero é uma boa notícia, porque de acordo com a teoria isso permitirá aos físicos medirem outro parâmetro relacionado com a chamada “violação de carga-paridade”. Medir essa quantidade vai ajudar a explicar como a matéria se tornou diferente da antimatéria no início do universo e assim não foi aniquilada completamente.

O par de sondas Grail, da Nasa, começou a orbitar a Lua no fim de semana do réveillon. As sondas vão mapear o campo gravitacional da Lua com uma precisão que vai dar uma ideia da composição de seu interior. Seus também vão podem ajudar a entender porque a face que vemos da Lua tem um relevo suave enquanto o outro lado do satélite é montanhoso e testar a hipótese de que a Lua na verdade é fruto da colisão de dois satélites anteriores.

Em artigo na revista PNAS, pesquisadores confirmaram que a única amostra de quasicristal já encontrada na natureza deve ter origem extraterrestre. Sofia Moutinho, da Ciência Hoje, tem os detalhes.

Ainda no mundo dos minerais exóticos, um mineral descoberto primeiramente em uma amostra trazida da Lua por astronautas da Apolo 11, a tranquilitita, foi encontrada analisando rochas da Austrália com microscopia eletrônica. Os geólogos acreditam que o mineral deve certamente existir em outras partes do globo. As propriedades da tranquilitita permitem que se aplique nela um método para determinar a idade das rochas, baseado na lenta transformação de átomos de urânio em chumbo.

Um estudo de biomecânica publicado na Nature demonstrou com câmeras de alta velocidade e modelos matemáticos como uma cauda longa e flexível ajuda lagartos e robôs a cair e saltar agilmente, sem se desiquilibrar. O mesmo deve ter valido para dinossauros como o velociraptor. Veja o vídeo.

Em reportagem na Nature, Nicolas Jones destacada cinco experimentos de física tão insanamente difíceis e importantes quanto a busca por novas partículas elementares no LHC: 1) Detectar a composição atmosférica de exoplanetas já é possível para gigantes gasosos e super Terras usando os telescópios espaciais Hubble e Spitzer, e será possível para planetas do tamanho da Terra com o sucessor do Hubble, o James Webb. 2)Usar espectroscopia de altíssima precisar para buscar por diferenças na vibração de uma dupla de moléculas que são quase idênticas, cuja estrutura de uma é o espelho da outra pode revelar melhor como a força nuclear fraca distingue a esquerda da direita, o que vai ajudar a entender melhor tanto as forças fundamentais do universo, como o mistério de por que nos seres vivos só encontramos a versão canhota dessas moléculas. 3)Buscar por dimensões espaciais extras usando uma balança de torsão com precisão de bilionésimos de grau para medir desvios na força gravitacional em escala micrométrica. Até agora, experimentos de uma equipe da Universidade de Washington já verificaram que não existem dimensões extras maiores que 44 micrômetros. 4) Detectar ondas gravitacionais monitorando ao longo de dez anos os flashes de radiação que 20 pulsares emitem milhares de vezes a cada segundo. A ideia é procurar por desvios na frequência ultraprecisa desses pulsares causadas por ondas gravitacionais passando entre eles e a Terra, geradas por exemplo por pares de buracos negros gigantes em rota de colisão. 5) Redefinir o quilograma com base em uma constante fundamental da natureza, a constante de Planck, que físicos experimentais vêm medindo por dois métodos diferentes e chegando a resultados levemente diferentes.

Na mesma revista, Ron Cowen reporta como os teléscópios espaciais Corot e Kepler, famosos por suas descobertas de exoplanetas, também estão revolucionando o estudo do interior das estrelas por meio das ondas que propagam dentro delas e chegam a sua superfície e afetam seu brilho em uma parte em mil – a astrosismologia. Até agora, essas observações confirmam que as estrelas tem o tamanho esperado, mas a distribuição de suas massas é menor do que a teoria prevê. Observações do Kepler também permitiram examinar a evolução do interior de gigantes vermelhas, o tipo de estrela que o Sol deve se transformar daqui uns 5 bilhões de anos. Se a missão Kepler for estendida por mais alguns anos, será possível comparar os ciclos de atividade magnética do Sol com os de outras estrelas.

Também na Nature, um grupo de físicos descreve uma nova técnica para resfriar átomos presos em uma armadilha feita de raios laser entrecruzados, chamada de rede ótica. Diferente de outros métodos baseados em colisões aleatórias que removem átomos com maior energia, o novo método aplica uma série de modulações na luz laser e pode em princípio alcançar temperaturas abaixo do que é possível atualmente (menos que 10-12Kelvins)

Nanofio pode salvar indústria de computadores

Nos anos 1960, um dos fundadores da Intel, Gordon Moore, notou uma tendência na indústria eletrônica, que de tão bem comportada ganhou o nome de “lei de Moore“: o número de transistores que cabem dentro de um chip de circuito integrado dobra a cada dois anos mais ou menos. Essa miniaturização frenética chegou ao ponto que os componentes da última geração de microchips tem um tamanhos de 22 nanômetros, isto é, apenas 100 vezes o espaçamento entre os átomos do cristal de silício de que são feitos.

Nos anos 1960, um dos fundadores da Intel, Gordon Moore, notou uma tendência na indústria eletrônica, que de tão bem comportada ganhou o nome de “lei de Moore“: o número de transistores que cabem dentro de um chip de circuito integrado dobra a cada dois anos mais ou menos. Essa miniaturização frenética chegou ao ponto que os componentes da última geração de microchips tem um tamanhos de 22 nanômetros, isto é, apenas 100 vezes o espaçamento entre os átomos do cristal de silício de que são feitos.

Com os componentes chegando perto da escala atômica, a lei de Moore está próxima de ser quebrada. Isso porque as leis clássicas da eletrônica, que tratam os elétrons da corrente elétrica como bolinhas, não devem funcionar direito na escala atômica, em que os elétrons também podem se comportar como ondas, interferindo uns com os outros. Além disso, físicos e engenheiros esperam que à medida que a espessura dos fios interconectando os componentes dentro dos microchips ultrapasse a marca dos 10 nanômetros, a sua resistência – uma medida de quanto o material impede o movimento dos elétrons da corrente elétrica – aumentará exponencialmente devido ao aumento da razão entre área e volume dos fios – os elétrons na superfície dos fios perderiam muito mais energia para o meio externo. A indústria eletrônica precisaria reformular todo o seu processo de produção ao alcançar essa escala.

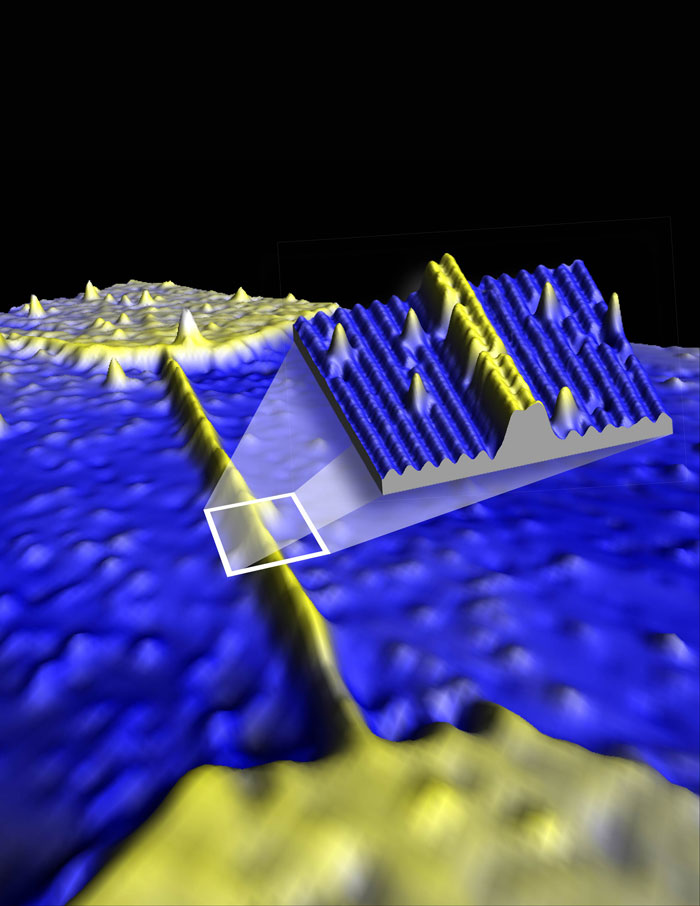

Mas de acordo com uma pesquisa publicada ontem na revista Science, parece que a lei de Moore pode ser mantida por mais duas ou três gerações a mais do que se pensava. Uma equipe internacional de onze pesquisadores coordenada por Bent Weber e Michelle Simmons da Universidade da Nova Gales do Sul, Austrália, conseguiu criar nanofios feitos de até quatro fileiras de átomos de fósforo (1,5 nanômetro de largura). O fósforo tem um elétron a mais que o silício, funcionando como um fio condutor de eletricidade imerso em um cristal de silício. Surpreendentemente, a resistência desses fios não cresce exponencialmente mas linearmente, obedecendo a clássica lei de Ohm, V = RI, onde V é o potencial elétrico entre as extremidades do fio, I é a corrente elétrica e a constante R é a resistência. A leis da eletrônica clássica também ditam que R é proporcional ao comprimento do fio e inversamente proporcional a sua área.

Para criar os nanofios, os pesquisadores esculpiram vários canais nanométricos em um cristal de silício, usando a ponta de um microscópio de varredura por tunelamento para depositar os átomos de fósforo nesses canais. Em seguida, cobriram tudo com outra camada cristalina de silício, isolando os nanofios de efeitos de superfície que poderiam diminuir suas propriedades condutoras.

Os cinco fios de comprimentos diferentes produzidos obedeceram a leis convencionais da eletrônica, conduzindo eletricidade com uma eficiência comparável a dos melhores interconectores de cobre usados nos microprocessadores atuais. O segredo da manutenção da lei de Ohm na escala atômica, de acordo com David Ferry, da Universidade Estadual do Arizona, EUA, que escreveu um comentário sobre a pesquisa na Science, está na alta densidade de átomos de fósforo que os pesquisadores obtiveram. O átomos de fósforos apinhados aumentam a densidade dos elétrons, o que provoca colisões e o espalhamento deles, desfazendo os fenômenos ondulatórios que alterariam a lei de Ohm.

Embora valha com uma demonstração de que é possível estender as leis da eletrônica a escalas atômicas, a técnica usada pelos pesquisadores ainda não pode ser usada em processos industriais, que imprimem circuitos inteiros no silício.

Na verdade, grupo de Simmons não está interessado na eletrônica convencional. Eles esperam usar os átomos individuais de fósforo como bits quânticos que poderiam ser interconectados pelos nanofios no circuito de um computador quântico. Mas Ferry duvida que isso seja possível, uma vez que o fenômeno ondulatório chamado de coerência, destruído nos nanofios, é essencial para a computação quântica.

Fontes: Nature, Sci Am, Physics World, New Scientist

Referências

Weber, B., Mahapatra, S., Ryu, H., Lee, S., Fuhrer, A., Reusch, T., Thompson, D., Lee, W., Klimeck, G., Hollenberg, L., & Simmons, M. (2012). Ohm’s Law Survives to the Atomic Scale Science, 335 (6064), 64-67 DOI: 10.1126/science.1214319

Neutrinos mais rápidos que a luz cada vez mais difíceis de explicar

Rastro deixado por múon de alta energia nos detectores do observatório IceCube. Crédito: icecube.wisc.edu

Mais uma vez os neutrinos mais rápidos que a luz esbarraram com a física conhecida. E dessa vez a trombada foi feia, muito pior que das outras vezes. Uma nova análise do polêmico resultado do experimento OPERA, cujo anúncio em setembro deste ano deixou tanto o público quanto a comunidade dos físicos em estado de choque, confrontou as conclusões do experimento com princípios básicos do movimento das partículas elementares, tais como a conservação da energia e do momento, assim como os dados de diversos experimentos espalhados pelo mundo, que detectam os neutrinos criados na colisão dos raios cósmicos com átomos da atmosfera da Terra. A conclusão da análise foi que, mesmo se a teoria da relatividade de Einstein, que proíbe a existência de partículas mais rápidas que a luz, não for totalmente verdadeira, mas apenas uma boa aproximação da realidade, mesmo assim os neutrinos mais rápidos que a luz supostamente detectados pelo OPERA não deveriam existir.

O físico Ramanath Cowsik, da Universidade Washington, em Saint Louis, no Missouri (EUA), junto com seus colegas Shmuel Nussinov e Utpal Sarkar, descobriram que o problema com os neutrinos mais rápidos que a luz começa exatamente quando eles são formados. No polêmico experimento, esses neutrinos nascem na Suíça a partir de um feixe de prótons em um laboratório do CERN. Quando os prótons colidem com um alvo de carbono, parte da sua energia se transforma em partículas chamadas mésons, principalmente os do tipo chamado píons, que viajam por um túnel a vácuo guiadas por um campo magnético, até que em um dado momento essas partículas se transformam em múons (uma espécie de elétron gordo e de vida curta) e neutrinos do múon. Esses neutrinos seguem debaixo da terra por 730 km, atravessando os Alpes, até colidirem com os detectores do OPERA, instalados a 1.400 metros de profundidade, no Laboratório Nacional de Gran Sasso, próximo a Roma, na Itália. A questão toda é o fato desses neutrinos terem chegado em média 60 nanossegundos antes que a luz demoraria para percorrer o mesmo caminho.

Fora a possibilidade de que haja um erro desconhecido nessa medida, um erro tão sutil que mesmo depois de meses de checagem e rechecagem nenhum dos 160 físicos que trabalham no experimento o tenha conseguido identificar, a explicação mais simples proposta até a agora é a de que a teoria da relatividade de Einstein não seja exatamente correta. Assim como hoje sabemos que, embora extremamente úteis, as leis do movimento da teoria da mecânica clássica de Isaac Newton são apenas aproximações válidas em certas circunstâncias, derivadas das leis da teoria da relatividade, a própria teoria da relatividade seria a aproximação de uma teoria desconhecida.

Mesmo sem saber os detalhes dessa teoria desconhecida, os físicos podem calcular as consequências de se considerar a relatividade uma aproximação. O coração da relatividade é uma estrutura matemática chamada de simetria ou invariância de Lorentz. Essa simetria implica que as leis da física são as mesmas para observadores em movimento uniforme e que a velocidade da luz é a mesma para qualquer observador. A ideia é que a teoria desconhecida resultaria em uma pequena quebra nessa simetria. Einstein estaria errado, mas só um pouquinho. A medida do movimento superluminal dos neutrinos do OPERA, por exemplo, sugere que a invariância de Lorentz seja violada em aproximadamente uma parte em cem mil.

O que Cowsik e seus colegas fizeram foi calcular qual seria o efeito de uma violação da invariância de Lorentz na transformação dos píons em múons e neutrinos do múon. O cálculo deles é simples de fato, assumindo apenas coisas bem básicas como a conservação da energia e do momento linear. A conclusão, publicada em 24 de dezembro na revista Physical Review Letters (preprint), é que quanto mais os neutrinos viajam mais rápidos que a luz, mais tempo os píons demoram para se transformarem, e uma fração cada vez menor da energia dos píons é transferida aos neutrinos.

Eles calcularam que, se o tamanho da violação da invariância de Lorentz for mesmo a sugerida pelo resultado do OPERA, o tempo de vida dos píons seria seis vezes maior que o observado, além do que não seriam observados neutrinos superluminais com energias maiores 5 GeVs. Os neutrinos detectados pelo OPERA, porém, tinham energias em torno de 20 GeVs, o que mostra que o resultado experimental não é consistente com premissas da física ainda mais fundamentais que as da teoria da relatividade.

Além disso, o trio de físicos resolveu comparar seus cálculos para os píons com os dados da detecção de múons e neutrinos do múons produzidos a partir de píons originados na colisão de raios cósmicos com átomos da atmosfera. Em particular, compararam seus cálculos com resultados recentes do maior telescópio de neutrinos em atividade, o gigantesco IceCube, localizado no Pólo Sul. E o resultado foi que, se existe mesmo uma violação da invariância de Lorentz, ela não deve ser maior que uma parte em mil bilhões, isto é, pelo menos cem milhões de vezes menor que a violação que resultado do OPERA sugere.

Os cálculos deles também mostraram que a situação só piora se essa violação da invariância de Lorentz depender da energia do neutrino, o que deveria acontecer para compatibilizar a medida do OPERA com outra medida da velocidade dos neutrinos, feita em 1987. Naquele ano, o experimento japonês Kamiokande detectou os neutrinos vindos da explosão de uma estrela na Grande Nuvem de Magalhães, a 168 mil anos-luz daqui, a supernova 1987A, e verificou que os neutrinos não viajam mais rápidos que a luz (se a velocidade dos neutrinos fosse a medida pelo OPERA, as partículas teriam chegado quatro anos antes na Terra). A energia dos neutrinos da 1987A, porém, era mil vezes menor que a dos neutrinos do OPERA, o que abre a possibilidade de que a violação dependa da energia. Mas essa mesma dependência não permitiria que os neutrinos superluminais de alta energia se formassem, de acordo com os cálculos de Cowsik e colegas, o que novamente torna o resultado do OPERA inconsistente com as leis da física.

Essa não é a primeira demonstração de que os neutrinos superluminais não podem ser explicados por uma violação da invariância de Lorentz. Em um trabalho semelhante publicado em outubro na Physical Review Letters (preprint), Andrew Cohen e Sheldon Glashow, ambos da Universidade de Boston, EUA, demonstraram que neutrinos superluminais tenderiam a perder energia ao longo do caminho, emitindo pares de elétrons e pósitrons (a antipartícula do elétron), de maneira semelhante a geração da onda de choque produzida por um avião quando quebra a barreira do som. Pelos cálculos de Cohen e Glashow, o OPERA não deveria detectar neutrinos com energias superiores a 12 GeVs, sendo que de fato alguns dos neutrinos chegavam a ter energias maiores que 40 GeVs. Outro experimento em Gran Sasso, o ICARUS, buscou por sinais da emissão de elétrons e pósitrons e nada encontrou.

Ao que parece, uma violação simples da invariância de Lorentz está descartada para explicar as medidas do OPERA. Como Cowsik e colegas comentam em seu artigo, pode ser que a violação tenha uma dependência da energia com termos matemáticos que precisamente cancelem o efeito que eles descobriram, mas isso soa bastante improvável. Se a medida do OPERA for confirmada, a física talvez passe por uma grande revolução, que no entanto manterá a relatividade de Einstein intacta.

***

P.S.: Pouco antes de publicar esse post encontrei este artigo interessante, em que os autores notam que todos os efeitos descritos acima que tornam o resultado do OPERA absurdo não existiriam se em vez da simetria de Lorentz ser quebrada, ela seja levemente deformada. Esse é um cenário teórico que alguns dos autores desse paper, os físicos Lee Smolin e Giovanni Amelino-Camelia vêm investigando há alguns anos, inclusive buscando por sinais de deformação na simetria de lorentz em observações de raios X, raios gama e raios cósmicos de altíssima energia vindos de explosões cósmicas extremas, até agora sem sucesso.

Referências:

Cowsik, R., Nussinov, S., & Sarkar, U. (2011). Superluminal Neutrinos at OPERA Confront Pion Decay Kinematics Physical Review Letters, 107 (25) DOI: 10.1103/PhysRevLett.107.251801

Partículas elementares: Quando alguma coisa pode ser nada, e nada pode ser alguma coisa

Nas últimas semanas, três experimentos diferentes com partículas elementares causaram sensação divulgando análises de seus resultados, dois deles com direito a destaque no New York Times. De longe o mais popular de todos foi a notícia de que físicos do Fermilab, nos EUA, acreditam que uma anomalia em seus dados pode ser uma nova e revolucionária força da natureza, mas também pode ser… nada. Já a segunda notícia destacada no NYT, foi a de que os pesquisadores envolvidos na procura mais sensível feita em busca das partículas que formariam a misteriosa matéria escura anunciaram ter encontrado… nada. E a terceira notícia, que até onde vi apareceu apenas na Wired e no blog do David Harris, foi a de que o maior detector de neutrinos do mundo, o único capaz de detectar essas partículas vindas das explosões mais poderosas do universo, achou… nada.

Geralmente é frustrante noticiar que nada foi descoberto. Talvez por isso o público e a imprensa tenham vibrado tanto com o anúncio do Fermilab, mesmo que as chances de que a descoberta tenha algum significado sejam muito pequenas, enquanto os dois outros resultados, embora nulos, tenham mais chance de serem confirmados, especialmente a notícia que passou desapercebida pelo NYT.

Senão, vejamos um resumo de cada uma delas.

***

Nova física ou só uma flutuação estatística?

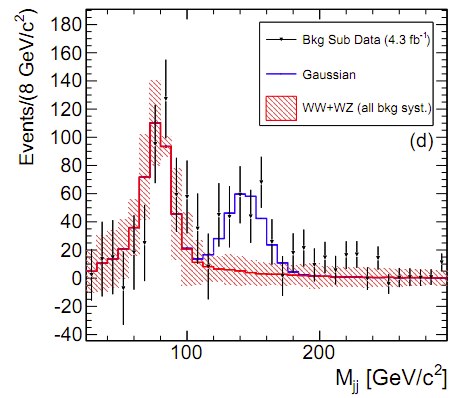

Físicos analisaram 10 mil colisões entre prótons e antiprótons registradas pelo detector CDF, do acelerador de partículas Tevatron, do Fermilab, nos EUA, que resultaram em uma partícula pesada conhecida como bóson W e dois jatos de quarks. A teoria mais aceita para as partículas elementares, o chamado Modelo Padrão, prevê que quanto maior a energia dos jatos, menos deles devem aparecer, isto é, o número de jatos detectados deve cair com a energia. Mas em torno da energia de 145 gigaeletrovolts parece haver um sutil pico de eventos (marcado em azul nos dados do gráfico acima, extraido do artigo original pelo blog Cosmic Variance), sugerindo que jatos extras foram produzidos.

Em 250 dessas colisões, os autores da análise acreditam que os jatos de quarks podem ter sido produzidos por uma nova partícula subatômica pesada, criada por uma nova força fundamental da natureza, além das quatro conhecidas. A tal força, segundo a análise, poderia ser explicada por uma velha teoria alternativa a do bóson de Higgs para explicar a massa de todas as partículas, conhecida como tecnicolor. Em vez de interagirem com o hipotético campo de Higgs, as partículas ganhariam suas massas interagindo com os “tecniquarks” do campo tecnicolor.

Seria a descoberta de física de partículas mais surpreendente das últimas décadas, exceto que é bem provável que seja apenas uma flutuação estatística. A chance é de uma em mil, ou “um intervalo de confiança de 3 sigma” no jargão dos físicos experimentais. Pode parecer pequena, mas nas investigações do resultado de colisões subatômicas, todo cuidado é pouco. Existem zilhões de maneiras de se cometer erros no experimento, há muito ruído de fundo, além do que, dada a natureza probabilística da mecânica quântica há margem para os resultados variarem e, vez ou outra, essas flutuações podem ser grandes o bastante para serem confundidas com o sinal de uma nova partícula. Sinais estranhos de “3 sigma” como esse já foram vistos e depois descartados. Por isso, o padrão oficial para se levar a sério um sinal desses é que a chance dele ser uma flutuação estatística seja de 1 em um milhão, ou “um intervalo de confiança de 5 sigmas”. A equipe do outro detector do Tevatron, o DZero deve divulgar as suas análises de dados parecidos nas próximas semanas. E logo os detectores do LHC devem confirmar ou descartar o achado (há rumores de que um dos detectores do LHC, o ATLAS analisou colisões parecidas e não viu nada…)

(Fontes adicionais: LA Times, New Scientist, Boing Boing)

***

Nada de matéria escura, por enquanto

Para explicar o movimento das galáxias e a evolução do Universo, a maioria dos físicos acredita que 80% da matéria do Universo seja um gás rarefeito, sentido pelo resto do cosmo na maior parte do tempo apenas pela sua força gravitacional. Essa chamada matéria escura seria feita de partículas conhecidas por WIMPS (da sigla em inglês para partículas massivas fracamente interagentes).

Considerado o maior e mais sensível detector de matéria escura, o experimento XENON 100 é um tanque cheio com 62 quilogramas de xenônio líquido no laboratório subterrâneo na montanha de Gran Sasso, na Itália, embaixo de 1400 metros de rocha, para evitar que raios cósmicos normais interfiram com o experimento. Se os WIMPS existem, há uma chance de que alguns deles atinjam os núcleos de xenônio do experimento, os fazendo ionizar e emitir luz que seria captada pelos detectores do XENON 100.

A física Elena Aprile, da Universidade de Columbia, EUA, e seus colaboradores, publicaram online um paper submetido ao Physical Review Letters, com a análise de 100 dias de busca do XENON100, entre janeiro e junho de 2010. Encontraram 3 eventos candidatos, mas a chance de que esses sejam provocados pela interferência da radiação ambiente na eletrônica do equipamento é muito alta. Cautelosos, os pesquisadores afirmam portanto que não encontraram matéria escura nenhuma.

Isso não quer dizer que a matéria escura não existe, mas apenas que ela é mais difícil de se detectar do que se imaginava. O resultado implica que a matéria escura interage cinco vezes menos com a matéria normal do que se acreditava. Isso significa que, se as partículas de matéria escura realmente existem, então serão precisos detectores ainda maiores que os atuais para encontrá-las. O XENON100 deve passar por uma ampliação de uma tonelada a mais de xenônio que vai torná-lo 100 vezes mais sensível.

Os resultados contradizem o de outros experimentos parecidos, mas menores – o italiano DAMA e o norte-americano CoGeNT – cujos pesquisadores afirmavam ter encontrado evidências de WIMPS. O físico Juan Collar, do CoGeNT, disse a revista Nature que desconfia de erros na metodologia do XENON100 e espera examinar os resultados com mais cuidado.

(Fontes adicionais: Science News, Physics World, S

cienceNow)

***

Nada de neutrinos vindos de GRBs (por enquanto ?)

Explosões de raios gama (GRB, em inglês) são os eventos mais luminosos do universo, durando poucos segundos e que todo dia são detectadas aqui na Terra. As teorias mais aceitas para a sua origem são a explosão de estrelas gigantes ou a colisão de estrelas de nêutrons ou buracos negros. Essas explosões acelerariam elétrons, que por sua vez emitiram raios gama. Também acelerariam prótons que seriam a fonte dos raios cósmicos mais energéticos observados na Terra, alguns 100 milhões de vezes mais energéticos que as partículas produzidas no LHC. Antes de saírem da zona da explosão, esses prótons interagiriam com os raios gama, gerando neutrinos energéticos que seriam em princípio detectáveis aqui na Terra.

Neutrinos são extremamente difíceis de detectar, porém. Quase não têm massa e interagem muito pouco com a matéria normal, pois são imunes à força eletromagnética e a força nuclear forte. Eles são produzidos em reatores nucleares, no interior da Terra, no Sol e em outros fenômenos astrofísicos, e a imensa maioria deles nos atravessa em linha reta, sem deixar vestígio. Mas eles são muitos, felizmente, e um ou outro colide com um núcleo atômico de vez em quando.

O IceCube, que foi terminado em dezembro de 2010, é o maior detector de neutrinos já construído. É uma rede cúbica quilométrica de 5160 fotodetetores enterrados a uma profundidade entre 1,5 e 2,5 quilômetros no gelo da Antártica, bem próximo ao polo Sul. Ocasionalmente, um neutrino colide com um dos átomos do gelo e cria uma partícula carregada, o múon, que emite luz à medida que se move no gelo, captada pelos foto detectores.

Em artigo publicado na Physical Review Letters, a equipe do IceCube descreve como comparou 13 meses de seus dados coletados com metade de sua rede com observações de 117 GRBs observados durante o período por telescópios espaciais. De acordo com a teoria, o IceCube esperava detectar pelo menos 3 neutrinos. Mas nenhum neutrino foi detectado dentro de meia hora depois de cada GRB, e mesmo depois desse intervalo de tempo, nenhum dos neutrinos detectado tinha a energia esperada.

Isso significa que os modelos para GRB estão errados? O IceCube está apenas começando a funcionar com sua rede completa. Se o experimento continuar não observando esses neutrinos nos próximos dois anos, a coisa vai ficar feia para o lado dos teóricos…

(Fonte adicional: Physics)

***

[P.S. : Neutrinos, aliás, tem uma história de balançar as bases de nossas teorias sobre o Universo, como você pode conferir neste texto em inglês bem divertido de Ann Finkbeiner. A autora chama atenção para outro mistério atual envolvendo essas partículas: o sumiço de antineutrinos em reatores nucleares podem ser um sinal de que existe um tipo a mais de de neutrino além do Modelo Padrão. ]

Cem anos de núcleo atômico e colisões

“Foi de longe o evento mais incrível que jamais aconteceu comigo em minha vida. Foi quase tão incrível quanto se você atirasse um projétil de 40 centímetros contra um pedaço de papel toalha e ele ricocheteasse e acertasse você.” – Ernest Rutherford (1871-1937), citado no livro Big Bang, de Simon Singh.

Assim o físico Ernest Ruhterford descreveu a incrível descoberta do núcleo atômico, anunciada pela primeira vez na Sociedade Filosófica e Literária de Manchester, Reino Unido, em 7 de março de 1911, como ficamos sabendo neste artigo na Ciência Hoje do físico Odilon Tavares, do CBPF, que relata vários detalhes interessantes da história e o espírito da física na época.

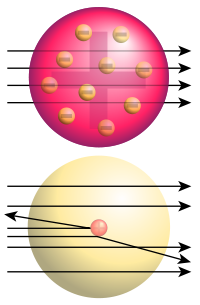

A descoberta resultou dos experimentos de Rutherford, realizados com seus colegas Hans Geiger e Ernest Marsden, em 1909. Na época, a visão que se tinha do átomo era a de uma esfera pouco densa e uniforme de carga elétrica positiva, incrustada com partículas de carga elétrica negativa (a esfera vermelha da figura abaixo). Para verificar esse modelo, Ruhterford, Geiger e Marsden resolveram lançar um feixe de partículas positivamente carregadas (núcleos de átomo de hélio, na época chamadas de partículas alfa) contra uma placa fina de ouro (figuras do experimento podem ser vistas no artigo da Ciência Hoje). Se o átomo fosse mesmo com se pensava até então, os núcleos de hélio atravessariam a placa de ouro sem sofrer quase nenhum desvio (setas pretas na figura). Mas em vez disso, os físicos observaram que uma vez ou outra, uma partícula alfa era fortemente espalhada, como se tivesse colidido com algo muito duro e ricocheteasse (figura abaixo).

Foi só em 1910 que Rutherford conseguiu entender o que estava acontecendo. Ele foi forçado a concluir que toda a carga elétrica positiva do átomo estava concentrada em seu centro, em uma região 100 mil vezes menor que o próprio átomo. Na maioria de seu volume, o átomo era essencialmente vazio. Foi uma conclusão estarrecedora, que desencadeou uma série de questionamentos que contribuiram ao desenvolvimento da mecânica quântica.

Fonte: Wikipedia

E há mais um motivo para se comemorar o experimento de Rutherford, Geiger e Marsden. Como ressaltam Frederick Dylla, do American Institute of Physics, e Steven Corneliussen, do Jefferson Lab, nesta apresentação em PDF, o método do experimento de colidir partículas e analisar o resultado das colisões é a base de todos os experimentos de física nuclear e de partículas elementares que resultaram em todas as outras descobertas da estrutura da matéria no século XX. Já no século XXI, embora um milhão de vezes mais energéticos que as partículas alfa de Rutherford, os prótons do recém inaugurado LHC, e os elétrons e pósitrons do ainda em projeto ILC, colidem em experimentos cuja essência é basicamente a mesma.

Estrela de neutrons tem superfluido em seu interior

Astrofísicos descobriram uma evidência clara de que no núcleo dos objetos estáveis mais densos do universo, as estrelas de nêutrons, a matéria existe em um dos estados mais bizarros já observados, o da superfluidez.

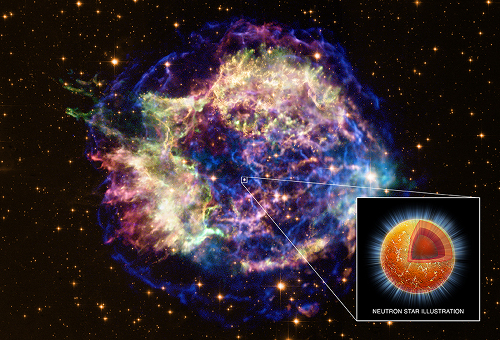

Formadas durante explosões conhecidas como supernovas, a partir da implosão do núcleo de uma estrela muito massiva, as estrelas de nêutrons concentram a massa de até dois sóis (ou seja, 660 mil vezes a massa da Terra) em uma esfera com uns 20 quilômetros de diâmetro. A matéria em seu interior, principalmente em seu núcleo, é tão espremida que os núcleos dos átomos se desfazem e formam uma sopa quente de neutrons. Uma colher de chá dessa sopa de temperatura de milhões de graus pesa seis bilhões de toneladas.

As estrelas de neutrons foram estudadas teoricamente desde os anos 1930 e, desde 1967, mais de duas mil delas já foram detectadas, conta Nicholas Chamel, da Universidade Livre de Bruxelas, que escreveu um comentário sobre a descoberta no site Physics.

Uma delas foi identificada pelo telescópio espacial Chandra de raios X em 1999, a 11 mil anos-luz de distância, no centro do remanescente da supernova Cassiopeia A — uma explosão que teria sido vista na Terra há 330 anos. A imagem abaixo mostra uma composição da Cassiopeia A vista em luz visível e em raios X, com uma ilustração artística de estrela de neutrons inserida, marcando sua localização:

Crédito:raios X: NASA/CXC/UNAM/Ioffe/D.Page,P.Shternin et al; luz visível: NASA/STScI; ilustração: NASA/CXC/M.Weiss

As estrelas de neutrons nascem bem quentes, com temperaturas de milhares de bilhões de graus Kelvin, mas esfriam ao longo de suas primeiras décadas de vida até chegarem a temperaturas da ordem de milhões de graus. Os principais responsáveis por esse resfriamento são partículas de massa quase inexistente chamadas de neutrinos. Elas são produzidas em reações nucleares no interior dessas estrelas [uma delas é “o processo Urca“, descoberta pelo físico brasileiro Mário Schenberg (1914-1990)] e rapidamente escapam para o espaço, levando energia consigo, o que com o tempo diminui a temperatura da estrela.

Ano passado, Craig Heinke, da Universidade de Alberta, Canadá, e Wynn Ho, da Universidade de Southampton, Reino Unido, analisaram as observações da estrela de neutrons em Cassiopeia A feitas pelo Chandra entre 1999 e 2009. Deduzindo a temperatura da estrela por sua emissão de raios X, eles notaram uma queda de 4% da temperatura em dez anos. Logo ficou claro que essa taxa era alta demais para ser explicada apenas pelos processos de emissão de neutrinos mais conhecidos.

Agora, no final de fevereiro, dois grupos de pesquisadores independentes anunciaram que chegaram a uma mesma solução para esse mistério. Um grupo publicou seus resultados em um artigo na Physical Review Letters, assinado por Dany Page, da Universidade Nacional Autônoma do México, e colegas. O outro grupo, liderado por Peter Shternin, do Instituto Técnico Físico Ioffe, na Rússia, e do qual Heinke e Ho fazem parte, publicará seu artigo na Monthly Notices of the Royal Astronomical Society.

Ambos grupos de pesquisadores conseguiram explicar as observações de Heinke e Ho, assumindo que há um século mais ou menos depois de nascer, quando o interior da estrela alcançou uma certa temperatura crítica, os seus nêutrons começaram a se organizar em pares. Quando dois nêutrons formam um par, eles emitem um par de neutrinos. Seriam esses neutrinos extras os responsáveis pelo rápido resfriamento da estrela.

De acordo com o modelo teórico, o resfriamento rápido acontece em uma fase da vida bem específica da estrela de nêutrons, durante algumas décadas, e depois continua mais lentamente. Se a explicação estiver correta, foi um lance de sorte encontrar uma estrela de neutrons jovem o suficiente e no momento certo para observar o fenômeno.

Uma consequência do pareamento dos nêutrons é que, pelas leis da mecânica quântica, o comportamento coletivo deles se transforma radicalmente. A sopa de nêutrons passa a se comportar como um superfluido, um fluido que, diferente da água ou de outro líquido normal, não tem viscosidade. Isso significa que ele flui sem oferecer nenhuma resistência.

Aqui na Terra, os físicos encontraram o fenômeno da superfluidez pela primeira vez em 1938, resfriando hélio de peso atômico 4 líquido até alcançar meros 2,17 graus acima do zero absoluto, como neste vídeo:

Como visto no vídeo, entre outras bizarrices a ausência de viscosidade permite que o superfluido vaze por qualquer canal, não importa o quão pequena seja a sua espessura. Permite também que o líquido superfluido em um recipiente aberto vaze dele escalando a superfície molhada de suas paredes!

Enquanto que a superfluidez do hélio-4 nos laboratórios aqui na Terra depende das interações entre os átomos resfriados quase ao zero absoluto, a superfluidez dos pares de nêutrons no interior das estrelas de neutrons depende da força nuclear forte, a interação da natureza que mantêm os núcleos atômicos coesos. Como os detalhes da força nuclear forte nas condições extremas de densidade e temperatura das estrelas de nêutrons são ainda incertos, estudar melhor o resfriamento rápido observado pode ajudar a testar os modelos atuais de como se comporta a matéria nuclear superdensa.

Se essa explicação para o fenômeno de Cassiopeia A estiver correta, os pesquisadores prevêm que o Chandra deve observar a mesma tendência de resfriamento pelas próximas décadas. Se a tendência não se confirmar e o resfriamento rápido parar abruptamente, sua causa pode ser algo mais simples, como a colisão de material remanescente da supernova com a estrela.

Referência:

Page, D., Prakash, M., Lattimer, J

., & Steiner, A. (2011). Rapid Cooling of the Neutron Star in Cassiopeia A Triggered by Neutron Superfluidity in Dense Matter, Physical Review Letters, 106 (8) DOI: 10.1103/PhysRevLett.106.081101

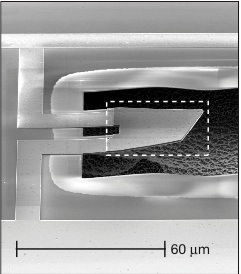

O vibrador que levou físicos ao delírio

Quase visível a olho nu, o pedacinho de metal na foto acima obtida por um microscópio eletrônico, foi projetado para se mexer e ficar parado ao mesmo tempo. Qualquer semelhança com o Gato de Schrödinger–o felino infeliz que está vivo e morto simultaneamente no experimento imaginário proposto por Erwin Schrödinger, um dos pioneiros da mecânica quântica–não é mera coincidência.

O mecanismo capaz de vibrar e não vibrar ao mesmo tempo é obra de Aaron O’Connell e mais onze colegas do laboratório de Andrew Cleland, na Universidade da Califórnia, em Santa Bárbara (EUA). No artigo publicado 17 de março no site da revista Nature, o grupo explicou como resfriou a peça de metal até quase zero absoluto, deixando o mecanismo em seu estado de movimento mínimo possível, seu “estado quântico fundamental”. Mais parado que isso o mecanismo não pode ficar.

Podiam cantar vitória só com esse feito, mas seguiram em frente. Depois de colocar o oscilador em seu estado fundamental, transmitiram à peça a menor quantidade de energia possível que ela é capaz de absorver, um “quantum de vibração”.

Durante esse experimento, os pesquisadores obtiveram evidências indiretas de que, por alguns instantes, o mecanismo fez algo que apenas feixes de luz, átomos e moléculas individuais fazem normalmente. Algo que por muito tempo se pensava que apenas esses entes tão minúsculos seriam capazes de fazer.

Mundo Quântico X Mundo Clássico

Desde o início do século XX, os físicos descobriram que as leis da física do dia-a-dia, a física clássica–cujas fórmulas aproximadas precisamos decorar para passar no vestibular e que é quase tudo o que os engenheiros precisam saber para construirem pontes e usinas hidrelétricas–funcionam mal e mal no mundo molecular, atômico e subatômico.

Elétrons orbitando o núcleo dos átomos, as partículas de luz que eles emitem e absorvem, tudo isso e muito mais é explicado apenas por outro conjunto de leis, as da mecânica quântica.

A teoria tem esse nome porque, ao contrário da física clássica, onde os objetos podem trocar energia de maneira contínua, a energia na mecânica quântica é trocada na forma de múltiplos de uma porção mínima, os chamados quantum de energia (o plural é quanta). A quantidade de energia de um quantum varia de caso para caso.

As diferenças entre a mecância quântica e a física clássica não param nos quanta. Elétrons, por exemplo, podem agir “como se estivessem em dois lugares ao mesmo tempo”. O que quero dizer com a frase anterior entre aspas fica bem claro com o famoso exemplo em que se faz um elétron passar por duas fendas em uma parede. Tentei achar um link para algum texto que descrevesse esse exemplo, mas não achei nada que preste. Prometo mais para frente escrever sobre isso com mais detalhe. Por ora, basta dizer que quando se faz esse experimento em certas circunstâncias, os resultados sugerem que o elétron percorreu dois caminhos diferentes simultâneamente.

Até dá para dormir sossegado aceitando que elétrons existem em estados além da nossa imaginação. Mas objetos maiores, feitos de muitos átomos? O físico Erwin Schrödinger imaginou em 1935 um gato preso dentro de uma caixa onde um dispositivo lança veneno no ar quando um núcleo atômico emite radiação. Acontence que, até o momento em que alguém abra a caixa, o núcleo pode estar em um desses estados insanos em que ele emite e não emite a radiação, o que faz com que o lançador de veneno tenha sido acionado e não acionado, e o gato esteje morto e vivo ao mesmo tempo.

Isso seria mesmo possível? Um objeto “clássico” poderia se comportar quanticamente? Onde fica a linha que separa o mundo quântico do clássico? Essa linha existe? Será que a mecânica quântica precisa ser corrigida? São essas questões que motivam experimentos com objetos em princípio”clássicos”, feitos de bilhões ou trilhões de átomos, mas pequenos o suficiente para que seja possível vislumbrar efeitos quânticos neles.

Esses experimentos já obtiveram resultados muito interesssantes. Em 2000, físicos observaram a corrente elétrica em um anel supercondutor girar em dois sentidos ao mesmo tempo. Ano passado, outro grupo de pesquisadores emaranhou o estado de dois qubits superconduntores visíveis a olho nu.

Até agora, porém,ninguém havia posto um objeto macroscópico para se mexer quânticamente. Desde os anos 1990, grupos de pesquisadores investigam como fazer isso, construindo aparelhos mecânicos minúsculos e tentando fazê-los vibrar como um “oscilador harmônico quântico“. Foi exatamente o que o pessoal do laboratório de Cleland conseguiu fazer.

Como fizeram

Em um comentário que acompanhou a publicação do artigo na Nature, o físico Markus Aspelmeyer notou que a construção do vibrador quântico macroscópico venceu dois desafios. O primeiro desafio foi resfriá-lo até uma temperatura bem próxima de zero Kelvin (-273 oC), o chamado “zero absoluto”.

Um oscilador harmônico clássico vibra com qualquer energia. Já a sua versão quântica, oscila apenas quando absorve dos átomos do ambiente a sua volta pacotes discretos de energia chamados de “quanta de vibração” ou de fônons. O oscilador só absorve fônons de um determinado valor de energia. Quanto maior a temperatura, mais fônons com a energia certa há no ambiente para o oscilador absorver. Se a temperatura do ambiente for baixa o suficiente, o oscilador não terá fônons para absorver e estará em seu estado de energia mínima, o “estado fundamental”.

O valor do fônon que excita o vibrador depende da frequência de oscilação dele. Quanto maior a frequência, maior a energia de cada fônon e, portanto, maior o valor da temperatura em que o oscilador fica em seu estado fundamental.

Quanto menor o tamanho do oscilador, maior sua frequência. Assim, para colocá-los no estado fundamental, a estratégia dos experimentalistas tem sido resfriar e miniaturizar cada vez mais seus osciladores.

Nos experimentos mais recentes, foram construidos osciladores de frequências na faixa dos megahertz (milhões de oscilações por segundo), exigindo temperaturas da ordem de bilionésimos de Kelvins. Temperaturas tão extremamente próximas do zero absoluto foram obtidas só recentemente e há muito custo, com técnicas de refrigeração de última geração. Os pesquisadores chegaram tantalizadoramente perto do estado quântico fundamental desses osciladores, registrando números médios de até 4 fônons, mas não conseguiram ir além disso

Em vez de seguir com a boiada, resfriando e miniaturizando cada vez mais, o pessoal do laboratório de Cleland teve um ideia genial. Eles aumentaram em mil vezes a frequência do microvibrador deles simplesmente mudando o seu design.

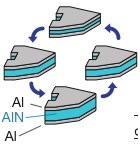

Os osciladores usados geralmente pelos grupos de pesquisa são baseados no deslocamento do centro de massa do objeto, como a vibração de uma prancha de megulho.

Já o oscilador do grupo de Cleland dilata e contrai sua espessura, chegando a uma frequência na faixa dos 6 gigahertz. Com essa frequência eles conseguiram chegar no estado fundamental a meros 25 milikelvins, o que pode ser obtido por meio de um sistema de refrigeração mais “convencional”.

Aliás, curiosamente, o design do novo oscilador foi inspirado em um modelo desenvolvido pela empresa Agilent para ser usado como filtro primário para telefones celulares.

Esquema do oscilador feito de matreial piezoelétrico, que transforma movimento mecânico em um sinal elétrico e vice versa. O mecanismo oscila dilatando e constraindo sua espessura.

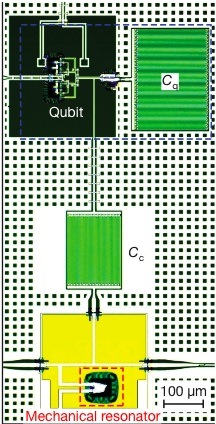

O segundo desafio da equipe de Cleland foi medir os fenômenos quânticos acontecendo em seu oscilador com um instrumento delicado o suficiente. Esse instrumento foi “um qubit supercondutor”, que serviu como uma espécie de termômetro quântico. O sistema é complicado de explicar, daria um post só sobre ele. Mas resumindo, o tal qubit supercondutor pode ter apenas dois níveis de energia, o nível excitado e o nível fundamental.

Na figura abaixo, dá para ver o qubit supercondutor acoplado com o oscilador:

Primeiro, os pesquisadores preparavam o qubit em seu nível fundamental. Em seguida, acionavam a ligação do qubit com o vibrador por um microsegundo e voltavam a desligá-la. Logo em seguida mediam o qubit para verificar se a energia de algum fônon vindo do oscilador havia sido transferida para o qubit. Fizeram essa medida várias vezes, variando a diferença de energia entre os níveis do qubit, e o resultado foi nulo. Mostraram assim que o vibrador estava em seu estado de energia mínima com um probalibidade maior que 93%.

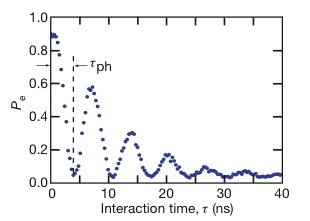

Uma vez que tinham certeza de que o oscilador estava em seu estado fundamental, os pesquisadores resolveram demonstrar a transferência de um quantum de energia do qubit para o oscilador. Fizeram isso primeiro preparando o qubit em seu estado excitado. Em seguida acionaram a interação entre o qubit e o oscilador. Repetiram o procedimento várias vezes, variando o tempo em que a interação entre qubit e oscilador permanecia ligada. Um dos resultados foi o gráfico abaixo:

Gráfico da probabilidade do qubit estar no estado excitado ao longo do tempo (em nanosegundos)

Essa oscilação é sinal de que um único quantum de energia ia e vinha entre o qubit e o vibrador. No máximos da curva o quantum está no qubit e nos mínimos, no vibrador. Nos demais pontos, o qubit e o vibrador estão em um estado que só existe na mecânica quântica, um “estado emaranhado”. É como se o conjunto estivesse em uma combinação de estado “qubit no estado fundamental e vibrador excitado” e “qubit excitado e vibrador no estado fundamental”. Em outras palavras, é como se o oscilador estivesse em dois estados de movimento ao mesmo tempo.

Ano passado um grupo de pesquisadores do Instituto de Tecnologia da Califórnia (Caltech) fez exatamente o contrário, medindo o estado do qubit com um vibrador clássico acoplado. O resultado foi celebrado na época, pois a esperança do grupo era de reverter o processo e usar o qubit para observar o oscilador antes clássico se comportar quanticamente. Mas, seus concorrentes conterrâneos de Santa Bárbara chegaram na frente…

As figuras todas foram extraídas do artigo científico original:

O’Connell, A., Hofheinz, M., Ansmann, M., Bialczak, R., Lenander, M., Lucero, E., Neeley, M., Sank, D., Wang, H., Weides, M., Wenner, J., Martinis, J., & Cleland, A. (2010). Quantum ground state and single-phonon control of a mechanical resonator Nature, 464 (7289), 697-703 DOI: 10.1038/nature08967

O dia em que o Universo quicou

A New Scientist da semana passada publicou uma reportagem sobre minha teoria quântica da gravidade favorita e suas implicações para a natureza do big bang.

Minha reação foi de pura nostalgia, pois a reportagem é uma atualização de um dos meus primeiros textos de divulgação científica, “o dia que o universo quicou“.

Desde que o entrevistei em 2006, Abhay Ashtekar e sua turma fizeram progressos, mas ainda falta o essencial. Eles precisam trabalhar a teoria até conseguirem fazer previsões que possam ser testadas por observações astronômicas.

Por que a Loop Quantum Gravity é minha favorita? O motivo é puramente sentimental. Em 1993, com treze anos de idade, li em uma extinta revista de divulgação científica em português uma adaptação da reportagem Loops of Space, escrita por Marcia Bartusiak, que contava a história de como Ashtekar, junto com Carlo Rovelli e Lee Smolin formularam a LQG. Foi minha introdução ao espaço-tempo curvo, ao mundo quântico, às questões apaixonantes da física contemporânea e também ao bom jornalismo científico…

Massa de próton e nêutron surge do “nada”, confirmam cálculos

Nessa representação artística, trios de quarks formam o que podem ser prótons ou nêutrons. Cálculos com supercomputadores (parte de baixo da figura) verificaram que mais de 95% da massa de prótons e neutrons não vem da massa dos quarks, mas sim da energia de ligação entre eles. Prótons e nêutrons formam quase toda a massa visível do universo. Crédito: Forschungszentrum Jülich/Seitenplan

Após meses de cálculos em uma rede de supercomputadores capaz de mais de 200 trilhões de operações por segundo, um time de 12 pesquisadores europeus conseguiu pela primeira vez deduzir a partir da teoria do Modelo Padrão a massa das partículas que constituem o núcleo dos átomos.

Os resultados da orgia numérica foram publicados na edição de 21 de novembro, da revista Science.

“O quê? Só agora fizeram isso? E pra quê tanta conta assim?”, pode perguntar alguém que já ouviu falar que, de acordo com o Modelo Padrão–atualmente a melhor e mais completa teoria das partículas elementares, desenvolvida com base em um século de alternativas frustradas e verificações experimentais–os constituintes dos núcleos atômicos, prótons e nêutrons, são constituídos por sua vez de outras partículas, os quarks.

O próton é feito de três quarks: dois quarks do tipo up e um do tipo down. Já o nêutron é feito de dois quarks down e um up. É natural pensar que basta somar a massa dos quarks constituintes para saber a massa do próton e do nêutron. Não é tão simples assim, porém.

Em primeiro lugar, não existe na teoria do Modelo Padrão uma maneira de calcular o valor absoluto da massa dos quarks. As massas dos seis tipos conhecidos (up, down, strange, charm, top e bottom) precisam ser medidas em experiências, para ajustar a teoria à realidade. Acontece que quarks não existem isolados, mas sempre andam ligados em pares, chamados de mésons, ou em trios, chamados de bárions. Mésons e bárions são chamados coletivamente de hádrons (daí o nome do famoso LHC, Grande Colisor de Hádrons, em inglês).

As massas dos quarks, então, são deduzidas comparando entre si as massas dos vários hádrons que surgem durante as colisões nos aceleradores (todos os hádrons, exceto o próton e o nêutron, se desintegram em frações de segundo).

As últimas medidas das massas e de outras propriedades das partículas elementares são publicadas todo ano em uma espécie de “almanaque” em forma de livrinho, que alguns físicos costumam carregar no bolso da camisa. É o famoso Particle Physics Booklet, do Particle Data Group.

Consultando a edição 2008 do livrinho, lemos na página 21 que a massa do quark up deve estar entre 1,5 e 3,3 MeV/c2 e que a massa do down está entre 3,5 e 6,0 MeV/c2. Essa unidade esquisita de massa vem da célebre equação E = mc2, da onde se deduz que a massa de uma partícula é sua energia (medida em MeVs) dividida pelo quadrado da velocidade da luz no vácuo.

Agora, se somarmos as massas dos quarks constituintes do próton e do nêutron, o resultado é no máximo uns 15 MeV/c2. Na página 124 do livrinho, está a massa medida do próton: 938 MeV/c2. Na página 126, a massa do nêutron: 939 MeV/c2… Portanto, a massa dos quarks não chega a um pouquinho mais que 1% da massa total próton ou do nêutron!

A solução para esse mistério está justamente na equação E=mc2. A maioria da massa do próton e do nêutron vem da energia do movimento de seus quarks e da força de ligação entre eles. Foi para calcular essa energia que demorou tanto uma dedução acurada das massas a partir da teoria.

A força que segura os quarks em trios ou em pares é transmitida por partículas chamadas de glúons, que constantemente aparecem e desaparecem no vácuo e são absorvidas e emitidas pelos quarks, conforme as regras da parte do Modelo Padrão conhecida como Cromodinâmica Quântica (QCD, em inglês). Pelas regras da QCD, além dos glúons, aparecem e desparecem do vácuo a toda hora pares de quarks e anti-quarks, que, apesar de efêmeros, também contribuem para a energia total do hádron. Veja a figura abaixo, tirada daqui.

Representação artística de um par “efêmero” de quark/anti-quark strange surgindo dentro de um próton. Note os quarks permanentes do próton: up, up e down. As massas azul-verde-amarelo-vermelha em volta dos quarks representam a energia do campo de glúons. Essa imagem é verificada em laboratório, observando colisões de elétrons com o próton, representadas pela linha branca na figura. Crédito: Derek B. Leinweber

Calcular quantidades à partir das equações da QCD é praticamente impossível na ponta do lápis. A QCD funciona ao contrário da força eletromagnética entre átomos e moléculas interagindo em gases e líquidos, onde a maioria da energia vem da interação direta entre pares de partículas, uma parcela menor da energia vem de trios de partículas, uma parte menor ainda vem de grupos de quatro e assim por diante, o que permite aproximações que facilitam os cáculos. No caso da QCD, a intensidade da interação aumenta com a distância e todas as possiblidades de interação precisam ser levadas em conta nos cálculos. Esse “acoplamento forte” entre os quarks é o motivo pelo qual não existem quarks isolados e pelo qual é preciso o auxílio de computadores para os cálculos em QCD.

Faz uns vinte anos que os físicos usam uma técnica computacional chamada de lattice gauge theory, que aproxima o contínuo do espaço e do tempo por uma rede cubíca. Esses modelos só levavam em conta os glúons, deixando de lado os pares de quarks/antiquarks. Os valores para as massas dos hádrons calculados assim eram em média 10% diferentes dos valores reais.

Em 2003, uma colaboração internacional conseguiu calcular a massa de alguns mésons incluíndo o efeito dos pares quark/anti-quark, mas a técnica não era apropriada para calcular a massa de bárions leves, como o próton e o nêutron.

O que os pesquisadores fizeram agora foi encontrar pela primeira vez uma aproximação do tipo lattice gauge theory, capaz de incluir todos os ingredientes da QCD, de permitir a realização de cálculos sem sobrecarregar os supercomputadores e que além disso permite a análise das possíveis fontes de erros e incertezas nos resultados.

As aproximações deles não distingüem os quarks up e down e inclui os efeitos de pares de quark/anti-quarks do tipo strange (os demais quarks são muito mais pesados e não influem significativamente). Os valores medidos das massas dos bárions Ω (sss) e Ξ (uss ou dss) foram usados para “calibrar” a teoria, que não deriva valores absolutos de massa, apenas razões entre elas.

A massa obtida para um bárion feito de quarks u e d é em torno de 936 MeV/c2, o que não está longe da massa real do próton e do nêutron.

Os pesquisadores usaram o mesmo método para calcular a massa de mais sete bárions e quatro mésons, feitos de quarks u, d e s.

Os pesquisadores querem agora calcular outras propriedades dos hádrons além da massa. O objetivo a longo prazo é comparar com os experimentos todas as previsões da teoria da cromodinâmica quântica e descobrir o que ainda há de desconhecido no interior dos núcleos…

É curioso como podemos pelo Modelo Padrão determinar a massa de prótons e nêutrons ainda que a massa exata dos quarks up e down seja desconhecida, principalmente pelo fato de um quark isolado não existir no universo atual.

Mas nem sempre foi assim. Pouco após o Big Bang, o universo era um gás quente de quarks e glúons livres. O universo expandiu, esfriando e rapidamente os quarks e glúons ficaram confinados, formando os primeiros hádrons, que guardaram dentro si parte da energia do Big Bang. Chega a ser poética a idéia de que parte da energia do Big Bang é a origem do peso de nossos corpos…

Fontes consultadas:

Origem da matéria dá Nobel a japoneses

Esta é uma versão expandida da reportagem sobre os ganhadores do Nobel 2008 de Física que fiz ontem em parceria com o grande Eduardo Geraque, e que foi publicada hoje na Folha de S.Paulo:

Um trio de origem japonesa ganhou ontem o Prêmio Nobel de Física por seus trabalhos que ajudam, sem exagero, a explicar por que tudo existe.

Se uma tal de “quebra de simetria”, estudada pelos laureados, não tivesse acontecido no início do Universo, toda a matéria teria sido aniquilada pela sua irmã gêmea “do mal”, a antimatéria.

O japonês naturalizado americano Yoichiro Nambu, 87, que está desde 1952 na Universidade de Chicago, vai receber US$ 700 mil pelo Nobel. Em 1960, Nambu inventou o conceito de “quebra de simetria”.

Makoto Kobayashi, 64, que trabalha no acelerador de alta energia KEK em Tsukuba, Japão, e Toshihide Maskawa, 68, da Universidade Kyoto, ganharão US$ 350 mil cada.

Nambu foi o primeiro a introduzir o conceito de “quebra espontânea de simetria” no estudo das partículas, inspirado em um trabalho anterior seu com supercondutividade elétrica. O físico usou a tal quebra de simetria para explicar porque a chamada força nuclear fraca tem um alcançe tão curto, se comparada à força eletromagnética. A explicação é que no início do Universo deve ter ocorrido uma quebra de simetria entre as partículas que transmitem a força eletromagnética, os fótons, e as partículas que transmitem as força nuclear fraca, os bósons W e Z. Enquanto os fótons permaneceram sem massa e portanto podem viajar à velocidade da luz, os bósons W e Z engordaram demais e vivem pouco, deslocando-se somente por distâncias subatômicas.

Dois trabalhos de Nambu, em 1961, contribuíram de forma decisiva para o surgimento do chamado Modelo Padrão, que consolida todo o conhecimento que os físicos têm sobre as partículas elementares.

A única peça faltante no Modelo Padrão é o chamado bóson de Higgs, que dá uma massa diferente para cada uma das partículas, justamente por uma “quebra de simetria”.

O físico brasileiro Rogério Rosenfeld, do Instituto de Física Teórica da Unesp (Universidade Estadual Paulista), explica a quebra de simetria imaginando um chapéu mexicano. “Imagine que sobre o cocuruto do chapéu exista um animal. A aba, neste caso, forma um extenso vale onde existe comida. Em tese, ele pode escolher qualquer direção mas, ao fazer isso, estará quebrada a simetria. Ele poderia ter ido tanto para a esquerda quanto para a direita”, explica.

Rosenfeld contou com a presença de Nambu na sua banca de doutorado, em 1990, na Universidade de Chicago.

Kobayashi e Maskawa levaram o Nobel por descobrirem a quebra de simetria que fez a matéria sobrepujar a antimatéria no Big Bang.

“Eu não esperava ganhar. É uma honra receber o prêmio pelo meu trabalho tanto tempo depois”, afirmou Kobayashi logo após o resultado ter sido divulgado, ontem de manhã. “Estava apenas perseguindo meu interesse [acadêmico].”

Em 1972, Kobayashi e Maskawa usaram o conceito de quebra de simetria para explicar o comportamento estranho de uma partícula chamada kaon, observada em 1964. O problema, explica o físico da Unesp, é que para o modelo deles fazer sentido deveria haver três quarks a mais do que os conhecidos na época, o “up”, o “down” e o “estranho”. Os quarks são partículas do núcleo do átomo que são os menores constituintes da matéria.

“O modelo deles foi ignorado na época”, conta o físico Gustavo Burdman, da USP. “A explicação que estava na moda era outra, que foi provada errada.”

Todos os físicos, porém, logo reconheceram a explicação de Kobayashi e Maskawa como a correta quando os quarks que eles previram (“charme”, “bottom” e “top”) foram descobertos, em 1974, 1977 e 1994.

Além de explicar o kaon, a proposta da dupla sobre a quebra de simetria relacionada às cargas dos pares de partículas e antipartículas explica a própria existência da matéria.

No momento do Big Bang, se toda a matéria tivesse sido aniquilada pela antimatéria, só teríamos a radiação. A sorte, talvez, é que houve um pequeno desvio da ordem de uma partícula de matéria para cada 10 bilhões de partículas de antimatéria. “O desbalanço é grande, mas os parâmetros que levaram a essa assimetria são pequenos”, diz Rosenfeld. Exatamente a explicação de parte dessa assimetria é que rendeu o Nobel à dupla japonesa.

Em 2001 e 2002, aceleradores de partículas nos EUA e no Japão -o mesmo onde Kobayashi trabalha-, confirmaram a sutil diferença entre matéria e antimatéria em partículas chamadas mésons B. Os mésons B são partículas feitas de um par de quark bottom e anti-quark bottom. O par oscila rapidamente se transformando um no outro e essa oscilação é afetada assimetria entre matéria e antimatéria.

A diferença descoberta por Kobayashi e Maskawa, porém, não é suficiente para explicar a quantidade de matéria que sobreviveu ao aniquilamento primordial.

O experimento LHCb, do gigantesco acelerador de partículas LHC, que deve entrar em operação ano que vem, vai medir com maior precisão o comportamento dos mésons B, em busca de outras assimetrias desconhecidas entre matéria e antimatéria.