FAQs da Bioengenharia – Introdução

Preocupados com os novos amantes da biologia sintética, estamos procurando materiais de introdução no assunto e encontramos algumas coisas interessantes! 🙂

Por isso vamos colocar uma sequência de posts explicativos, partindo de uma visão geral e seguindo por perguntas mais específicas. É um pequeno tutorial-FAQ sobre alguns fundamentos que quando entendidos ajudam bastante a entender algumas de nossas discussões e outros posts deste blog. Serve para ajudar principalmente quem não é da área de biológicas ou quem ainda não se aprofundou muito neste assunto! Se continuarem com dúvidas, perguntem tá?!

Lembrem-se de ativar as legendas dos vídeos, caso necessitem! Todos possuem legendas originais em inglês e alguns em português. Você pode colocá-las traduzidas quando só houver em inglês (não muito recomendado, rs). Nos vídeos do JOVE existe a opção de colocar os textos em português. Se você não sabia que o YouTube fazia isso por você, dá uma olhada aqui (dica: barrinha inferior do vídeo).

Antes de mais nada, você sabe o que são e quais as relações entre nossas principais moléculas orgânicas (DNA, RNA e proteínas), certo? Se sua resposta é não, assista um desses vídeos!

[youtube_sc url=”http://www.youtube.com/watch?v=h3b9ArupXZg#t=0″]

[youtube_sc url=”http://www.youtube.com/watch?v=tMr9XH64rtM”]

Indo além da Estrutura

OK, agora vamos além desses conceitos básicos dos vídeos. Mais que entender a estrutura e a dinâmica dessas biomóleculas, como os cientistas a alteram? Em linhas gerais, como se faz para modificar geneticamente um organismo?

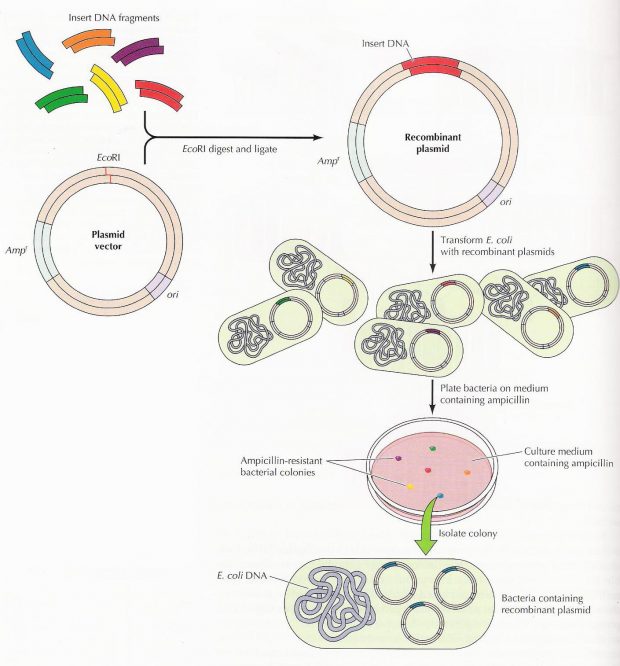

Vamos lá! Primeiro pegamos um pedacinho codificante de DNA (gene) de outro organismo que tenha certa característica que desejamos. Para isso, extraímos o DNA e depois multiplicamos só esse pedaço que nos interessa através de uma técnica chamada PCR (afinal, a eficiência das transformações é pequena e quanto mais material melhor). Precisamos também extrair e abrir os plasmídeos (DNA circular) do organismo escolhido para receber este gene e assim receber as novas características (já que o plasmídeo é nosso principal veículo de introdução dos genes nas células). Para abrir estes plasmídeos usamos enzimas de restrição que cortam as moléculas de DNA em lugares específicos e chamamos isso de digestão. Depois que tivermos vários plasmídeos e genes, podemos grudá-los com a ajuda de enzimas de ligação. E então, para saber se nosso novo plasmídeo deu certo usamos uma técnica de separação por carga e tamanho de molécula, a eletroforese em gel. Nela, as moléculas se acumulam em certas posições que nos dizem seus tamanhos (mergulhadas em um polímero) e assim podemos identificar aquelas que correspondem ao que estimamos. Além disso, fazemos testes com a técnica PCR e o sequenciamento genético. Se os testes disserem que tudo que fizemos deu certo, recuperamos o material e colocamos nossos novos plasmídeos nos organismos, geralmente utilizando choque térmico ou elétrico. Esse passo, introdução de plasmídeos, é a chamada transformação. Mas para selecionarmos somente aqueles organismos que realmente foram transformados usamos antibióticos que matam as células que não ganharam os nossos novos plasmídeos, já que não possuem os genes de resistência que foram colocados neles. E no final, cada célula que sobreviveu se multiplicará, formando colônias de organismos geneticamente modificados. Agora dá uma olhada no esquema de novo e vê se entendeu até aqui!

Por Otto Heringer e Viviane Siratuti.

Estratégias para tempos adversos.

Em tempos adversos é comum haver muitas mudanças e isto não acontece somente com os humanos que saem as ruas, fazem guerra ou revolução. Na natureza observamos inúmeras estratégias dos seres vivos para superar tempos difíceis, algumas bastante chocantes do ponto de vista humano, tais como infanticídio ou canibalismo. E no mundo microscópio não é diferente.

Se você pensa que as bactérias morrem pacíficas quando as condições não são favoráveis você está bastante enganado. Até mesmo para estes minúsculos seres unicelulares a vida pode ser complexa e cheias de decisões difíceis e estressantes a serem tomadas. Existem diversas estratégias para lidar com tempos difíceis, tais como escassez de alimentos e danos ao DNA. Uma das estratégias mais radicais e mais utilizadas quando a coisa está realmente feia é formar esporos, uma resposta celular bastante complexa que envolve a ativação de mais de 500 genes ao longo de aproximadamente 10 horas. Este processo termina com a morte da célula mãe e a formação de uma célula filha dormente com a capacidade de resistir a situações extremas como calor, radiação e presença de substancias químicas. Por outro lado, durante este tempo o esporo não pode tirar vantagem imediata de situações favoráveis para se reproduzir.

Esporulação é uma tomada de decisão bastante complexa e que não se inicia simplesmente com a escassez de alimentos, mas é resultado de uma série de passos que podem ser descritas como decisões celulares sobre como lidar com o stress presente. Envolve, por exemplo, uma comunicação entre as bactérias da mesma colonia por um mecanismo chamado de quorum sensing. Além disto, antes da esporulação, comumente as bactérias tentam outras táticas como ativar um flagelo para buscar alimentos, secretar antibióticos e outras substancias na tentativa de destruir outros micróbios competidores. As células também checam uma série de condições internas antes de decidir esporular tais como a integridade do DNA cromossomal.

Mesmo quando a maior parte da colonia decide por esporular, o material gerado pela lise da membranas das células que esporularam são aproveitados por outras células da colonia que, no caminho para esporular, entram no estado chamado de competência, que consiste em abrir poros na membrana para facilitar a entrada de DNA exógeno, que pode ser utilizado para reparo do DNA e eventualmente como fonte de informação genética que as ajudará a resistir ao momento. Há ainda um outro caminho mais radical tomado por algumas células da colônia que consiste em secretar alguns fatores antibacterianos que faz com que células irmãs fiquem incapazes de esporular, causando inclusive a lise de sua membrana, em uma espécie de canibalismo. Interessante notar que, sobre a perspectiva de teoria de jogos, a estratégia de canibalismo seria predominante sobre a estratégia de entrar em competência, o que não é observado. Isto indica que possivelmente as células em competência são imunes ao canibalismo, mas não sabemos ainda se é este o caso.

Modelos teóricos/moleculares para este tipo de tomada de decisões normalmente consistem na integração de módulos gênicos formados principalmente por circuitos regulados por diversos fatores de transcrição e micro RNAs. Estes tipos de sistemas gênicos também desempenham um papel importante no desenvolvimento embrionário e de células cancerígenas, motivo pelo qual tem se dado muita atenção a este tipo de estudo.

Referencias:

Brincando de Comparar Códons

Sou daquelas pessoas que simplesmente não conseguem dormir direito com um mistério. Essa é uma obsessão que provavelmente muitos cientisas (e “wannabe scientists”, como eu) têm. Às vezes ficamos obcecados com uma coisa muito importante, às vezes com uma coisa banal e muitas vezes com algo que você nunca parou para pensar direito. O mais emocionante é que qualquer resposta de uma dúvida tem aquela probabilidade mágica de revelar algo impressionante ou bem útil. Hoje (dia dessa postagem), fiquei obcecado por tentar entender “na prática” qual é a grande ideia da otimização de códons e o quanto os organismos podem ter preferências de códons diferentes. Aqui está o registro da investigação do pequeno mistério de hoje!

Códons, Otimizações e Preferências

Antes de discorrer sobre o que andei brincando. Uma pequena contextualização ao intrépido viajante sobre o que são códons, porque eles precisam ser otimizados e o que diabos é essa “preferência de códons”.

Códons são os trios de combinações de letrinhas A,T,C e G do DNA (os nucleotídeos) que, depois de transcritos a RNA (em que a grande diferença é que os “T’s” são substituídos por “U’s”), são literalmente traduzidos em aminoácidos; ou seja: três nucleotídeos codificam um aminoácido. A grande coisa dos códons é que eles são redundantes: existe mais de uma maneira de um aminoácido específico ser traduzido à partir dos trios de nucleotídeos. Os cientistas fizeram uma tabela espertinha que “decodifica” nucleotídeos em aminoácidos:

Comece lendo do centro até às bordas do círculo combinando as letras que você for olhando pelo caminho. Por exemplo: U+A+C = Tyr, abreviação de Tirosina.

Mas aí você se pergunta: “Querida Natureza, qual é o propósito disso!?”. A redundância da leitura de aminoácidos tem uma implicação muito importante na conservação do código genético; ela é a última barreira espertinha da contra mutações no DNA. Imagine que o “C” do códon UAC que traduz uma Tirosina fosse mutado e virasse um “U” (dando UAU): graças à redundância de tradução, o aminoácido Tirosina ainda continua sendo traduzido! Pra se ter uma ideia de como isso é importante, uma única substituição de aminoácidos (o que pode acontecer com uma única mutação de nucleotídeos) já pode gerar doenças (pesquise sobre Anemia Falciforme).

Enfim, concluindo: existem muitos códons que podem ser traduzidos em diferentes tipos de aminoácidos. Como existem muitas opções, diferentes organismos costumam a ter preferências por diferentes códons para traduzir aminoácidos específicos – por exemplo: nós Humanos adoramos traduzir Arginina como AGA e AGG, já uma das bactérias do nosso cocô, a E.coli, acha muito mais interessante traduzir Arginina como CGU e CGC. Vai entender esses procariotos viu!

Mas porque isso acontece? Porque evolutivamente cada espécie foi selecionada em um ambiente particular, o que implica em diferentes necessidades de estabilidade do DNA em diferentes contextos, e portanto diferentes porcentagens de C e G, e A e T no genoma. Essas porcentagens direcionam quais códons os organismos preferem.

Por causa de tudo isso, quando algum cientista vai fazer o design de um pedaço de DNA, é preciso colocar a sequência no contexto do organismo a ser utilizado, deixando os códons “otimizados” para cada ser vivo – caso contrário, os genes inseridos no organismo serão pouco ou nada expressos.

Investigando leveduras

Mais profundamente, resolvi brincar dessas coisas querendo responder uma pergunta: “O quão compatível os códigos genéticos de duas espécies de leveduras podem ser?”. No caso, Pichia pastoris e Saccharomyces cerevisiae.

Primeiramente eu entrei no “Codon Usage Database“. Procurando por Pichia e Saccharomyces, o site dá uma tabela com a frequência de se encontrar determinado códon a cada mil pares de base. Eu peguei os resultados e coloquei num site chamado “Text Diff” – ele compara dois textos e mostra as diferenças e igualdades entre os dois. Com a comparação, dei print screen e destaquei as frequências mais discrepantes entre as duas espécies de levedura, obtendo o seguinte diagrama:

Texto em vermelho: Pichia. Texto em Verde: Saccharomyces. Laranja – diferença de 4 a 5; Rosa – diferença de 6 a 9; Amarelo – diferença acima de 10; Códons circulados – frequências iguais.

Fui atrás de cada códon, procurando o que codifica. Cheguei na seguinte tabela:

Eu chamei de “eficiência de códons” o quão os códons de Pichia funcionam em Saccharomyces, tomando como “códons incompatíveis” aqueles com diferença de no mínimo 4 entre as frequências de códon em cada espécie (a marcação em amarelo na imagem de comparação das frequências) – também estou tomando como hipótese que há uma relação direta entre frequência de códon e a preferência do mesmo por determinada espécie. Cheguei nesses valores através da porcentagem do número de códons “compatíveis” (totais – incompatíveis). De 20 aminoácidos possíveis, apenas 7 seriam seus códons prontamente compatíveis.

Ambas as espécies são leveduras, e por isso eu esperava uma maior compatibilidade natural. O problema é que eu não tenho um controle para saber se a usagem de códons de cada levedura é realmente discrepante. Por isso, fiz a mesma comparação entre Pichia e E.coli. Como esses organismos são bem mais diferentes (um é eucarioto e outro procarioto), esperei uma diferença bem maior. (veja imagem abaixo)

Texto em vermelho: Pichia. Texto em Verde: E.coli. Laranja – diferença de 4 a 5; Rosa – diferença de 6 a 9; Amarelo – diferença acima de 10; Códons circulados – frequências iguais.

Legenda: Laranja – diferença de 4 a 5; Rosa – diferença de 6 a 9; Amarelo – diferença acima de 10; Códons circulados – frequências iguais.

Como esperado, dá pra ver claramente o quanto E.coli e Pichia são diferentes em comparação com Pichia e Sccharomyces. Nesse panorama, eu diria em Pichia e Saccharomyces são bem parecidas. Quanto mais comparações forem feitas mais certeza se terá do quão um organismo se parece com outro.

Otimização de Códons

Apesar de eu não ter certeza da relação direta entre frequência e preferência de códon, consegui observar coisas muito interessantes: a única inviabilidade de tradução correta entre Pichia e Saccharomyces de aminoácido é o Glutamato, em que as frequências de todas as possibilidades de códons não entram na minha classificação de “códons compatíveis” (diferença de frequência menor que 3). O resto dos códons podem ser compatibilizados entre espécies usando-se versões alternativas de códon para um mesmo aminoácio! 🙂

Quando se otimizam códons para deixar um plasmídeo compatível em diferentes plataformas, faz-se exatamente isso. O problema é que mesmo assim a expressão ainda não é ótima, então em geral prefere-se “sacrificar” a compatibilidade do plasmídeo em diferentes espécies para se ter um plasmídeo com os melhores códons em cada bichinho.

Existem vários programas que fazer essa otimização de códons rapidamente, mas em geral as empresas que sintetizam DNA já incluem isso (de graça ou não) no planejamento do plasmídeo a ser sintetizado.

Conclusão

Por fim, a conclusão que tirei disso tudo é: eu ACHO que um gene de Pichia funcionaria suficientemente bem em Saccharomyes e vice-versa. No caso de não conseguirmos sintetizar os genes que precisamos já códon-atimizados, talvez valha a pena fazer uma mistureba de DNA interespécies – mas só para as leveduras!

Aventuras em Biologia Sintética

Eu considero os quadrinhos como uma das formas mais interessantes de se narrar uma história. São também uma ótima forma de divulgar ciência de uma maneira didática e divertida.

Drew Endy um dos pais da biologia sintética (e do Registry of Parts), juntamente com Isadora Deese (ambos do MIT) elaboraram o quadrinho Adventures in Synthetic Biology. E tem mais: o quadrinho foi publicado no website da prestigiada revista Nature.

Confira Adventures in Synthetic Biology e aprenda de maneira didática o que são biobrick, PoPs, entre outros conceitos básicos.

Links possivelmente interessantes:

- Bastidores da produção do quadrinho

- The cartoon guide to genetics

- TED talk do Jorge Cham, criador do sensacional PhD Comics

Bactéria Sintética Segundo Craig Venter

Autor: Mira Melke

O Anúncio da criação da bactéria sintética pelo J. Carig Venter Institute (JCVI) foi há pouco mais de dois anos, em 2010. Na época, cientistas de várias regiões do mundo e de áreas distintas se pronunciaram a respeito do que o Próprio Venter chamou de “A Criação de uma nova vida”. Afirmação extremamente questionável, mas que movimentou a mídia como poucos cientístas conseguiram fazer até hoje. Essa afirmação foi tema do meu trabalho para a disciplina de Filosofia da Biologia e resolvi compartilhá-lo com vocês.

A base do meu trabalho foram dois artigos. O Primeiro deles é o publicado pela Science e pelo grupo do JCVI, intitulado “Creation of a Bacterial Cell Controled by a Chemically Synthesized Genome”. Reporta o design síntese e organização de um genoma completo de uma bactéria. Esse genoma foi posteriormente transplantado em uma bactéria que teve seu material genético extraído por completo.

O segundo, publicado pela Nature, apenas 7 dias depois, intitulado “Life After the Synthetic Cell” traz a opinião de oito especialistas na área da Biologia Sintética sobre as implicações para a ciência e para a Sociedade da “Célula Sintética” feita pelo JCVI.

Ambos os artigos podem ser encontrados facilmente no pubmed.

Antes de entrarmos propriamente na discussão filosófica, quero apresentar brevemente a proposta do trabalho e a metodologia utilizada. Na apresentação, está resumida em apenas um slide, mas quero detalhar um pouco de cada etapa.

Minimização do Material Genético

Essa etapa consistiu em determinar, a partir de dois organismos simples (duas cepas (linkar uma referência explicando a palavra cepa) de Mycoplasma mycoides) com o genoma conhecido. Muitos anos foram necessários para estabelecer o conjunto de genes que era estritamente necessários para a sobrevivência da bactéria. 100 de 485 genes testados foram considerados dispensáveis quando inibidos um de cada vez.

Design do Genoma

A combinação do resultado da minimização com algumas sequências de controle (watermarks) formou o genoma base para a síntese. Ele precisava conter apenas os genes essenciais para a sobrevivência da bactéria, ainda que o papel desses, individualmente, não tivesse sido elucidado.

O design da sequência foi realizado digitalmente.

Síntese em Quatro etapas

Essa síntese foi, de fato, o grande feito realizado pelo grupo. Eles “montaram” a partir de partes sintéticas bem pequenas um genoma com 1.08 mega pares de bases. No primeiro estágio, 10 cassetes de 1080 pb sintetizados (overlapping synthetic oligonucleotides) foram combinados, formando 109 assemblies de aproximadamente 10kb – setas em azul. Esses, em grupos de 10, foram recombinados para produzir os assemblies com aproximadamente 100 kb – setas em verde. Na etapa final, 11 desses foram combinados para produzir o genoma completo – circulo vermelho. Essas etapas foram realizadas, primeiramente em E.coli, as etapas finais, foram realizadas utilizando leveduras.

Para um melhor entendimento dos processos, recomendo que vá direto ao paper. Algumas leituras auxiliares podem ser necessárias.

Transferência do Genoma

O genoma sintetizado e montado foi transplantado em uma bactéria recipiente (Mycoplasma capricolum) que teve seu material genético totalmente removido. Toda a maquinália celular ( enzimas, organelas,membranas) estava intacta. Dessa forma, os elementos que seriam controlados pelo novo genoma e que atuariam sobre ele estavam presentes. Observe também que o gênero das bactérias (a que serviu como base para o genoma e a que recebeu o material genético sintetizado) é o mesmo. Sendo assim, é esperável que não haja rejeição ao novo material genético e morte da célula.

Após todos esses processos e análise do sucesso do transplante a “nova” bactéria foi capaz de auto-replicação e apresentou o crescimento logarítmico característico das bactérias. Algumas mutações ocorreram durante o processo, mas essas não alteraram o desempenho da célula. Dessa forma, foram mantidas.

Depois de milhares de replicações celulares, as características da célula, bem como todos os seus componentes celulares eram derivados do novo genoma sintetizado, não guardando nenhuma informação da célula recipiente. Com isso em mente, os cientistas do JCVI afirmaram que de fato, criaram uma célula sintética.

Depois de milhares de replicações celulares, as características da célula, bem como todos os seus componentes celulares eram derivados do novo genoma sintetizado, não guardando nenhuma informação da célula recipiente. Com isso em mente, os cientistas do JCVI afirmaram que de fato, criaram uma célula sintética.

Tal afirmação foi extensamente questionada por boa parte da comunidade científica. Para não alongarmos muito a discussão, aconselho que sigam pela apresentação, e observem as opiniões e divergências sobre o assunto.

Minha opinião também se encontra a apresentação e estou disponível para continuarmos essa conversa pelo comentários, caso se sintam a vontade. Em caso de dúvidas, comente.

Apresentação disponível em: http://prezi.com/veskghxybqgv/nature-entra-na-discussao/

Um Abraço.

Modelagem em biologia (sintética), um guia para ateus em modelagem.

Para uma pessoa que lida diariamente com biologia, pode ser bastante difícil imaginar uma maneira de abordar matematicamente um problema em sua área ou como isto poderia ter alguma utilidade. A biologia é uma ciência considerada bastante complexa, pois são muitas as variáveis que podem afetar o sistema. Até mesmo um sistema relativamente simples como a expressão de uma proteína em E. coli, pode se tornar um problema bastante complexo de se modelar se todas as variáveis que afetam a expressão desta proteína forem levadas em consideração. Na realidade, não há nem mesmo quem seja capaz de listar todas estas variáveis. Assim sendo, como é possível fazer um modelo disto, se não consigo nem mesmo listar as variáveis que alteram meu sistema? Neste caso, melhor mesmo fazer como o Calvin e ser um ateu em modelagem, não é mesmo?

Para uma pessoa que lida diariamente com biologia, pode ser bastante difícil imaginar uma maneira de abordar matematicamente um problema em sua área ou como isto poderia ter alguma utilidade. A biologia é uma ciência considerada bastante complexa, pois são muitas as variáveis que podem afetar o sistema. Até mesmo um sistema relativamente simples como a expressão de uma proteína em E. coli, pode se tornar um problema bastante complexo de se modelar se todas as variáveis que afetam a expressão desta proteína forem levadas em consideração. Na realidade, não há nem mesmo quem seja capaz de listar todas estas variáveis. Assim sendo, como é possível fazer um modelo disto, se não consigo nem mesmo listar as variáveis que alteram meu sistema? Neste caso, melhor mesmo fazer como o Calvin e ser um ateu em modelagem, não é mesmo?

Na verdade não, fazer um modelo não é tão complicado assim. Pensar que é necessário colocar tudo no modelo é o erro conceitual mais comum de quem tem formação em áreas complexas como a biologia. Já os físicos por exemplo, tem uma visão dita reducionista, de tentar entender um problema dividindo-o em pequenas partes fundamentais e começar pelo modelo mais simples possível para depois aumentar a complexidade, se necessário (ou possível). Reza a lenda que um dono galinheiro certa vez chamou um fisico para solucionar o porquê as galinhas não estavam botando. Uma semana depois o fisico apareceu com a solução. Entretanto, a solução só era válida para galinhas esfericamente simétricas e no vácuo. True story!

Pode parecer contraditório, mas um modelo que leva mais variáveis em consideração não necessariamente é melhor ou mais “realistico”. Na verdade se um modelo leva mais variáveis em consideração do que outro e ambos tem a mesma efeciência, o segundo modelo é considerado melhor, conforme veremos.

Portanto, o melhor caminho para fazer um bom modelo é considerar as poucas e relevantes variáveis do problema, ou seja, ao fazer um modelo, a principal regra é:

Keep it simple, stupid!!

Este é o famoso princípio KISS, uma boa regra para começar um modelo. A maioria dos modelos funcionam melhor e são melhor entendidos se mantidos simples. Complexidade desnecessária deve ser evitada, mas obviamente, simplicidade demasiada não deve resultar em um modelo útil (como no caso das galinhas). Assim, uma boa maneira de se começar um modelo é pensar quais são as variáveis que devem ser realmente importantes para o problema. Tente formular seu modelo com o mínimo de variáveis e veja se seus resultados condizem com o esperado, ou com os experimentos. Se isto não ocorrer, é um sinal de que seu modelo ou é demasiadamente simples e você esqueceu alguma variável muito importante ou você pode ter feito hipóteses que não sejam válidas. Fazer hipóteses condizentes não é uma tarefa na simples e exige um conhecimento profundo do problema em questão.

O principio KISS é um conceito bastante semelhante à famosa navalha de Occam. Este princípio, introduzido por William Occam diz:

“Se em tudo o mais forem idênticas as várias explicações de um fenômeno, a mais simples é a melhor.”

Exemplo

Para exemplificar o que foi dito, vamos brincar de modelar com um simples exemplo que discutimos certa vez em nosso grupo.

O problema consiste em estimar a concentração de uma proteína (nosso caso era a Cre recombinase) dentro das bactérias E.coli, ou seja, quantas Cre-recombinases existem, em média, por bactéria? Esta inferência é base para estimar o PoPS (veja post anterior)

Este parece ser um problema simples mas pode se tornar bastante complicado de resolver caso o princípio KISS não seja utilizado. Quem é importante neste problema? Devo considerar a temperatura? Devo considerar a quantidade de alimento no meio?

Você pode pensar, e com razão, que a temperatura e a quantidade de alimento são importantes pois afetam a taxa de produção das proteínas. Entretanto estes são exemplos de variáveis que não precisam

ser levados em consideração pois, nos experimentos não trabalharemos com situações extremas de escassez de alimento nem de mudanças de temperatura e pequenas variações destas variáveis (fora de um regime extremo) não devem afetar significantemente a produção da proteína. Muitas são as variáveis que não afetam significamente o sistema e ter intuição disto é fundamental e repito, exige um bom entendimento do problema.

OK, mas por onde começar?

Bom, sabemos que para se produzir uma proteína primeiramente precisamos da produção do RNA mensageiro. A quantidade de mRNA certamente é uma variável relevante!!!

Portanto, vamos tentar criar uma equação sobre como o mRNA deve variar no tempo. A variação temporal de uma variável é representada matematicamente pela derivada da variável no tempo ![]()

Sabemos que nosso mRNA deve ser produzido pela leitura do DNA, feita pela DNA polimerase. OK, mas com que velocidade ela lê isto? Uma boa referencia, é o Bionumbers (tipo um google para dados biológicos)

Lá encontramos que nossa taxa de transcrição (Ktrans) é de, em média, 40 pares de base por segundo. Mas então precisamos saber qual o tamanho do RNA que gera nossa proteína. No caso da Cre é de 1032 pares de base (Nbp). Portanto, quantidade de proteína produzida por tempo e por volume (V) é de:

![]()

Dividimos pelo volume pois queremos saber a variação de concentração, ou seja, quantidade de proteínas por volume (unidade em Molar). Este será o primeiro termo de nossa equação, que se refere a produção do mRNA. Existem outras maneiras dele ser produzido? Se sim, novos termos devem ser adicionados. Neste caso, aparentemente esta é a unica forma dele ser produzido. Mas ele pode ser degradado, não é mesmo? Então precisamos de mais um termo, o de degradação. Novamente se formos até o bionumbers teremos a taxa de degradação (KdRNA) do mRNA. Este novo termo fará com que a taxa do mRNA diminua no tempo, e por este motivo ele é negativo. Portanto nossa equação fica:

![]()

Onde o termo positivo se refere a produção e o negativo se refere a degradação.

Agora vamos escrever uma equação para a tradução do mRNA em proteína. Neste caso encontramos uma taxa de tradução de 15 aminoacidos por segundo. Como nossa proteina tem 1032 pares de base ela deve ter 1032/3=344 aminoacidos. Como, além de produzida, nossa proteína também pode ser degradada então temos uma equação bastante semelhate à anterior:

![]()

Podemos supor que inicialmente a concentração desta proteína é zero, isto não fará diferença nos cálculos mas suponhamos que não haja proteina inicialmente. Ao longo do tempo, a concentração

desta proteína irá crescer até alcançar o equilibrio entre produção e degradação. Neste equilibrio, a concentração das proteínas não mudam mais no tempo e portanto nossas equações são iguais a zero. Para entender o equilibrio, pense na equação logistica que descreve a curva de crescimento de uma população de bactérias. Inicialmente temos um crescimento exponencial, mas depois de um tempo a população satura, ou seja, estabiliza em uma determinada população. Este ponto de saturação é que chamamos de ponto de equilibrio, onde a quantidade de bactérias não muda mais no tempo. Neste ponto, a quantidade de bactérias que morrem é proporcional às que “nascem”. Matematicamente o ponto de equilibrio é um ponto onde a derivada no tempo é igual a zero, portanto:

![]()

![]()

ou seja:

![]()

e

![]()

Agora podemos isolar a concentração do mRNA na primeira equação e substituir na segunda. Com isto, chegamos a:

![]()

Qual o sentido deste valor? Bem você pode utilizar o volume da bactéria e calcular qual a concentração de uma única proteína dentro de uma bactéria e você chegará que isto é aproximadamente 1 nM. Portanto, nosso resultado nos diz que há aproximadamente 2.000 proteínas, em média, dentro da bactéria.

OK, isto quer dizer que se eu fizer um experimento eu vou encontrar exatamente 2000 proteínas dentro da bactéria?

Obviamente não, devemos ter em mente a limitação de nosso modelo. Aproximações foram feitas e há muitas variáveis que podem fazer com que este valor mude. Entretanto, podemos dizer com certa segurança que teriamos algo de 1.000 à 10.000 proteínas na bactéria. Pode parecer muito inexato e que nosso modelo não foi tão útil por não ser preciso. Mas devemos lembrar que inicialmente não tínhamos nenhuma ideia de quantas proteínas haviam. Se alguém chutasse que há somente 10 ou 100 proteínas em média poderiamos pensar que era uma estimativa boa. Com o modelo sabemos que esta estimativa não é boa, que devem haver bem mais proteínas que isto!

Além da quantidade de proteína, com este simples modelo poderiamos estimar o tempo que demora para que a quantidade de proteína sature, ou seja, atinja o ponto de equilibrio. Estas são estimativas que podem ser muito úteis na hora de definir um protocolo experimental e pode economizar uma razoável quantidade de tempo e reagentes durante os experimentos. Portanto, não é necessário de ser ateu em modelagem, mas, tampouco, é recomendado acreditar religiosamente no modelo!!

Polimerase Por Segundo

![]() A Biologia é imprecisa por natureza, e vice versa. Isso é uma grande dificuldade ao se fazer design de sistemas biológicos sintéticos; aquilo que é muito bonito no papel às vezes nunca pode ser feito por motivos obscuros e por excesso de ruído dos sinais do sistema. Não dá pra prever. Na tentativa de deixar dispositivos sintéticos mais previsíveis, a Biologia Sintética tenta padronizar não somente partes biológicas, mas também os sinais que a compõem a dinâmica de seu sistema. Esses sinais são justamente a passagem de informação entre DNA e o fenótipo desejado, mas… como diabos deixar isso mais preciso e medir a velocidade dessa passagem de informação? Como medir “Polimerases Por Segundo”?

A Biologia é imprecisa por natureza, e vice versa. Isso é uma grande dificuldade ao se fazer design de sistemas biológicos sintéticos; aquilo que é muito bonito no papel às vezes nunca pode ser feito por motivos obscuros e por excesso de ruído dos sinais do sistema. Não dá pra prever. Na tentativa de deixar dispositivos sintéticos mais previsíveis, a Biologia Sintética tenta padronizar não somente partes biológicas, mas também os sinais que a compõem a dinâmica de seu sistema. Esses sinais são justamente a passagem de informação entre DNA e o fenótipo desejado, mas… como diabos deixar isso mais preciso e medir a velocidade dessa passagem de informação? Como medir “Polimerases Por Segundo”?

Padronização da Transmissão de Informação

Independente do que um aparelho elétrico faça, existem sinais “universais” que pertencem a todos eles: variações na diferença de potencial, na corrente, no campo elétrico e etc. A transmissão de informação entre os dispositivos eletrônicos que compõem esse aparelho são dadas justamente através desses sinais, fazendo todo o sistema elétrico funcionar. Em circuitos genéticos, sinais análogos à corrente elétrica são as taxas de transcrição e tradução, ou mais especificamente, a velocidade com que – respectivamente – uma polimerase e um ribossomo “leêm” seus nucleotídeos. O problema é que esses sinais (as taxas de transcrição e tradução) não são bons como transmissores de sinais. Entenda o porquê:

PoPS e RiPS: Qual é o sentido disso!?

Para que um transmissor de sinal seja bom, ele precisa facilitar com que dispositivos possam ser facilmente combinados em um sistema – além de ser algo “universal”, como foi dito anteriormente. Foi aí então que, usando experiências da engenharia, os biólogos sintéticos cunharam o termo “PoPS” (Polimerase Per Second – Polimerase Por Segundo) e “RiPS” (Ribossome Per Second – Ribossomo Por Segundo). Muitos pesquisadores acham que a criação desses novos termos é como “reinventar a roda”: qual seria a grande diferença entre isso e as clássicas taxas de transcrição e tradução? A diferença é a abrangência da nova medida. Quando se trata de um sítio operador, um RBS, um RNAm e o próprio gene sendo “lido”, não há diferença alguma em se medir uma taxa de transcrição e o “PoPS” ou uma taxa de tradução e o “RiPS”. Mas faz sentido se medir a taxa de transcrição de um sítio terminador por exemplo!? Esse elemento de DNA, que teoricamente não é transcrito (é ele quem justamente para a transcrição), ainda pode eventualmente ter um “leak” e permitir a passagem de uma polimerase. Usar a expressão “… a taxa de transcrição de um sítio terminador …” não faz sentido nenhum, mas acontece. Se usarmos PoPS, que por definição é o número de vezes que uma RNA polimerase passa por um ponto específico de uma molécula de DNA por unidade de tempo, ainda há sentido, pois nessa definição não importa qual a região do DNA a Polimerase passa. É esse tipo de generalidade que permite o fácil uso e novas combinações de dispositivos sintéticos.

Hierarquia de Abstração

Com a criação de sistemas fáceis de se integrar, os engenheiros biológicos podem se beneficiar de métodos largamente praticados em qualquer campo da engenharia, como a hierarquia de abstração. Com isso é mais simples se lidar com a complexidade de sistemas biológicos quando se omite informações desnecessárias. Desse modo (ver imagem abaixo), alguém trabalhando no nível de abstração das partes biológicas não precisa se preocupar com o design e síntese do DNA que usará, do mesmo modo, alguém trabalhando no nível sistêmico precisa pensar em apenas quais dispositivos incluir e como conectá-los para realizar uma função desejada, sem precisar se preocupar com os outros níveis de abstração.

Imagem retirada de: D. Baker, G. Church, J. Collins, D. Endy, J. Jacobson, J. Keasling, P. Modrich, C. Smolke, and R. Weiss. ENGINEERING LIFE: Building a FAB for biology. Scientific American, pages 44–51, June 2006.

Como medir PoPS?

A maioria dos sistemas criados e estudados hoje em dia em Biologia Sintética envolve controle transcricional da atividade genética, o que faz do PoPS a variável mais difundida na área, principalmente pelas pesquisas envolvendo lógica booleana em sistemas genéticos (portanto não é muito comum encontrar “RiPS” em artigos por aí).

Não existe um método direto para se medir PoPS, mas é possível chegar em seu valor indiretamente através de medições de fluorescência de genes reporter. É possível – se você puder encontrar os parâmetros na literatura ou medí-los – encontrar o PoPS de um dispositivo em cinco passos:

Cinco Passos Para o PoPS

1. Ligação de um Gene Repórter como Output

Antes de mais nada, será preciso de um fluorímetro (é claro) e demum espectofotômetro para medir densidade celular. Como exemplo, vamos observar a parte BBa_F2620:

Esse BioBrick tem como “entrada” a substância de quorum sensing 3-oxohexanoil-homoserina lactona e tem como “saída” PoPS. Em presença de 3OC6HSL, o gene que produz o fator de transcrição luxR promove a transcrição de genes após o Lux pR, na parte final do BioBrick BBa_F2620. Para mensurar o quão ativo o luxpR fica, liga-se outro BioBrick no final do dispositivo para mudar o output do sistema colocando-se o BBa_E0240 – a ORF (Open Reading Frame) do GFP (Green Fluorescent Protein):

Assim tem-se uma nova parte, o BioBrick BBa_T9002:

2. Medição da Fluorescência e Absorbância e Subtração do Background

Para medir a fluorescência do GFP e a absorbância da amostra de células, é preciso criar dois controles: um da absorbância (A) e outro da fluorescência (G). O controle da fluorescência será o próprio BBa_T9002 sem ser induzido pela substância de quorum sensing (G_não-induzido), enquanto o controle da absorbância é feita da maneira trivial, verificando somente a absorbância do meio de cultura (A_background). Para se obter os reais valores de Fluorescência induzida por 3OC6HSL e da densidade celular, basta então subtrair esses valores de background com os valores medidos durante a indução pela substância de quorum sensing:

3. Correlação com a Curva Padrão

Com as correções em mãos, outro procedimento trivial a ser feito é encontrar a curva padrão de fluorescência versus GFP e de absorbância versus número de células. Por exemplo, experimentos feitos em laboratório chegaram a essas retas de correlação de valores:

Em que UFC é “Unidade Formadora de Colônia” – o número de células na amostra. E “GFP” seria o número de moléculas de GFP medidas.

4. Interpolar a Curva de GFP versus Tempo Obtida na Medição

A síntese total de GFP por célula (S_célula) é dada pela taxa de produção de GFP total (S_total) dividida pelo número de células (UFC):

Para encontrar a derivada de [GFP] por tempo, basta plotar os dados de GFP obtidos por tempo e interpolar com uma função logística (provavelmente) para obter a equação que melhor descreve a variação de GFP no tempo.

5. Colocar os Valores Nessa Equação Aqui

Depois de determinada a função Scélula, basta colocá-la nessa fórmula e encontrar o PoPS:

Em que:

a = Taxa de maturação do GFP – 1/s

GammaM = Constante de degradação do RNA – 1/s

GammaI = Constante de degradação do GFP imaturo – 1/s

Rô = Constante de síntese proteica por RNAm (RiPS) – [Proteína]/[RNAm].s

PoPS = Polimerase por segundo – [mRNA]/[DNA].s

CUIDADO: Conteúdo Matemático – Prossiga com Cuidado (Ou não…)

Chega-se nessa expressão através de um pequeno sistema de equações diferenciais:

As equações expressam uma dinâmica simplificada de um sistema de transcrição e tradução de uma informação genética. Para chegar na expressão de PoPS, basta substituir a última equação na segunda e isolar M. Com a expressão resultante, basta substituir a variável M na primeira equação e sua derivada em dM/dt.

ATENÇÃO: Aqui acaba o conteúdo matemático. Está tudo bem agora.

E essa é a história de como você pode encontrar o PoPS – essa variável estranha! – no seu próprio laboratório (ou ao menos entender do que se trata). Assim como um circuito elétrico, que pode ser montado da melhor maneira possível e mesmo assim não funcionar por razões obscuras, sistemas biológicos têm muito mais esse problemático costume de não se comportar como esperado. Contudo essa abordagem mais generalista da atividade transcricional de uma célula é uma boa maneira de se tentar enfrentar o grande desafio de se deixar a biologia mais “engenheirável” e mais “precisa”. Não que essa seja a coisa mais fácil do mundo, mas ela nunca será se ninguém tentar. E estamos aos poucos conseguindo.

Referências:

- Bio FAB Group, Baker D, Church G, Collins J, Endy D, Jacobson J, Keasling J, Modrich P, Smolke C, & Weiss R (2006). Engineering life: building a fab for biology. Scientific American, 294 (6), 44-51 PMID: 16711359

- http://partsregistry.org/Part:BBa_F2620:Experience/Endy/Data_analysis

- http://openwetware.org/wiki/Endy:Measuring_PoPS_on_a_plate_reader