Nano-fios e energia solar

University of Copenhagen – Niels Bohr Institute

Nano-fios para células solares aumentam o limite de eficiência

|

A imagem mostra, da esquerda para a direita, imagens de cristal de arseniato de gálio sobre um substrato de silício, tiradas com um SEM (Scaning Electron Microscope), uma de um único fio, tirada com um TEM (Transmission Electron Microscope) e as colunas de átomos, flagradas por um STEM (Scanning Transmission Electron Microscope) |

||||

Os cientistas do Centro de Nano-Ciência do Niels Bohr Institut, Dinamarca, e da Ecole Polytechnique Fédérale de Lausanne, Suíça, mostraram como um único nano-fio pode concentrar a luz do Sol até 15 vezes mais do que a intensidade normal da luz solar. Estes resultados são surpreendentes e têm um grande potencial para desenvolver um novo tipo de célula solar de alta eficiência.

Devido a algumas propriedades físicas particulares apresentadas pelos nano-fios em absorver a luz, o limite de quanta energia dos raios solares pode ser utilizada acaba sendo maior do que se pensava antes. Estes resultados demonstram o grande potencial de desenvolvimento de células solares com base em nano-fios, diz o PhD Peter, sobre a surpreendente descoberta descrita em um artigo na Nature Photonics.

Os grupos de pesquisas estudaram nos últimos anos como desenvolver e melhorar a qualidade dos cristais de nano-fios que são estruturas cilíndricas com um diâmetro de cerca um décimo-milésimo de um cabelo humano. Acredita-se que os nano-fios terão um grande potencial não só no desenvolvimento de células solares, como também nos futuros computadores quânticos e outros produtos eletrônicos.

|

|

||||

Acontece que os nano-fios naturalmente concentram os raios de Sol em uma área muito pequena do cristal, até um fator de 15 vezes. Como o diâmetro do nano-fio é menor que o comprimento de onda da luz solar, isto causa ressonâncias na intensidade da luz dentro e em torno dos nano-fios. Desta forma, as ressonâncias podem fornecer uma luz solar concentrada para a conversão na energia desejada, o que pode ser usado para obter uma maior eficiência na captação da energia solar, explica Peter Krogstrup.

Um novo limite de eficiência

O típico limite de eficiência – o assim chamado “Limite de Shockley-Queisser” – é um limite que, por muitos anos, tem sido um marco de referência para a eficiência de células solares para os pesquisadores. Porém, agora, parece que esse limite pode ser superado.

“Para um pesquisador é entusiasmante poder mover um limite teórico, como todos sabem. Embora não pareça muito que o limite seja aumentado em alguns pontos percentuais, isso terá um grande impacto no desenvolvimento de células solares, na exploração de raios solares com nano-fios e talvez na extração de energia a nível internacional. No entanto, serão necessários alguns anos até que a produção [industrial] de células solares feitas com nano-fios se torne uma realidade”, declara Peter Krogstrup que acabou de completar seu PhD no Instituto Niels Bohr da Universidade de Copenhagen.

A pesquisa foi (e continua sendo) realizada em colaboração com o Laboratório de Materiais Semicondutores da Escola Politécnica Federal de Lausanne e a Fundação e a companhia SunFlake A / S. A presente descoberta corrobora os resultados publicados na Science em janeiro. Aqui, um grupo de pesquisadores de Lund, mostraram que os raios de Sol eram chupados para dentro dos nano-fios, devido à grande quantidade de energia que sua célula solar produzia.

E o universo ficou mais velho… e diferente

|

|

|

Telescópio do Polo Sul. Imagem da WikiMedia Commons. |

Quando eu publiquei o post O universo antigo produzia mais estrelas do que se pensava, eu tive que escolher entre vários press-releases sobre o mesmo assunto. Eu traduzi o da Universidade de Chicago, mas havia também os da National Science Foundation, “Telescópios Financiados pela NSF no Polo Sul e Chile descobrem bursts de formação de estrelas no universo primitivo”, da Fundação Kavli, “Testemunhando starbursts em galáxias jovens”, da Universidade do Arizona, “[O Telescópio] ALMA expõe fábricas de estrelas escondidas no universo jovem”, do National Radio Astronomy Observatory, “[O Telescópio] ALMA descobre “monstruosas” galáxias starburst no universo jovem”, da Carnegie Institution, “Descobertas galáxias antigas e extremamente ativas”, e outros dois com o mesmo título: “[O Telescópio] ALMA reescreve a história do baby boom estelar do Universo”, um da Universidade McGill e outro do European South Observatory.

É claro que todo este fuzuê sobre a descoberta tinha um motivo bem claro: os cálculos dos astrofísicos sobre a linha-do-tempo da formação de estrelas, galáxias e do próprio universo continham algum erro.

Imediatamente me ocorreu entrar em contato com o scibling Ethan Siegel do Starts With a Bang, mas diversas outras coisas (combinadas com meu raro talento em procrastinar) foram “deixando-para-depois” e, quando finalmente eu acessei o blog dele, me deparei com o post “O que todos deveriam saber sobre o universo, na véspera [da divulgação dos dados] do [Telescópio Espacial] Planck”. Bem… se Ethan esperava alguma novidade importante dos dados do Planck, eu também poderia…

|

|

|

Imagem do Fundo Cósmico de Micro-ondas obtida pelo Satélite Planck. |

Agora, esta figura já é conhecida por todos e as agências de notícias já comentaram que o Universo é, pelo menos, 80 milhões de anos mais velho do que se calculava. Mas, como eu esperava, Ethan chama a atenção para diversas outras novidades em seu post “Do que é feito todo o Universo, graças ao Planck”. E eu vou tomar a liberdade de kibar desavergonhadamente o post dele. Espero que me perdoem se eu não reproduzir algumas das ilustrações do post do Ethan porque elas são demasiado técnicas. Por mais que eu ame a física quântica e a astrofísica, quando começam a argumentar “se o hamiltoniano é hermitiano”, eu me sinto como o cachorrinho que caiu do caminhão de mudanças…

|

|

|

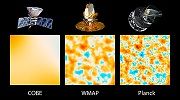

Comparação da Resolução das imagens Cobe, WMAP e Planck. Crédito: NASA Jet Propulsion Laboratory, CalTech. |

A primeira coisa que Ethan enfatiza é a qualidade da imagem fornecida pelo Planck. Como diz ele, na década de 1990 o satélite Cosmic Background Explorer (COBE ou Explorador do Fundo Cósmico) nos deu uma primeira imagem difusa do Fundo Cósmico de Micro-ondas (Cosmic Microwave Background, ou simplesmente CMB). Se você está pensando naquele eco do Big Bang descoberto quase que por acaso por Penzias e Wilson em 1965, está correto! A primeira imagem disto foi obtida na década de 1990 pelo satélite Cobe, com uma resolução de imagem de cerca de 7 graus, e a sonda Wilkinson Microwave Anisotropy Probe (WMAP) da NASA obteve, em 2006, após muita filtragem dos ruídos das emissões “atuais”, uma imagem bem mais nítida do CMB, com uma resolução de cerca de meio grau. Agora, também após um exaustivo processo de filtragem do ruído, o Planck chegou ao limite de resolução possível; Ethan enfatiza que o problema não é o da sensibilidade dos instrumentos do Planck, mas da própria natureza do universo!

A segunda coisa que ele realça é que o universo não só é composto de mais matéria do que se pensava, como também está se expandindo mais devagar do que se calculava. O Parâmetro de Hubble medido pelo Planck é tão menor do que aquele que se usava que, se fosse ele a única diferença encontrada, significaria que o universo seria um bilhão de anos mais velho do que se pensava! (Só que não…) As quantidades de matéria normal e escura são bem maiores do que se acreditava, sobrando uma fatia menor para a energia escura. Em lugar de 73% de energia escura, o Planck nos diz que é algo na faixa de 68 a 69%; a matéria escura deve ficar entre 26 a 26,5% e a matéria bariônica (ou “normal”, da qual somos feitos nós e as estrelas) não é mais só 4,6% do universo: o número subiu para 4,9%. Ah!… Sim… E, em tanto quanto o Planck tem a nos dizer, não há uma “curvatura” no universo: ele é “plano”.

Em outras palavras, existe um pouco mais de matéria normal, uma quantidade significativamente maior de matéria escura e uma quantidade significativamente menor de energia escura do que pensávamos! De forma que, enquanto a taxa de expansão menor nos diz que o universo é mais velho do que acreditávamos, o aumento de matéria (e diminuição da energia escura) nos diz que o universo é mais jovem do que seria de outra forma!

Um universo que fosse composto por 100% de matéria normal + matéria escura, teria apenas uns 10 bilhões de anos, porém o nosso parece ser dividido em cerca de 31,5% de matéria-total e 68,5% de energia escura. De forma que, quando ajustamos nossos atuais dados, chegamos a um universo com 13,81 bilhões de anos, ou seja: 80 milhões de anos mais velho do que nossa melhor estimativa anterior.

Outra coisa que se procurou entre os dados do Planck foi a “assinatura” de ondas gravitacionais primevas, o que corroboraria certos modelos da inflação do universo e descartaria outros. Os dados de polarização ainda estão sendo analisados, mas, por enquanto, nada definitivo emergiu.

Finalmente, os dados confirmam algo muito esquisito, já notado anteriormente: existe um alinhamento das anomalias locais do CMB com o eixo de nossa galáxia, algo que os astrofísicos chamam jocosamente de “eixo do mal”.

Crédito da imagem: ESA e a Colaboração Planck (essa eu não achei o original e kibei direto do blog do Ethan)

O universo antigo produzia mais estrelas do que se pensava

“Ruidos” nos dados levam à surpreendente descoberta de um nascedouro de estrelas

|

|

||||

Por — Steve Koppes and Marcus Woo

Quando uma leva de brilhantes objetos cósmicos apareceu pela primeira vez nos mapas feitos com dados obtidos pelo Telescópio do Polo Sul, os astrônomos do Instituto Kavli de Física Cosmológica da Universidade de Chicago viram isto apenas como um aborrecimento inevitável.

As fontes luminosas interferiam com os esforços para medir com maior precisão o fundo cósmico de micro-ondas — o brilho remanescente do big bang. No entanto, os astrônomos logo perceberam que tinham feito uma rara descoberta na varredura ampla dos céus feita pelo Telescópio do Polo Sul. Os espectros de alguns dos objetos brilhante – o arco-íris de luz que eles emitem – eram inconsistentes com o que os astrônomos esperavam de uma população de rádio-galáxias bem conhecida.

Pelo contrário, os objetos pareciam ser galáxias cheias de poeira e com uma alta taxa de formação de estrelas. Esse tipo de galáxia deveria ser facilmente identificável nas varreduras dos céus na faixa infravermelha, só que não havia coisa alguma conhecida que correspondesse ao que o Telescópio do Polo Sul tinha descoberto. Eles tinham que estar extremamente distantes para escaparem da detecção do infravermelho e, portanto, tinham que ser extremamente luminosos. Intrigados, os astrônomos realizaram um imageamento detalhado do local indicado com o novo Telescópio ALMA (Atacama Large Millimeter Array) no Deserto de Atacama, no Chile. Estas observações mostraram que as galáxias poeirentas estavam prenhes de estrelas em formação muito antes do que se previa na história do cosmo.

|

|

||||

Joaquin Vieira, atualmente um doutor do California Institute of Technology, encabeça uma equipe que relata a descoberta na edição de 14 de março da Nature e em dois outros artigos que serão publicados no Astrophysical Journal.

“Nós mal podíamos esperar o ALMA ficar pronto para que pudéssemos realizar essas observações”, relata Vieira, com mestrado em 2005 e PhD em 2009, que baseou sua pesquisa de doutorado na UChicago na descoberta de fontes extra-galáticas. “As fontes que descobrimos com o Telescópio do Polo Sul ficavam tão distantes no céu do Sul que nenhum telescópio no Hemisfério Norte as podia observar. Nós temos o raro privilégio de estarmos entre os primeiros astrônomos a usarem o ALMA.”

Vieira tem trabalhado com o Telescópio do Polo sul desde o início, tendo ajudado a construir o telescópio e sua câmera, diz John Carlstrom, Professor de Serviços Distinguidos S. Chandrasekhar em Astronomia e Astrofísica na UChicago. “Ele esteve envolvido desde o chão, ou do gelo para ser mais preciso”, diz Carlstrom, que chefia a colaboração do TPS e é um co-autor do artigo na Nature.

|

|

||||

Uma produção prodigiosa de estrelas

As galáxias starburst produzem estrelas a uma taxa prodigiosa, criando o equivalente a um milhar de novos sóis anualmente. Vieira e seus colegas descobriram starbursts que estavam parindo estrelas quando o universo tinha apenas um bilhão de anos de idade. Antes disto, os astrônomos duvidavam que as galáxias pudessem formar novas estrelas tão cedo na história do universo.

Brilhando com a energia de um trilhão de sóis (ou mais), essas galáxias recém-descobertas são vistas como eram mais ou menos há 12 bilhões de anos, mostrando uma “foto de infância” das galáxias mais maciças nas vizinhanças cósmicas da Terra atualmente. “Quanto mais distante for a galáxia, mais se está olhando para o passado, de forma que, ao medir suas distâncias, nós podemos alinhavar uma linha de tempo sobre o quão vigorosamente o universo vem fazendo novas estrelas nos diferentes estágios de sua existência de 13,7 bilhões de anos”, explica Vieira.

Os astrônomos descobriram dúzias dessas galáxias com o Telescópio do Polo Sul, um prato de 10 metros na Antártica que varre o céu na faixa de comprimento de onda milimétrico (situada entre as faixas de rádio e infravermelho do espectro eletromagnético). Então a equipe deu uma olhada mais detalhada, usando o ALMA no Chile. “Essas não são galáxias normais”, diz Vieira. “Elas formavam estrelas a uma taxa extraordinária quando o universo ainda era muito jovem — nós ficamos muito surpresos em encontrar galáxias assim tão cedo na história do universo”.

As novas observações representam alguns dos mais significativos resultados científicos do ALMA até agora. Vieira afirmou que “Não poderíamos ter feito isto sem a combinação do TPS e do ALMA”, acrescentando que “O ALMA é tão sensível que vai mudar nossa visão do universo de várias maneiras diferentes”.

Os astrônomos usaram somente 16 dos 66 pratos que eventualmente comporão o ALMA, que é o mais poderoso telescópio que funciona nos comprimentos de onda milimétrico e sub-milimétrico. O ALMA começou a operar no ano passado.

Análise dos dados do ALMA

A análise dos dados do ALMA mostraram que mais de 30% das novas galáxias começaram a existir a apenas um bilhão de anos depois do big bang. Só nove dessas galáxias eram anteriormente conhecidas – o número dessas galáxias quase que dobrou, dando novos dados valiosos que auxiliarão outros pesquisadores a limitar e refinar modelos de computador de formação de estrelas e galáxias no universo primitivo.

A equipe de Vieira estabelece a distância dessas poeirentas galáxias starburst a partir das emissões de seus gases e da própria poeira. Antes, os astrônomos tinham que depender de uma complicada combinação de observações indiretas ópticas e de rádio, precisando de muitos telescópios para estudar as galáxias. Porém a sensibilidade sem precedentes do ALMA e sua capacidade de medir os espectros permitiu aos astrônomos fazer suas observações e analisá-las em um único passo. Como resultado, as novas distâncias são mais confiáveis e representam a melhor amostra, até agora, dessa população de galáxias primitivas.

As propriedades exclusivas desses objetos também ajudou nas medições. Primeiro, as galáxias observadas por acaso estavam sob o efeito de lentes gravitacionais — um fenômeno previsto por Einstein, no qual uma galáxia mais próxima encurva a luz de uma galáxia mais ao fundo, como uma lente de aumento. Esse efeito de lente faz com que as galáxias mais ao fundo pareçam mais brilhantes, o que reduz o tempo necessário para observá-las com um telescópio umas 100 vezes.

Segundo, os astrônomos tiraram vantagem de uma característica fortuita dos espectros dessas galáxias. Normalmente, galáxias mais distantes aparecem mais esmaecidas. Mas acontece que o universo em expansão desvia os espectros de emissão de uma maneira tal que a luz que recebemos na faixa milimétrica não é atenuada para fontes que estejam mais distantes de nós. Consequentemente, as galáxias aparecem, nessas faixas de comprimento de onda, com o mesmo brilho, não importa a distância.

Os novos resultados representam aproximadamente um quarto do número total de fontes que Vieira e seus colegas descobriram com o Telescópio do Polo Sul. Eles preveem encontrar ainda mais dessas galáxias starbust poeirentas e esperam que algumas sejam de épocas ainda mais antigas do universo, à medida em que continuam analisando seus dados.

Nota do tradutor: eu escolhi este press-release entre vários outros que relatam a mesma descoberta. Essencialmente, todos contém as declarações de Vieira e cada instituição “puxa a brasa para sua sardinha”, como faz a UChicago ao descrever os títulos de Vieira neste aqui.

Descoberto novo sistema estelar próximo

O sistema estelar mais próximo encontrado no último século

|

|

||||

Por Barbara K. Kennedy

Um para de estrelas recém-descobertas é o terceiro sistema estelar mais próximo do Sol, de acordo com um artigo a ser publicado em Astrophysical Journal Letters. O par é o sistema estelar mais próximo descoberto desde 1916. A descoberta foi feita por Kevin Luhman, um professor associado de astronomia e astrofísica da Penn State University e pesquisador no Centro para Exoplanetas e Mundos Habitáveis da Penn State.

Ambas as estrelas no novo sistema binário são “anãs marrons”, ou seja, estrelas com massa tão pequena que jamais conseguiram chegar à temperatura necessária para dar início à fusão do hidrogênio. Por causa disso, elas são muito frias e esmaecidas, lembrando mais um planeta gigante como Júpiter do que uma estrela brilhante como o Sol.

“A distância até o par de anãs marrons é de 6,5 anos-luz – tão próximas que as emissões de TV de 2006 daqui da Terra estão chegando lá agora”, diz Luhman. “Isto vai ser um excelente campo de caça por novos planetas porque é muito próximo da Terra, o que faz ser bem mais fácil observar quaisquer planetas que estejam em órbita de qualquer uma das anãs marrons”. E Luhman acrescenta que, já que é o terceiro sistema estelar mais próximo, no futuro distante pode ser um dos primeiros destinos de expedições tripuladas além do sistema solar.

|

|

||||

O sistema estelar tem o nome “WISE J104915.57-531906” porque foi descoberto em um mapa completo do céu obtido pelo satélite Explorador de Busca Infravermelho Grande-angular (Wide-field Infrared Survey Explorer = WISE) da NASA. Ele fica um pouquinho mais distante do que a segunda estrela mais próxima, a Estrela de Barnard, que foi descoberta em 1916 e fica a 6 anos-luz do Sol. O sistema estelar mais próximo consiste de Alpha Centauri, que se descobriu ser o vizinho mais próximo do Sol em 1839, a uma distância de 4,4 anos-luz e a menos luminosa Proxima Centauri, descoberta em 1917 a 4,2 anos-luz.

Edward (Ned) Wright, o principal investigador do satélite WISE, declarou: “Uma das principais metas da proposta do WISE era descobrir as estrelas mais próximas do Sol. O WISE 1049-5319 é de longe o sistema estelar mais próximo descoberto através dos dados do WISE e podemos obter vistas mais aproximadas desse sistema binário com grandes telescópios como o Gemini e o futuro Telescópio Espacial James Webb que vão nos ensinar um bocado sobre as estrelas de pequena massa conhecidas como anãs marrons”. Wright é o Catedrático Presidente David Saxon de Física e professor de física e astronomia na UCLA.

|

|

||||

Os astrônomos vinham especulando há tempos sobre a possível existência de um objeto escuro e distante em órbita do Sol, algumas vezes chamado de “Nêmesis”. No entanto, Luhman concluiu que “podemos descartar a hipótese de que o novo sistema de anãs marrons seja este tal objeto porque ele se move pelo céu rápido demais para estar em órbita em torno do Sol”.

Para descobrir o novo sistema estelar, Luhman estudou as imagens do ceú que o satélite WISE obteve durante um período de 13 meses que terminou em 2011. Durante sua missão, o WISE observou cada pedaço do céu de 2 a 3 vezes. “Por estas imagens intervaladas no tempo, eu pude concluir que o sistema estava se movendo muito depressa pelo céu – uma grande pista de que ele estava provavelmente muito próximo de nosso sistema solar”, explicou Luhman.

Após ter detectado este movimento rápido nas imagens do WISE, Luhman foi procurar por outros indícios detectados do sistema em outras pesquisas anteriores. Ele descobriu que, realmente, ele tinha sido detectado em imagens desde 1978 até 1999 obtidas pelas Digitized Sky Survey, a Two Micron All-Sky Survey e a Deep Near Infrared Survey of the Southern Sky. “Com base no movimento aparente desse sistema estelar tiradas das imagens do WISE, eu fui capaz de extrapolar as posições prováveis dele nas pesquisas mais antigas e, com certeza, lá estava ele”, diz Luhman.

Combinando as detecções do sistema estelar das várias pesquisas, Luhman foi capaz de medir sua distância através da paralaxe que é a aparente mudança de posição de uma estrela causada pela órbita da Terra em torno do Sol. Aí ele usou o Telescópio Gemini [do Hemisfério] Sul, em Cerro Pachón no Chile, para obter seu espectro, o qual mostrou que o sistema tinha uma temperatura muito baixa e, portanto, era uma anã marrom. “E como um bônus adicional, as imagens nítidas do Gemini também revelaram que o objeto não era apenas uma anã marrom, mas um par delas orbitando uma a outra”, acrescenta Luhman.

“Foi um verdadeiro trabalho de detetive”. conta Luhman. “Existem bilhões de pontos em infravermelho pelo ceú e o mistério é qual deles – se é que algum deles é – pode ser uma estrela bem próxima de nosso sistema solar”.

CONTATOS

Kevin Luhman at Penn State: kluhman@astro.psu.edu

Barbara Kennedy at Penn State (PIO): (+1) 814-863-4682, science@psu.edu

Peter Michaud at Gemini (PIO): 808-974-2510, pmichaud@gemini.edu

Edward (Ned) Wright at WISE and UCLA: 310-825-5755, wright@astro.ucla.edu

IMAGENS e ANIMAÇÃO

Imagens de alta definição e uma animação online em http://science.psu.edu/news-and-events/2013-news/Luhman3-2013.

Driblando a incerteza quântica (2)

Dando a volta no Princípio da Incerteza

Físicos realizam as primeiras medições diretas dos estados de polarização da luz

|

|

||||

Pesquisadores da Universidade de Rochester e da Universidade de Ottawa aplicaram uma técnica recentemente desenvolvida para medir diretamente pela primeira vez os estados de polarização da luz. Seu trabalho ao mesmo tempo suplanta os importantes desafios impostos pelo famoso Princípio da Incerteza de Heisenberg, como também é aplicável aos qubits, as unidades da teoria da informação quântica.

Seus resultados são relatados em um artigo na edição desta semana da Nature Photonics.

A técnica de medição direta foi inicialmente desenvolvida em 2011 pelos cientistas do Conselho Nacional de Pesquisas do Canadá (National Research Council) para medir a função de onda – uma maneira de estabelecer o estado de um sistema quântico.

Essa medição direta da função de onda sempre pareceu impossível por causa de um dos fundamentos do princípio da incerteza – a ideia de que certas propriedades de um sistema quântico só podem ser conhecidas de maneira vaga, se outras propriedades relacionadas forem conhecidas com precisão. A capacidade de realizar tais medições diretamente desafia diretamente a ideia de que uma completa compreensão de um sistema quântico jamais poderia decorrer de uma observação direta.

Os pesquisadores em Rochester/Ottawa, liderados por Robert Boyd, que desempenha funções em ambas universidades, mediu os estados de polarização da luz – as direções nas quais os campos elétrico e magnético da luz oscilam. Seu principal resultado, tal como o da equipe pioneira na medição direta, é que é possível medir variáveis chave relacionadas, conhecidas como “variáveis conjugadas”, de uma partícula ou estado quântico diretamente. Os estados de polarização da luz podem ser usados para codificar informação e exatamente por isso podem ser a base dos qubits nas aplicações de informação quântica.

“A capacidade de realizar medições diretas da função de onda quântica tem importantes implicações futuras para a ciência da informação quântica”, explica Boyd, Catedrático de Óptica Quântica Não-linear Canada Excellence Research da Universidade de Ottawa e Professor de Óptica e Física na Universidade de Rochester. “O trabalho corrente de nosso grupo envolve aplicar esta técnica a outros sistemas, por exemplo, medir a forma de um estado quântico “misturado” (o oposto a um estado “puro”)”.

Anteriormente, uma técnica chamada tomografia quântica permitiu aos pesquisadores medir a informação contida nesses estados quânticos, porém somente de maneira indireta. A tomografia quântica necessita de uma grande quantidade de pós-processamento dos dados e isto é um processo demorado, não necessário na técnica de medição direta. Em outras palavras, em princípio, a nova técnica fornece a mesma informação que a tomografia quântica, porém em um tempo significativamente menor.

“A chave para a caracterização de qualquer sistema quântico é reunir informações sobre as variáveis conjugadas”, declara o co-autor Jonathan Leach, atualmente um palestrante da Universidade Heriot-Watt, no Reino Unido. “A razão pela qual se pensava ser impossível medir duas variáveis conjugadas diretamente é porque medir uma causaria o colapso da função de onda antes que se pudesse medir a outra”.

A técnica de medição direta emprega um “truque” para medir a primeira propriedade de forma tal que não há perturbação significativa do sistema e a informação da segunda propriedade pode ainda ser obtida. Esta medição cuidadosa consiste em uma “medição fraca” da primeira propriedade, seguida de uma “medição forte” da segunda propriedade.

Esta medição fraca, descrita há 25 anos, requer que o acoplamento entre o sistema e o medidor seja, como o nome sugere, “fraco” o que significa que o sistema quase não seja perturbado pelo processo de medição. O lado ruim deste tipo de medição é que uma única medição fornece somente uma pequena quantidade de informação e, para conseguir uma leitura precisa, o processo tem que ser repetido várias vezes a partir do que se obtêm uma média dos resultados.

Boyd e seus colegas usaram a posição e o momento da luz como indicadores do estado de polarização. Para acoplar a polarização ao grau de liberdade espacial, eles usaram cristais bi-refringentes: quando a luz passa através de um cristal desses, é introduzida uma separação espacial entre polarizações diferentes. Por exemplo, se a luz for composta de uma combinação de componentes polarizados vertical e horizontalmente, as posições dos componentes individuais vão se separar quando eles passarem através do cristal conforme suas polarizações. A espessura do cristal pode ser usada para controlar a força da medição, fraca ou forte, e estabelecer o grau de separação correspondente, pequeno ou grande.

Nesta experiência, Boyd e seus colegas passaram a luz polarizada através de dois cristais de diferentes espessuras: o primeiro, um cristal muito fino que media “fracamente” os estados de polarização vertical e horizontal; o segundo, um cristal muito mais espesso que media “fortemente” o estado de polarização diagonal e anti-diagonal. Como a primeira medição era “fraca”, o sistema não era perturbado de maneira significativa e, dessa forma, a informação obtida pela segunda medição ainda era válida. Este processo é repetido várias vezes para a obtenção de um resultado estatisticamente significativo. Reunindo tudo, se tem uma caracterização completa e direta dos estados de polarização da luz.

Os demais autores do artigo são Jeff Z. Salvail, Megan Agnew e Allan S. Johnson, todos estudantes da Universidade de Ottawa quando a pesquisa foi realizada e o estudante de pós-graduação de Ottawa, Eliot Bolduc.

Este trabalho foi financiado pelo Programa Canada Excellence Research Chairs (CERC) e Boyd também reconhece o apoio do Programa DARPA InPho.

O terceiro cinturão de Van Allen

NASA/Goddard Space Flight Center

A sonda Van Allen da NASA descobre uma surpresa em torno da Terra

|

|

||||

Após o lançamento da maior parte das espaçonaves científicas da NASA, os pesquisadores esperam pacientemente por meses, à medida em que os instrumentos são ligados, um de cada vez, lentamente levados à máxima potência e testados para se assegurar que eles funcionam em plena capacidade. É um rito de passagem para qualquer novo satélite no espaço e uma agenda assim estava programada para as Sondas Van Allen quando elas foram lançadas em 30 de agosto de 2012 para estudar os dois cinturões de radiação gigantes que circundam a Terra.

No entanto, um grupo de cientistas da missão resolveu mudar esses planos. Eles pediram que o Telescópio Relativístico Elétron Próton (Relativistic Electron Proton Telescope = REPT) fosse ligado bem cedo – apenas três dias após o lançamento – a fim de que suas observações se superpusessem com as de outra missão chamada SAMPEX (Solar, Anomalous, and Magnetospheric Particle Explorer = Explorador de Partículas Solares, Anômalas e Magnetosféricas) que iria em breve sair de órbita e re-entrar na atmosfera terrestre.

Foi uma decisão afortunada. Logo antes do REPT ser ligado, a atividade no Sol tinha emitido um jorro de energia na direção da Terra que fez os cinturões de radiação oscilarem. O instrumento REPT funcionou bem desde que foi ligado em 1º de setembro. Ele realizou observações dessas novas partículas aprisionadas entre os cinturões, registrando suas altas energias e o aumento de tamanho dos cinturões.

Aí aconteceu algo que ninguém tinha visto antes: as partículas de assentaram em uma nova configuração que exibia um cinturão extra, o terceiro, que se projetava para o espaço. Alguns poucos dias após seu lançamento, as sondas Van Allen mostraram aos cientistas algo que os faria re-escrever seus livros-texto.

“Lá pelo quinto dia após o REPT ser ligado, nós conseguimos plotar nossas observações e observar a formação de um terceiro cinturão de radiação”, disse Shri Kanekal, o cientista adjunto para a missão das Sondas Van Allen no Centro Espacial Goddard da NASA em Greenbelt, Maryland, co-autor de um artigo sobre esses resultados. “Nós chegamos a pensar que havia algo errado com nossos instrumentos. Nós verificamos tudo, mas não havia coisa alguma errada. O terceiro cinturão persistiu lindamente, dia após dia, semana após semana, por quatro semanas”.

Os cientistas publicaram seus resultados em um artigo na Science de 28 de fevereiro de 2013. A incorporação desta nova configuração a seus modelos dos cinturões de radiação dá aos cientistas novas pistas sobre o que causa a mudança de formato dos cinturões – uma região que pode algumas vezes oscilar dramaticamente em resposta à energia emitida pelo Sol, causando impactos sobre satélites e espaçonaves ou apresentar riscos potenciais ao voo espacial tripulado.

Os cinturões de radiação, ou cinturões de Van Allen, foram descobertos com os primeiros lançamentos de satélites em 1958 por James Van Allen. Missões subsequentes observaram partes dos cinturões – inclusive a SAMPEX que observou os cinturões por baixo – porém o que causa tal variação dinâmica permanecia algo de misterioso. Realmente, tempestades aparentemente semelhantes vindas do Sol, às vezes causavam efeitos completamente diferentes nos cinturões, ou, em outras, não mudavam coisa alguma.

As Sondas Van Allen consistem em duas espaçonaves idênticas com a missão de mapear essa região com detalhes requintados, catalogando uma ampla gama de energias e partículas e rastreando o zoológico de ondas magnéticas que pulsam pela área, algumas vezes acelerando as partículas a velocidades tão extremas que elas escapam inteiramente dos cinturões.

|

|

||||

“Nós já tínhamos uma longa série de dados de missões como a SAMPEX”, diz Daniel Baker que é o principal investigador do REPT na Universidade do Colorado em Boulder e principal autor do artigo na Science. “Porém nós nunca estivemos dentro da garganta do acelerador que funciona uns poucos quilômetros acima de nossas cabeças, acelerando essas partículas a velocidades incríveis”.

Em seus primeiros seis meses em órbita, os instrumentos nas Sondas Van Allen funcionaram excepcionalmente bem e os cientistas estão entusiasmados com a catadupa de observações que chegam com uma clareza sem precedentes. Esta é a primeira vez que os cientistas puderam reunir um conjunto completo de dados acerca dos cinturões, com o bônus adicional de observá-los a partir de duas espaçonaves separadas que podem mostrar mais claramente como os eventos transitam pela área.

A descoberta de algo novo no espaço tal como o terceiro cinturão de radiação, tem mais implicações do que o simples conhecimento de que um tal terceiro cinturão é possível. Em uma região do espaço que permanece ainda tão misteriosa, quaisquer observações capazes de ligar certas causas a certos efeitos adiciona uma nova peça de informação ao quebra-cabeças.

Baker gosta de comparar os cinturões de radiação aos anéis de armazenagem de partículas nos aceleradores dos laboratórios de física. Nesses aceleradores, usa-se campos magnéticos para manter as partículas orbitando em círculos, enquanto se usa ondas de energia para enviar essas partículas a velocidades cada vez maiores. Nesses aceleradores, tudo tem que ser cuidadosamente sintonizado com o tamanho e formato do anel, e com as características dessas partículas. Os Cinturões de Van Allen dependem de uma sintonia similar. Uma vez que os cientistas observam os anéis somente em certos lugares e certas ocasiões, eles podem calcular com mais exatidão quais partículas e quais ondas devem estar causando um determinado formato. Cada novo conjunto de observações ajuda a estreitar o campo ainda mais.

“Nós podemos oferecer estas novas observações aos teóricos que vão modelar o que está acontecendo nos cinturões”, diz Kanekal. “A natureza nos presenteia com este evento – ele está bem aí, é um fato, não há o que discutir – e agora temos que explicar por que é este o caso. Por que o terceiro cinturão persistiu por quatro semanas? Por que ele se modifica? Toda esta informação nos ensina mais sobre o espaço”.

Os cientistas já têm teorias sobre exatamente qual tipo de ondas varrem para fora as partículas na região do “escaninho” entre os dois primeiros cinturões. Agora eles têm que criar modelos para descobrir quais ondas têm as características corretas para varrer as partículas para fora da nova região de “escaninho” ainda mais longe também. Outra observação fascinante para explorar reside em rastrear as causas que dão origem a esta nova região ainda antes: em 31 de agosto de 2012, um longo filamento de material solar que tinha pairado sobre a atmosfera solar, foi expelido para o espaço. Baker diz que isto pode ter causado a onda de choque que levou à formação do terceiro cinturão poucos dias depois. Além disto, o novo cinturão foi virtualmente aniquilado quatro semanas depois de ter aparecido por outra onda de choque provinda do Sol. Ser capaz de observar um tal fenômeno durante seu acontecimento, fornece mais material ainda para teorias sobre os Cinturões de Van Allen.

A despeito de já haver 55 desde que os cinturões de radiação foram descobertos, ainda há muito o que investigar e explicar, e apenas poucos dias após seu lançamento, as Sondas Van Allen mostraram que os cinturões ainda são capazes de surpreender.

“Eu acho que demos muita sorte”, diz Baker. “Termos ligado nossos instrumentos quando o fizemos, com grande confiança em nossos engenheiros e que os instrumentos funcionariam imediatamente, e ainda tendo a cooperação do Sol para mexer com o sistema como mexeu – foi tudo uma oportunidade extraordinária. Isso corroborou a importância da missão e como é importante revisitar os Cinturões de Van Allen como uma novidade”

O Laboratório de Física Aplicada da Universidade Johns Hopkins construiu e opera as Sondas Van Allen. As Sondas Van Allen compreendem a segunda missão do programa “Vivendo com uma estrela” (Living With a Star = LWS) da NASA para explorar os aspectos do sistema Sol-Terra que afetam diretamente a vida e a sociedade. O programa é gerenciado pelo Centro Espacial Goddard da NASA.

Driblando a incerteza quântica

Truques quânticos com medições

|

||||

Uma equipe de físicos da Universidade de Innsbruck, Áustria, realizou uma experiência que parece contradizer os fundamentos da teoria quântica – à primeira vista. A equipe, liderada por Rainer Blatt, reverteu uma medição quântica em um protótipo de processador de informação quântico. A experiência foi possibilitada por uma técnica que foi desenvolvida para a correção de erros quânticos em um futuro computador quântico.

As medições em sistemas quânticos têm intrigado gerações de físicos devido a suas propriedades contraintuitivas. Uma delas é o fato de que medições em um sistema quântico são, de modo geral, não determinísticas. Isso quer dizer que, mesmo que o estado do sistema seja completamente conhecido, é impossível prever o resultado de uma única medição. Além disso, a medição altera o estado do sistema, de forma que uma medição posterior certamente vai dar o mesmo resultado da primeira medição. Em outras palavras, a primeira medição altera irreversivelmente o sistema.

Em sua recente experiência, os cientistss demonstraram que é possível reverter uma medição com o auxílio de um protocolo de correção de erro quântico. Isto aparentemente contradiz os fundamentos da teoria quântica que proíbe explicitamente a reversão de uma medição quântica. Porém, uma olhadela mais detalhada torna fácil a solução deste enigma: a equipe de Philipp Schindler transfere a informação pertinente a uma única partícula para um estado emaranhado que consiste de três partículas. Se agora uma partícula individual for medida, seu estado original pode ser reconstruído a partir das informações que residem nas duas outras partículas restantes, o que não contraria as leis da mecânica quântica.

Artigo publicado: Undoing a quantum measurement. Philipp Schindler, Thomas Monz, Daniel Nigg, Julio T. Barreiro, Esteban A. Martinez, Matthias F. Brandl, Michael Chwalla, Markus Hennrich, Rainer Blatt. Physical Review Letters 110, 070403 (2013). DOI: 10.1103/PhysRevLett.110.070403 (http://dx.doi.org/10.1103/PhysRevLett.110.070403)

A vitória dos Trolls

University of Wisconsin-Madison

A vitória dos trolls: comentários rudes nos blogs ofuscam o brilho da ciência online

BOSTON – Os trolls estão ganhando.

Escolha um post acerca de qualquer aspecto da ciência – qualquer um – role até os comentários do blog e deixe o pau cantar:

- “Eu fico imaginando quanto dinheiro de impostos foi gasto com este estudo ‘profundo’?”

- “Eu acho que se pode pegar todos esses estudos feitos por cientistas da cabeça grande, 99% deles socialistas e comunistas, e enfiar eles onde o sol não brilha.”

- “Bah!… Lá vêm os histéricos do mito das mudanças climáticas de novo…”

- “Este artigo é 100% propaganda babaca.”

- “Falando de palermas, se você existisse nos anos 70, quando também havia cientistas, a grande novidade era a chegada de uma nova era glacial. E não me venha com essas m€Ʀ** de emissões de carbono.”

Essas grosserias, gostem ou não, são agora o prato principal de nossa dieta de notícias e, no reino das notícias de ciência online, as diatribes, esculachos e insultos estão cobrando seu pedágio sobre a percepção pública da ciência e da tecnologia, de acordo com um estudo realizado por pesquisadores da Universidade de Wisconsin-Madison.

Dirigindo-se aos cientistas presentes aqui hoje (14 Fev 2013) na reunião anual da Associação Americana para o Progresso da Ciência (American Association for the Advancement of Science – AAAS), a pesquisadora de comunicação científica da UW-Madison, Dominique Brossard, relatou os resultados de um estudo que mostram que o tom dos comentários pode, por si só, influenciar a percepção dos riscos advindos da nanotecnologia, a ciência da manipulação de materiais nas menores escalas.

O estudo, agora publicado no Journal of Computer Mediated Communication, foi financiado pela Fundação Nacional de Ciências (National Science Foundation – NSF). A amostragem foi tomada em um segmento representativo de 2.338 americanos em uma experiência online, onde a civilidade dos comentários no blog foi manipulada. Por exemplo, o estudo mostrou que a introdução de xingamentos nos comentários pré-existentes em um post de um blog de um jornal – originalmente com comentários equilibrados – podia exacerbar para cima ou para baixo as percepções do risco, dependendo da predisposição individual quanto à ciência da nanotecnologia.

“Parece que nós não temos realmente uma clara norma social acerca do que se espera [em termos de civilidade] online,” declara Brossard, professor de Comunicação de Ciências da via da UW-Madison, em contraste com fóruns públicos online, onde normas prescritas para decoro ajudam a manter a civilidade das discussões. “No caso dos posts dos blogs, é um velho-oeste”.

Para a nanotecnologia, que se desenvolve rapidamente e já faz parte de mais de 1.300 produtos comerciais, a exposição a comentários grosseiros online é uma das muitas variáveis que podem influenciar a percepção de risco associada à mesma.

“Quando as pessoas se deparam com um assunto pouco familiar, tal como a nanotecnologia, elas frequentemente se baseiam em outro valor existente – tais como a religiosidade ou a deferência pela ciência – para fazerem um julgamento”, explica Ashley Anderson, uma doutora associada ao Centro de Comunicação sobre Mudanças Climáticas na Universidade George Mason e a principal autora do recém-publicado estudo no Journal of Computer Mediated Communication.

Leitores muito religiosos – revela o estudo – eram levados a ver a nanotecnologia como algo arriscado quando expostos a comentários rudes, em comparação com leitores menos religiosos, observou Brossard.

“Os Blogs já fazem parte da nova paisagem da mídia há algum tempo, mas nosso estudo é o primeiro a examinar os efeitos potenciais dos comentários dos blogs sobre a percepção do público sobre a ciência”, diz Brossard.

Enquanto que o tom dos comentários em um blog podem ter um impacto, a simples discordância em posts pode também fazer oscilar a percepção: “A discordância aberta adiciona outra camada. Ela influencia a conversação”, explica ela.

O Professor Dietram Scheufele de Comunicação de Ciências da Vida na UW-Madison, outro coautor do estudo, observa que a Web é o primeiro lugar onde as pessoas buscam informações detalhadas e discussões sobre os aspectos da ciência e da tecnologia. Por conta desta tendência, “os estudos sobre a mídia online estão se tornando cada vez mais importantes, porém compreender o ambiente da informação online é particularmente importante para as questões de ciência e tecnologia”.

Essa é quente: temperaturas (absolutas) negativas

Uma temperatura abaixo do zero absoluto

Átomos a temperaturas absolutas negativas são os sistemas mais quentes do mundo

|

||||

![]()

![]()

![]()

![]()

![]()

![]()

![]()

O que é corriqueiro para a maior parte das pessoas durante o inverno, até agora era impossível na física: uma temperatura negativa. Na escala Celsius, uma temperatura negativa só é surpreendente durante o verão. Na escala absoluta de temperaturas – também chamada de escala Kelvin – usada pelos físicos, não é possível ir abaixo do zero – pelo menos não no sentido de ficar mais frio do que zero Kelvin. Segundo o significado de temperatura para a física, a temperatura de um gás é determinada pelo movimento caótico de suas partículas – quanto mais frio um gás, mais lentas serão suas partículas. A zero kelvin (menos 273 graus Celsius) as partículas param de se mover e toda a desordem desaparece. Desta forma, nada pode ser mais frio do que o zero absoluto na escala Kelvin. Os físicos da Universidade Ludwig-Maximilians em Munique e do Instituto Max Planck de Óptica Quântica criaram agora em laboratório um gás atômico que, não obstante, apresenta valores Kelvin negativos. Estas temperaturas absolutas negativas causam várias consequências aparentemente absurdas: embora os átomos se atraiam mutuamente e criem uma pressão negativa, o gás não entra em colapso – um comportamento igualmente postulado para a energia escura na cosmologia. Máquinas supostamente impossíveis, tais como um motor de combustão com uma eficiência termodinâmica maior que 100%, também podem ser imaginadas com a ajuda de temperaturas absolutas negativas.

Para levar água à fervura, é preciso adicionar energia. À medida em que a água se aquece, as moléculas de água têm sua energia cinética aumentada ao longo do tempo e se movem cada vez mais rápido em média. Ainda assim, cada molécula individual tem uma energia cinética diferente – desde muito lentas até muito rápidas. Os estados de baixa energia são mais prováveis do que os estados de alta energia, isto é, somente algumas partículas se movem muito rápido. Na física, esta distribuição [de estados] é chamada de distribuição de Boltzmann. Os físicos que trabalham com Ulrich Schneider e Immanuel Bloch agora obtiveram um gás no qual esta distribuição é precisamente invertida: muitas partículas têm altas energias e umas poucas têm baixas energias. Esta inversão da distribuição de energia se traduz como se as partículas tivessem assumido uma temperatura negativa.

“A distribuição de Boltzmann invertida é o marco da temperatura absoluta negativa e foi isso o que conseguimos”, diz Ulrich Schneider. “Entretando o gás não é mais frio do que zero kelvin, porém mais quente”, explica o físico: “É mais quente ainda do que quaisquer temperaturas positivas – a escala de temperaturas simplesmente não termina no infinito; ao invés disso, ela salta para valores negativos”.

Uma temperatura negativa só pode ser obtida com um limite superior para a energia

O significado de uma temperatura absoluta negativa pode ser melhor ilustrado com esferas rolantes em um terreno montanhoso, onde os vales representam uma baixa energia potencial e os topos uma alta energia. Quanto mais rápido as esferas se moverem, mais alta será sua energia cinética: se começarmos com uma temperatura positiva e aumentarmos a energia total das esferas, aquecendo-as, as esferas vão se espalhar, cada vez mais, pelas regiões de alta energia. Se fosse possível aquecer as esferas a uma temperatura infinita, haveria uma probabilidade igual de as encontrarmos em qualquer ponto do terreno, sem qualquer diferença da energia potencial. Se fosse possível adicionar ainda mais energia e aquecer as esferas ainda mais, elas tenderiam a ser reunir em estados de alta energia e ficariam ainda mais quentes do que em uma temperatura infinita. A distribuição de Boltzmann seria invertida e a temperatura, portanto, seria negativa. À primeira vista pode parecer estranho que uma temperatura absoluta negativa seja mais quente do que uma positiva. No entanto, isto é apenas uma consequência da definição histórica de temperatura absoluta; se houvesse uma definição diferente, a aparente contradição não existiria.

Esta inversão da população de estados de energia não é possível com a água ou qualquer outro sistema natural, uma vez que o sistema teria que absorver uma quantidade infinita de energia – O que é impossível! No entanto, se as partículas tivessem um limite superior para sua energia, tal como o topo dos montes em nosso terreno de energias potenciais, a situação seria completamente diferente. Os pesquisadores do grupo de pesquisa de Immanuel Bloch e Ulrich Schneider obtiveram um sistema assim, de um gás atômico com um limite superior de energia em seu laboratório, seguindo as propostas teóricas de Allard Mosk e Achim Rosch.

|

|

||||

Em sua experiência, os cientistas primeiro resfriaram cerca de cem mil átomos em uma câmara de vácuo até uma temperatura positiva de poucos bilionésimos de grau Kelvin e os capturaram em armadilhas ópticas feitas com raios laser. O vácuo ultra alto em torno dos átomos garantiu que os átomos ficassem perfeitamente isolados termicamente de seu ambiente. Os feixes de laser criaram uma, assim chamada, grade óptica, na qual os átomos ficam arrumados regularmente nas casas da grade. Nessa grade, os átomos ainda podem se mexer de uma casa para outra, através do efeito de túnel, mas, mesmo assim, sua energia cinética tem um limite superior e, portanto, fica estabelecido o limite superior de energia necessário. A temperatura, entretanto, é relacionada não apenas com a energia cinética, mas à energia total das partículas, o que, neste caso, inclui as energias interativa e potencial. O sistema dos pesquisadores de Munique e Garching também estabelece um limite a ambas. Os físicos então levam os átomos até esse limite superior de energia total – criando assim uma temperatura negativa, no entorno de uns poucos bilionésimos de grau kelvin.

Em uma temperatura negativa, uma máquina pode realizar mais trabalho

Se nossas esferas tivessem uma temperatura positiva e ficassem em um vale de energia potencial mínima, tal estado seria obviamente estável – essa é a natureza que conhecemos. Se as esferas estivessem posicionadas no topo de uma montanha na energia potencial máxima, usualmente elas rolariam para baixo, convertendo sua energia potencial em cinética. “Entretanto, se as esferas estiverem em uma temperatura negativa, sua energia cinética já será tão grande que não pode mais ser aumentada”, explica Simon Braun, um estudante de doutorado do grupo de pesquisas. “Assim, as esferas não podem rolar para baixo e permanecem no topo do morro. O limite de energia as tornou estáveis, portanto!” O estado de temperatura negativa na experiência é, em verdade, tão estável quanto um estado de temperatura positiva. “Desta forma nós criamos o primeiro estado de temperatura absoluta negativa para partículas móveis”, acrescenta Braun.

A matéria em uma temperatura absoluta negativa tem todo um leque de consequências espantosas: com ajuda dela, se pode criar motores térmicos, tais como motores de combustão, com uma eficiência maior que 100%. Isso, porém, não quer dizer que a lei de conservação de energia seja violada. Em lugar disso, o motor seria capaz de absorver energia não só do meio mais quente – e assim realizar trabalho – como, em contraste com o caso usual, poderia absorver também energia do meio mais frio.

Em temperaturas apenas positivas, o meio mais frio inevitavelmente se aquece, absorvendo assim uma parte da energia do meio quente e, desta forma, limitando a eficiência. Se o meio quente tiver uma temperatura negativa, é possível absorver energia de ambos os meios simultaneamente. O trabalho realizado pelo motor, então, será maior do que a energia inserida apenas no meio quente – e a efeiciência sera maior do que 100%.

A realização dos físicos de Munique pode ser também interessante para a cosmologia, uma vez que o comportamento termodinâmico da temperatura negativa exibe semelhanças com a assim chamada energia escura. Os cosmologistas postulam que a energia escura é uma força misteriosa que acelera a expansão do universo, embora o cosmos devesse se contrair por conta da energia da atração gravitacional de todas as massas. Ocorre um fenômeno similar na nuvem atômica do laboratório de Munique: a experiência se apoia no fato de que os átomos no gás não se repelem mutuamente, tal como em um gás ususal; ao contrário, eles se atraem. Isso significa que os átomos exercem uma pressão negativa, em lugar de uma pressão positiva. Como consequência, a nuvem de átomos quer se contrair e deveria entrar em colapso – exatamente como seria de se esperar do universo sob o efeito da gravidade. Porém, por causa da sua temperatura negativa, isso não acontece. O gás é poupado do colapso, tal como o universo.

Publicação original:

Simon Braun, J. Philipp Ronzheimer, Michael Schreiber, Sean S. Hodgman, Tim Rom, Immanuel Bloch, Ulrich Schneider Negative Absolute Temperature for Motional Degrees of Freedom

Science, 4 January 2013

As 10 melhores do ano (segundo a AAAS)

American Association for the Advancement of Science

A grande descoberta científica do Ano: O Bóson de Higgs

A longamente procurada partícula completa o Modelo Padrão da Física de Partículas

A observação de uma elusiva partícula subatômica, conhecida como o Bóson de Higgs, foi eleita pela publicação Science a mais importante descoberta científica de 2012. Essa partícula, cuja existência foi proposta há mais de 40 anos, guarda a chave para explicar como as outras partículas elementares (as que não são compostas por partículas menores), tais como os elétrons e os quarks, adquirem suas massas.

Além de reconhecer a detecção dessa partícula como a Descoberta Científica do Ano em 2012, a Science e seu editor internacional (sem fins lucrativos), a AAAS, identificaram nove outras realizações científicas de alta relevância no ano passado e as compilaram na lista das “10 mais” que será publicada na edição de 21 de dezembro.

Os pesquisadores revelaram indícios do Bóson de Higgs em 4 de julho, encaixando a última peça que faltava em um quebra-cabeças que os físicos chamam de Modelo Padrão da Física de Partículas. Esta teoria explica como as partículas interagem através das forças eletromagnética, nuclear fraca e nuclear forte, a fim de formar a matéria do universo. No entanto, até este ano, os pesquisadores não podiam explicar como as partículas envolvidas nessas interações adquiriam suas massas.

“A simples atribuição de massas às partículas fazia com que a teoria se tornasse matematicamente errática”, explica o correspondente Adrian Cho da Science que escreveu sobre a descoberta para o artigo da Descoberta do Ano. “Dessa forma, as massas tinham que aparecer de alguma forma das interações das partículas originalmente sem massa. É aí que entra em cena o Higgs”.

Como explica Cho, os físicos presumem que o espaço é preenchido por um “Campo de Higgs”, similar a um campo elétrico¹. As partículas interagem com o Campo de Higgs para obter energia e — graças à famosa equivalência de massa e energia de Einstein — adquirem massa também. “Tal como um campo elétrico consiste de partículas chamadas fótons, o Campo de Higgs consiste de bósons de Higgs ocultos no vácuo”, explica ele. “Os físicos conseguiram agora estourá-los para fora do vácuo para uma breve existência”.

Porém essa vista do Bóson de Higgs não foi fácil de obter — nem custou barato. Milhares de pesquisadores trabalharam com um esmagador de átomos de 5,5 bilhões de dólares em um laboratório de física de partículas perto de Genebra, Suíça, chamado CERN, usando dois detectores de partículas gigantescos, chamados ATLAS e CMS, para detectar o bóson há muito procurado.

Ainda não está claro para onde esta descoberta conduzirá o campo da física de partículas no futuro, porém seu impacto na comunidade dos físicos neste ano é inegável, motivo pelo qual a Science declarou a detecção do bóson de Higgs a Descoberta do Ano em 2012. A edição especial do dia 21 de dezembro inclui três artigos escritos por pesquisadores do CERN, que ajudam a explicar como esse feito foi conseguido.

A lista de feitos científicos pioneiros de 2012 da Science é a seguinte:

O Genoma do Homídeo de Denisov: Uma nova técnica que une moléculas especiais a cadeias singelas de DNA, permitiu aos pesquisadores sequenciar o genoma completo do Homídeo de Denisov a partir de apenas um fragmento de osso de um antigo dedo mínimo. O sequenciamento genômico permitiu aos pesquisadores comparar os Denisovanos — uma espécie arcaica de humanos muito semelhante aos Neandertals — com os humanos modernos. Também revelou que o osso de dedo pertenceu a uma menina de olhos castanhos, cabelos castanhos e pele escura que morreu na Sibéria entre 74.000 a 82.000 anos atrás.

Fabricação de Células Ovo a partir de Células Tronco: Pesquisadores japoneses demonstraram que células tronco embrionárias de camundongos podem ser levadas a se tornarem células ovo viáveis. Eles fecharam o caso quando as células, fertilizadas com esperma no laboratório, se desenvolveram em fetos de camundongos que nasceram de mães hospedeiras. O processo requer camundongos fêmeas para desenvolver os ovos em seus corpos por algum tempo, de forma que não foi atingido o principal objetivo dos cientistas: criar células ovo inteiramente no laboratório. Poré, fornece uma poderosa ferramenta para o estudo dos genes e outros fatores que influenciam a fertilidade e o desenvolvimento das células ovo.

Sistema de Pouso da “Curiosity”: Muito embora não fossem capazes de testar todo o sistema de pouso de seu rover sob condições marcianas, os engenheiros da missão do Laboratório de Propulsão a Jato da NASA em Pasadena, California, conseguiram colocar o Curiosity de maneira segura e precisa na superfície de Marte. O veículo de entrada com 3,3 toneladas do rover era pesado demais para um pouso tradicional, de forma que a equipe se inspirou em guindastes e helicópteros para criar um “guindaste aéreo” que levou pendurado o Curiosity, com as rodas desdobradas, na ponta de três cabos. O pouso sem problemas assegurou aos planejadores que a NASA pode algum dia pousar uma segunda missão próximo de um rover antigo para coletar as amostras que o rover tenha coletado e trazê-las de volta à Terra.

Laser de Raios-X Revela a Estrutura de uma Proteína: Pesquisadores empregaram um laser da raios-X, que brilha um bilhão de vezes mais forte do que uma fonte síncrotron tradicional, para descobrir a estrutura de uma enzima necessária para o parasita Trypanosoma brucei, a causa da doença do sono africana. O avanço demonstrou o potencial de lasers de raios-X para decifrar proteínas que as fontes tradicionais de raios-X não conseguem.

Engenharia de Precisão de Genomas: A revisão e deleção do DNA de organismos mais complexos sempre foi um processo de tentativa e erro. Porém, em 2012, uma nova ferramenta conhecida como TALENs, (acrônimo para “transcription activator-like effector nucleases”), deu aos pesquisadores a capacidade de alterar ou inativar genes específicos em peixes paulistinhas, sapos, gado e outros animais — até mesmo em células em pacientes com doenças. Esta tecnologia, junto com outras que estão emergindo, está se provando ser tão eficaz quanto (e mais barata do que) técnicas correntes que visam os genes e pode permitir aos pesquisadores controlar tarefas específicas para os genes e suas mutações, tanto em indivíduos saudáveis, quanto doentes.

Férmions de Majorana : A existência dos férmions de Majorana, partículas que (entre outras propriedades) agem como a própria antimatéria e se aniquilam entre si, tem sido debatida por mais de sete décadas. Este ano, uma equipe de físicos e químicos na Holanda conseguiu obter os primeiros indícios consistentes de que essa matéria exótica realmente existe, na forma de quase-partículas: grupos de elétrons que interagem entre si e se comportam como uma só partícula. A descoberta já fez com que sejam desenvolvidos esforços para incorporar os férmions de Majorana na computação quântica, já que os cientistas acham que os “qubits” feitos dessas partículas misteriosas podem ser mais eficientes para a armazenagem e processamento de dados do que os bits atualmente usados nos computadores digitais.

O Projeto ENCODE: Um estudo que se estendeu por toda uma década, relatado este ano em mais de 30 artigos, revelou que o genoma humano é mais “funcional” do que os pesquisadores pensavam. Embora tão somente 2% do genoma sirva de código para proteínas reais, o projeto da Encyclopedia of DNA Elements (Enciclopédia de Elementos do DNA), ou ENCODE, indicou que cerca de 80% do genoma é ativo, ajudando a ligar ou desligar os genes, por exemplo. Estes novos detalhes devem auxiliar os pesquisadores a compreender as maneiras pelas quais os genes são controlados e esclarecer alguns dos riscos genéticos para doenças.

Interfaces Cérebro-Máquina: A mesma equipe que havia demonstrado antes como gravações (das atividades) neurais do cérebro poderiam ser usadas para movimentar um cursor em uma tela de computador, demonstrou em 2012 que pacientes humanos paralíticos podem movimentar um braço mecânico com suas mentes e realizar movimentos complexos em três dimensões. A tecnologia ainda é experimental — e extraordinariamente cara — porém os cientistas têm esperanças que algorítimos mais avançados possam melhorar essas próteses neurais para ajudar pacientes paralisados por derrames, lesões na espinha e outras condições mórbidas.

Ângulo de Mistura de Neutrinos: Centenas de pesquisadores que trabalham na Experiência com Neutrinos no Reator da Baía Daya, na China, relataram que o último parâmetro desconhecido de um modelo que descreve como as elusivas partículas, conhecidas como neutrinos, mudam de um “sabor” para outro, na medida em que se deslocam próximos da velocidade da luz. Os resultados mostram que neutrinos e anti-neutrinos possivelmente podem mudar de sabor de maneira diferente e sugerem que a física de neutrinos pode algum dia auxiliar os pesquisadores a explicar porque o universo tem tanta matéria e tão pouca antimatéria. Se os físicos não conseguirem identificar outras novas partículas além do bóson de Higgs, a física de neutrinos pode representar o futuro da física de partículas.

Nota do tradutor:

1 – Pelamordedeus!… Isso é um texto referendado pela AAAS! Comparar o campo escalar de Higgs com um campo vetorial eletromagnético é meio forte!