O tamanho do Universo: uma pergunta difícil

Atenção! Este post é uma tradução expressamente autorizada pelo autor. A reprodução total ou parcial do mesmo pode ser considerada violação de direitos autorais. O link para o post original de Ethan Siegel em “Starts with a Bang” vai aí abaixo.

The Size of the Universe: A Hard Question

Category: Astronomy • Galaxies • Physics • Q & A • big bang • relativity

Posted on: July 31, 2009 3:19 PM, by Ethan Siegel

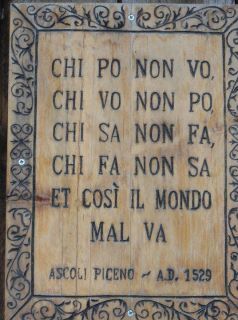

Me fazem uma mesma pergunta frequentemente e ela é uma das perguntas mais difíceis para qualquer cosmologista responder. Hoje, vou tentar encará-la. Ela é mais ou menos assim:

Se o Universo tem 13,7 bilhões de anos de idade e nada pode viajar mais rápido do que a velocidade da luz, como é que podemos ver coisas que estão a 46,5 bilhões de anos-luz de distância?

Em primeiro lugar – e eu quero deixar isto bem claro – tudo nesta pergunta é uma dúvida legítima.

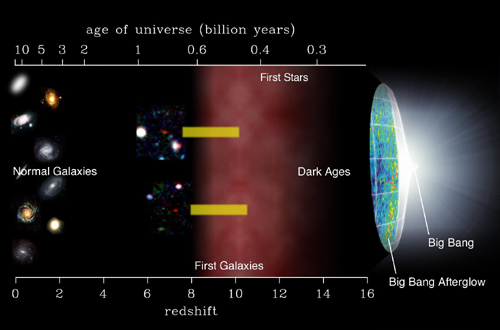

1.) O Universo tem mesmo 13,7 bilhões de anos de idade. Existe um pequeno erro de aproximação aqui – ninguém ficaria surpreso de ele tivesse 13,5 ou 14,0 bilhões de anos – mas certamente não são 12 bilhões ou menos de anos, nem 16 ou mais bilhões de anos.

2.) Nada pode se mover mais rápido do que a velocidade da luz. Se você tiver massa, seja você uma galáxia, uma nave espacial, uma bala ou um neutrino, você terá que ir mais lentamente do que a velocidade da luz. E, se você não tiver massa, vai ter que andar exatamente na velocidade da luz. Sem exceções.

3.) As coisas mais distantes no Universo – coisas que emitiram suas luzes a 13,7 bilhões de anos atrás – estão a 46,5 bilhões de anos-luz de distância de nós agora.

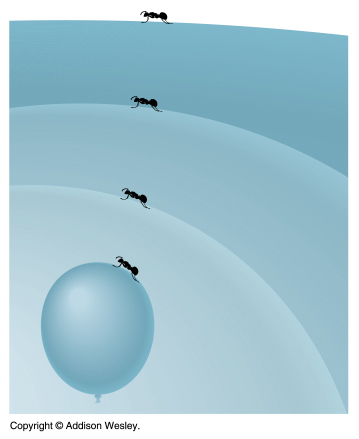

Então, como foi que isso aconteceu? De duas maneiras, uma simples e outra nem tanto. A parte simples é que o Universo vem se expandindo todo esse tempo. Imagine que você tem uma formiga sobre um balão murcho e essa formiga se move a 1 cm/seg. Quando o balão está totalmente murcho, a formiga está a apenas 2 cm do topo do balão, seu destino. Porém, na medida em que ela caminha em direção ao topo, ela percebe que o balão em volta dela está se expandindo.

Como é que acontece essa expansão? Bem, essa é parte não tão simples assim… Expansão não é uma velocidade. É uma velocidade por unidade de distância. Digamos que ela seja de 0,4 cm/seg por centímetro. Isto significa que, se a formiga estiver a 1 cm de alguma coisa, essa coisa se expande para longe dela a 0,4 cm/seg. O topo do balão, que estava inicialmente a 2 cm de distância, se expande para longe a 0,8 cm/seg. E qualquer coisa que estiver a 15 cm de distância, estaria se expandindo para longe a 6 cm/seg.

Então, se eu fizer os cálculos dessa formiga caminhando a 1 cm/seg para um ponto a 2 cm de distância neste balão em expansão, não leva 2 segundos para ela chegar lá. Na verdade – fazendo corretamente os cálculos – leva um pouquinho de nada mais do que 3 segundos para a formiga alcançar seu destino. Além disso, o balão continuou a se expandir, de forma que, quando ela olha de volta para o ponto de partida, você sabe a que distância ele está?… A mais de 6 centímetros! Quando ela olha de volta para o ponto de partida, não só ele está três vezes mais distante do que quando ela começou a viagem, como todo o balão está maior do que era antes.

E é isso que o Universo está fazendo: se expandindo enquanto a luz está viajando em nossa direção, vinda de fontes distantes. Existe, é claro, mais um “busilis” em nosso Universo. A taxa de expansão é abestalhantemente lenta: 72 km por segundo por Megaparsec. Nos termos da formiga, isso é 2,3 x 10-18 cm / segundo / cm. Acontece apenas que nosso Universo é tão grande que, se você se afastar bastante – pouco menos do que 13 bilhões de anos-luz – a taxa de expansão eventualmente fica maior do que a velocidade da luz.

Mas está tudo bem. É somente o espaço (isto é, o balão) que está se expandindo; não há matéria alguma se movendo. Portanto, em princípio, o espaço pode se expandir tão rapidamente quanto quiser, até mais rápido do que a velocidade da luz, porque não há coisa alguma se movendo. E é por isso que, muito embora o

Universo tenha apenas 13,7 bilhões de anos, nós podemos ver coisas a 46,5 bilhões de anos-luz de distância.

Alguma pergunta?

Os elétrons são indivisíveis? Talvez…

uma equipe das Universidades de Cambridge e Birmingham demonstrou que os elétrons em fios estreitos pode se dividir em duas novas partículas chamadas spinons e holons.

O “se dividir” é meio que uma licença poética… O que realmente acontece é que em um fio excepcionalmente fino (chamado de “fio quântico”) os elétrons (que têm cargas EM iguais) se repelem mutuamente e criam o que, em física de matéria condensada, se chama de elétron-buraco: uma ausência de um elétron que funciona como se houvesse um posítron no espaço correspondente.

Em 1981 o físico Duncan Haldane conjeturou teoricamente que, nessas condições de limitação de espaço e em temperaturas extremamente baixas, os elétrons iriam se comportar de maneira que seus campos elétrico e magnético assumisse a forma de duas partículas distintas que ele chamou de spinions (de “spin”) e holons (de “hole” = “buraco” em inglês).

O desafio consistia em criar um “fio quântico” que confinasse os elétrons, e trazer esse fio próximo o suficiente de um metal comum, de forma que os elétrons do metal pudessem realizar um “salto quântico” (por meio do “tunelamento quântico”) para dentro do fio. Observando como o ritmo de saltos varia em função de um campo magnético aplicado, a experiência pode revelar como o elétron, ao entrar no fio quântico, se “separa” em spinions e holons.

Isso foi feito mediante a colocação de um pente de fios acima de uma nuvem plana de elétrons em um metal. Assim, os físicos de Cambridge, Yodchay Jompol e Chris Ford, puderam ver distintamente as assinaturas das novas partículas, exatamente como os teóricos, Tim Silk e Andy Schofield, de Birmingham tinham previsto.

O Dr Chris Ford do Laboratório Cavendish da Univesidade de Cambridge descreve:

“Tivemos que desenvolver uma nova tecnologia para fazer passar uma corrente entre um fio e uma folha [metálica] separadas por apenas 30 diâmetros atômicos.”

“As medições tiveram que ser realizadas em temperaturas extremamente baixas: cerca de um décimo de grau acima do zero absoluto.

“Os fios quânticos são largamente empregados para conectar ‘pontos’ quânticos, os quais podem vir a ser no futuro a base de um novo tipo de computador – o chamado computador quântico. Assim, compreender suas propriedades pode ser importante para tais tecnologias quânticas, além de auxiliar no desenvolvimento de teorias mais completas sobre a super-condutividade e a condutividade nos sólidos em geral. Isto pode levar a uma nova revolução nos computadores”.

O Professor Andy

Schofield, da Escola de Física e Astronomia da Universidade de Birmingham, diz:

“O experimento para testar isso se baseia em uma ideia que eu e mais três colegas tivemos, fazem quase dez anos. Naquela época, a tecnologia necessária para realizar o teste ainda estava a anos de distância.”

“O notável nesta nova experiência não é somente a clareza com que se pode observar o spinion e o holon, o que confirma alguns estudos anteriores, mas que o spinion e o holon sejam visíveis bem além da região originalmente imaginada por Duncan Haldane”.

“Nossa capacidade em controlar o comportamento de um único elétron é a responsável pela revolução dos semicondutores que levou a computadores mais baratos, iPods e outros. Se vamos ser capazes de controlar essas novas partículas com o mesmo sucesso dos elétrons isolados, é algo ainda por se descobrir. O que isso revela é que espremer elétrons em um ambiente confinado faz emergir novas propriedades e até novas partículas”.

Notas:

1. O artigo original foi publicado em Science 10.1126/science.1171769 em http://dx.doi.org/10.1126/science.1171769

2.

A experiência foi realizada no Laboratório Cavendish em Cambridge com o apoio teórico da Escola de Física e Astronomia da Universidade de Birmingham.

Em nano-escala, se pode quebrar a lei

[ traduzido deste press-release do MIT ]

Quebrando a lei, na nano-escala

Colocar objetos extremamente perto um do outro pode aumentar a transferência de calor por radiação, de acordo com um novo estudo que demonstra a quebra da Lei de Planck

Por David L. Chandler,

MIT News Office

29 de julho de 2009

Uma lei firmemente estabelecida da física descreve a transferência de calor entre dois objetos, porém alguns físicos a muito tempo prediziam que essa lei deveria ser quebrada quando os objetos estivessem muito próximos. Entretanto, os cientistas jamais tinham podido confirmar – sequer medir – essa quebra na prática. Pela primeira vez, os pesquisadores do MIT conseguiram realizar esse feito e comprovaram que a transferência de calor pode ser até 1.000 vezes maior do que o previsto na lei.

As novas descobertas podem levar a novas aplicações significativas que incluem melhores projetos das cabeças de gravação dos discos rígidos usados para a armazenagem de dados em computadores e novos tipos de dispositivos para coletar a energia do calor que, de outra forma, seria desperdiçada.

A Lei da Radiação do Corpo Negro de Planck, formulada em 1900 pelo físico alemão Max Planck, descreve como a energia é dissipada na forma de diferentes comprimentos de onda de radiação, a partir de um objeto ideal não-reflexivo, chamado de corpo negro. A lei diz que a emissão proporcional de radiação em diferentes comprimentos de onda segue um padrão preciso que varia de acordo com a temperatura do objeto. A emissão de um corpo negro é usualmente considerada o máximo que um objeto pode irradiar.

|

|

|

Professor Gang Chen com a câmara de vácuo usada nesta pesquisa. (Foto: cortesia de Gang Chen) |

A lei funciona perfeitamente na maioria dos casos, porém o próprio Planck sugeriu que, quando os objetos estivessem muito próximos, as previsões feitas pela lei seriam quebradas. No entanto, controlar os objetos de forma a manter as minúsculas separações necessárias para demonstrar este fenômeno se provou uma tarefa incrivelmente.

Gang Chen, Professor “Carl Richard Soderberg” de Engenharia de Energia e diretor do Laboratório Pappalardo de Micro e Nano Engenharia do MIT, explica: “Planck foi muito cuidadoso ao dizer que sua teoria só era válida para sistemas grandes. Dessa forma ele meio que antecipou essa quebra, mas a maioria das pessoas não sabe disto”.

Parte do problema em medir a forma como a energia é irradiada quando os objetos estão muito próximos reside na dificuldade mecânica em manter os objetos em estreita proximidade sem que eles realmente se toquem. Chen e sua equipe, o estudante de pós-graduação Sheng

Shen e o Professor da Universidade de Columbia Arvind Narayaswamy, solucionaram este problema de duas maneiras, descritas em um artigo a ser publicado na edição de agosto de Nano Letters (atualmente disponível online). Em primeiro lugar, ao invés de usar duas superfícies planas e tentar manter um minúsculo intervalo entre elas, eles usaram uma superfície plana próxima de uma pequena conta de vidro redonda, cuja posição é mais fácil de controlar. “Se usarmos duas superfícies paralelas, fica muito difícil levá-las à escala nanométrica sem que algumas partes se toquem”, explica Chen, mas com o uso de uma conta só há um único ponto de quase-contato, o que é bem mais fácil de manter. Em segundo lugar, eles usaram a tecnologia do cantilever bimetálico de um microscópio de força atômica para medir as mudanças de temperatura com grande precisão.

|

|

|

Foto: cortesia de Sheng Shen. Diagrama do dispositivo, inclusive um cantilever de um microscópio de força atômica, usado para medir a transferência de calor entre objetos separados por distância na faixa de nanômetros. |

“Por muitos anos tentamos fazê-lo com placas paralelas”, descreve Chen. Mas com esse método não foram capazes de manter separações menores do que cerca de um mícron (um milionésimo de metro). Usando contas de vidro (sílica), eles conseguiram obter separações de até 10 nanômetros (10 bilionésimos de metro, ou seja, um centésimo da distância conseguida anteriormente) e agora estão tentando obter separações menores ainda.

O professor Sir John Pendry do Imperial College London, que realizou extensos trabalhos neste campo, chama os resultados de “muito entusiasmantes”, ao mesmo tempo que observa que os teóricos desde há muito previam essa quebra e a ativação de um mecanismo mais poderoso.

“A confirmação experimental se mostrou elusiva por causa da extrema dificuldade em medir diferenças de temperatura em distâncias muito pequenas”, diz Pendry. “As experiências de Gang Chen dão uma elegante solução para essa dificuldade e confirmam a contribuição preponderante dos efeitos de campo próximo na transferência de calor”.

Nos sistemas atuais de gravação magnética de dados – tais como o usado nos discos rígidos de computador – o espaçamento entre a cabeça de gravação e a superfície do disco fica tipicamente na faixa de 5 a 6 nanômetros, diz Chen says. A cabeça tende a se aquecer e os pesquiadores têm procurado por meios para gerenciar esse calor e até mesmo explorar o aquecimento para controlar o espaçamento. Segundo ele, “é uma questão muito importante para a armazenagem de dados”. Tais aplicações podem ser desenvolvidas bem rapidamente – prossegue ele – e algumas companhias já mostraram um grande interesse pelo trabalho.

As novas descobertas podem também auxiliar o desenvovimento de novos dispositivos de conversão de energia fotovoltáica para captar os fótons emitidos por uma fonte de calor, chamada de termofotovoltáica. Segundo Chen, “O alto fluxo de fótons potencialmente pode permitir a fabricação de conversores de energia termofotovoltáicos mais eficientes e com maior densidade de energia, e até dispositivos totalmente novos de conversão de energia”.

Shen diz que as novas descobertas podem ter “um largo impacto”. As pessoas que trabalham com dispositivos que usam separações muito pequenas, agora podem entender claramente que a Lei de Planck “não é uma limitação fundamental”, como muitos pensavam até agora. Mas Chen adverte que mais pesquisas são necessárias para explorar separações ainda menores porque “não sabemos exatamente qual é o limite ainda” em termos de quanto calor pode ser dissipado em sistemas estreitamente separados. “As teorias correntes não serão mais válidas quando passarmos do intervalo de 1 nanômetro”.

E ele finaliza: “além das aplicações práticas, tais experimentos podem ser uma ferramenta útil para compreender alguma física básica”.

O trabalho foi financiado pelo Departamento de Energia e pelo Escritório de Pesquisa Científica da Força Aérea dos EUA.

Mais do que a vista alcança…

[ Livremente traduzido daqui: An ‘eye catching’ vision discovery Ah!… Sim… Eu juro que a legenda das ilustrações é essa mesmo…]

Johns Hopkins Medical Institutions

|

|

||||

Quase todas as espécies têm alguma capacidade de detectar a luz. Ao menos três tipos de células na retina nos permitem ver imagens ou distinguir entre o dia e a noite. Agora, os pesquisadores da Escola de Medicina Johns Hopkins descobriram nos peixes um outro tipo de célula que pode sentir a luz e contribuir para o sentido da visão.

Conforme relatado na edição desta semana da Nature,

a equipe de neurocientistas mostra que as células horizontais da retina, que são um tipo de células nervosas que, se pensava, só se comunicavam com células nervosas adjacentes – nem sequer com o cérebro – são fotossensíveis por si próprias.

Segundo diz King-Wai Yau, Ph.D., professor de

neurociência no Departamento Solomon H. Snyder de Neurociência na

Johns Hopkins: “Isto é estarrecedor! Por mais de 100 anos se sabe que os cones e bastonetes são responsáveis por sentir a luz e, portanto, pela visão. Então, a cerca de sete anos, foi descoberto um outro tipo de sensor de luz na retina, revelando um terceiro tipo de célula fotossensível nos mamíferos, de forma que nos dispusemos a pesquisar se isso era verdade em outros vertebrados também”.

Focalizando a pesquisa no fotossensor de melanopsina, o qual é responsável por diferenciar o dia da noite, mas raramente está envolvido na visão de imagens — pelo menos, nos mamíferos — a equipe de Yau buscou células que contém melanopsina em outros vertebrados, e encontrou algumas nas células horizontais da retina de peixinhos dourados e bagres.

|

|

||||

Os bagres têm dois tipos de células horizontais: as que se conectam com cones, que respondem à luzes intensas, e as que se conectam com os bastonetes, que respondem à luz suave. A equipe realizou medições elétricas de células horizontais de retina isoladas e descobriu que a luz causava uma mudança de corrente elétrica nas células horizontais tipo-cone, mas não nas células horizontais tipo-bastonete.

As células horizontais, segundo Yau, permitem a intercomunicação entre células foto-receptoras adjacentes, permitindo que essas células comparem a luz que estão sensoreando, um processo necessário para que o cérebro veja as imagens. “O cérebro processa o que ele vê dentro do contexto do ambiente”, explica Yau. “Isso permite que nosso cérebro veja bordas e contornos — as células horizontais são a razão de podermos reconhecer uma face que vemos, por exemplo”.

Testando luzes em diferentes comprimentos de onda, a equipe descobriu que essas células horizontais dos peixes são milhares de vezes menos fotossensíveis do que os cones. Yau aduz: “Em suma, o efeito da luz sobre as células horizontais é sutil, talvez permitindo que os olhos desses animais faça o ajuste fina de suas funções para condições diferentes de iluminação ambiente. Mas o mero fato dessas células horizontais serem sensíveis à luz é uma descoberta bastante surpreendente e muda nossa compreensão das retinas como um todo”.

Aprender mais sobre como a sensibilidade à luz das células horizontais contribui para a visão de imagens, vai necessitar o estudo de retinas completas, não só de células isoladas. Yau que busca compreender a visão em si, declara: “Pode ser que ainda haja outras células fotossensíveis nos olhos sobre as quais ainda não sabemos”.

Os autores do artigo são Ning Cheng, Takashi Tsunenari e Yau, todos da Johns Hopkins.

Você já ouviu falar do Itérbio?… Pois devia.

DOE/Lawrence Berkeley National Laboratory

A quebra de simetria no Itérbio

As maiores violações da paridade jamais medidas em um átomo

|

|

||||

O Itérbio (Yb) foi descoberto em 1878, porém, até que encontrasse uso como nos atuais relógios atômicos, o metal mole jamais foi notícia. Agora o itérbio pode reclamar seu lugar na “calçada da fama” da ciência. As medições feitas no isótopo Yb-174 (70 prótons e 104 nêutrons) mostraram os maiores efeitos de quebra de paridade jamais observadas em um átomo — cem vezes mais do que o medido com precisão no elemento césio.

O princípio da “paridade” presume que, na escala atômica, a natureza se comporte da mesma forma quando se troca a esquerda pela direita: interações vistas “no espelho” devem ser indistinguíveis das “normais”. Parece uma questão de mero bom senso, mas, notavelmente, não é sempre assim…

Dmitry Budker, da Divisão de Ciência Nuclear do Laboratório Nacional Lawrence Berkeley e professor de física da Universidade da Califórnia em Berkeley, que liderou a pesquisa, explica que a violação da paridade é um efeito da Força [Nuclear] Fraca.

Das quatro forças fundamentais da natureza – [Nuclear] Forte, Eletromagnética, [Nuclear] Fraca e Gravitacional – a última a ser descoberta foi a Fraca que tem um alcance extremamente curto. Os neutrinos, que não têm carga eletromagnética, são imunes ao eletromagnetismo e só interagem através da Força Fraca. A Força Fraca tem também a espantosa capacidade de modificar o “sabor” dos quarks e, desta forma, transformar prótons em nêutrons e vice versa.

A violação da paridade – os nêutrons e a Força Fraca

Os prótons isolados duram para sempre, aparentemente, mas um nêutron isolado se desmancha em cerca de 15 minutos; ele se transforma em um próton, emitindo um elétron e um antineutrino – um processo conhecido como decaimento beta. E o decaimento beta é um efeito da Força Fraca.

|

|

||||

Os cientistas pensaram por muito tempo que a natureza era simétrica na escala atômica. As coisas deveriam parecer as mesma, não somente quando se invertesse esquerda por direita, mas também quando as cargas elétricas das partículas envolvidas em uma interação fossem invertidas, ou mesmo se todo o processo fosse invertido no tempo, do futuro para o passado. Essa inversão é chamada de “conjugação” – e a conjugação de cargas é denotada por “C”, da paridade “P” e de tempo “T”. Se pensava que a natureza fosse invariante em C, P e T.

Porém em 1957 os pesquisadores descobriram que a Força Fraca não dava a mínima para o que os cientistas achavam. Quando certos tipos de núcleos atômicos (tais como o de cobalto-60) são colocados em um campo magnético para serem polarizados (alinhar os polos N e S nas mesmas direções) e passam por um decaimento beta, mais elétrons são emitidos do polo Sul do que do polo Norte.

Essa foi a primeira demonstração da violação da paridade. Antes que essa experiência com o cobalto-60 fosse realizada, o grande físico Richard Feynman tinha dito que, se a violação de P fosse verdadeira (coisa que ele duvidava), seria possível algo que se pensava ser impossível: “distinguir a esquerda da direita”.

Agora parece que vários átomos exibem a violação da paridade, embora isso não seja fácil de detectar. A violação de P foi medida com a mais alta precisão nos átomos de césio que têm 55 prótons e 78 nêutrons no núcleo, por meio de processos ópticos que observam os efeitos resultantes da excitação dos elétrons do átomo a níveis de energia mais elevados.

Os pesquisadores de Berkeley projetaram sua própria aparelhagem para detectar a violação da paridade prevista para o itérbio (que deveria ser bem mais alta do que no césio). Na experiência, o itérbio metálico é aquecido a 500ºC, produzindo um feixe de átomos que é enviado através de uma câmara com campos elétricos e magnéticos orientados perpendicularmente entre si. Dentro da câmara, os átomos de itérbio são alvejados por um raio laser, sintonizado para excitar alguns dos elétrons até estados energéticos mais altos, através de uma transição “proibida” (altamente improvável). Depois os elétrons voltam a níveis energéticos menores através de diferentes caminhos.

As interações fracas entre o elétron e o núcleo – junto com interações fracas dentro do núcleo do átomo – contribuem para “misturar” alguns dos estados de energia dos elétrons, dando uma pequena contribuição para a transição “proibida”. No entanto, outros processos eletromagnéticos mais comuns (que envolvem imperfeições na aparelhagem) também contribuem para misturar os estados e “borrar” o sinal. O propósito dos campos elétricos e magnéticos dentro da câmara é amplificar o efeito de violação da paridade e remover ou identificar esses efeitos eletromagnéticos espúrios.

Quando analisaram seus dados, os pesquisadores encontraram um sinal claro de violações de paridade a nível atômico, 100 vezes maior do que o sinal similar obtido a partir do césio. Com refinamentos na experiência, a força e a clareza do sinal do itérbio promete avanços significativos no estudo das Forças Fracas no núcleo.

Observando o trabalho da Força Fraca

Espera-se que as experiências do grupo de

Budker possam expor como a Carga Fraca se modifica em diferentes isótopos (núcleos com o mesmo número de prótons e diferentes números de nêutrons) de itérbio e revelem como as Correntes Fracas se propagam dentro desses núcleos.

|

|

||||

Os resultados também devem ajudar a explicar como os nêutrons dentro dos núcleos de átomos pesados se distribuem, inclusive se uma “película” de nêutrons circunda os prótons no centro, como sugerem diversos modelos nucleares.

Budker afirma: “A película de nêutrons é muito difícil de detectar com sondas com carga, tais como a dispersão de elétrons, porque os prótons, com suas grandes cargas elétricas, dominam a interação”.

E acrescenta: “Em um nível pequeno, o efeito da violação de paridade medido depende de como os nêutrons ficam distribuídos dentro do núcleo – especificamente de seu raio quadrado médio. O raio quadrado médio do próton é bem conhecido, mas esse seria o primeiro indício de seu gênero da distribuição dos nêutrons”.

As medições de violação de paridade no itérbio também pode revelar “momentos anapolares” na camada externa de nêutrons no núcleo (chamados de “nêutrons de valência”). Como previsto pelo físico russo Yakov Zel’dovich, essas correntes elétricas são induzidas pela Interação Fraca e circulam dentro do núcleo tal como as correntes na bobina toroidal de um tokamak. Elas foram observadas nos prótons de valência do césio, mas ainda não nos nêutrons de valência.

As experiências podem levar a testes sensíveis do Modelo Padrão – a teoria que, embora sabidamente incompleta, ainda é a que melhor descreve as interações de todas as partículas subatômicas observadas até agora.

“Até agora, os dados mais precisos acerca do Modelo Padrão vieram de aceleradores de partículas de altas energias”, explica Budker. “Os bósons vetores da Força Fraca, W e Z, foram descobertos no CERN colidindo prótons com antiprótons, um regime de ‘alta transferência de momento’. As experiências de violação de paridade atômicas do Modelo Padrão são muito diferentes – elas ficam no regime de baixa transferência de momento e complementam as experiências de altas energias”.

Desde 1957, quando Zel’dovich primeiro sugeriu procurar uma variação a nível atômico por meio de dispositivos ópticos, os pesquisadores têm chegado cada vez mais perto de aprender como a Força Fraca atua nos átomos. A violação da paridade foi detectada em vários átomos e seus efeitos previstos, tais como momentos anapolares nos prótons de valência do césio, observados com uma clareza sempre crescente. Com suas novas técnicas experimentais e a observação de uma grande violação da paridade no itérbio, Dmitry

Budker e seus colegas chegaram a uma nova marca, mais próxima da compreensão da assimetria fundamental de nosso universo na escala atômica.

Artigo: “Observation

of a large atomic parity violation in ytterbium,” por K. Tsigutkin, D.

Dounas-Frazer, A. Family, J. E. Stalnaker, V. V. Yashchuck e D.

Budker, publicado em Physical Review Letters e disponível online em http://arxiv.org/abs/0906.3039.

Ciclos solares e o clima na Terra

![]()

Os Ciclos Solares causam eventos similares a El Niño e La Niña

|

Cientistas descobrem uma ligação entre os ciclos solares e o clima global similares a El Nino e La Nina.

|

16 de julho de 2009

Uma pesquisa realizada pelos cientistas do Centro Nacional de Pesquisas Atmosféricas (National

Center for Atmospheric Research = NCAR) em Boulder, Colorado, demonstra haver uma ligação entre os ciclos solares e o clima global, onde os máximos de atividade solar causando efeitos sobre a Terra que se assemelham aos fenômenos conhecidos como La Niña e El Niño sobre o Oceano Pacífico tropical. Essa pesquisa pode auxiliar na previsão de temperaturas e padrões de precipitações em determinadas fases desses ciclos que duram aproximadamente 11 anos.

Jay Fein, diretor de programa da Divisão de Ciências Atmosféricas da Fundação Nacional de Ciências (NSF), declarou: “Esses resultados são surpreendentes, já que apontam para uma série de eventos cientificamente verificáveis que relacionam o ciclo solar de 11 anos com o fenômeno El Niño que influencia tão fortemente as variações climáticas por todo o globo. O próximo passo será confirmar ou refutar esses intrigantes resultados do modelo por meio da análise de novos dados de observações específicas”.

Embora a variação da energia total vinda do Sol para a Terra seja de apenas 0,1% ao longo de cada ciclo solar, havia tempo os cientistas pensavam que deveria haver uma ligação entre esses máximos e mínimos e as variações climáticas, de forma a poder distinguir entre esses efeitos sutis e o padrão mais amplo das mudanças climáticas provocadas pelas atividades humanas.

A pesquisa, publicada neste mês em uma artigo no Journal of Climate, foi baseada em trabalhos anteriores, empregando modelos computacionais do clima global e mais de um século de dados sobre as temperaturas do oceano, e foi conduzida pelo NCAR, com o patrocínio da NSF e do Departamento de Energia do governo dos EUA.

Diz o cientista, Gerald Meehl do NCAR, autor principal do artigo: “Nós traçamos o arcabouço dos efeitos desse novo mecanismo para entender o que acontece no Pacífico tropical quando há um máximo de atividade solar. Os picos de emissão do Sol têm um efeito abrangente e sutil sobre a precipitação na região tropical e nos sistemas climáticos por todo o mundo”.

O novo artigo mostra como, quando o Sol atinge um máximo de atividade, aquece as regiões livres de nuvens no Oceano Pacífico o suficiente para aumentar a evaporação, intensificando as chuvas tropicais e os ventos alisios,e resfriando o Pacífico Leste nos trópicos. O resultado dessa cadeia de eventos é similar a La Niña, embora o aquecimento médio de menos de dois graus seja focalizado mais a Leste e tenha apenas a metade da força de uma La Niña típica.

Nos um ou dois próximos anos, o padrão semelhante a La

Niña, causado pelo máximo da atividade solar, tende a evoluir para um padrão semelhante a El Niño, na medida em que as lentas correntes substituem as águas frias na superfície do Pacífico Leste Tropical com águas mais quente que o usual. Igualmente, esse efeito tem apenas metade da força do El Niño.

O artigo não analisa os impactos climáticos dos eventos causados pelos ciclos solares, porém Meehl e a co-autora Julie Arblaster, que é tanto do NCAR como do Serviço de Meteorologia da Austrália, descobriram que essa “La Niña” solar tende a causar condições relativamente quentes e secas em partes do Oeste da América do Norte. Serão necessárias mais pesquisas para estabelecer os impactos desses eventos em escala global. Segundo Meehl: “Aumentar nossa compreensão acerca dos ciclos solares pode nos levar a conseguir conectar suas influências com as probabilidades meteorológicas, de forma a alimentar previsões de longo prazo com uma abrangência de uma década”.

Há anos os cientistas sabem que as variações solares de longo prazo afetam certos padrões climáticos, inclusive secas e temperaturas regionais. Porém estabelecer uma ligação física entre o ciclo solar de uma década e os padrões climáticos, se mostrou uma tarefa difícil. Uma das razões para isso é que só nos últimos anos os modelos computadorizados se tornaram capazes de simular de maneira realística os processos associados com o aquecimento e resfriamento das águas do Pacífico Tropical associados com El Niño e La Niña. De posse deste novo modelo, os cientistas podem reproduzir o comportamento do Sol no último século e verificar como ele afeta o Pacífico.

Para estressar essas conexões, por vezes sutis, entre o Sol e a Terra,

Meehl e seus colegas analisaram as temperaturas da superfície do mar de 1890 a

2006. Então, usaram dois modelos de computador do NCAR para simular a resposta dos oceanos a essas mudanças na emissão do Sol. Eles descobriram que, quando as emissões do Sol atingem um pico, a pequena quantidade extra de energia solar, ao longo de vários anos, causa um pequeno aumento no aquecimento local da atmosfera, especialmente nas regiões do Pacífico tropical e sub-tropical, onde normalmente a cobertura de nuvens é escassa. O pequeno aumento do calor leva à produção de mais vapor d’água, que é levado pelos ventos alísios para as áreas normalmente chuvosas do Pacífico Tropical Oeste, alimentando chuvas mais pesadas.

Enquanto esse ciclo se intensifica, os ventos alísios se fortalecem, deixando o Pacífico Leste ainda mais frio e seco do que o

usual, produzindo condições semelhantes a La Niña.

Embora esse padrão no Pacífico seja produzido pelo máximo solar, os autores descobriram que sua mudança para um estado semelhante a El Niño é possivelmente ativado pelo mesmo tipo de processo que normalmente leva de La Niña a El Niño. A transição começa quando a força dos ventos alísios produz pulsos lentos, conhecidos como ondas de Rossby, na superfície do oceano, as quais levam cerca de um ano para cobrir a distância de volta ao Oeste através do Pacífico. A energia então é refletida na borda Oeste do Pacífico Tropical e ricocheteia para o Leste, ao longo do Equador, engrossando a camada superior da água e aquecendo a superfície do Oceano. Como resultado, ocorre um evento semelhante a El Niño, cerca de dois anos após o máximo solar. O evento cessa em cerca de um ano e o sistema volta a um estado neutro.

“El Niño e La Niña parecem ter seus próprios mecanismos distintos”, diz Meehl, “porém o máximo solar pode aparecer e viciar os dados na direção de uma La Niña fraca. Se o sistema já estivesse na direção de La Niña,” ele acrescenta, “presumivelmente será uma mais intensa”.

O Brasil e o combate à AIDS

De vez em quando é bom ver uma notícia que fala bem de alguma política do governo do Brasil, notadamente quando é veiculada pelo EurekAlert. Esse é o caso desta notícia, divulgada pela Universidade Brown: “Brazil Proves Developing Countries Can Use Generic Medicines To Fight HIV/AIDS Epidemic”. É isso mesmo: “O Brasil prova que países em desenvolvimento podem usar medicamentos genéricos para combater a epidemia de HIV/AIDS”.

|

|

|

O Brasil pressionou as companhias farmacêuticas a baixarem seus preços e começou a produzir medicamentos contra a AIDS em fábricas públicas, como nesta linha de produção na Farmanguinhos. |

O estudo, que teve como autora principal a Dra. Amy Nunn, professora assistente de pesquisa em medicina da Es- cola de Medicina Warren Alpert da Universidade Brown, será publicada na edição de julho/agosto de Health Affairs e tem como co-autores Francisco Bastos, da Fundação Oswaldo Cruz, Elize da Fonseca, da Universidade de Edinburgo na Escócia, e, como autora sênior, Sofia Gruskin, professora associada de saúde e direitos humanos na Escola de Saúde Pública da Universidade Harvard em Boston (onde começou a pesquisa).

O estudo enfatiza que o sucesso no combate a AIDS começa pela batalha do governo brasileiro pela produção de medicamentos genéricos, contrariando os interesses da grande indústria farmacêutica internacional, e pelas campanhas de informação do público, especialmente os dos chamados “grupos de risco”.

Segundo a notícia, “O exemplo [do governo brasileiro] motivou vastas mudanças nas políticas de saúde pública globais e de ajuda externa relacionada com a saúde global, tendo as ações do Brasil dado o exemplo de como tornar as políticas [de combate à epidemia] de HIV/AIDS mais eficazes”.

A professora Gruskin disse que “o Brasil também foi ponta de lança para importantes mudanças referentes à saúde global, políticas de comércio e proteção internacional dos direitos humanos referentes a medicamentos, e que o país forçou a haver uma maior transparência nos preços globais dos medicamentos”.

Como exemplo dessas mudanças: desde 2003, os Estados Unidos e outros países desenvolvidos que tinham se oposto às políticas do Brasil, investiram bilhões de dólares anualmente no fornecimento de medicamentos genéricos contra a AIDS para a população dos países em desenvolvimento.

Melhoramentos para as células solares

09 de julho de 2009

A partir de substratos de folhas de alumínio de baixo custo, os pesquisadores do Laboratório Berkeley montaram densos arranjos de semi-condutores do tipo negativo em cristal singelo, em um dispositivo em forma de pilares nanométricos. Quando os nano-pilares são combinados com um semi-condutor transparente, do tipo positivo, que serve como janela, isso resulta em uma célula fotovoltáica eficiente, barata e flexível.

|

|

|

Um substrato de alumínio forma a base para uma floresta de nano-pilares de sulfeto de cádmio e serve também como eletrodo inferior. Quando inserido em telureto de cádmio transparente dotado de um eletrodo superior de cobre e ouro, forma uma célula solar eficiente e barata. |

BERKELEY, Califórnia — Pesquisadores do Laboratório Nacional Lawrence Berkeley do Departamento de Energia e da Universidade da Califórnia em Berkeley apresentar uma nova maneira de fabricar células solares eficiente a partir de materiais baratos e flexíveis. Este novo projeto cria semi-condutores opticamente ativos em um arranjo de pilares de dimensões nanométricas (1 nanômetro = 1 bilionésimo de metro), cada um deles um único cristal.

Ali Javey, cientista da Divisão de Ciência dos Materiais do Laboratório Berkeley e professor de engenharia elétrica da UC Berkeley, diz: “Para podermos aproveitar a abundante energia solar, temos que achar maneiras para produzir em massa elementos fotovoltáicos eficientes. Os semi-condutores de cristal singelo são muito promissores, mas as maneiras padrão para produzí-los não são economicamente viáveis”.

O trabalho básico de uma célula solar é converter a energia da luz em elétrons e “buracos” (a ausência de um elétron) portadores de carga que fluem através de eletrodos para produzir uma corrente. Diferentemente de uma célula solar plana típica, um arranjo em nano-pilares oferece uma superfície muito maior para coletar a luz. Simulações em computador indicam que, comparados a superfícies planas, os arranjos de semi-condutores em nano-pilares devem ser mais sensíveis à luz, ter uma maior capacidade de separar os elétrons dos buracos e serem um coletor mais eficiente desses portadores de carga.

“Infelizmente, as tentativas anteriores de fabricar células fotovoltáicas com base em semi-condutores em forma de pilar, criados de baixo para cima, levaram a resultados desapontadores. A eficiência na transformação de luz para eletricidade foi de menos do que um a dois porcento”, explica Javey. “O processo de crescimento epitaxial de substratos mono-cristalinos era usado com frequência, mas isso é caro. As dimensões dos nano-pilares não podiam ser controladas, a densidade e o alinhamento dos pilares eram fracos e a qualidade da interface entre os semi-condutores era ruim”.

Javey usou uma nova maneira, controlada, de empregar o processo “vapor-líquido-sólido” para fabricar módulos em larga escala de arranjos densos e altamente ordenados de nano-pilares mono-cristalinos. Sua equipe criou, dentro de uma fornalha de quartzo, pilares de sulfeto de cádmio, rico em elétrons, sobre uma folha de alumínio na qual poros geometricamente distribuídos, feitos através de anodização, serviam como gabarito.

Dentro dessa mesma fornalha, eles embeberam os pilares formados em uma fina camada de telureto de cádmio, rico em buracos, que funciona como uma janela para coletar a luz. Os dois materiais em contato formam uma célula solar na qual os elétrons fluem através dos nano-pilares para o contato de alumínio por baixo e os buracos são conduzidos para finos eletrodos de cobre-ouro colocados na superfície da janela por cima.

A primeira célula-piloto testada apresentou um rendimento medido de apenas 6%, inferior aos 10 a 18% das células solares comerciais – mas muito melhor do que as outras células nanométricas feitas até hoje, justamente por seu arranjo em forma de nano-pilares. O fato do contato superior ser feito de cobre-ouro – materiais não transparentes – por si só já tirou uns 50% da eficiência. Outro problema é obter uma maior densidade dos pilares e diminuir a área destes que fica em contato com a janela. Esses problemas parecem ter soluções simples que serão testadas em breve.

|

|

|

Uma célula solar flexível é obtida pela remoção do substrato de alumínio e sua substituição por um eletrodo inferior de irídio. O dispositivo é, então, envolto em plástico flexível transparente. |

Com um olho nas aplicações práticas, além do desempenho teórico, os pesquisadores fabricaram uma célula solar flexível com o mesmo projeto, removendo quimicamente o substrato de alumínio e o substituindo por uma fina camada de irídio para criar o eletrodo inferior. Toda a célula solar resultante é recoberta com plástico transparente (polidimetilsiloxano) para criar um dispositivo dobrável, que pode ser flexionado com um efeito apenas marginal sobre o desempenho – e sem qualquer perda de desempenho após sucessivas dobragens.

Javey finaliza: “Existem várias maneiras de melhorar o desempenho dos dispositivos fotovoltáicos tridimensionais em nano-pilares, assim como maneiras de simplificar os processos de fabricação, mas o método já é altamente promissor como forma de diminuir os custos de células solares eficientes. Obtivemos a capacidade de criar estruturas mono-cristalinas diretamente sobre grandes folhas de alumínio. E a configuração tridimensional significa que os requisitos de qualidade e pureza dos materiais empregados podem ser relaxados, portanto menos custosos. Os arranjos em nano-pilares são um novo caminho para módulos solares mais versáteis”.

O artigo “Three-dimensional nanopillar-array photovoltaics on low-cost and

flexible substrates”, por Zhiyong Fan, Haleh Razavi, Jae-won Do, Aimee

Moriwaki, Onur Ergen, Yu-Lun Chueh, Paul W. Leu, Johhny C. Ho,

Toshitake Takahashi, Lothar A. Reichertz, Steven Neale, Kyoungsik Yu,

Ming Wu, Joel W. Ager e Ali Javey, será publicado na edição de agosto de Nature Materials e está disponível online em http://www.nature.com/nmat/journal/vaop/ncurrent/abs/nmat2493.html.

Buraco negro “tamanho médio”

1 de julho de 2009

Os astrônomos que estudavam os dados colhidos pelo Observatório Espacial XMM-Newton de Raios-X, vindos de uma galáxia distante, toparam com algo há muito tempo procurado: um buraco negro com uma massa superior a 500 massas solares, um “elo perdido” entre os buracos negros de massa estelar – menos maciços – e o buracos negros super-maciços que costumam ficar nos centros das galáxias. Em outras palavras, um buraco negro de “tamanho médio”.

A descoberta que será publicada amanhã na Nature, foi feita por uma equipe internacional de pesquisadores que trabalham os dados do XMM-Newton, liderada por Sean Farrell do Centre d’Etude Spatiale des Rayonnements, agora na Universidade de Leicester.

Os astrônomos já conheciam os buracos negros de massa estelar (de cerca de três a cerca de vinte vezes a massa do Sol) e os super-maciços (de vários milhões a vários bilhões de vezes a massa do Sol). O enorme intervalo entre os dois extremos sugeria aos astrônomos a existência de um terceiro tipo de buracos negros, com massas de cem a várias centenas de vezes a do Sol. Porém, até agora, os cientistas não tinham conseguido descobrir um buraco negro que se enquadrasse nessas especificações.

A equipe de Farrell estava analisando dados em arquivo obtidos pelo XMMNewton, à procura de estrelas de nêutrons e anãs brancas, quando esbarrou em um objeto estranhamente peculiar, observado em 23 de novembro de 2004.

Esse objeto, chamado HLX-1 (Hyper-Luminous X-ray source 1 = Fonte de Raios-X Hiper-Luminosa), fica na periferia da galáxia ESO 243-49, a aproximadamente 290 milhões de anos-luz da Terra. Caso realmente localizado nessa galáxia distante, o HLX-1 seria altamente luminoso na faixa dos raios-X, com uma luminosidade de pico de 260 milhões de vezes a luminosidade do Sol.

Ao analisar a luz vinda do HLX-1, a equipe descobriu que a assinatura em raios-X era inconsistente com qualquer outro objeto que não fosse um buraco negro que está se alimentando da matéria próxima. A luminosidade medida era fraca demais para que o objeto estivesse dentro de nossa própria galáxia, e a ausência de emissões em luz visível e de rádio-frequência da posição do HLX-1, somada à assinatura em raios-X observada, indica que é pouco provável que seja uma galáxia ao fundo.

|

||

Isso tudo quer dizar que a fonte de emissão dos raios-X deve estar dentro da ESO 243-49. Sua localização é muito distante do centro galático para que seja um buraco negro super-maciço e ele é muito brilhante para ser um buraco negro de massa estelar que esteja se alimentando no ritmo mais frenético.

Para se assegurar de que essa coisa era mesmo um único objeto astronômico e não um aglomerado de fontes mais tênues que brilhavam intensamente em conjunto, a equipe usou novamente o XMM-Newton para observá-lo em 28 de novembro de 2008.

Comparando os dados das duas observações, descobriu-se que a assinatura em raios-X variava significativamente no tempo, o que levou à conclusão de que se tratava de um único objeto. E a única explicação possível para sua intensa luminosidade é que se tratava mesmo de um buraco negro maior do que 500 massas solares – nenhuma outra explicação física cabia nos dados das obsevações.

Todos os outros candidatos a buracos negros de massa intermediária descobertos até agora, poderiam ser explicados por outras teorias, porém este resistiu à peneira por sem mais brilhante do que todos os candidatos anteriores em mais de 10 vezes. A equipe tinha encontrado a melhor detecção de buracos negros de massa intermediária até hoje.

Embora seja já sabido que buracos negros de massas estelares sejam os remanescentes de estrelas enormes, não se sabe ao certo como se formam os buracos negros super-maciços. Uma das possibilidades é que eles sejam gerados pela fusão de buracos negros de massa intermediária, mas, para se provar essa teoria, era necessário provar, antes de mais nada, a existência de buracos negros de massa intermediária. Daí a importância da descoberta.

A equipe planeja agora fazer novas observações do HLX-1 nas faixas de raios-X, ultravioleta, luz visível, infravermelho e rádio-frequência no futuro próximo, a fim de compreender melhor esse objeto sem par e o ambiente que o circunda.