Esta semana no EurekAlert

Descoberto o primeiro planeta orbitando uma “gêmea” do Sol em um aglomerado estelar

|

||||

O Observatório Europeu do Sul (ESO), no Chile, anunciou a descoberta de três planetas no aglomerado estelar Messier 67, um dos quais orbita uma estrela “gêmea” de nosso Sol.

Embora já se saiba que exoplanetas são comuns, pouquíssimos deles foram encontrados em aglomerados estelares, o que é até um pouco estranho, se considerarmos que a maioria das estrelas nasce dentro desses aglomerados..

Anna Brucalassi (do Instituto Max Planck de Física Extraterrestre, na Alemanha), principal autora do estudo diz: “No aglomerado Messier 67, as estrelas são todas da mesma idade e composição de nosso Sol. Isso faz desse aglomerado um laboratório perfeito para estudar quantos planetas podem se formar em um ambiente tão populoso e se eles tendem a se formar em torno de estrelas mais ou menos massivas”.

A equipe empregou o instrumento HARPS (High Accuracy Radial velocity Planet Searcher = Buscador de Planetas [por meio da medição da] Velocidade Angular de Alta Precisão), montado no telescópio de 3,6m no Observatório La Silla, cujos resultados foram cotejados com vários outros dados de observatórios pelo mundo inteiro.

O aglomerado fica a cerca de 2500 anos-luz de distância, na direção da constelação de Câncer, e contem cerca de 500 estrelas. Muitas das estrelas do aglomerado são mais tênues do que aquelas onde usualmente se procura por exoplanetas, o que levou as capacidades do HARPS ao limite. Os três planetas descobertos – dois deles orbitando estrelas similares ao Sol e um que orbita uma mais massiva que já evoluiu para o estágio de gigante vermelha – os dois primeiros tem uma massa de cerca de um terço da massa de Júpiter e orbitam sua estrela-mãe em períodos de sete e cinco dias, respectivamente. O terceiro leva 122 dias para orbitar a estrela-mãe e é mais massivo do que Júpiter.

Links

Artigo que relata a pesquisa: “Three planetary companions around M67 stars”, por A. Brucalassi et al., a ser publicado em Astronomy & Astrophysics

(pré-publicação online: – http://www.eso.org/public/archives/releases/sciencepapers/eso1402/eso1402a.pdf

Fotos do telescópio de 3,6m do ESO – http://www.eso.org/public/images/archive/search/?adv=&subject_name=3.6

California Institute of Technology

Himiko e a aurora do cosmo

|

||||

Um dos mais fascinantes objetos descobertos pelo Telescópio Subaru – o telescópio de 8,2m operado pelo Observatório Astronômico Nacional do Japão, localizado no monte Mauna Kea no Hawaii – é uma “bolha espacial”, batizada de Himiko (uma lendária rainha do Japão antigo). Himiko apresenta três “bolhas” visíveis e foi identificada como uma enorme galáxia com um halo gasoso que cobre mais de 55.000 anos-luz. Himiko não só é enorme, como é muito distante e a imagem que vemos é de uma época cerca de 800 milhões de anos após o Big Bang, quando o universo tinha apenas 6% de seu tamanho atual e as estrelas e galáxias estavam apenas começando a se formar.

Em busca da resposta para como uma galáxia tão primeva poderia ter energia suficiente para aquecer uma nuvem de gás tão grande, uma equipe de astrofísicos da CalTech, da Universidade de Tóquio e do Centro Harvard-Smithsonian de Astrofísica combinou os resiltados de observações do Telescópio Espacial Hubble e do novo rádio-telescópio ALMA (Atacama Large Millimeter/submillimeter Array). E, junto com a resposta à pergunta inicial, obtiveram mais uma surpresa.

As imagens do Hubble – que detecta luz visível e utra-violeta – mostravam três aglomerados estelares que cobriam um espaço de 20.000 anos-luz cada; portanto, três galáxias típicas da época de Himiko, em processo de fusão, todas elas com intensa formação de estrelas que, somadas, equivalem a uma centena de massas solares por ano – o que é mais do que suficiente para explicar Himiko e seu halo gasoso. A tripla fusão de galáxias é, por si só, um evento raro.

A surpresa apareceu com os dados do ALMA. Embora Himiko estivesse brilhando nas faixas da luz visível e no ultra-violeta, nas faixas que o ALMA observa – submilimétrica e rádio-frequência – ela era quase apagada. Normalmente, regiões de intensa formação de estrelas criam nuvens compostas de carbono, oxigênio e silício (no jargão dos astrônomos, tudo mais massivo que hidrogênio e hélio é um “metal”) e essas nuvens quando aquecidas, reemitem a radiação ultra-violeta na faixa de rádio-frequência. Isso sugeria uma baixa “metalicidade” de Himiko.

A conclusão dos pesquisadores é que Himiko é tão antiga que é composta quase que exclusivamente por hidrogênio e hélio, elementos formados no próprio Big Bang. E antes de chegarem a esta conclusão, os cientistas tiveram que cuidadosamente descartar outras possibilidades, tais como a aparência de Himiko ser causada por um efeito tal como o de lente gravitacional ou por um gigantesco buraco negro no seu centro.

O artigo com os resultados é intitulado “An Intensely Star-Forming Galaxy at Z ~ 7 with Low Dust and Metal Content Revealed by Deep ALMA and HST Observations”, publicado na edição de 1/12/2013 do Astrophysical Journal.

A vitória dos Trolls

University of Wisconsin-Madison

A vitória dos trolls: comentários rudes nos blogs ofuscam o brilho da ciência online

BOSTON – Os trolls estão ganhando.

Escolha um post acerca de qualquer aspecto da ciência – qualquer um – role até os comentários do blog e deixe o pau cantar:

- “Eu fico imaginando quanto dinheiro de impostos foi gasto com este estudo ‘profundo’?”

- “Eu acho que se pode pegar todos esses estudos feitos por cientistas da cabeça grande, 99% deles socialistas e comunistas, e enfiar eles onde o sol não brilha.”

- “Bah!… Lá vêm os histéricos do mito das mudanças climáticas de novo…”

- “Este artigo é 100% propaganda babaca.”

- “Falando de palermas, se você existisse nos anos 70, quando também havia cientistas, a grande novidade era a chegada de uma nova era glacial. E não me venha com essas m€Ʀ** de emissões de carbono.”

Essas grosserias, gostem ou não, são agora o prato principal de nossa dieta de notícias e, no reino das notícias de ciência online, as diatribes, esculachos e insultos estão cobrando seu pedágio sobre a percepção pública da ciência e da tecnologia, de acordo com um estudo realizado por pesquisadores da Universidade de Wisconsin-Madison.

Dirigindo-se aos cientistas presentes aqui hoje (14 Fev 2013) na reunião anual da Associação Americana para o Progresso da Ciência (American Association for the Advancement of Science – AAAS), a pesquisadora de comunicação científica da UW-Madison, Dominique Brossard, relatou os resultados de um estudo que mostram que o tom dos comentários pode, por si só, influenciar a percepção dos riscos advindos da nanotecnologia, a ciência da manipulação de materiais nas menores escalas.

O estudo, agora publicado no Journal of Computer Mediated Communication, foi financiado pela Fundação Nacional de Ciências (National Science Foundation – NSF). A amostragem foi tomada em um segmento representativo de 2.338 americanos em uma experiência online, onde a civilidade dos comentários no blog foi manipulada. Por exemplo, o estudo mostrou que a introdução de xingamentos nos comentários pré-existentes em um post de um blog de um jornal – originalmente com comentários equilibrados – podia exacerbar para cima ou para baixo as percepções do risco, dependendo da predisposição individual quanto à ciência da nanotecnologia.

“Parece que nós não temos realmente uma clara norma social acerca do que se espera [em termos de civilidade] online,” declara Brossard, professor de Comunicação de Ciências da via da UW-Madison, em contraste com fóruns públicos online, onde normas prescritas para decoro ajudam a manter a civilidade das discussões. “No caso dos posts dos blogs, é um velho-oeste”.

Para a nanotecnologia, que se desenvolve rapidamente e já faz parte de mais de 1.300 produtos comerciais, a exposição a comentários grosseiros online é uma das muitas variáveis que podem influenciar a percepção de risco associada à mesma.

“Quando as pessoas se deparam com um assunto pouco familiar, tal como a nanotecnologia, elas frequentemente se baseiam em outro valor existente – tais como a religiosidade ou a deferência pela ciência – para fazerem um julgamento”, explica Ashley Anderson, uma doutora associada ao Centro de Comunicação sobre Mudanças Climáticas na Universidade George Mason e a principal autora do recém-publicado estudo no Journal of Computer Mediated Communication.

Leitores muito religiosos – revela o estudo – eram levados a ver a nanotecnologia como algo arriscado quando expostos a comentários rudes, em comparação com leitores menos religiosos, observou Brossard.

“Os Blogs já fazem parte da nova paisagem da mídia há algum tempo, mas nosso estudo é o primeiro a examinar os efeitos potenciais dos comentários dos blogs sobre a percepção do público sobre a ciência”, diz Brossard.

Enquanto que o tom dos comentários em um blog podem ter um impacto, a simples discordância em posts pode também fazer oscilar a percepção: “A discordância aberta adiciona outra camada. Ela influencia a conversação”, explica ela.

O Professor Dietram Scheufele de Comunicação de Ciências da Vida na UW-Madison, outro coautor do estudo, observa que a Web é o primeiro lugar onde as pessoas buscam informações detalhadas e discussões sobre os aspectos da ciência e da tecnologia. Por conta desta tendência, “os estudos sobre a mídia online estão se tornando cada vez mais importantes, porém compreender o ambiente da informação online é particularmente importante para as questões de ciência e tecnologia”.

As 10 melhores do ano (segundo a AAAS)

American Association for the Advancement of Science

A grande descoberta científica do Ano: O Bóson de Higgs

A longamente procurada partícula completa o Modelo Padrão da Física de Partículas

A observação de uma elusiva partícula subatômica, conhecida como o Bóson de Higgs, foi eleita pela publicação Science a mais importante descoberta científica de 2012. Essa partícula, cuja existência foi proposta há mais de 40 anos, guarda a chave para explicar como as outras partículas elementares (as que não são compostas por partículas menores), tais como os elétrons e os quarks, adquirem suas massas.

Além de reconhecer a detecção dessa partícula como a Descoberta Científica do Ano em 2012, a Science e seu editor internacional (sem fins lucrativos), a AAAS, identificaram nove outras realizações científicas de alta relevância no ano passado e as compilaram na lista das “10 mais” que será publicada na edição de 21 de dezembro.

Os pesquisadores revelaram indícios do Bóson de Higgs em 4 de julho, encaixando a última peça que faltava em um quebra-cabeças que os físicos chamam de Modelo Padrão da Física de Partículas. Esta teoria explica como as partículas interagem através das forças eletromagnética, nuclear fraca e nuclear forte, a fim de formar a matéria do universo. No entanto, até este ano, os pesquisadores não podiam explicar como as partículas envolvidas nessas interações adquiriam suas massas.

“A simples atribuição de massas às partículas fazia com que a teoria se tornasse matematicamente errática”, explica o correspondente Adrian Cho da Science que escreveu sobre a descoberta para o artigo da Descoberta do Ano. “Dessa forma, as massas tinham que aparecer de alguma forma das interações das partículas originalmente sem massa. É aí que entra em cena o Higgs”.

Como explica Cho, os físicos presumem que o espaço é preenchido por um “Campo de Higgs”, similar a um campo elétrico¹. As partículas interagem com o Campo de Higgs para obter energia e — graças à famosa equivalência de massa e energia de Einstein — adquirem massa também. “Tal como um campo elétrico consiste de partículas chamadas fótons, o Campo de Higgs consiste de bósons de Higgs ocultos no vácuo”, explica ele. “Os físicos conseguiram agora estourá-los para fora do vácuo para uma breve existência”.

Porém essa vista do Bóson de Higgs não foi fácil de obter — nem custou barato. Milhares de pesquisadores trabalharam com um esmagador de átomos de 5,5 bilhões de dólares em um laboratório de física de partículas perto de Genebra, Suíça, chamado CERN, usando dois detectores de partículas gigantescos, chamados ATLAS e CMS, para detectar o bóson há muito procurado.

Ainda não está claro para onde esta descoberta conduzirá o campo da física de partículas no futuro, porém seu impacto na comunidade dos físicos neste ano é inegável, motivo pelo qual a Science declarou a detecção do bóson de Higgs a Descoberta do Ano em 2012. A edição especial do dia 21 de dezembro inclui três artigos escritos por pesquisadores do CERN, que ajudam a explicar como esse feito foi conseguido.

A lista de feitos científicos pioneiros de 2012 da Science é a seguinte:

O Genoma do Homídeo de Denisov: Uma nova técnica que une moléculas especiais a cadeias singelas de DNA, permitiu aos pesquisadores sequenciar o genoma completo do Homídeo de Denisov a partir de apenas um fragmento de osso de um antigo dedo mínimo. O sequenciamento genômico permitiu aos pesquisadores comparar os Denisovanos — uma espécie arcaica de humanos muito semelhante aos Neandertals — com os humanos modernos. Também revelou que o osso de dedo pertenceu a uma menina de olhos castanhos, cabelos castanhos e pele escura que morreu na Sibéria entre 74.000 a 82.000 anos atrás.

Fabricação de Células Ovo a partir de Células Tronco: Pesquisadores japoneses demonstraram que células tronco embrionárias de camundongos podem ser levadas a se tornarem células ovo viáveis. Eles fecharam o caso quando as células, fertilizadas com esperma no laboratório, se desenvolveram em fetos de camundongos que nasceram de mães hospedeiras. O processo requer camundongos fêmeas para desenvolver os ovos em seus corpos por algum tempo, de forma que não foi atingido o principal objetivo dos cientistas: criar células ovo inteiramente no laboratório. Poré, fornece uma poderosa ferramenta para o estudo dos genes e outros fatores que influenciam a fertilidade e o desenvolvimento das células ovo.

Sistema de Pouso da “Curiosity”: Muito embora não fossem capazes de testar todo o sistema de pouso de seu rover sob condições marcianas, os engenheiros da missão do Laboratório de Propulsão a Jato da NASA em Pasadena, California, conseguiram colocar o Curiosity de maneira segura e precisa na superfície de Marte. O veículo de entrada com 3,3 toneladas do rover era pesado demais para um pouso tradicional, de forma que a equipe se inspirou em guindastes e helicópteros para criar um “guindaste aéreo” que levou pendurado o Curiosity, com as rodas desdobradas, na ponta de três cabos. O pouso sem problemas assegurou aos planejadores que a NASA pode algum dia pousar uma segunda missão próximo de um rover antigo para coletar as amostras que o rover tenha coletado e trazê-las de volta à Terra.

Laser de Raios-X Revela a Estrutura de uma Proteína: Pesquisadores empregaram um laser da raios-X, que brilha um bilhão de vezes mais forte do que uma fonte síncrotron tradicional, para descobrir a estrutura de uma enzima necessária para o parasita Trypanosoma brucei, a causa da doença do sono africana. O avanço demonstrou o potencial de lasers de raios-X para decifrar proteínas que as fontes tradicionais de raios-X não conseguem.

Engenharia de Precisão de Genomas: A revisão e deleção do DNA de organismos mais complexos sempre foi um processo de tentativa e erro. Porém, em 2012, uma nova ferramenta conhecida como TALENs, (acrônimo para “transcription activator-like effector nucleases”), deu aos pesquisadores a capacidade de alterar ou inativar genes específicos em peixes paulistinhas, sapos, gado e outros animais — até mesmo em células em pacientes com doenças. Esta tecnologia, junto com outras que estão emergindo, está se provando ser tão eficaz quanto (e mais barata do que) técnicas correntes que visam os genes e pode permitir aos pesquisadores controlar tarefas específicas para os genes e suas mutações, tanto em indivíduos saudáveis, quanto doentes.

Férmions de Majorana : A existência dos férmions de Majorana, partículas que (entre outras propriedades) agem como a própria antimatéria e se aniquilam entre si, tem sido debatida por mais de sete décadas. Este ano, uma equipe de físicos e químicos na Holanda conseguiu obter os primeiros indícios consistentes de que essa matéria exótica realmente existe, na forma de quase-partículas: grupos de elétrons que interagem entre si e se comportam como uma só partícula. A descoberta já fez com que sejam desenvolvidos esforços para incorporar os férmions de Majorana na computação quântica, já que os cientistas acham que os “qubits” feitos dessas partículas misteriosas podem ser mais eficientes para a armazenagem e processamento de dados do que os bits atualmente usados nos computadores digitais.

O Projeto ENCODE: Um estudo que se estendeu por toda uma década, relatado este ano em mais de 30 artigos, revelou que o genoma humano é mais “funcional” do que os pesquisadores pensavam. Embora tão somente 2% do genoma sirva de código para proteínas reais, o projeto da Encyclopedia of DNA Elements (Enciclopédia de Elementos do DNA), ou ENCODE, indicou que cerca de 80% do genoma é ativo, ajudando a ligar ou desligar os genes, por exemplo. Estes novos detalhes devem auxiliar os pesquisadores a compreender as maneiras pelas quais os genes são controlados e esclarecer alguns dos riscos genéticos para doenças.

Interfaces Cérebro-Máquina: A mesma equipe que havia demonstrado antes como gravações (das atividades) neurais do cérebro poderiam ser usadas para movimentar um cursor em uma tela de computador, demonstrou em 2012 que pacientes humanos paralíticos podem movimentar um braço mecânico com suas mentes e realizar movimentos complexos em três dimensões. A tecnologia ainda é experimental — e extraordinariamente cara — porém os cientistas têm esperanças que algorítimos mais avançados possam melhorar essas próteses neurais para ajudar pacientes paralisados por derrames, lesões na espinha e outras condições mórbidas.

Ângulo de Mistura de Neutrinos: Centenas de pesquisadores que trabalham na Experiência com Neutrinos no Reator da Baía Daya, na China, relataram que o último parâmetro desconhecido de um modelo que descreve como as elusivas partículas, conhecidas como neutrinos, mudam de um “sabor” para outro, na medida em que se deslocam próximos da velocidade da luz. Os resultados mostram que neutrinos e anti-neutrinos possivelmente podem mudar de sabor de maneira diferente e sugerem que a física de neutrinos pode algum dia auxiliar os pesquisadores a explicar porque o universo tem tanta matéria e tão pouca antimatéria. Se os físicos não conseguirem identificar outras novas partículas além do bóson de Higgs, a física de neutrinos pode representar o futuro da física de partículas.

Nota do tradutor:

1 – Pelamordedeus!… Isso é um texto referendado pela AAAS! Comparar o campo escalar de Higgs com um campo vetorial eletromagnético é meio forte!

O guia do mochileiro das profundezas

Traduzido de: Hitchhiker’s Guide to The Deep

Criaturas dos abismos invadem o mundo da superfície

Por Cheryl Dybas, NSF (703) 292-7734 cdybas@nsf.gov

|

|

O submersível Alvin trouxe consigo alguns inesperados “caronas” das profundezas. |

8 de junho de 2012

“Não entre em pânico”, poderia ter dito Douglas Adams.

Autor da novela de ficção científica O Guia do Mochileiro das Galáxias, Adams sempre recomendava “não entre em pânico” sempre que se confrontasse invasores.

O que Adams pode não ter sabido é que o espaço interior dos oceanos esconde alienígenas tão cheios de recursos como qualquer outro que espreita no espaço exterior.

“E agora esses moradores das profundezas dos mares viraram a mesa contra nós”, diz Janet Voight, uma bióloga do Museu Field de História Natural em Chicago.

Voight e outros cientistas que estudam as fontes hidrotermais do oceano profundo, descobriram que algumas formas de vida podem sobreviver às extremas mudanças de pressão do fundo do oceano para a superfície do mar.

Em um recente mergulho do submersível de pesquisa oceânica profunda Alvin, alguns companheiros – 38 deles, para ser exato – acharam o caminho para a superfície.

Lepetodrilus gordensis, é o nome do invasor. É um tipo de caracol marinho chamado lapa, bem conhecido pela sua habilidade de grudar como cola a diversas superfícies.

“Entretanto, ninguém pensou que isso incluísse os instrumentos de um submersível”, comenta Voight.

|

|

Um aglomerado de invasores – lapas do fundo do oceano – que subitamente apareceram na superfície. |

A fauna nas fontes hidrotermais das profundezas dos mares estão entre as mais isoladas e inacessíveis da Terra. A vida nessas “fontes” se baseia em um processo chamado quimiossíntese, que, diferentemente da fotossíntese, não depende da luz do Sol. Em lugar disso, ele subsiste em substâncias químicas expelidas pelas próprias fontes.

“As fontes hidrotermais só podem ser visitadas por veículos especiais submarinos, os quais podem se mover livremente entre elas”, escreveram Voight e seus colegas em um artigo publicado recentemente em Conservation Biology.

Os co-autores do artigo são Raymond Lee da Universidade do Estado de Washington, Abigail Reft da Universidade do Estado de Ohio e Amanda Bates da Universidade da Tasmania.

“Os pesquisadores supunham que os indivíduos da fauna da fonte, se fossem trazidos à superfície, seriam mortos pela mudança da pressão da água”, explica Voight. “Claramente não é assim”.

Depois de um mergulho do Alvin, Voight encontrou as 38 lapas das fontes em amostras tiradas de outro local submarino onde não há fontes hidrotermais – e, portanto, não há lapas das fontes.

|

|

Um grupo de Lepetodrilus gordensis, a espécie de lapa encontrada no submersível. |

Os cientistas tinham coletado amostras de um habitat sem lapas ao longo da Serra Juan de Fuca, uma cordilheira submarina nas profundezas do Pacífico Noroeste. Mas quando Voight foi examinar o “tesouro”, ele continha lapas.

“O que está errado aqui?”, ela se perguntou. “Bem, essa espécie de lapa só era conhecida nas fontes da Cordilheira Gorda, 635 quilômetros ao sul de Juan de Fuca.”

A pergunta passou a ser: como as lapas chegaram a mais de 600 km de seu habitat? “A única resposta é que elas devem ter sido transportadas pelo submersível”.

O que serve para mostrar, segundo Chuck Lydeard, diretor de programa na Divisão de Biologia Ambiental da Fundação Nacional de Ciências(NSF), que financiou a pesquisa, “que a humanidade não pode supor coisa alguma acerca da capacidade de dispersão de outros organismos, inclusive aqueles que se pensa que estão restritos aos ambientes mais extremos do planeta”.

A introdução inadvertida de uma nova espécie em um ecossistema é um dos maiores desafios aos esforços de conservação.

Como uma espécie reagirá ao novo ambiente e o efeito que terá se ela começar a se reproduzir e predominar, é imprevisível.

“A perfuração de águas profundas e atividade de submersíveis podem aumentar a probabilidade dessas introduções”, acrescenta Voight, “mas até agora se considerava que as fontes hidrotermais eram isoladas demais para serem uma fonte de invasores”.

|

|

Caracóis em cima de caracóis recobrem o chão das profundezas do mar perto de uma fonte hidrotermal. |

Em áreas costeiras, uma das maiores ameaças de espécies invasivas é a introdução de doenças. Patógenos recém-incluídos podem causar a morte em massa das espécies nativas. As doenças que possam existir em ambientes extremos, tais como as fontes hidrotermais, não foram bem estudadas, lembra Voight.

“Claramente é possível introduzir acidentalmente uma espécie – e as doenças que ela potencialmente carregue – de uma fonte do mar profundo a uma nova localização”, acrescenta ela. “Isso tem implicações para a exploração futura das fontes hidrotermais. E também revela o risco potencial de mudanças introduzidas pela ação humana em ecossistemas, mesmo naqueles ecossistemas que a maioria de nós jamais chegará a ver”.

A descoberta é uma valiosa lição para os cientistas e operadores de veículos que trabalham nas profundezas dos mares, diz Brian Midson da Divisão de Ciências Oceânicas da NSF.

“Uma potencial fertilização cruzada e a contaminação das fontes hidrotermais e outros locais tem que ser considerada durante as atividades pré e pós-mergulho”, afirma Midson. “Esta nova informação vai resultar em discussões futuras entre as tripulações dos navios e os cientistas pesquisadores acerca da necessidade de uma limpeza rigorosa e da inspeção dos mecanismos de coleta de amostras e dos veículos, antes e depois de cada mergulho”.

|

|

O Alvin com o braço de manipulação e o dispositivo coletor de amostras – os caracóis podem ter se fixado aqui. |

As lapas que Voight achou pegaram uma carona em algum lugar do coletor de amostras do submersível, ela acredita, “talvez no tubo corrugado, onde ficou água suficiente para mantê-las vivas”.

“A substituição do tubo corrugado por um tubo liso pode ajudar a impedir os transplantes inadvertidos de biota, mas qualquer superfície ou rugosidade do submersível ou seus equipamentos pode servir como refúgio”.

Os cientistas urgem que outros pesquisadores presumam que clandestinos “fisiologicamente rústicos” podem estar presentes em instrumentos de pesquisa de águas profundas e tomem precauções para não transportar espécies não-nativas de e para as profundezas.

“Impedir essas introduções é de capital importância”, declara Voight, “para manter intactos os ecossistemas das fontes termais”.

Planeje com antecedência para a eventualidade de invasores, poderia ter sugerido Douglas Adams, mas “não entre em pânico”.

Pelo menos, não por enquanto…

ISNS: Não é a melhor equipe que vence a Copa

[ Original em inglês: Best Team Not Guaranteed World Cup Success ]

Por que é importante ter um pouco de sorte, junto com uma sólida estrategia para o jogo.

11 de junho de 2010

Por Chris Gorski

Inside Science News Service

|

Crédito: Christopher Bruno |

WASHINGTON (ISNS) — A Copa do Mundo dá aos fãs do esporte mais popular do mundo a oportunidade de vibrarem e agonizarem com os altos e baixos das equipes de suas nações. Para os cientistas, sejam ou não fãs, é mais uma oportunidade para coletarem dados e testar hipóteses acerca do quanto a final reflete mesmo as habilidades relativas e desempenho das duas equipes – e se elas usaram as melhores estrategias possíveis para obter a vitória.

Um jogo e um torneio imperfeitos?

Quando a poeira assentar, depois do término no mes que vem dessa Copa do Mundo, provavelmente o campeão não será o time que jogou melhor, diz Gerald Skinner, astrofísico da Universidade de Maryland em

College Park.

Após uma discussão no refeitório com seus fanáticos companheiros de mesa,

Skinner, que admite não ser um grande entusiasta por esportes, publicou uma pesquisa em 2009 que detalhavam sua afirmação, usando técnicas familiares aos astrônomos. E as descobertas apoiavam sua posição.

“Não chega a ser um processo totalmente aleatório, porem o resultado de uma partida de futebol em particular tem uma grande dose de sorte e aleatoriedade nele”, argumenta Skinner.

A média de gols por partida na Copa de 2006 foi de 2,3 gols por partida. Pela análise do número de gols e sua distribuição, que é melhor descrita pelo fenômeno estatístico chamado de distribução de Poisson, Skinner foi capaz de demonstrar que, se uma partida fosse jogada novamente, o número de gols e até o vencedor poderiam variar consideravelmente, mesmo que ambas as equipes jogassem igualmente bem – em parte porque o futebol é um jogo de baixos escores.

Se uma seleção vence por uma diferença de 3×0, seus torcedores podem estar certos de que o melhor triunfou. Porém, segundo Skinner, se o resultado for 2×1 ou 1×0, a coisa não fica tão clara. Por exemplo, ele descobriu que nos jogos que acabaram em 2×1, quase um terço das vezes não foi o time com a melhor campanha que ganhou.

Essa incerteza influencia todo o torneio. Skinner afirma que a primeira fase da Copa do Mundo provavelmente revela os melhores times de cada chave, já que todos jogam entre si. Mas as fases seguintes são por eliminação simples e as incertezas se acumulam em quatro jogos sucessivos. Skinner calculou que a probailidade de ser a melhor equipe que ganhe a Copa do Mundo fica em torno dos 28%.

“É realmente na fase do mata-mata que a incerteza é introduzida no processo”, argumenta Skinner. “Você tem que vencer quatro vezes contra a chance de um resultado inesperado”.

Skinner propõe que mudanças no jogo que aumentem a média de gols fariam diminuir a chance de alguém ganhar por pura sorte. As opções incluem aumentar o tamanho do gol, ou fazer com que as equipes continuem jogando até uma diferença significativa no número de gols, mas acrescenta “eu tenho que admitir que essas opções não são realísticas”.

Para alguns torcedores, a chance de que qualquer coisa pode acontecer é uma das boas coisas nos esportes. Não importa o quanto improvável for o vencedor, a marra vai durar por quatro anos.

Os times deveriam ser mais ofensivos?

Talvez mesmo porque o futebol seja um jogo de poucos pontos ou talvez porque as equipes temam sofrer um gol de bobeira e perder o jogo, o fato é que muitas equipes parecem defender muito mais do que atacar. Um modelo desenvolvido com base na Teoria dos Jogos – que pode ser usado para descobrir uma estrategia ideal, dado que o(s) adversário(s) também procuram estrategias ideiais – sugere que esse modo de ver pode ser contraproducente.

Este modelo, desenvolvido para analisar estratégias otimizadas em futebol, é o trabalho de Ricardo Manuel Santos, economista do Instituto Tecnologico

Autonomo de Mexico na Cidade do Mexico. “O que eu faço é comparar como os times deveriam jogar segundo o modelo e como eles realmente jogam segundo os dados, e eu encontro grandes discrepâncias”, diz ele.

Santos analisou dados de nove anos da Liga dos Campeões da UEFA, que reune as melhores euquipes da Europa e, felizmente, guarda numerosas estatísticas. Ele usou uma técnica chamada análise de fatores que ele descreve como uma maneira de estudar algo que não é diretamente observável, tal como felicidade ou comportamento de um time.

A partir das estatísticas da UEFA, Santos estimou a estrategia dos times baseado no número de chutes a gol, corners, faltas e outros fatores. O modelo refletiu como a estrategia causa impacto em um jogo.

“Eu sou capaz de encontrar a probabilidade de fazer qualquer número de gols, bem como a de levar qualquer número de gols”, afirma Santos. “Eu posso ver como os times jogam, como isso afeta a probabilidade de vencer ou perder o jogo”.

Santos admite que a Liga dos Campeões não é a mesma coisa que a Copa do Mundo, mas ele acredita que as descobertas devem ser aplicáveis a esta última. E ele concede que os técnicos podem não colocar seus times no ataque porque isso pode cansá-los muito cedo em uma partida, ou por outro motivo não aparente nas estatísticas.

Pode ser que os técnicos sejam simplesmente muito conservadores.

“O que eu percebo é que os times deveriam atacar muito mais do que aparentemente o fazem”, diz Santos. “Eles deveriam atacar muito, quando na verdade eles parecem defender muito”.

Será que um time ofensivo pode tomar conhecimento dessa pesquisa, ter um ou dois lances de sorte e ganhar a Copa do Mundo? Possivelmente.

Uma coisa é certa: o mundo inteiro vai estar de olho.

Nota do tradutor:

Outra coisa é certa: americano não entende chongas de futebol, adora estatísticas que não levam a nada, e, se dependesse dos cientistas, o que se consegue é uma Jabulani… Uma “tecnologia de ponta” que é, simplesmente, ruim…

Atualizando em 12/06 17:39: aí vem o goleiro da seleção da Inglaterra e engole um frango épico e manda as probabilidades de Santos para o vinagre…

Chega de amarguras!

Traduzido de: Edible Synthetic Blocks Bitter Taste

Uma nova molécula inibe a capacidade da língua de sentir sabores amargos.

27 de maio de 2010

Por Devin Powell

Inside Science News Service

|

Imagerm ampliada |

WASHINGTON (ISNS) — Não aguenta mais as couves de Bruxelas de sua avó? Em vez de encharcá-las de manteiga ou dá-las para o cachorro, em breve você disporá de uma opção científica, codinome GIV3727.

A molécula recentemente descoberta é um bloqueador de amargos que contem a exata combinação de carbono, oxigênio e hidrogênio para proteger sua língua de substâncias amargas. Ela faz parte da última moda da indústria alimentícia – componentes sintéticos de sabores, montados em laboratório, que funcionam como um botão de volume em seu aparelho de som, ajustando a sensiibilidade de suas papilas gustativas para mais ou para menos.

“Com esta abordagem sintética, podemos sonhar com estruturas químicas além daquelas que a natureza nos fornece, para bloquear diferentes sabores”, diz Jay Slack, biólogo molecular na Givaudan Flavors Corp. em Cincinnati. A companhia publicou a estrutura da molécula em Current Biology hoje .

Nosso Amargo Passado

A corrida para criar essas moléculas de sabor na Givaudan e outras companhias de biotecnologia é uma batalha contra os 400 milhões de anos de evolução que tornaram a língua humana no que ela é hoje.

Sua língua é equipada com 10.000 papilas gustativas, cada uma da largura de um cabelo humano. Cada papila gustativa contem um sortimento de 50 a 150 células de sabor, cada uma das quais especializadas em um dos cinco sabores básicos: salgado, doce, azedo, amargo ou umami. Partículas da comida se grudam aos pequenos receptores de sabor nessas células, disparando uma série de eventos dentro da célula que levam à sensação de sabor no cérebro.

A primeira criatura dotada de receptores para o sabor amargo semelhantes aos nossos, viveu a uns 400 milhões de anos atrás. Os humanos modernos, aves, peixes e outros mamíferos todos tem genes semelhantes vindos desse ancestral comum, genes que permitem a nosso corpo criar receptores de sabor.

Os cientistas identificaram moléculas receptoras de sabor em 1998, quando Charles Zucker da Universidade da California em San Diego descobriu que ratos que não tinham um gene em particular, eram incapazes de sentir o gosto de açúcar. Depois do Projeto Genoma Humano em 2003, Zucker identificou todos os genes humanos que contem os códigos para nossos receptores de sabor especializados.

Nós possuimos um tipo de receptor dedicado ao doce, um para o salgado, um para o azedo e um para o umami – no entanto, na última contagem, existiam 25 receptores diferentes para o amargo. Os cientistas acreditam que essa variedade de recetores de amargor, capazes de detectar milhares de diferentes compostos, são uma forma de auto-proteção, uma vez que venenos e toxinas encontrados na natureza tendem a ter sabores amargos.

“Trata-se de um velhíssimo princípio da evolução”, comenta Wolfgang Meyerhof,

geneticista do Insituto Alemão de Nutrição Humana em Potsdam-Rehbruecke que trabalhou com a Givaudan. “O sabor nos ajuda a evitar substâncias prejudiciais e torna os nutrientes atrativos”.

O Doce Futuro

Muitos alimentos e bebidas – especialmente bebidas dietéticas feitas com adoçantes artificiais – também tem um sabor ou um arrière-goût que a indústria alimentícia gostaria de eliminar.

“Nós queríamos desenvolver um bloqueador de amargos que visasse um único receptor”, explica Meyerhof.

Para encontrar o GIV3727, a Givaudan recruitou milhões de pequeninos testes de sabor semelhantes aos da língua – células talhadas pela engenharia genética para fazer as vezes dos receptores de amargor humanos. Essas células brilham quando expostas a compostos amargos e podem ser usadas para verificar a eficácia de centenas de milhares de bloqueadores em potencial do amargor, de forma muito mais rápida e barata do que provadores humanos.

Slack testou mais de 170.000 moléculas para encontrar a GIV3727, um “antagonista” do amargor que gruda em vários receptores de amargo diferentes e bloqueia o contato dos compostos amargos dos alimentos.

Depois de passar por testes de segurança e ser certificada pela Food and Drug Administration como “Genericamente Reconhecida como Segura”, a molécula foi testada com voluntários humanos. As pessoas que experimentaram o bloqueador de amargos com adoçantes artificiais como acesulfame K e sacarina, que são centenas de vezes mais doces do que o açúcar, relataram sentir um sabor muito menos amargo, mas igualmente doce.

Há anos os cientistas descobriram outro composto químico – monofosfato de adenosina – que interfere com nossas células gustativas, impedindo os sabores doce e amargo. Ele é usado para atenuar o amargor de certos medicamentos, motivo pelo qual alguns deles tem um gosto acentuadamente doce: os fabricantes adicionam adoçante concentrado para suplantar o efeito de atenuação da doçura.

No entanto Danielle Reed, geneticista no Monell Chemical Senses Center em Philadelphia, que não estava envolvida na pesquisa, declarou que a descoberta da Givaudan é sem precedentes:

“Nunca foi demonstrada a existência de um bloqueador específico para amargos que tue como antagonista de um receptor de amargor”, disse Reed.

Slack não revela os clientes da Givaudan, mas diz que várias importantes companhias do ramo alimentício compraram o GIV3727, que pode estar chegando aos supermercados no futuro em qualquer coisa, de bebidas dietéticas, passando por enxaguante bucal, até gomas de mascar sem açúcar.

Pescado do EurekAlert (26/5/10)

O sangue flui de maneira diferente no cérebro dos esquizofrênicos:

A Sociedade de Radiologia dos Estados Unidos relata que pesquisadores do Departamento de Radiologia da Universidade de Bonn, Alemanha, empregaram uma técnica chamada continuous arterial spin labeling (CASL) que mapeia os fluxos sanguíneos sem emprego de agentes radioativos ou de contraste e detectaram que, nos esquizofrênicos, esse fluxo apresenta um padrão diferentes das pessoas “normais”, o que permite diagnosticar casos de esquizofrenia a partir de exames de Ressonância Magnética.

Segundo o médico Lukas Scheef, principal autor do artigo a ser publicado em Radiology, os pacientes esquizofrênicos se caracterizam por apresentar distintas áreas de hipoperfusão – um fluxo de sangue menor que o normal – nas regiões dos lobos frontais, cortex frontal, giros cingulados anterior e medial, e nos lobos parietais, regiões estas associadas a funções cognitivas que incluem planejamento, tomada de decisões, julgamento e controle de impulsos.

Também foi observada hiperperfusão – o inverso: fluxo sanguíneo acima do normal – no cerebelo, tronco encefálico e tálamo dos pacientes esquizofrênicos.

Novas espécies de invetebrados descobertas na Antártica:

|

|

|

IMAGEM: Austasensis Tauroprimnoa (A) e Digitogorgia kuekenthali (B). |

Duas novas espécies de gorgônias, Tauroprimnoa austasensis e Digitogorgia kuekenthali, descobertas respectivamente no Leste do Mar de Weddell Sea e a Sudoeste das Ilhas Falklands (Malvinas) e na Isla Nueve (na Patagônia Chilena), são pequenas e alongadas. Ambas as espécies se notabilizam pelo número, formato e disposição das escamas de carbonato de cálcio que cobrem seus pólipos e pelos tipos de ramificações formadas por suas colônias.

“As Tauroprimnoa se caracterizam pelas colônias em forma de escova, com ramos singelos e cujos pólipos, dispostos em leque, tem somente quatro escamas marginais. O restante do pólipo é coberto por cinco fileiras longitudinais de escamas. A figura se assemelha a um touro, daí o nome”, explica Rebeca Zapata-Guardiola, principam autora do estudo e pesquisadora do Departamento de Fisiologia e Zoologia da US.

As Digitogorgia tem características semelhantes, porém uma aparência diferente (como se vê na figura).

Outras quatro espécies de gorgônias foram descobertas nas Ilhas Georgia do Sul e na Baia Atka, na Antártica – Thouarella bayeri, Thouarella sardana, Thouarella undulata e Thouarella andeep– que, como outras de seu gênero, são feitas de oito fileiras de escamas que cobrem a superfície do pólipo.

“As diferenças se encontram nos padrões de ramificação das colônias, na disposição dos pólipos nos ramos e na ornamentação das escamas do pólipo”, explica Zapata-Guardiola.

Finalmente, uma notícia bombástica, vinda do Conselho de Pesquisas de Engenharia e Ciências Físicas da Grã-Bretanha:

Nova tecnologia tornará a votação em eleições mais eficiente

O press-release afirma que “demoradas contagens manuais de votos e as urnas podem estar destinadas aos livros de história, graças a uma nova e segura tecnologia para votação”.

O “simples” sistema proposto prevê um tipo de cédula picotado ao meio, onde estão impressos (em ordem aleatória em cada cédula, não vá alguem “vazar o gabarito”) os nomes dos candidatos no “canhoto” e as caixas para preenchimento dos votos na outra parte. O press-release deixa subentendido que há alguma forma de identificar cada cédula, porque, após o preenchimento, o votante fica com o canhoto (que ele pode enfiar em uma trituradora de papeís ou guardar para controle) e enfia o “volante” de votação em um escâner que faz a leitura do voto e envia por uma linha criptografada para uma central de processamento eletrônico de votos. Supostamente, o “volante” também será destruido após o escaneamento, embora o press-release seja omisso quanto a isto.

A idéia do “canhoto” é que cada eleitor possa verificar, através de um sistema protegido por senha, se seu voto foi corretamente contabilizado pelo sistema, após a totalização.

Eu consigo pensar em umas dez formas diferentes por onde o sigilo da votação pode ser quebrado com tal sistema, mais umas duas dúzias de maneiras para fraudar a totalização dos votos…

Cá entre nós, as já conhecidas “urnas eletrônicas” usadas pela Justiça Eleitoral Brasileira me parecem mais simples e confiáveis, mas vá convencer os “sábios” britânicos disso…

Ciência e engenharia dignas de um Oscar

Tornar os filmes mais semelhantes à realidade não foi uma tarefa fácil para os indicados para o Oscar da Academia de Artes e Ciências Cinematográficas em 20 de fevereiro

17 de fevereiro de 2010

Por Emilie Lorditch

Inside Science News Service

WASHINGTON (ISNS) — Quando as pessoas vêem um filme, elas sabem que o que estão vendo é uma ilusão – e fazer com que as imagens pareçam tão reais quanto possível pode ser uma tarefa difícil para qualquer equipe de produção de um filme.

Criar essas ilusões que parecem realísticas é o trabalho do elenco e da equipe do filme. Se assegurar que as cores pareçam as mesmas por todo o filme e reproduzir as mesmas luzes e sombras que as criadas pela iluminação natural, é somente um exemplo das realizações dos 15 cientistas e engenheiros que serão premiados durante a Cerimônia de Premiação do Oscar 2010, apresentada pela atriz Elizabeth

Banks no sábado 20 de fevereiro.

Manter as cores consistentes

Indicado para “melhor filme”, “Avatar” perderia sua capacidade de imergir a audiência no fantástico mundo de Pandora se a marca registrada da pele azul de Na’vi mudasse de tom a cada cena.

“As telas de computador têm uma composição de cores diferentes daquelas geradas em uma película; as cores que eu enxergo em um computador, nem sempre consigo reproduzí-las em filme e vice-versa”, explica Mark Wolforth, um engenheiro elétrico e biomédico que é um especialista em imagens da FilmLight Limited. “O Truelight é um sistema de gerenciamento de cores que mantém as cores iguais, seja na tela do computador, seja na tela do cinema”.

Antes mesmo que a primeira tomada do filme seja realizada, o sistema Truelight é usado para estabelecer como as câmeras e a iluminação do filme irão trabalhar em conjunto. A equipe é instruída a criar uma impressão do filme, usando suas câmeras e equipamentos de iluminação normais.

“Eles fazem a impressão e nos enviam junto com os dadosde ajustagem das câmeras e iluminação”, conta Wolforth. “Olhando a impressão do filme, nós damos à equipe instruções específicas das ajustagens que darão sempre as mesmas cores”.

Tornar o mundo de animação mais realístico

As cenas quase-reais do filme de animação “Up”, também indicado para “melhor filme”, prenderam a atenção tanto de crianças, como de adultos. A criação de um cômodo realístico sem o uso de um cenário ou iluminação reais apresentou um grande desafio para os cientistas e engenhieros da PIXAR.

A renderização por pontos é a forma pela qual cada um dos objetos em uma cena de animação é mapeado. Cada objeto é feito a partir de um grupo de pontos coloridos chamados de “nuvem de pontos” (“point cloud”) que mostram a posição e a cor de um objeto na cena. A mesma técnica está sendo agora empregada para conceitos como iluminação indireta e oclusão aumbiente.

“Iluminação indireta é quando uma superfície que está iluminada por uma fonte de luz, reflete essa luz sobre outras superfícies”, explica Christensen, engenheiro elétrico e cientista de computação especializado em gráficos computadorizados dos estúdios de animação PIXAR. “Um dos efeitos da iluminação indireta é o que chamamos de ‘vazamento de cor’; se tivermos um tapete vermelho próximo de uma parede branca, parte da luz que incide sobre o tapete será refletida na parede branca, dando a ela um tom rosado”.

Por outro lado, a oclusão ambiente tem a ver com as sombras.

“Pense nisso como uma sombra muito tênue como em um dia nublado sem luz solar direta”, explica Christensen. “A oclusão ambiente também faz com que rachaduras e rugas nas superfícies fiquem mais visíveis e escurece objetos próximos; esse é um efeito que é importante capturar para adicionar realismo em imagens geradas por computador”.

Iluminando rostos

Seja o ator em cena real ou digital, capturara a maneira como a luz brilha em sua face é crucial para um cena.

“Existe um monte de tecnologias para capturar a forma e alguns até lhe dão um mapa da textura da face, mas o que é preciso e desejável é como ela reflete a luz”, diz Paul Debevec, Diretor Associado de Pesquisa Gráfica do Instituto de Tecnologias Criativas da Universidade do Sul da Califórnia em Marina del Ray. “Queremos saber como os modelos mudam, como suas faces refletem a luz, a cor e o brilho de sua pele, e saber onde sua pele cintila ou cria rugas quando eles sorriem”.

A LightStage captura um modelo de computador realístico da face humana. O ator fica sentado dentro de um arco de 32 luzes estroboscópicas que dão flashes sequenciados, enquanto as imagens são gravadas em vídeo de alta velocidade, o que resulta em centenas de imagens do rosto.

“Nós ficamos surpresos de descobrir que, algumas vezes, nossa versão digital do ator estava melhor iluminada e parecia mais realística do que as imagens tomadas ao vivo com um ator, de forma que o diretor escolhia usar nossa versão digital para cenas específicas”, disse Debevec.

O progresso nas ciências e na engenharia continuam a revolucionar nosso modo de vida, mas não nos esqueçamos que ele também revoluciona nosso entretenimento.

Terremoto no Haiti: pode não ter acabado ainda…

[ traduzido de:Scientists Return to Haiti to Assess Possibility of Another Major Quake ]

![]()

Geocientistas vão coletar dados cruciais para avaliação de possíveis riscos futuros

|

Em uma foto anterior ao terremoto, um receptor e uma antena de GPS instalados na laje de um prédio em Port-au-Prince, Haiti. |

25 de janeiro de 2010

Uma equipe financiada pela National Science Foundation (NSF) está voltando ao Haiti esta semana para investigar a causa do terremoto de magnitude 7 lá ocorrido em 12 de janeiro.

Os geólogos vão coletar dados cruciais para avaliar se o terremoto pode desencadear outro evento grave a leste ou oeste da capital do Haiti, Port-au-Prince.

Eric Calais, um geofísico da Universidade Purdue que lidera a equipe, declarou que a maior parte das réplicas ocorrem no intervalo de semanas após o tremor iniicial e que a equipe precisa chegar urgentemente ao local para fazer uma avaliação detalhada, antes que as informações geológicas cruciais desapareçam.

,

Segundo Calais, “A questão principal é saber se, depois das pequenas réplicas, poderia estar a caminho um terremoto ainda maior. Existem diversos exemplos históricos de um terremoto inicial desencadear um ainda maior ao longo da mesma falha ou de falhas próximas. Estamos preocupados com a República Dominicana, porque nossos modelos preliminares mostram que a continuação da falah nessa área está sobrecarregada”.

O terremoto de 12 de janeiro causou danos no Haiti estimados em 200.000 mortos, 250.000 feridos e 1,5 milhão de desabrigados. Port-au-Prince sentiu uma réplica de magnitude 6 em 20 de janeiro.

|

|

|

O geofísico Eric Calais segura um marcador geodésico que rastreia até os menores movimentos da Terra. |

“Os dados de GPS e geológicos que essa equipe vai recolher, vão fornecer conhecimentos importantes para estabelecer a causa do terremoto de 12 de janeiro no Haiti”, declara Tim Killeen, diretor assistente da NSF para geociências, “e são essenciais para avaliar o potencial para a ocorrência de futuros terremotos na área de Port-au-Prince”.

O Serviço de Minas e Energia e a Agência de Defesa Civil do governo haitiano convidaram Calais e sua equipe a retornar ao país para examinar a falha e aconselhar as autoridades quando do início dos trabalhos de reconstrução.

“O governo precisa de aconselhamento científico para decidir o que fazer agora e no futuro, quando começarem a pensar em reconstrução”, confirma Calais. E prossegue:

“Nós sabemos como fazer os cálculos que servirãode base para predizer se a probabilidade de novos terremotos ao longo da falha aumentou, porém precisamos de informações que só podem ser obtidas no próprio local, mediante observações diretas e medições feitas diretamente no solo”.

|

|

|

Louis Obenson da Agência de Defesa Civil do Haiti instala o equipamento GPS em Port-au-Prince. |

A equipe de pesquisas de Calais vinha rastreando o acúmulo de energia ao longo das falhas Setentrional e de Enriquillo na ilha Hispaniola, que abriga o Haiti e a República Dominicana, usando tecnologia do Global Positioning System (GPS).

A equipe estudou a área por cinco anos, usando 100 marcadores GPS. Em 2008, os pesquisadores alertaram para a probabilidade de ocorrência de um terremoto de magnitude 7,2 no Haiti e um de magnitude 7,5 na República Dominicana, em uma pesquisa financiada pela NSF.

Agora, a NSF alocou uma nova verba para a equipe para encontrar e mapear a área da falha onde ocorreu a ruptura, plotar novamente os marcadores GPS existentes e instalar 10 novos marcadores contínuos para monitorar as mudanças que ocorrerão nos anos vindouros, na medida em que a crosta terrestre se reajusta.

A equipe de pesquisas inclui ainda outros geocientistas: Andrew Freed e a estudante de pós-graduação Sarah Stamps, da Purdue; Paul Mann da Universidade do Texas em Austin; Glenn Mattioli da Universidade do Arkansas; Estelle Chaussard da Universidade de Miami; e Richard Koehler da Divisão do alaska do Serviço Geológico e Geofísico dos EUA.

|

|

|

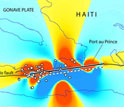

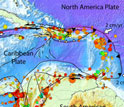

Haiti: as áreas em vermelho são as mais próximas do ponto de ruptura; os círculos cinzentos marcam as réplicas. |

O apoio técnico para a operação é prestado pela UNAVCO, a estatal vinculada à NSF que opera o sistema GPS com base em Boulder, Colorado.

A partir das medições por GPS na superfície, a equipe pode estabelecer o que aconteceu ao longo da falha até sua profundidade máxima de 20 km no subsolo.

As medições precisas desses movimentos subterrâneos é crítica para a validação dos modelos de mudanças de estresse que podem indicar a probabilidade potencial – e a possível magnitude – de futuros terremotos, afirma Calais.

|

|

|

Mapa com o ambiente sismo-tectônico da Placa Tectônica do Caribe. |

“Os estesses em mutação na crosta terrestre depois de um grande terremoto, podem atuar nos sentidos de travar ou de destravar outras falhas. Se uma falha estiver prestes a destravar e uma mudança no estresse aliviar ligeiramente a pressão, ela pode se romper e causar um terremoto”, explicou ele.

“Nós achamos que é isso que vem causando as réplicas que se concentram mais na extremidade oeste da área do epicentro, inclusive a recente réplica de magnitude 6”.

A equipe também vai colaborar com Falk Amelung e Timothy Dixon da Universidade de Miami para coletar dados de radar por satélite para mapear as mudanças antes e depois do terremoto. Essa informação, combinanda com os dados do GPS, resultarão na estimativa mais precisa da fonte do terremoto, um ponto de partida fundamental para estudos futuros.

|

|

|

Mapa com o histórico sísmico da Ilha Hispaniola, antes de 1960. |

“Esta é uma oportunidade sem precedentes para estudar um grande terremoto ocorrido em uma falha onde se encontram duas placas tectônicas”, disse Freed. “O que aprendermos aqui pode ser traduzido para outras falhas similares por todo o mundo, tais como o Sistema de Falhas de San Andreas. Felizmente, grandes terremotos não ocorrem com frequência, mas isso torna esta uma rara oportunidade para aprender sobre o comportamento da Terra”.

A despeito do convite do governo haitiano e de ser uma missão da NSF, conseguir transporte para o Haiti foi difícil, disse Calais. Membros do Departamento de Tecnologia de Aviação da Purdue mexeram uns pauzinhos junto à firma Aeroservice em Miami para conseguir que Calais e seus equipamentos fossem transportados para Port-au-Prince em um avião de carga que levava suprimentos de emergência para o país.

Calais observa que “a ajuda de meus colegas da Purdue foi fundamental para me levar a Port-au-Princ. Não está fácil entrar no país agora e não queríamos interferir com o mais importante: a chegada de suprimentos e pessoal de socorro”.

Além de bancar o transporte, a companhia Trimble, fabricante de equipamentos de GPS, doou ao Haiti seis receptores de GPS, adaptados para operação em campo pela UNAVCO e que serão posicionados pela equipe de pesquisas.

ISNS: A caminho dos exawatts

[ Traduzido de: Going For Exawatts ]

Uma universidade no Texas está tentando construir o laser mais poderoso do mundo.

25 de janeiro de 2010

Por Phillip F. Schewe

Inside Science News Service

|

O Dr. Todd Ditmire dirige o projeto do Texas Petawatt na Universidade do Texas em Austin

Crédito: UT Austin

|

WASHINGTON (ISNS) — Produzir um laser com um terawatt de energia – ou seja, um trilhão de watts – costumava ser algo impressionante, no entanto a vanguarda da pesquisa da energia óptica anda na casa de 1 quatrilhão de watts, ou seja, 1 petawatt. Porém mesmo uma tal energia não é o bastante para o professor de física Todd Ditmire da Universidade do Texas em Austin.

Ditmire planeja construir um laser de exawatt, uma potência equivalente a 1.000

petawatts. Mas esse super-laser ainda está a anos do atual estado-da-arte. Enquanto isso, Ditmire já tem o laser mais poderoso do mundo.

Para fazer uma ideia do que significa um exawatt, compare com uma típica lâmapda incandescente de 100 W. A capacidade de toda a rede de energia elétrica dos EUA é de cerca de 10 bilhões de vezes isso, ou seja, cerca de 1 terawatt. Assim, toda a rede de energia elétrica dos EUA poderia acender continuamente 10 bilhões de lâmpadas de 100 W. Um

petawatt é 1.000 vezes isso tudo e um exawatt são 1.000 petawatts.

O laser de Ditmire não produz mais energia do que a rede de energia dos EUA toda: o laser atinge seu pico máximo por um breve instante de cada vez e o faz a partir de uma quantidade pequena de energia por um período menor do que um trilionésimo de segundo. Apenas durante esse instante o laser da UT Austin se torna mais poderoso do que toda a rede de energia elétrica. Ditmire usa uma técnica conhecida como “chirping” (uma técnica de compressão de pulso por modulação linear de frequência) para estender o tempo de duração do breve pulso de luz. Esse pulso alongado é amplificado a uma energia mais alta e então re-comprimido para uma duração mais curta, comprimindo a energia em um pacote muito poderoso.

O principal emprego do Texas Petawatt Laser, como ele é chamado, é produzir fusão termonuclear, um processo que muitos engenheiros gostariam de dominar para a produção de energia elétrica comercial. Outras configurações usam a energia do laser para bombardear alvos que liberam nêutrons que podem ser usados em pesquisas biomédicas ou de nanotecnologia.

Para alcançar sua próxima meta, lasers com exawatts de potência, Ditmire espera combinar tecnologias já conhecidas de laser e sua técnica já comprovada de pulsos curtos, com novos materiais de vidro para lasers que permitirão a amplificação a energias ainda mais altas, porém estima que a construção de um laser na casa do exawatt possa demorar ainda uns 10 anos.

O ano de 2010 marca o 50º aniversário da invenção do laser, o que vem sendo sublinhado pelo LaserFest que enfatiza a importância dos lasers em vários congressos científicos por todo o ano. Os dipositivos laser apresentam a qualidade única de concentrar uma grande quantidade de energia luminosa em um pequeno ponto e enviar feixes de luz em linhas quase retas, tornando possíveis coisas como cirurgias a laser, mapeamentos a laser e apontadores a laser.