Uma estrela com dupla personalidade

National Radio Astronomy Observatory

Estrela imita ‘O médico e o Monstro” e fica alternando entre pulsar de rádio para pulsar de Raios-X e de volta

|

|

||||

Os astrônomos descobriram um estranho caso de uma estrela de nêutrons com a peculiar habilidade de se transformar de um rádio pulsar para um pulsar de raios-X e ficar alternando de uma para a outra. O comportamento caprichoso dessa estrela parece ser alimentado por uma estrela acompanhante próxima e pode fornecer novos conhecimentos sobre o nascimento de pulsares em milissegundos.

“O que vemos é uma estrela que é o equivalente cósmico de ‘O médico e o Monstro’, com a capacidade de mudar de uma forma para sua contraparte mais intensa, em uma velocidade espantosa”, declarou Scott Ransom, um astrônomo do National Radio Astronomy Observatory (NRAO) em Charlottesville, Virgínia. “Embora já soubéssemos que binárias [emissoras] de raios-X – algumas das quais são observadas como pulsares de raios-X – possam evoluir ao longo de milhões de anos e se tornarem pulsares de rádio que giram extremamente rápido, fomos surpreendidos ao encontrar uma que parecia oscilar de uma para outra rapidamente”.

Estrelas de nêutrons são os remanescentes super densos de estrelas massivas que explodiram como supernovas. Esta estrela de nêutrons em particular, catalogada como IGR J18245-2452, fica a aproximadamente 18.000 anos-luz da Terra, na constelação de Sagitário, em um aglomerado de estrelas conhecido como M28. Ela tinha sido inicialmente identificada como um radio pulsar de milissegundo em 2005 com o Telescópio Robert C. Byrd de Green Bank Telescope (GBT) e, posteriormente, foi redescoberta como um pulsar de raios-X por outra equipe de astrônomos em 2013. Eventualmente, as duas equipes perceberam que estavam observando o mesmo objeto, muito embora ele estivesse se comportando de maneira bem diferente, dependendo de quando era observado. Observações adicionais e dados de arquivo de outros telescópios acabaram por confirmar o ciclo “liga-desliga” de raios-X e pulsos de rádio.

“Várias observações desta estrela em particular, ao longo dos anos e com diferentes telescópios, revelaram coisas tremendamente diferentes – certas vezes era um pulsar e outras, uma binária de raios-X”, declarou Alessandro Papitto do Consejo Superior de Investigaciones Cientificas – Institut d’Estudis Espacials de Catalunya, em Barcelona, Espanha, o autor principal de um artigo publicado na Nature. “Isso era particularmente intrigante, uma vez que binárias de raios-X não emitem pulsos de rádio e a fonte de emissão de raios-X tem que se ter esgotado muito antes que os sinais de rádio possam emergir”.

A resposta para este enigma foi descoberta na complexa interação entre a estrela de nêutrons e sua acompanhante próxima.

|

|

||||

As binárias de raios-X, como seu nome implica, ocorrem em um sistema de duas estrelas no qual uma estrela de nêutrons é acompanhada por outra estrela normal de pequena massa. A estrela de nêutrons – menor mas consideravelmente mais massiva – pode arrancar material de sua companheira, formando um disco achatado de gás em torno da estrela de nêutrons. Gradualmente, na medida em que esse material mergulha para a superfície da estrela de nêutrons, ele fica superaquecido e gera uma intensa emissão de raios-X.

Os astrônomos acreditavam que esse processo de acreção continuava, sem interrupções por milhões de anos a fio. Eventualmente, o material se esgotava e a acreção parava, juntamente com a emissão de raios-X.

Sem o influxo de material novo, os poderosos campos magnéticos da estrela de nêutrons se tornavam capazes de emitir feixes de ondas de rádio que varrem o espaço enquanto a estrela gira, dando ao pulsar sua característica aparência de um farol.

A maioria dos rádio pulsares gira umas poucas dezenas de vezes por segundo e – se deixados por sua própria conta – vão se desacelerando ao longo de muitos milhares de anos. No entanto, no caso em que a estrela de nêutrons comece sua existência como uma binária de raios-X, a matéria que se acumula sobre sua superfície faz com que a estrela de nêutrons acelere a rotação, até que esteja girando a centenas de vezes a cada segundo. Quando o processo de acreção para, o resultado é um pulsar de milissegundos.

Durante suas observações, os pesquisadores detectaram súbitas emissões de pulsos de raios-X que duravam aproximadamente um mês e paravam abruptamente. Dentro de alguns dias, os pulsos de rádio recomeçavam. Essas oscilações abruptas indicavam que o material do disco de acreção estava caindo na estrela de nêutrons em catadupas, em lugar do fluxo longo e constante teorizado pelos astrônomos.

Um estudo anterior de outro sistema com o GBT detectou o primeiro indício de um disco de acreção em torno de uma estrela de nêutrons, o que ajudou a estabelecer a ligação entre binárias de raios-X de pequena massa e pulsares.

Os novos dados apoiam esta ligação, mas também mostram pela primeira vez que o processo de evolução, que se pensava levar alguns milhões de anos, é na verdade mais complexo e pode ocorrer de forma abrupta e episódica, em fenômenos que podem durar apenas dias ou semanas. “Isto não só demonstra a ligação evolutiva entre a acreção e os pulsares acelerados de milissegundos”, observa Ransom, “mas também que alguns sistemas podem alternar entre os dois estados em escalas de tempo muito curtas”.

A fonte de raios-X foi descoberta pelo International Gamma-Ray Astrophysics Laboratory (INTEGRAL) e as subsequentes observações em raios-X foram realizadas pelos satélites XMM-Newton, Swift e Chandra. As observações de rádio foram feitas pelo GBT, o rádio-telescópio Parkes, o Australia Telescope Compact Array e o Westerbork Synthesis Radio Telescope.

O National Radio Astronomy Observatory é uma instalação da National Science Foundation, operada em cooperativa pela Associated Universities, Inc.

A atividade humana afeta a estrutura vertical da atmosfera

Original em inglês por Anne M Stark, LLNL.

|

|

|

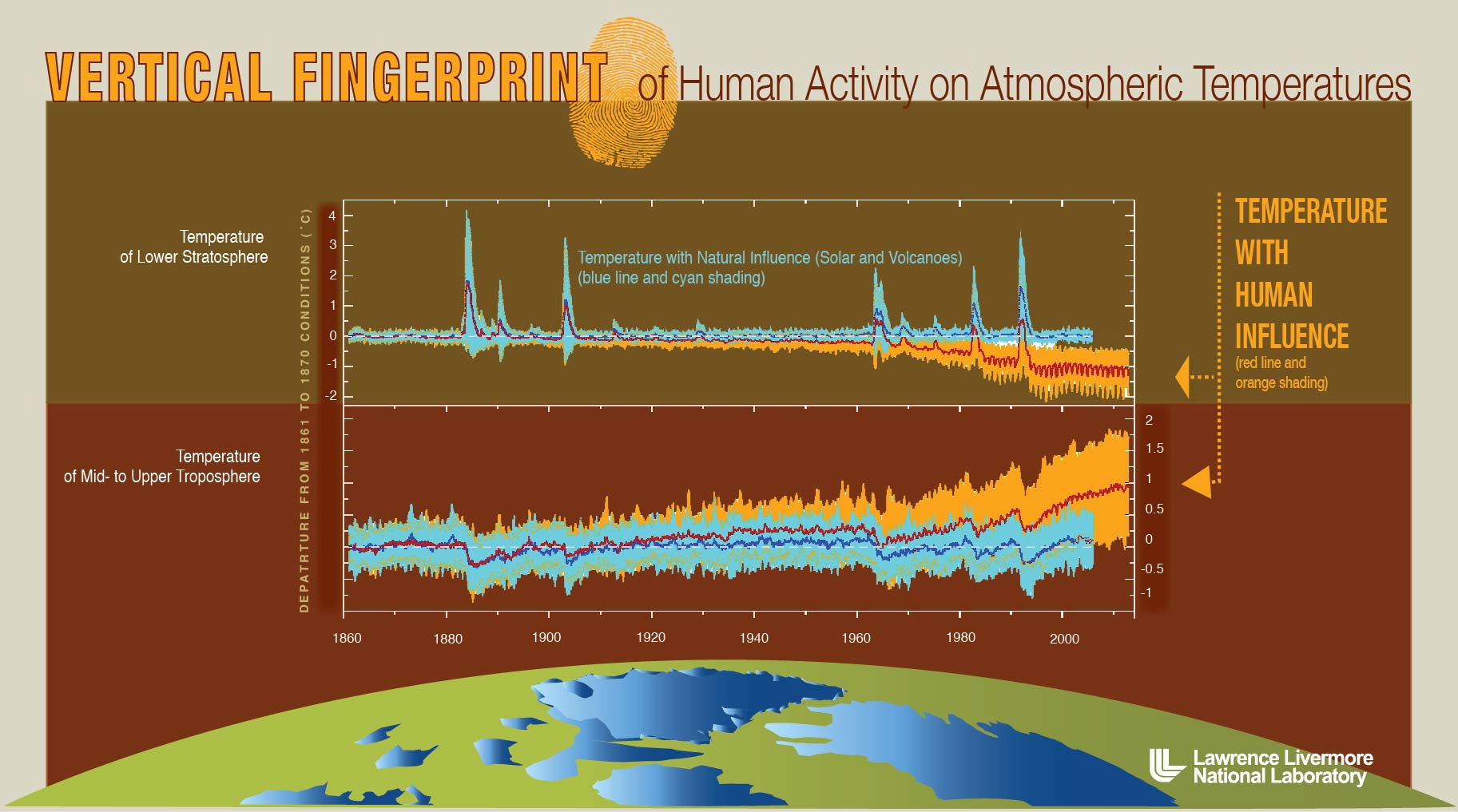

Representação gráfica das “digitais” – tanto das atividades humanas, quanto as da natureza – sobre a estrutura vertical da atmosfera. As mudanças decorrentes das atividades humanas, tais como a produção acelerada de gases de efeito estufa, faz com que a estratosfera esfrie, enquanto a troposfera, do meio para cima, se aqueça. Um novo estudo comprova que as influências naturais não poderiam causar sozinhas essas mudanças de temperaturas. Crédito da imagem: Lawrence Livermore National Laboratory. (Imagem ampliada) |

As influências das atividades humanas causaram um impacto direto no padrão latitude/altitude da temperatura atmosféricas. Esta é a conclusão de um novo relatório apresentado pelos cientistas do Lawrence Livermore National Laboratory e seis outras instituições científicas. A pesquisa compara vários registros feitos por satélites de mudanças nas temperaturas atmosféricas com os resultados de simulações computadorizadas de grande tamanho e vários modelos.

“A atividade humana tem efeitos muito diferentes sobre as temperaturas da atmosfera superior e inferior, e uma digital muito diferente das influências puramente naturais”, afirma Benjamin Santer, o principal autor do artigo publicado na edição de 16 de setembro de Proceedings of the U.S. National Academy of Sciences. “Nossos resultados fornecem indícios claros de uma distinta influência humana sobre a estrutura térmica da atmosfera”.

Os dados das observações por satélites e as previsões do modelo de computação da resposta à influência humana têm um padrão comum de latitude/altitude de mudanças da temperatura atmosférica. As características principais desse padrão são, em escala global, o aquecimento da troposfera e o resfriamento da estratosfera, ao longo dos registros dos satélites por 34 anos. (A troposfera é a parte mais baixa da atmosfera da Terra. A estratosfera fica acima da troposfera.)

“Os atuais modelos climáticos provavelmente não são capazes de produzir este padrão de sinal distinto, somente pela variabilidade interna, ou em resposta a mudanças causadas por fenômenos naturais, tais como variações na radiação solar, ou aerossóis espalhados por erupções vulcânicas”, diz Santer.

As flutuações internas naturais no clima são geradas por complexas interações no sistema atmosfera-oceano, tais como o bem conhecido El Niño. As influências externas incluem mudanças causadas pelas atividades humanas, tais como os gases de efeito estufa, camada estratosférica de ozônio e outros agentes sobre as radiações, assim como flutuações de origem puramente natural na radiação solar e os aerossóis vulcânicos. Cada uma dessas influências deixa uma “digital” inconfundível no padrão detalhado por latitude/altitude de mudanças na temperatura atmosférica.

A informação das digitais se comprovou particularmente útil para separar as influências climáticas das atividades humanas, solares e vulcânicas.

“O padrão de mudanças de temperaturas que foi observado no sentido vertical na atmosfera, desde o nível do chão até a estratosfera, se ajusta ao que era esperado da atividade humana de emissão de gases de efeito estufa. O mesmo padrão entra em conflito com o que seria de se esperar de outras explicações, tais como flutuações na emissão de radiações pelo Sol”, explica Santer.

Outra pesquisadora do LLNL, co-autora do artigo, Celine Bonfils, observa que grandes erupções vulcânicas também podem perturbar profundamente a estrutura vertical da temperatura atmosférica. “Durante o período de recuperação de tais erupções, também acontecem o aquecimento da troposfera e o resfriamento da estratosfera”, diz ela. “Porém, de forma diferente das influências vulcânicas, as mudanças de temperaturas atmosféricas causadas pela atividade humana afetam todas as latitudes e duram mais tempo. Isto sugere que as recentes mudanças de temperaturas não são uma simples recuperação de eventos vulcânicos passados”.

Os outros cientistas do Livermore incluem Jeff Painter, Peter Gleckler, Charles Doutriaux e Karl Taylor. A equipe de pesquisadores contou ainda com cientistas do Remote Sensing Systems (Carl Mears e Frank Wentz), do Massachusetts Institute of Technology (Susan Solomon), da Universidade de Adelaide, Austrália (Tom Wigley), do NASA/Goddard Institute of Space Studies (Gavin Schmidt), do Canadian Centre for Climate Modelling and Analysis (Nathan Gillett) e do Nansen Environmental and Remote Sensing Center, Noruega (Peter Thorne).

Primeira medição experimental da carga fraca do próton

Carga Fraca do Proton é Medida pela Primeira Vez

O Q-weak do Jefferson Lab mediu a carga fraca do próton.

NEWPORT NEWS, Virgínia, 17 de setembro de 2013 — Pesquisadores realizaram a primeira medição experimental da carga fraca do próton em uma pesquisa realizada na Instalação Nacional do Acelerador de Partículas Thomas Jefferson do Departamento de Energia do Governo dos EUA (Jefferson Lab).

Os resultados, aceitos para publicação em Physical Review Letters, também inclui medições da carga fraca do nêutron e dos quarks up e down. Essas medições foram feitas mediante a combinação dos novos dados obtidos com dados publicados por outros experimentos. Embora estas medições preliminares sejam as medições mais precisas até hoje feitas, elas foram obtidas a partir da análise de apenas 4% do total dos dados coletados pelo experimento; a análise completa dos dados deverá levar mais um ano para ser completada.

A força fraca é uma das quatro forças fundamentais do nosso universo, junto com a gravidade, o eletromagnetismo e a força forte. Muito embora a força fraca só atue no nível subatômico, seus efeitos podem ser observados em nosso mundo do dia a dia. A força fraca desempenha um papel fundamentas nas reações nucleares que ocorrem dentro das estrela e são responsáveis por grande parte da radiação natural existente no universo.

O experimento Q-weak foi projetado por um grupo internacional de físicos nucleares que se reuniram há mais de uma década para propor uma nova medição no Jefferson Lab. Eles propuseram a primeira medição direta da carga fraca do próton, denotada pelo símbolo  – ou seja, a intensidade do puxão exercido pela força fraca dentro do próton, ou, em outras palavras, o quanto o próton interage através da força fraca. Uma vez que a carga fraca do próton é uma quantidade precisamente prevista pelo Modelo Padrão – o arcabouço teórico (porém bem testado) que descreve as partículas elementares e detalha como elas interagem – ela se torna um parâmetro ideal para medir experimentalmente a exatidão do Modelo Padrão.

– ou seja, a intensidade do puxão exercido pela força fraca dentro do próton, ou, em outras palavras, o quanto o próton interage através da força fraca. Uma vez que a carga fraca do próton é uma quantidade precisamente prevista pelo Modelo Padrão – o arcabouço teórico (porém bem testado) que descreve as partículas elementares e detalha como elas interagem – ela se torna um parâmetro ideal para medir experimentalmente a exatidão do Modelo Padrão.

Para realizar o experimento, os cientistas direcionaram um feixe muito intenso de elétrons para dentro de um contentor de hidrogênio líquido. Os elétrons foram polarizados longitudinalmente (girando ao longo ou em sentido contrário de seu movimento). Os elétrons que apenas resvalavam nos prótons (dispersão elástica, onde o próton permanece intacto), emergiam em pequenos ângulos e eram defletidos por poderosos eletromagnetos em oito detectores simetricamente dispostos.

A força fraca é muito mais fraca do que a eletromagnética. Em termos clássicos, se pode pensar nisso como para cada milhão de elétrons que interajam com os prótons através da força eletromagnética, apenas um vai interagir através da força fraca. Os físicos mediram essas poucas interações fracas, explorando uma importante diferença entre as duas forças – a força fraca viola um tipo de simetria conhecido como paridade, pela qual nosso universo “destro”, mediante a rotação de todas as direções espaciais, se torna “canhoto”. Em um mundo de paridade oposta, os elétrons que giram com seus eixos ao longo da direção de seu movimento, interagem como os prótons através da força eletromagnética, com a mesma intensidade. Quando a interação é através da força fraca, os elétrons com spin “destrógiro” interagem de forma diferente dos “levógiros”. Quando se mantém todos os demais parâmetros do experimento inalterados e somente a polarização do feixe de elétrons é revertida, os cientistas podem usar a diferença, ou “assimetria” das medições entre as duas polarizações para isolar o efeito da interação fraca. A meta é medir esta diferença, na faixa de ~200 partes por bilhão, tão precisamente como possível. Essa precisão é equivalente a medir a espessura de uma folha de papel no alto da Torre Eifel.

A análise inicial dos dados da experiência Q-weak deram um valor para  que está bem de acordo com a previsão do Modelo Padrão. No entanto, a colaboração dispõe de 25 vezes mais dados do que os usados nessa medição inicial. O resultado final deverá fornecer um rigoroso teste experimental para o Modelo Padrão, fornecendo novas restrições para a nova física nas escalas de energia que estão sendo exploradas no LHC do CERN.

que está bem de acordo com a previsão do Modelo Padrão. No entanto, a colaboração dispõe de 25 vezes mais dados do que os usados nessa medição inicial. O resultado final deverá fornecer um rigoroso teste experimental para o Modelo Padrão, fornecendo novas restrições para a nova física nas escalas de energia que estão sendo exploradas no LHC do CERN.

“Os leitores devem encarar esses resultados primeiramente como uma medição da carga fraca do próton. Nossa publicação definitiva será focalizada nas implicações a respeito de potenciais novidades na física”, diz Roger Carlini, um cientista do staff do Jefferson e porta-voz da colaboração Q-weak.

O experimento Q-weak foi originalmente aprovado em janeiro de 2002. Um período de instalação de quase um ano, começou em 2009, seguido por um período de dois anos de coleta de dados de 2010 a 2012.

Várias conquistas técnicas na década passada tornaram este experimento possível. Estas incluem o feixe de elétrons de alta corrente, alta polarização e extremamente estável produzido pelo Acelerador Contínuo de Feixe de Elétrons do Jefferson Lab; o alvo de hidrogênico criogênico com a maior potência no mundo; detectores Cerenkov com extrema resistência à radiação; circuitos eletrônicos com ruído ultra baixo para a leitura dos sinais e medição precisa da corrente do feixe; e um sistema que mede a polarização do feixe com uma precisão melhor que 1%, usando um laser backscatter. Estas inovações técnicas permitiram a obtenção de uma incerteza assombrosamente pequena de 47 partes por bilhão para os dados divulgados até agora.

A colaboração Q-weak consiste de 97 pesquisadores de 23 instituições nos EUA, Canadá e Europa. O experimento foi financiado pelo Escritório de Ciências do Departamento de Energia do governo dos EUA, pela Fundação Nacional de Ciências dos EUA e pelo Conselho de Pesquisas de Ciências Naturais e Engenharia do Canadá. Também contribuíram as seguintes universidades: The College of William and Mary, Virginia Tech, George Washington University e Louisiana Tech University. Apoio técnico de TRIUMF, MIT/Bates e Jefferson Lab.

Os resultados serão publicados na edição de 13 de outubro (online) e 18 de outubro (impressa) da Physical Review Letters.

Qual será o formato do Universo?

Dados deixam em aberto a possibilidade de um Universo curvo

Crédito da imagem: NASA

Indícios dos ecos do Big Bang podem sugerir um universo em forma de sela.

11 de setembro de 2013

Original em inglês por: Charles Q. Choi, Contribuidor do ISNS Contributor

Charles Q. Choi é um escritor independente da cidade de Nova York que já escreveu para The New York Times, Scientific American, Wired, Science, Nature e vários outros noticiosos.

Armazenar energia “verde” compensa?

Cientistas de Stanford calculam a energia necessária para armazenar energia eólica e solar na rede

As baterias de armazenamento convencionais são boas para “fazendas” de energia solar (em larga escala), mas são necessários aperfeiçoamentos tecnológicos para o armazenamento da energia eólica, dizem os cientistas de Stanford.

Original (em inglês) por MARK SHWARTZ

A energia de fontes renováveis é a grande esperança para que se torne possível reduzir as emissões de dióxido de carbono. Mas há ocasiões onde as “fazendas” solares e eólicas geram mais energia do que a demanda requer. Armazenar essa energia excedente para futuro emprego parece uma solução óbvia, porém um novo estudo da Universidade Stanford sugere que essa solução nem sempre se aplica.

“Examinamos as baterias e outras tecnologias promissoras para o armazenamento da energia solar e eólica na rede elétrica”, explica Charles Barnhart, o principal autor do estudo e doutor-pesquisador no projeto da Stanford Global Climate and Energy Project (GCEP).

“Nossa meta principal foi calcular o custo energético total – ou seja, a quantidade total de combustível e eletricidade necessários para construir e fazer funcionar essas tecnologias de armazenamento. Descobrimos que, quando se computa os custos energéticos, baterias em escala de rede só fazem sentido para armazenar energia solar excedente, mas não a eólica”.

O estudo, financiado pelo GCEP, foi publicado na edição online de Energy and Environmental Science.

Mudanças climáticas e energia renovável

A maior parte da energia elétrica nos Estados Unidos é gerada em usinas que funcionam a base de carvão e gás natural – combustíveis fósseis que contribuem de maneira significativa para o aquecimento global através da emissão de grandes quantidades de dióxido de carbono. As energias solar e eólica não geram emissões e são fontes renováveis, mas são dependentes da luz solar e dos ventos para funcionarem.

“Para que a rede funcione eficientemente, a geração de energia precisa se adequar à demanda sempre, porém, no caso das fontes renováveis, nem sempre é o caso”, prossegue Barnhart. “Por exemplo, as fazendas de ventos algumas vezes produzem eletricidade demais à noite, quando a demanda é pequena. Este excesso de energia tem que ser armazenado ou usado em outro lugar, senão, será desperdiçado. No entanto, a rede de energia dos Estados Unidos tem uma capacidade de armazenagem muito limitada”.

Uma grande variedade de tecnologias está sendo desenvolvida para resolver essa deficiência de capacidade de armazenagem de energia na rede. A equipe de Stanford avaliou várias tecnologias emergentes, inclusive cinco tipos de baterias – ácido-chumbo, íon de lítio, sódio-enxofre, vanádio-redox e zinco-bromo.

Em um estudo anterior, Barnhart calculou o custo energético para a construção e manutenção de cada um dos cinco sistemas de baterias para armazenagem em escala da rede. Ele descobriu que as baterias ácido-chumbo eram as de maior custo energético, enquanto as de íon de lítio eram as de menor.

“Calculamos quanta energia é empregada ao longo de todo o ciclo de vida da bateria – desde a mineração das matérias primas, até a instalação do dispositivo pronto”, explica Barnhart. “As baterias com maior custo energético são aquelas são as que mais consumem combustíveis fósseis e, portanto, são responsáveis pelas maiores emissões de dióxido de carbono ao longo de seu tempo de vida. Se o custo energético de uma bateria for alto demais, sua contribuição para o aquecimento global pode neutralizar os benefícios que a fazenda solar ou eólica – cujo funcionamento ela deveria apoiar – possam gerar”.

Para o presente estudo, ele e seus colegas calcularam o custo energético de células solares fotovoltáicas e turbinas elólicas na escala da rede.

“Tanto as turbinas eólicas quanto as células fotovoltaicas produzem mais energia que o necessário para construí-las e mantê-las”, diz o doutor-pesquisador do GCEP Michael Dale, um co-autor do estudo. “No entanto, nossos cálculos mostraram que o custo energético global das turbinas eólicas é muito menor do que o dos painéis solares convencionais, os quais requerem uma grande quantidade de energia, fundamentalmente de combustíveis fósseis, para o processamento do silício e a fabricação de outros componentes”.

É melhor armazenar ou desligar?

A seguir, os cientistas examinaram os custos energéticos do desligamento dos painéis solares e turbinas eólicas para não permitir a geração de um excesso de energia para a rede.

“O desligamento de fontes de energia renovável parece um desperdício”, diz Barnhart. “Porém os operadores da rede rotineiramente desligam turbinas eólicas para evitar um excesso súbito e inesperado de geração de eletricidade que poderia causar uma sobrecarga nas linhas de transmissão e causar apagões. A frequência desses desligamentos nos EUA provavelmente vai aumentar, na medida em que as fontes de energia renováveis se tornem mais participantes”.

Desligar uma fonte de energia limpa pode parecer contra-intuitivo, mas será que armazenar o excesso de energia em baterias é uma alternativa prática?

Para descobrir, os pesquisadores compararam o custo energético do desligamento dos geradores solares e eólicos com o custo energético do armazenamento em grande escala na rede. Seus cálculos se basearam em uma fórmula conhecida como “retorno em energia sobre o investimento” – a quantidade de energia produzida por uma tecnologia, dividida pela quantidade de energia necessária para construir e manter essa tecnologia.

Usando esta formula, os pesquisadores calcularam que a quantidade de energia necessária para criar uma fazenda solar é comparável à energia usada para construir cada uma das cinco diferentes tecnologias de baterias de armazenamento. “O uso de bateria para armazenar energia solar durante os períodos de baixa demanda seria, portanto, favorável em termos energéticos”, afirma Dale.

Os resultados foram bem diferentes para as fazendas de ventos. Os cientistas descobriram que o desligamento das turbinas eólicas reduz o retorno do investimento em energia em apenas 10%. Porém o armazenamento dos eventuais excessos de energia elétrica gerada por turbinas eólicas resulta em reduções ainda maiores – desde cerca de 20% com baterias de íon de lítio, até mais de 50% com baterias de ácido-chumbo.

“Idealmente, o custo energético do deligamento de um sistema deveria ser ao menos igual ao custo de armazenagem”, explica Dale. “Este é o caso com as células fotovoltaicas, porém no caso das fazendas de ventos, o custo energético do desligamento é muito menor do que o de armazenagem com baterias. Assim, o desligamento de uma turbina eólica é mais eficiente em termos de economia de energia do que o custo de armazenagem de excessos”.

Ele faz a comparação com um cofre: “Não compensa gastar $100 em um cofre para guardar um relógio de $10”, diz ele. “Da mesma forma, não é sensato montar baterias energeticamente caras para armazenar uma energia cujo custo de produção é barato como o vento, embora faça sentido para sistemas de células fotovoltaicas que demandam muita energia em sua produção”.

Barnhart aduz que a maneira mais eficaz de melhorar o desempenho energético de uma bateria, seria aumentar sua vida útil. Baterias de íon de lítio convencionais duram cerca de quatro anos, ou 6.000 ciclos de carga-descarga. As baterias de ácido-chumbo duram apenas 700 ciclos. Para armazenar de maneira eficiente a energia para a rede, as baterias deveriam suportar entre 10.000 e 18.000 ciclos, segundo ele.

“Armazenar energia consome energia e desligar a fonte é um desperdício”, conclui Barnhart. “Em ambos os casos há uma redução no total do retorno energético do investimento”.

Outras opções

Além das baterias, os pesquisadores consideraram outras tecnologias para armazenamento de energia de fontes renováveis, tais como armazenamento por bombeamento para hidroeléticas, que usa a energia elétrica excedente para bombear água para um reservatório de uma barragem. Mais tarde, quando a demanda por energia crescer, a água armazenada é liberada através das turbinas da barragem para gerar eletricidade.

“O bombeamento de água é usado em 99% do armazenamento para a rede atualmente”, diz Barnhart. “Funciona incrivelmente bem, de um ponto de vista energético, tanto para energia solar como eólica. O retorno do investimento em energia é 10 vezes melhor do que o das baterias convencionais. Mas existem restrições geológicas e ambientais para o armazenamento da água bombeada”.

O armazenamento não é a única maneira de melhorar a confiabilidade da rede. “A energia que seria perdida em caso de excesso de produção, pode ser usada para bombear água para irrigação, ou para recarregar uma frota de veículos elétricos, por exemplo”, sugere Dale.

Barnhart acrescenta que é importante que a sociedade tenha consciência de como economizar energia, notadamente quanto à implementação de novas tecnologias. “Investidores e aqueles que tomam as decisões políticas precisam também considerar os custos energéticos, além dos financeiros, das novas tecnologias”, afirma ele. “Se a economia for o único fator considerado, as tecnologias mais baratas que necessitam significativas quantidades de energia para sua manufatura, manutenção e substituição, podem sair vencedoras – mesmo que elas ao fim e ao cabo aumentem as emissões de gases de efeito estufa e acabem por jogar fora todos os benefícios de longo prazo da implementação da geração de eletricidade por energia solar e eólica”.

“Nossa meta é compreender o que é necessário para construir um sistema energético com baixo rastro de carbono”, diz a co-autora Sally Benson, diretora do GCEP e professora de engenharia de recursos energéticos. “O retorno do investimento em energia é uma dessas métricas que alertam sobre prováveis obstáculos a frente. Temos esperança que este estudo forneça um padrão para desempenho que guie futuras pesquisas de armazenamento de energia em escala para a rede”.

Adam Brandt, um professor assistente de engenharia de recursos energéticos da Escola de Ciências da Terra em Stanford, também assina o estudo como co-autor.

Mark Shwartz escreve sobre ciências e tecnologias da energia para o Precourt Institute for Energy na Universidade Stanford.

Poderosos jatos expelem material de uma galáxia em formação

National Radio Astronomy Observatory

Poderosos jatos expelem material de uma galáxia

Este processo limita os crescimento do buraco negro no centro e a taxa de formação de estrelas

Astrônomos, usando uma rede mundial de rádio telescópios, descobriram um forte indício de que um poderoso jato de material, acelerado até próximo da velocidade da luz pelo buraco negro central de uma galáxia, está expelindo massivas quantidades de gás para fora da galáxia. Segundo eles, este processo está limitando o crescimento do buraco negro e a taxa de formação de estrelas na galáxia, sendo assim uma peça chave para a compreensão do desenvolvimento das galáxias.

Os astrônomos vêm teorizando que muitas galáxias deveriam ser mais massivas e ter mais estrelas do que as na verdade existentes. Os cientistas propuseram que dois principais mecanismos poderiam frear ou interromper os processos de aumento da massa e de formação de estrelas – violentos ventos estelares, oriundos de bursts de formação de estrelas e as perdas decorrentes das jatos alimentados pelo buraco negro supermassivo central da galáxia em formação.

“Com as imagens em grande detalhe obtidas por uma combinação intercontinental de radio telescópios, pudemos observar massivas bolhas de gás frio sendo empurradas para fora do centro galático pelos jatos alimentados pelo buraco negro”, diz Raffaella Morganti, do Instituto Holandês para Radio Astronomia e da Universidade de Groningen.

Os cientistas estudaram uma galáxia chamada 4C12.50, a uns 1,5 bilhões de anos-luz da Terra. Eles escolheram essa galáxia porque ela está em um estágio onde o “motor” do buraco negro que produz os jatos, acaba de ser ‘ligado”. Na medida em que o buraco negro, uma concentração de massa tão densa que nem a luz consegue escapar, puxa material para dentro de si, o material forma um disco giratório em torno do buraco negro. Processos que ocorrem nesse disco, sugam a tremenda energia gravitacional do buraco negro e a usam para expulsar material pelos polos do disco.

Nas extremidades de ambos os jatos, os pesquisadores encontraram bolhas de gás de hidrogênio se movendo para fora da galáxia a 1.000 km por segundo. Uma das nuvens tem mais de 16.000 vezes a massa de nosso Sol, enquanto a outra contém 140.000 vezes a massa solar. A nuvem maior, segundo os cientistas, tem mede aproximadamente 160 por 190 anos-luz.

“Este é o indício mais definitivo até hoje de uma interação entre o jato acelerado de uma galáxia assim e uma densa nuvem de gás interestelar”, diz Morganti. “Acreditamos estar observando em ação o processo pelo qual um motor ativo central pode retirar o gás – a matéria prima para a formação de estrelas – de uma galáxia jovem”, acrescenta ela.

Os cientistas também afirmam que suas observações indicam que os jatos expelidos pelo núcleo da galáxia podem tensionar e deformar as nuvens de gás interestelar de forma que o efeito de “empurrão” se expande além da pequena amplitude dos próprios jatos. Além disto, eles relatam que, no estágio de desenvolvimento da 4C12.50, os jatos podem “ligar” e “desligar”, de forma a repetir periodicamente o processo de expulsão de gases da galáxia.

Em julho, outra equipe de cientistas, usando o Atacama Large Millimeter/submillimeter Array (ALMA), anunciou ter encontrado o gás sendo soprado para fora de uma galáxia mais próxima – a NGC 253 – por um intenso burst de formação de estrelas.

“Acredita-se que ambos os processos possam estar atuando, frequentemente de modo simultâneo, nas galáxias jovens, a fim de regular o crescimento de seu buraco negro central, assim como a taxa na qual elas podem criar novas estrelas”, declarou Morganti.

Morganti e sua equipe usaram radio telescópios na Europa e nos Estados Unidos, combinando seus sinais para formar um gigantesco telescópio intercontinental. Nos Estados Unidos esses incluíram o Very Long Baseline Array (VLBA) da Fundação Nacional de Ciências (NSF), um sistema continental de radio telescópios desde o Hawaii, passando pelos EUA continentais e chegando a St. Croix nas Ilhas Virgens, e mais uma antena do Karl G. Jansky Very Large Array (VLA) no Novo México. Os radio telescópios europeus empregados foram os de Effelsberg, Alemanha; Westerbork, na Holanda; e em Onsala, Suécia. O extremo poder de resolução – ou seja, a capacidade de observar pequenos detalhes – de um sistema tão abrangente, foi essencial para localizar precisamente a posição das nuvens de gás afetadas pelos jatos da galáxia.

Morganti trabalhou em conjunto com Judit Fogasy da Universidade Eotvos Lorand em Budapest, Hungria; Zsolt Paragi do Instituto Conjunto de Interferometria de Linha de Base Muito Longa da Europa; Tom Oosterloo do Instituto Holandês para Radio Astronomia e da Universidade de Groningen; e Monica Orienti do Instituto Nacional de Astrofísica da Itália – Instituto de Radio Astronomia. Suas descobertas serão publicadas na edição de 6 de setembro da Science.

O National Radio Astronomy Observatory é uma instalação da National Science Foundation, operado em cooperativa pela Associated Universities, Inc.

“Efeito borboleta” na Via Láctea

Um alinhamento bizarro de nebulosas planetárias

|

|

||||

Os astrônomos usaram o Telescópio Espacial Hubble da NASA e o Telescópio “New Technology” (NTT) do ESO para explorar mais de 100 nebulosas planetárias no bulbo central da nossa galáxia. E eles descobriram que os membros dessa família cósmica, aqueles com o formato de borboleta, tendem a ser misteriosamente alinhados — um resultado surpreendente, dadas suas diferentes histórias e variadas propriedades.

Nos estágios finais da vida de uma estrela como nosso Sol, elas dispersam suas camadas externas pelo espaço circundante, formando os objetos conhecidos como nebulosas planetárias, os quais assumem vários formatos belos e surpreendentes. Um dos tipos dessas nebulosas planetárias, conhecido como nebulosa planetária bipolar, cria formatos fantasmagóricos de ampulhetas ou borboletas em torno de suas estrelas mães.

Todas essas nebulosas se formaram em locais diferentes e têm diferentes características. Nem cada nebulosa, nem a estrela que a formou, interagem com qualquer outra nebulosa planetária. No entanto, um novo estudo realizado pelos astrônomos da Universidade deManchester, Reino Unido, mostra similaridades surpreendentes entre algumas dessas nebulosas: muitas delas seguem o mesmo alinhamento nos céus [1].

“Esta é uma descoberta realmente surpreendente e, caso confirmada, uma muito importante”, explica Bryan Rees da Universidade de Manchester, um dos dois autores do artigo. “Muitas destas borboletas fantasmagóricas parecem ter seus eixos maiores alinhados com o plano da galáxia. Usando imagens tanto do Hubble como do NTT, pudemos obter uma visão realmente boa desses objetos, de forma que pudemos estudá-los bem detalhadamente”.

Os astrônomos examinaram 130 nebulosas planetárias no bulbo central da Via Láctea. Eles identificaram três tipos diferentes e esmiuçaram suas características e aparência [2].

“Muito embora duas dessas populações estivessem alinhadas de modo totalmente aleatório nos céus, tal como esperado, descobrimos que a terceira – as nebulosas bipolares – exibiam uma surpreendente preferência por um alinhamento em particular”, diz o segundo autor do artigo, Albert Zijlstra, também da Universidade de Manchester. “Embora qualquer tipo de alinhamento seja uma surpresa, encontrá-lo na superlotada região central de galáxia é mais inesperado ainda”.

Acredita-se que as nebulosas planetárias sejam esculpidas pela rotação do sistema estelar do qual são formadas. Isto depende das propriedades de cada sistema – por exemplo, se se trata de um sistema binário [3], ou se tem alguns planetas em órbita, duas coisas que podem influenciar grandemente o formato da bolha de material expelido. Os formatos das nebulosas bipolares são alguns dos mais extremos e acredita-se que isto seja decorrente da formação de jatos perpendiculares ao plano orbital do sistema estelar que sopram o material expelido para fora.

“O alinhamento que observamos nessas nebulosas bipolares indica algo estranho acerca dos sistemas estelares dentro do bulbo central”, explica Rees. “Para que eles se alinhem da maneira que observamos, os sistemas estelares que formaram essas nebulosas teriam que estar girando perpendicularmente com relação às nuvens interestelares a partir das quais se formaram, e isto é muito estranho”.

Não obstante as propriedades das estrelas mães serem um fator preponderante para o formato assumido por essas nebulosas, esta nova descoberta indica um novo fator ainda mais misterioso. Juntamente com as complexas características dos sistemas estelares, entram em conta as de nossa Via Láctea; todo o bulbo central gira em torno do centro da galáxia. Este bulbo pode ter uma influência maior do que se pensava sobre toda a galáxia – por meio de seus campos magnéticos. Os astrônomos sugerem que este comportamento ordeiro das nebulosas planetárias pode ter sido causado pela presença de fortes campos magnéticos quando da formação do bulbo.

Como o mesmo tipo de nebulosas mais próximos da Terra não se alinham da mesma forma ordenada, esses campos teriam que ter sido várias vezes mais fortes do que são hoje em dia na nossa vizinhança [4].

“Podemos aprender muito ao estudar esses objetos”, conclui Zijlstra. “Se eles realmente se comportam dessa forma inesperada, isto tem implicações não só para o passado de cada estrela, mas para o passado de toda nossa galáxia”.

Notas

[1] O “eixo longo” de uma nebulosa planetária bipolar corta as “asas” da “borboleta”, enquanto o “eixo curto” corta seu “corpo”.

[2] Os formatos das nebulosas planetárias foram classificados em três tipos, segundo as convenções: elíptico, com ou sem uma estrutura interna alinhada, e bipolar.

[3] Um sistema binário consiste de duas estrelas que giram em torno de um centro de gravidade comum.

[4] Pouco se sabe acerca da origem e das características dos campos magnéticos que estiveram presentes em nossa galáxia quando ela era jovem, de forma que é pouco claro como eles possam ter evoluído ao longo do tempo.

Outras Notas

O Telescópio Espacial Hubble é um projeto de cooperação internacional entre ESA e NASA.

A pesquisa é apresentada em uma artigo intitulado “Alignment of the Angular Momentum Vectors of Planetary Nebulae in the Galactic Bulge”, a ser publicado em Monthly Notices of the Royal Astronomical Society.

A equipe de astrônomos foi composta por B. Rees (Universidade de Manchester, RU) e A. A. Zijlstra (Universidade de Manchester, RU). Bryan Rees só veio a pesquisar astronomia recentemente – ele decidiu por um curso de PhD após sua aposentadoria precoce e este trabalho fez parte de sua tese.

Mais informações

Crédito da imagem: NASA (http://www.nasa.gov/) , ESA (http://www.spacetelescope.org/) , A. Zijlstra

Agradecimento: Josh Barrington

Links

- Artigo da pesquisa – http://www.spacetelescope.org/static/archives/releases/science_papers/heic1315a.pdf

- Notícia do ESO – http://www.eso.org/public/news/eso1338/

- Clip do filme da ESA “15 Years of Discovery”: Flight through butterfly shaped nebulae – http://spacetelescope.org/videos/hst15_butterfly/

- Imagens do Hubble – http://www.spacetelescope.org/images/archive/category/spacecraft/