Por que a bateria do seu laptop viciou…

Por que as baterias de íon de lítio falham

|

||||

As baterias de íon de lítio estão presentes em nossos telefones celulares, laptops e câmeras digitais. Existem poucos dispositivos eletrônicos portáteis que não dependam dessas fontes de energia. Atualmente, os eletrodos das baterias contém materiais ativos conhecidos como compostos de intercalação. Esses materiais armazenam carga em suas estruturas químicas sem sofrerem uma mudança estrutural substancial. Isto torna essas baterias comparativamente duráveis e seguras. No entanto, esses materiais de intercalação têm uma limitação: a pequena densidade de energia, a quantidade de energia que pode ser armazenada por unidade de volume e massa.

Na procura poe baterias com mais densidade de energia, os cientistas realizaram experiências por mais de 20 anos com materiais capazes de fazerem e desfazerem liga com o lítio repetitivamente. As experiências em escala de laboratório mostraram que baterias feitas com esses materiais possuem densidades de energia muitas vezes superiores às dos materiais de intercalação; no entanto, esses materiais que fazem ligas ainda não são muito empregados pela indústria porque sua duração é limitada. Martin Ebner, estudante de Ph.D. no Laboratório de Nanoeletrônica do Departamento de Tecnologia da Informação e Engenharia Elétrica (D-ITET) explica: “sua capacidade tipicamente se atenua após um par de ciclos carga-descarga”. Isto é atribuído a uma enorme expansão – de até três vezes – do material do eletrodo durante o carregamento. Durante o descarregamento, o material se contrai novamente, mas não volta a seu estado original. As partículas do eletrodo se separam, a estrutura do eletrodo se desintegra e os fragmentos perdem o contato com o restante da célula.

Observando as baterias durante o funcionamento com raios-x

Para compreender melhor a complexa degradação eletroquímica e mecânica do eletrodo, bem como obter novos dados para o desenvolvimento de baterias melhores, Martin Ebner e a Professora Vanessa Wood do ETH, chefe do Laboratório de Nanoeletrônica do D-ITET, perceberam a necessidade de estudar o funcionamento de um eletrodo de bateria com um processo não invasivo. Dessa forma, eles se voltarm para um instrumento de imageamento desenvolvido pelo Professor Marco Stampanoni do ETH. O Professsor Stampanoni, é catedrático no Instituto de Engenharia Biomédica do D-ITET e opera o feixe de raios-x para tomografia microscópica da Fonte de Luz Suíça, a instalação de síncrotron no Instituto Paul Scherrer. A radiação síncrotron de raios-x, de espectro puro e intensa, permite a rápida aquisição de imagens de raios-x de alta definição que podem ser montadas por computação em filmes tridimensionais.

Os pesquisadores observaram o interior da bateria enquanto ela carregava e descarregava ao longo de 15 horas. Com isso conseguiram montar filmes inéditos que registraram os mecanismos de degradação que ocorrem nas baterias e quantificaram os processos que acontecem com cada uma das milhares de partículas dos eletrodos. Os resultados deste estudo serão publicados na Science; uma versão pré-impressão está disponível online na Science Express.

Mudanças estruturais irreversíveis

Os dados mostram que as partículas de óxido de estanho (SnO) se expandem durante o carregamento devido ao influxo de íons de lítio, o que causa um aumento no volume das partículas. Os cientistas demonstram que a litificação acontece em um processo de fora para dentro, que progride da superfície da partícula até seu núcleo. O material que sofre esta reação, se expande linearmente com a carga armazenada. As imagens de raios-x mostram que o carregamento destrói a estrutura da partícula de modo irreversível, formando rachaduras dentro das partículas. “A formação de rachaduras não é aleatória”, enfatiza Ebner. As rachaduras crescem em locais onde a retícula do cristal contém defeitos pré-existentes. Durante o descarregamento, o volume das partículas diminui; entretanto, o material não volta a seu estado original; portanto, o processo não é completamente reversível.

A mudança de volume das partículas individuais acarreta a expansão de todo o eletrodo, de 50 micrômetros até 120 micrômetros. Porém, durante o descarregamento, o eletrodo só se contrai até 80 micrômetros. Esta deformação permanente do eletrodo demonstra que o polímero agregante que une o eletrodo, ainda não está otimizado para materiais de grande expansão volumétrica. Isto é algo crítico para o desempenho de uma bateria, porque a deformação do agregante faz com que as partículas fiquem desconectadas do eletrodo e bateria perca capacidade.

Além de demonstrar que a microscopia tomográfica por raios-x permite a observação de mudanças morfológicas nas partículas e eletrodos, os pesquisadores demonstraram que esta técnica pode também ser empregada para a obtenção de informações químicas quantitativas e com resolução espacial. Por exemplo, os pesquisadores analisaram a composição química por todo o eletrodo, para procurar por diferenças na dinâmica de litificação ao nível das partículas individuais e comparar isto ao comportamento médio das partículas. Esta abordagem é essencial para a compreensão da influência do tamanho e formato das partículas e a homogeneidade do eletrodo sobre o desempenho da bateria.

Tais vislumbres do funcionamento da bateria não seriam possíveis sem o dispositivo avançado de tomografia com raios-x da Fonte de Luz Suíça. “A visualização das baterias durante o funcionamento era praticamente impossível até os recentes avanços na tomografia por raios-x. Graças às instalações de qualidade mundialmente reconhecidas, desenvolvidas pelo Professor Stampanoni e sua equipe, fomos capazes de observar a bateria funcionando”, acrescenta entusiasticamente Wood.

Alternativas para os materiais cristalinos

Os pesquisadores escolheram o óxido de estanho como material modelo porque ele passa por uma série de transformações complexas, também presentes em outros materiais, o que permite uma compreensão mais profunda do comportamento de vários materiais para baterias. Essas observações fornecem a base para o desenvolvimento de novos materiais para eletrodos e estruturas de eletrodos que sejam tolerantes a expansão volumétrica. Para o Prof. Wood, os resultados de seu trabalho indicam os benefícios do uso de materiais amorfos ou com nano-estrutura, em lugar dos cristalinos. “Na busca por novos materiais, se deve ter em mente que eles só têm interesse para a indústria se puderem ser produzidos em largas quantidades e a baixo custo. Mesmo assim, os materiais amorfos e de nano-estrutura oferecem um campo grande o suficiente para inovações”, enfatiza Wood.

Referencia

Ebner M, Marone F, Stampanoni M, Wood V. Visualization and quantification of electrochemical and mechanical degradation in Lithium ion batteries. Science Express, publicado online em 17 de outubro de 2013.

Novidades acerca das Supernovas

Cientistas da Queen’s University lançam novas luzes sobre a morte de estrelas

Estudo sobre supernovas será publicado na Nature em 17 de outubro.

Os astrônomos da Queen’s University lançaram novas luzes sobre as mais raras e mais brilhantes explosões de estrelas jamais descobertas no universo.

|

|

|

Crédito: ESO/L.Calçada |

A pesquisa, será publicada na edição de 17 de outubro da Nature – uma das publicações científicas mais prestigiosas do mundo. Ela propõe que as supernovas – estrelas explodidas – mais luminosas são energizadas por estrelas de nêutrons pequenas e incrivelmente densas, com campos magnéticos gigantescos que giram a centenas de vezes por segundo.

Os cientistas do Centro de Pesquisas Astrofísicas da Queen’s observaram duas supernovas super-luminosas – duas das estrelas explodidas mais luminosas do universo – por mais de um ano. Ao contrário das teorias correntes, que sugerem que as supernovas mais brilhantes são causadas pela explosão de estrelas super-massivas, as descobertas sugerem que sua origem pode ser melhor explicada por um tipo de explosão dentro do núcleo da estrela que cria uma estrela magnética menor, porém extremamente densa e que gira muito rápido.

Matt Nicholl, um estudante pesquisador do Centro de Pesquisas de Astrofísica na Escola de Matemática e Física da Queen’s, é o autor principal do artigo. Segundo ele: “As supernovas são vários bilhões de vezes mais brilhantes do que o Sol e, na verdade, são tão brilhantes que os astrônomos amadores as buscam regularmente nas galáxias próximas. Há décadas que se sabe que o calor e a luz dessas supernovas vêm de poderosas ondas de choque e material radioativo”.

“Porém foram recentemente encontradas algumas supernovas muito inusitadas que são brilhantes demais para serem explicadas desse jeito. Elas são centenas de vezes mais brilhantes do que aquelas encontradas ao longo dos últimos 50 anos e a origem de suas propriedades extremadas é algo muito misterioso”.

“Alguns físicos teóricos predisseram que estes tipos de explosão se originavam das maiores estrelas do universo se destruindo de maneira quase igual a uma bomba termonuclear. No entanto, os dados que obtivemos não corroboram essa teoria”.

“Na explosão de uma supernova, as camadas externas da estrela são violentamente ejetadas, enquanto seu núcleo colapsa para formam uma estrela de nêutrons extremamente densa – que pesa o mesmo que o Sol, mas com um diâmetro de poucas dezenas de quilômetros. Acreditamos que, em um pequeno número de casos, a estrela de nêutrons tenha um campo magnético muito forte e que gire incrivelmente rápido – cerca de 300 vezes por segundo. Na medida em que a rotação abranda, ela pode transferir energia da rotação [NT: leia-se: momento angular] para toda a supernova, através do magnetismo, tornando-a muito mais brilhante do que o normal. Os dados que obtivemos concordam com essa previsão quase que exatamente”.

Os astrônomos da Queen’s lideraram uma equipe internacional de cientistas neste estudo, empregando alguns dos telescópios mais poderosos do mundo. Grande parte dos dados coletados o foi com o Pan-STARRS – o Telescópio de Pesquisa Panorâmica e Sistema Rápido de Resposta. Com base no Monte Haleakala no Hawaii, o Pan-STARRS tem a maior câmera digital do mundo e pode cobrir uma área com 40 vezes o tamanho da Lua cheia em uma única foto.

Este estudo é um dos projetos financiados por um fundo de € 2,3 milhões do Conselho de Pesquisas Europeu, administrado pelo Professor Stephen Smartt, Diretor do Centro de Astrofísica da Queen’s, a partir de 2012, para condução de pesquisas internacionais sobre as primeiras supernovas do universo.

O Professor Smartt declarou: “Estas são supernovas realmente especiais. Já que elas são tão brilhantes, podemos usá-las como luzes de navegação no universo muito distante. Como a luz viaja pelo espaço a uma velocidade fixa, à medida em que olhamos mais distante, vemos imagens de um passado constantemente mais distante no tempo. Ao compreendermos os processos que levam a essas estonteantes explosões, podemos sondar o universo tal como ele era logo após seu nascimento. Nossa meta é achar essas supernovas do universo primitivo e observá-las a produzir os primeiros elementos químicos criados no universo”.

Link para o artigo completo na Nature: www.nature.com/nature/journal/v502/n7471/full/nature12569.html

Grafeno já era!… Conheça o Carbyno

Nota do tradutor: o nome “Carbyne” em inglês pode ter vários significados. No caso específico, “carbyne” se refere ao (teoricamente possível) poliacetileno (-C≡C-)n e eu chamei de “carbyno”, fazendo um aportuguesamento do termo em inglês, com “y” e tudo.

O tradutor também deseja enfatizar que observou que este “press-release” é exageradamente bombástico, ao descrever uma substância que, apesar de ser teoricamente possível, ainda não foi sintetizada em quantidades suficientes para testar na prática as qualidades apregoadas, e a “American Chemical Society” é chegada a apregoar “progressos” que acabam não dando em nada…

O novo campeão dos Carbonos

Os teóricos da Universidade Rice calculam que as cadeias de carbyno, com um átomo de espessura, pode ser o material mais forte que pode existir

|

||||

HOUSTON – (9 de outubro de 2013) – O Carbyno será o mais forte de toda uma nova classe de materiais microscópicos, quando e se alguém puder sintetizá-lo em grande escala.

Se conseguirem, vão descobrir que as nano-hastes ou nano-cordas têm uma pletora de propriedades notáveis e úteis, tal como descreve um novo artigo do físico teórico Boris Yakobson, da Universidade Rice, e seu grupo. O artigo será publicado nesta semana na publicação Nano da American Chemical Society.

O Carbyno é uma cadeia de átomos de carbono ligada por ligações, ou duplas, ou, alternadamente, simples e triplas. Isso o faz um material realmente unidimensional, diferentemente das folhas de grafeno, com um único átomo de espessura, que têm um topo e um fundo, ou nano-tubos ocos que têm um lado de dentro e outro de fora.

De acordo com o retrato traçado pelos cálculos de Yakobson e seu grupo:

- A resistência à tração – a capacidade de suportar o esticamento – supera “a de qualquer outro material conhecido” e é o dobro da do grafeno. (Os cientistas já calcularam que seria necessário um elefante, se equilibrando em cima de um lápis, para perfurar uma folha de grafeno)

- Seu módulo de elasticidade (Young) é o dobro do grafeno e dos nano-tubos de carbono, e cerca de três vezes o do diamante.

- Esticar o carbyno tão pouco como 10%, altera sua banda proibida (electronic band gap) significativamente.

- Se for dotado de alças moleculares em suas extremidades, também pode ser torcido para alterar sua banda proibida. Com uma rotação de 90 graus, ele se torna um semi-condutor magnético.

- Cadeias de carbyno podem receber moléculas colaterais, o que pode torná-las capazes de armazenar energia.

- O material é estável a temperatura ambiente, resistindo bem à reticulação com cadeias próximas.

Isto é um notável conjunto de qualidades para uma simples cadeia de átomos de carono, como diz Yakobson.

“Se pode encará-lo como uma fita de grafeno extremamente fina, reduzida a um único átomo, ou um nano-tubo extremamente fino”, diz Yakobson. Poderia ser útil para sistemas nano-mecânicos, em dispositivos spintrônicos, como sensores, como materiais leves e fortes para aplicações mecânicas, ou para armazenagem de energia.

“Quaisquer que sejam as aplicações”, prossegue ele, “em termos acadêmicos é muito instigante conhecer a mais forte molécula possível”.

Com base nos cálculos, ele declara que o carbyno pode ser o mais alto estado de energia possível para o carbono estável. “Usualmente nos preocupamos em encontrar o “estado fundamental“, a configuração de átomos com a menor energia possível”, explica Yakobson. “No caso do carbono, este seria a grafite, seguida pelo diamante, nano-tubos e, por fim, fulerenos. Porém, ninguém se pergunta sobre a mais alta configuração de energia. Acreditamos que esta possa sê-lo, uma estrutura estável com a maior energia possível”.

As teorias sobre o carbyno começaram a aparecer no século XIX e a primeira tentativa de sintetizá-lo foi feita na URSS em 1960. Desde então, o carbyno tem sido observado em grafite comprimida, foi detectado em poeira interestelar e foi criado em pequenas quantidades pelos cientistas experimentais.

“Eu sempre me interessei pela estabilidade de fios ou qualquer outra coisa extremamente finos, e o quão fina uma haste se pode fazer com uma determinada substância química”, diz Yakobson. “Nós publicamos um artigo, há 10 anos, sobre silício, no qual explorávamos o que acontece com um nano-fio de silício na medida em que fica mais fino. Para mim, isto era apenas parte da mesma pergunta”.

Os pesquisadores da Rice, sob a liderança do estudante de pós-graduação Mingjie Liu e o pesquisador pós-doutorado Vasilii Artyukhov, tinham conhecimento de vários artigos que descreviam uma ou outra propriedade do carbyno. Eles se dispuseram a detalhar o carbyno com modelos de computação, usando regras de lógica de primeira ordem pra estabelecer as interações energéticas dos átomos, segundo Artyukhov.

|

||||

“Nossa intenção era reunir tudo, construir um quadro mecânico completo do carbyno como material”, disse Artyukhov. “O fato dele ter sido observado nos diz que ele ao menos é estável sob tensão, senão simplesmente teria sido destruído”.

Yakobson diz que os pesquisadores ficaram surpresos em encontrar uma fixa proibida no carbyno tão sensível à torção. “Ele vai ser útil como um sensor para torção ou campos magnéticos, se conseguirmos um meio de fixá-lo a alguma coisa que o faça se enrolar”, diz ele. “Nós não estávamos procurando especificamente por isto; foi algo que surgiu como um produto colateral”.

“Isso é o que é bom em estudar as coisas cuidadosamente”, acrescenta Artyukhov.

Outra descoberta de grande interesse é a barreira de energia que impede os átomos em cadeias de carbono adjacentes de colapsarem umas sobre as outras. “Quando se fala de material teórico, é sempre bom ser cuidadoso para verificar se ele reage com ele próprio”, diz Artyukhov. “Isto nunca tinha sido realmente investigado para o carbyno”.

A literatura parecia indicar que o carbyno “não era estável e se desfaria em grafite ou fuligem”, diz ele.

Ao contrário, os pesquisadores descobriram que os átomos de carbono em cadeias separadas poderiam sobrepujar a barreira em um ponto, mas a rigidez das hastes iria impedir que elas se juntassem em outro local, ao menos em temperatura ambiente. “Iriam ficar parecidas com asas de borboleta”, disse Artyukhov.

“Novelos poderiam ficar grudados, mas não colapsariam inteiramente”, acrescenta Yakobson. “Isso poderia criar uma rede, altamente porosa e randômica, que poderia ser boa para adsorção”. Artyukhov diz que a área específica do carbyno é cerca de cinco vezes a do grafeno.

[Nota do tradutor: Alerta para hype escandaloso!] Quando o artigo da equipe ficou disponível neste verão nos arXiv, os noticiários científicos e mesmo alguns noticiários populares ficaram tão entusiasmados com os cálculos que começaram a especular sobre o artigo e suas implicações, antes que a equipe o submetesse à revisão por pares. Agora que o artigo inteiro está pronto para a publicação, os pesquisadores dizem que vão levar suas investigações em novas direções.

Eles estão examinando mais rigorosamente a condutividade do carbyno e cogitando também sobre outros elementos. “Conversamos sobre examinarmos diferentes elementos da tabela periódica para ver se alguns deles podem formar cadeias unidimensionais”, disse Yakobson.

O estudante de pós-graduação da Rice, Fangbo Xu e o ex-pesquisador pós-doutorado, Hoonkyung Lee, agora professor da Universidade Konkuk na Coréia do Sul, são os co-autores do artigo.

Extrato do artigo em http://pubs.acs.org/doi/abs/10.1021/nn404177r

O prêmio Nobel de Física de 2013

Comitê do Nobel também menciona os experimentos do Large Hadron Collider como confirmação da partícula de Higgs.

(ISNS) – O Prêmio Nobel de Física de 2013 foi concedido ao cientista belga François Englert e ao cientista britânico Peter W. Higgs “pela descoberta teórica de um mecanismo que contribui para nossa compreensão da origem da massa das partículas subatômicas e que foi recentemente confirmado pela descoberta da partícula fundamental prevista, pelos experimentos ATLAS e CMS do Large Hadron Collider do CERN”.

Em 1964, Englert, em conjunto com um colega já falecido, Robert Brout, e Higgs publicaram, independentemente, artigos que davam uma explicação sobre como algumas partículas subatômicas, tais como elétrons e quarks, adquirem massa. Segundo seu trabalho teórico, essas partículas intergiriam com um campo invisível, existente no universo, agora conhecido como o Mecanismo de Higgs, para adquirirem suas massas. Em 4 de julho de 2012, dois grupos de pesquisas no Large Hadron Collider (LHC), no laboratório do CERN de física de partículas na Europa anunciaram a detecção de uma partícula que, como mais tarde foi confirmado, vem desse campo invisível.

“Ambos [os teóricos] fizeram uma contribuição para a explicação da origem da massa e estas contribuições não podem ser individualizadas. Afinal, o que eles fizeram foi essencial para o Modelo Padrão da Física de Partículas”, declarou Olga Botner, da Universidade de Uppsala na Suécia, ao anunciar o prêmio.

“Não surpresa alguma”, comento Drew Baden, um físico da Universidade de Maryland, em College Park, “e é uma história realmente interessante”.

Há cinquenta anos, os físicos enfrentavam um enorme problema. Eles sabiam que o universo era composto por partículas fundamentais, tais como elétrons, prótons e nêutrons, que serviam como peças para a montagem da matéria. Estas partículas eram governadas por forças, tais como o eletromagnetismo, que as punham em movimento. Entretanto, este Modelo Padrão da física de partículas tinha sérias limitações. Ele não podia explicar porque alguns objetos — tais como os elétrons — tinham massa e outros, tais como os fótons, não tinham. Pelo Modelo Padrão de 1963, nada teria massa e zuniria pelo universo afora na velocidade da luz. Não seria possível a formação de átomos e moléculas e as estrelas, planetas, galáxias e as pessoas não poderiam existir.

É aí que entra em cena um grupo de teóricos — físicos que pretendem descrever a natureza através da matemática — para resolver o problema de porque certas partículas no universo têm massa, enquanto outras não.

A resposta veio com a percepção de que o universo está imerso em campos. Por exemplo, o campo eletromagnético permeia o espaço e faz com que objetos com carga positiva sejam atraídos por outros com carga negativa. As forças eletromagnéticas são exercidas entre os objetos através da troca de fótons.

Na década de 1960, vários teóricos descobriram independentemente que tinham a solução para o enigma das massas para o Modelo Padrão. A solução que eles apresentaram envolvia a existência de outro campo invisível, agora conhecido como Campo de Higgs. Algumas partículas, tais como os fótons, não são afetadas por ele enquanto o atravessam. Outras, tais como os elétrons, experimentam uma resistência a seu movimento, ou inércia, o que lhes confere massa.

“Até a descoberta do Higgs, não havia um fiapo de indício experimental”, comenta Baden, um físico da equipe do CMS no LHC. Em lugar disso, segundo ele, o conceito todo veio de uma solução matemática para um problema, que mostrava como as partículas poderiam adquirir massa.

Vários teóricos descobriram a solução de Higgs. Primeiro, Englert e seu colega Brout, publicaram um artigo que previa esse campo invisível. Peter Higgs, de maneira independente, publicou um artigo que previa que uma partícula, que veio a ser denominada Bóson de Higgs, poderia ser emitida pelo campo, tal como os fótons são emitidos pelo campo eletromagnético. Outro grupo de teóricos, Gerald Guralnik, C. Richard Hagen e Tom Kibble, porteriormente publicaram independentemente um artigo que predizia o mesmo mecanismo.

Baden disse que a premiação simultânea para Englert e Higgs “uma solução de compromisso muito bonita”, assim como o reconhecimento dos experimentais do LHC que detectaram a partícula. Englert e Higgs “puseram a bola em movimento” quanto à ideia da existência de um campo invisível que permeia o espaço.

Ao longo de décadas, o Higgs permaneceu como a peça que faltava no Modelo Padrão. Ele explciava porque algumas partículas fundamentais tinham massa. No entanto, ele era incrivelmente difícil de detectar. Segundo as previsões, o próprio Higgs tinha massa. E ele era muito pesado, muito mais pesado do que qualquer outra partícula fundamental até então detectada. Para extrair uma partícula do campo de Higgs é necessária uma enorme quantidade de energia.

Somente depois da construção pelo CERN do LHC que os físicos puderam extrair de modo confiável as partículas de Higgs desse campo invisível. O LHC começou a funcionar em 2008.

O LHC acelera feixes de 500 trilhões de prótons — as partículas positivamente carregadas do núcleo dos átomos — até 99,99999 % da velocidade da luz, ou seja, uma energia de 4 teraeletron-volts, ou TeV. É o equivalente à energia de um trem em disparada, concentrada em um raio de prótons subatômicos. O LHC esmaga dois desses feixes, um de encontro ao outro, para criar jorros de partículas. A famosa equação de Einstein, E=mc², diz que a energia pode ser convertida em massa e vice versa. A partir da pura energia dessa colisão, podem emergir novas partículas, totalmente diferentes dos prótons iniciais.

Em 4 de julho de 2012, os físicos das duas colaborações experimentais do LHC, ATLAS e CMS, anunciaram que tinham confirmado a existência de uma partícula parecida com o previsto Higgs. Sua massa aproximada era de 125 gigaelectron volts, ou GeV, muito maior do que qualquer outra partícula fundamental e cerca de 100 vezes mais pesada do que um próton. Durante o último ano, os cientistas confirmaram que partículas observada era mesmo o Higgs. Dados anteriores, obtidos pelo acelerador Tevatron do Laboratório Nacional Fermi, também confirmavam alguns indícios da existência desta partícula.

Porém, com a confirmação do Higgs, os enigmas do universo estão longe de estarem solucionados. Embora o Higgs possa ser a última peça principal do Modelo Padrão, os físicos entendem que o Modelo Padrão ainda está incompleto. Por exemplo, ele só descreve três das quatro forças fundamentais do universo e deixa de fora a gravidade.

“Em minha opinião, o principal e mais fundamental problema ainda não resolvido, apesar de alguns progressos, é o problema da gravidade quântica, a quantização da gravidade”, declarou Englert, em uma coletiva de imprensa, imediatamente após o anúncio do Prêmio Nobel de 2013.

Englert também lembrou as questões da supersimetria, matéria escura e energia escura, mistérios que ainda estão por resolver.

O Modelo Padrão somente descreve a matéria comum do universo, o que agora se supõe compreender apenas um quinto da matéria existente no universo. Ele não prevê a matéria escura invisível, nem a energia escura, que foram o objeto do Prêmio Nobel de Física em 2011.

Peter Higgs não foi entrevistado quando do anúncio do Nobel por estar em gozo de férias.

Então, os teóricos e experimentalistas continuam com um monte de questões para responder. As soluções para essas questões provavelmente serão objetos dos próximos Prêmios Nobel de Física.

Ben P. Stein, diretor do Inside Science, vem cobrindo a física como escritor de ciências e editor desde 1991.

Um novo tipo de microscópio: Microscópio de Nêutrons

Massachusetts Institute of Technology

Novo tipo de microscópio usa nêutrons

Dispositivo pode abrir novas áreas de pesquisa de materiais e de amostras biológicas em pequeníssimas escalas

|

O pequeno protótipo de microscópio de nêutrons da equipe, pronto para os testes iniciais no Laboratório do Reator Nuclear do MIT. Os espelhos do microscópio ficam dentro da pequena caixa de metal, acima e à direita. FOTO CORTESIA DOS PESQUISADORES (CLIQUE PARA AMPLIAR) |

Pesquisadores do MIT, em conjunto com seus parceiros da NASA, desenvolveram um novo conceito para um microscópio que usará nêutrons — partículas subatômicas sem carga elétrica — em lugar de feixes de luz ou de elétrons, para criar imagens de alta resolução.

Entre outras características, os instrumentos com base em nêutrons têm a capacidade de sondar o interior de objetos metálicos — tais como células combustíveis, baterias e motores, mesmo com estes em funcionamento — para aprender detalhes de sua estrutura interna. Os instrumentos de nêutrons também são peculiarmente sensíveis às propriedades magnéticas e aos elementos mais leves que são importantes em materiais biológicos.

O novo conceito foi delineado em uma série de artigos de pesquisas, neste ano, inclusive um publicado nesta semana em Nature Communications por Dazhi Liu, pesquisador pós-doutorado do MIT, Boris Khaykovich, cientista pesquisador, professor David Moncton e quatro outros.

Moncton, um professor adjunto de física de diretor do Laboratório do Reator Nuclear do MIT, diz que foi Khaykovich quem propôs em primeiro lugar a ideia de adaptar um conceito já com 60 anos de focalizar raios-X com o uso de espelhos, para o desafio de construir um microscópio de nêutrons de alto desempenho. Até agora, a maioria dos instrumentos de nêutrons eram semelhantes a uma câmera pinhole: sistemas grosseiros de imageamento que apenas deixavam a luz passar através de um pequeno orifício. Sem eficientes componentes ópticos, tais dispositivos produziam imagens fracas com pouca resolução.

Além do pinhole

“Para os nêutrons, não havia dispositivos de focalização de alta qualidade”, prossegue Moncton. “Essencialmente todos os instrumentos de nêutrons, desenvolvidos ao longo de meio século, eram efetivamente câmeras pinhole”. Com relação a este novo avanço, diz ele que “Estamos levando o campo de imageamento com nêutrons das câmeras pinhole para uma era de genuína óptica”.

“O novo dispositivo de espelhos funciona como a lente formadora de imagens de um microscópio óptico”, acrescenta Liu.

Uma vez que os nêutrons interagem minimamente com a matéria, é difícil focalizar feixes deles para criar um telescópio ou microscópio. No entanto, em 1952 Hans Wolter propôs um conceito básico para raios-X, que foi mais tarde desenvolvido, sob os auspícios da NASA, para telescópios tais como o Observatório Espacial Chandra de Raios-X (projetado e gerenciado pelos cientistas do MIT). Feixes de nêutrons interagem fracamente, de forma muito semelhantes aos raios-X, e podem ser focalizados por um sistema óptico similar.

É um fato bem conhecido que a luz pode ser refletida por superfícies normalmente não refletivas, contanto que incidam sobre tal superfície em um ângulo bem aberto; isto é o princípio físico básico por trás das miragens dos desertos. Usando o mesmo princípio, espelhos com certos revestimentos podem refletir nêutrons incidentes em ângulos abertos.

Um dispositivo menor e mais preciso

O instrumento atual emprega vários cilindros refletores, aninhados um no interior do outro, de forma a aumentar a área de superfície disponível para a reflexão. O dispositivo resultante pode melhorar o desempenho dos sistemas de imageamento por nêutrons existentes por um fator de cerca de 50, segundo os pesquisadores — o que permite imagens mais nítidas, instrumentos muito menores, ou ambas as coisas.

A equipe primeiro projetou e otimizou o conceito digitalmente, então fabricou um pequeno instrumento de teste como prova-de-conceito, e demonstrou seu desempenho, usando uma instalação de feixe de nêutrons no Laboratório do Reator Nuclear do MIT. Trabalhos posteriores que necessitavam de um espectro de energias de nêutrons diferente, foram realizados no Laboratório Nacional Oak Ridge (ORNL) e no Instituto Nacional de Padrões e Tecnologia (NIST).

Um tal instrumento poderia ser usado para observar e caracterizar vários tipos de materiais e amostras biológicas; outros processos, não geradores de imagens, que exploram a dispersão de nêutrons, poderiam ser também beneficiados. Uma vez que os feixes de nêutrons têm energia relativamente baixa, eles são “uma sonda de dispersão muito mais sensível”, segundo Moncton, para fenômenos tais como “de que forma os átomos ou os momentos magnéticos se movem dentro de um material”.

Os pesquisadores planejam, a seguir, a construção de um sistema otimizado de microscopia a nêutrons em colaboração com o NIST, que já dispõe de uma grande instalação de pesquisas com feixes de nêutrons. Este novo instrumento deve custar uns poucos milhões de dólares.

Moncton sublinha o fato de que um recente avanço importante neste campo foi a construção de uma instalação de US$ 1,4 bilhões que provê um aumento de dez vezes no fluxo de nêutrons. “Dado o custo da produção dos feixes de nêutrons, é essencial equipá-los com o sistema óptico mais eficiente possível”.

Roger Pynn, um cientista de materiais da Universidade da Califórnia em Santa Barbara, que não esteve envolvido nesta pesquisa, diz que “Eu esperava que isso levasse a algumas grandes novidades no imageamento por nêutrons… Isso apresenta o potencial para algumas aplicações realmente novas da dispersão de nêutrons — algo que não é visto há algum tempo”.

Além dos pesquisadores do MIT, a equipe inclui Mikhail Gubarev e Brian Ramsey do Centro Marshall de Voo Espacial da NASA, e Lee Robertson e Lowell Crow do ORNL. O trabalho foi financiado pelo Departamento de Energia do Governo dos EUA.

Uma estrela com dupla personalidade

National Radio Astronomy Observatory

Estrela imita ‘O médico e o Monstro” e fica alternando entre pulsar de rádio para pulsar de Raios-X e de volta

|

|

||||

Os astrônomos descobriram um estranho caso de uma estrela de nêutrons com a peculiar habilidade de se transformar de um rádio pulsar para um pulsar de raios-X e ficar alternando de uma para a outra. O comportamento caprichoso dessa estrela parece ser alimentado por uma estrela acompanhante próxima e pode fornecer novos conhecimentos sobre o nascimento de pulsares em milissegundos.

“O que vemos é uma estrela que é o equivalente cósmico de ‘O médico e o Monstro’, com a capacidade de mudar de uma forma para sua contraparte mais intensa, em uma velocidade espantosa”, declarou Scott Ransom, um astrônomo do National Radio Astronomy Observatory (NRAO) em Charlottesville, Virgínia. “Embora já soubéssemos que binárias [emissoras] de raios-X – algumas das quais são observadas como pulsares de raios-X – possam evoluir ao longo de milhões de anos e se tornarem pulsares de rádio que giram extremamente rápido, fomos surpreendidos ao encontrar uma que parecia oscilar de uma para outra rapidamente”.

Estrelas de nêutrons são os remanescentes super densos de estrelas massivas que explodiram como supernovas. Esta estrela de nêutrons em particular, catalogada como IGR J18245-2452, fica a aproximadamente 18.000 anos-luz da Terra, na constelação de Sagitário, em um aglomerado de estrelas conhecido como M28. Ela tinha sido inicialmente identificada como um radio pulsar de milissegundo em 2005 com o Telescópio Robert C. Byrd de Green Bank Telescope (GBT) e, posteriormente, foi redescoberta como um pulsar de raios-X por outra equipe de astrônomos em 2013. Eventualmente, as duas equipes perceberam que estavam observando o mesmo objeto, muito embora ele estivesse se comportando de maneira bem diferente, dependendo de quando era observado. Observações adicionais e dados de arquivo de outros telescópios acabaram por confirmar o ciclo “liga-desliga” de raios-X e pulsos de rádio.

“Várias observações desta estrela em particular, ao longo dos anos e com diferentes telescópios, revelaram coisas tremendamente diferentes – certas vezes era um pulsar e outras, uma binária de raios-X”, declarou Alessandro Papitto do Consejo Superior de Investigaciones Cientificas – Institut d’Estudis Espacials de Catalunya, em Barcelona, Espanha, o autor principal de um artigo publicado na Nature. “Isso era particularmente intrigante, uma vez que binárias de raios-X não emitem pulsos de rádio e a fonte de emissão de raios-X tem que se ter esgotado muito antes que os sinais de rádio possam emergir”.

A resposta para este enigma foi descoberta na complexa interação entre a estrela de nêutrons e sua acompanhante próxima.

|

|

||||

As binárias de raios-X, como seu nome implica, ocorrem em um sistema de duas estrelas no qual uma estrela de nêutrons é acompanhada por outra estrela normal de pequena massa. A estrela de nêutrons – menor mas consideravelmente mais massiva – pode arrancar material de sua companheira, formando um disco achatado de gás em torno da estrela de nêutrons. Gradualmente, na medida em que esse material mergulha para a superfície da estrela de nêutrons, ele fica superaquecido e gera uma intensa emissão de raios-X.

Os astrônomos acreditavam que esse processo de acreção continuava, sem interrupções por milhões de anos a fio. Eventualmente, o material se esgotava e a acreção parava, juntamente com a emissão de raios-X.

Sem o influxo de material novo, os poderosos campos magnéticos da estrela de nêutrons se tornavam capazes de emitir feixes de ondas de rádio que varrem o espaço enquanto a estrela gira, dando ao pulsar sua característica aparência de um farol.

A maioria dos rádio pulsares gira umas poucas dezenas de vezes por segundo e – se deixados por sua própria conta – vão se desacelerando ao longo de muitos milhares de anos. No entanto, no caso em que a estrela de nêutrons comece sua existência como uma binária de raios-X, a matéria que se acumula sobre sua superfície faz com que a estrela de nêutrons acelere a rotação, até que esteja girando a centenas de vezes a cada segundo. Quando o processo de acreção para, o resultado é um pulsar de milissegundos.

Durante suas observações, os pesquisadores detectaram súbitas emissões de pulsos de raios-X que duravam aproximadamente um mês e paravam abruptamente. Dentro de alguns dias, os pulsos de rádio recomeçavam. Essas oscilações abruptas indicavam que o material do disco de acreção estava caindo na estrela de nêutrons em catadupas, em lugar do fluxo longo e constante teorizado pelos astrônomos.

Um estudo anterior de outro sistema com o GBT detectou o primeiro indício de um disco de acreção em torno de uma estrela de nêutrons, o que ajudou a estabelecer a ligação entre binárias de raios-X de pequena massa e pulsares.

Os novos dados apoiam esta ligação, mas também mostram pela primeira vez que o processo de evolução, que se pensava levar alguns milhões de anos, é na verdade mais complexo e pode ocorrer de forma abrupta e episódica, em fenômenos que podem durar apenas dias ou semanas. “Isto não só demonstra a ligação evolutiva entre a acreção e os pulsares acelerados de milissegundos”, observa Ransom, “mas também que alguns sistemas podem alternar entre os dois estados em escalas de tempo muito curtas”.

A fonte de raios-X foi descoberta pelo International Gamma-Ray Astrophysics Laboratory (INTEGRAL) e as subsequentes observações em raios-X foram realizadas pelos satélites XMM-Newton, Swift e Chandra. As observações de rádio foram feitas pelo GBT, o rádio-telescópio Parkes, o Australia Telescope Compact Array e o Westerbork Synthesis Radio Telescope.

O National Radio Astronomy Observatory é uma instalação da National Science Foundation, operada em cooperativa pela Associated Universities, Inc.

A atividade humana afeta a estrutura vertical da atmosfera

Original em inglês por Anne M Stark, LLNL.

|

|

|

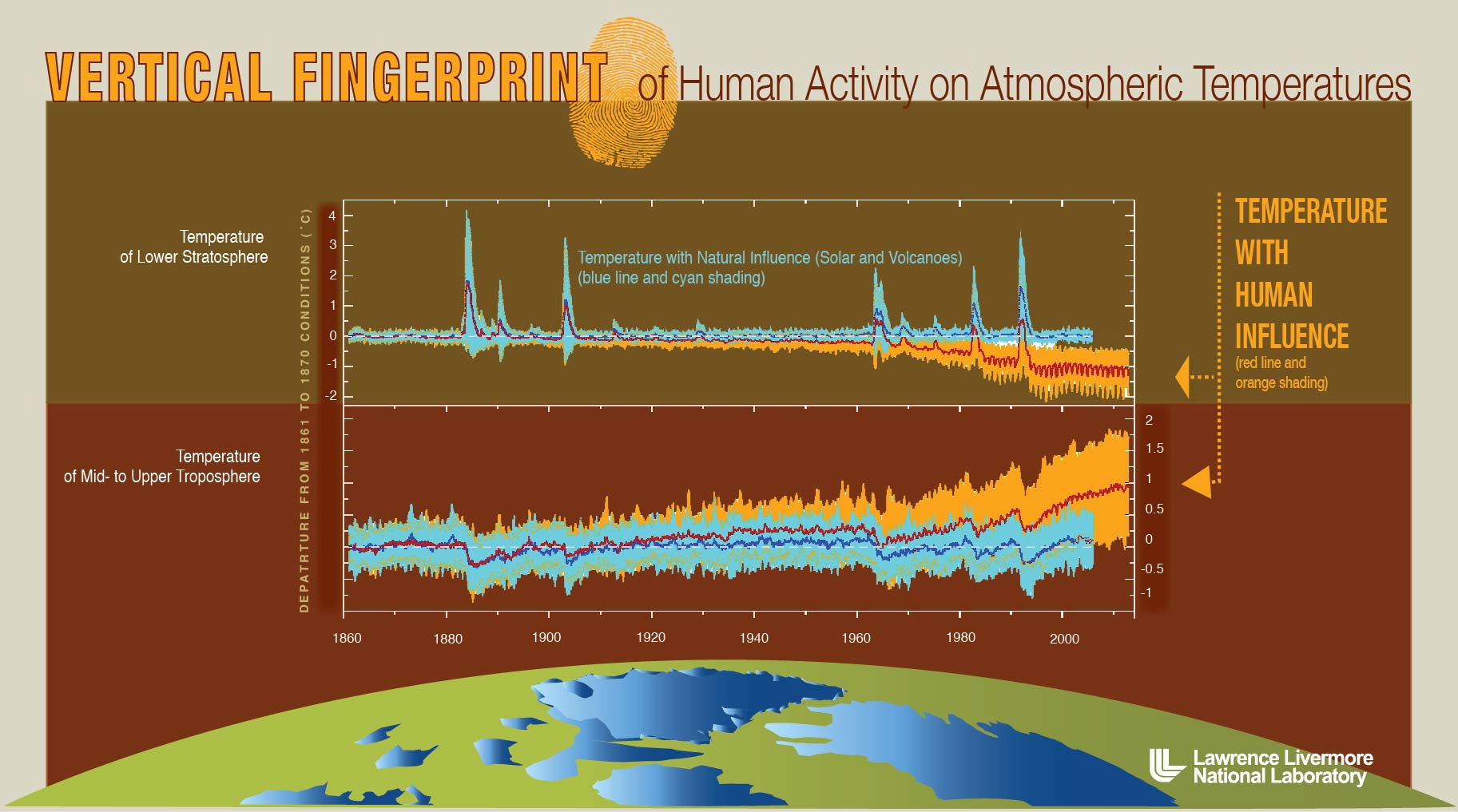

Representação gráfica das “digitais” – tanto das atividades humanas, quanto as da natureza – sobre a estrutura vertical da atmosfera. As mudanças decorrentes das atividades humanas, tais como a produção acelerada de gases de efeito estufa, faz com que a estratosfera esfrie, enquanto a troposfera, do meio para cima, se aqueça. Um novo estudo comprova que as influências naturais não poderiam causar sozinhas essas mudanças de temperaturas. Crédito da imagem: Lawrence Livermore National Laboratory. (Imagem ampliada) |

As influências das atividades humanas causaram um impacto direto no padrão latitude/altitude da temperatura atmosféricas. Esta é a conclusão de um novo relatório apresentado pelos cientistas do Lawrence Livermore National Laboratory e seis outras instituições científicas. A pesquisa compara vários registros feitos por satélites de mudanças nas temperaturas atmosféricas com os resultados de simulações computadorizadas de grande tamanho e vários modelos.

“A atividade humana tem efeitos muito diferentes sobre as temperaturas da atmosfera superior e inferior, e uma digital muito diferente das influências puramente naturais”, afirma Benjamin Santer, o principal autor do artigo publicado na edição de 16 de setembro de Proceedings of the U.S. National Academy of Sciences. “Nossos resultados fornecem indícios claros de uma distinta influência humana sobre a estrutura térmica da atmosfera”.

Os dados das observações por satélites e as previsões do modelo de computação da resposta à influência humana têm um padrão comum de latitude/altitude de mudanças da temperatura atmosférica. As características principais desse padrão são, em escala global, o aquecimento da troposfera e o resfriamento da estratosfera, ao longo dos registros dos satélites por 34 anos. (A troposfera é a parte mais baixa da atmosfera da Terra. A estratosfera fica acima da troposfera.)

“Os atuais modelos climáticos provavelmente não são capazes de produzir este padrão de sinal distinto, somente pela variabilidade interna, ou em resposta a mudanças causadas por fenômenos naturais, tais como variações na radiação solar, ou aerossóis espalhados por erupções vulcânicas”, diz Santer.

As flutuações internas naturais no clima são geradas por complexas interações no sistema atmosfera-oceano, tais como o bem conhecido El Niño. As influências externas incluem mudanças causadas pelas atividades humanas, tais como os gases de efeito estufa, camada estratosférica de ozônio e outros agentes sobre as radiações, assim como flutuações de origem puramente natural na radiação solar e os aerossóis vulcânicos. Cada uma dessas influências deixa uma “digital” inconfundível no padrão detalhado por latitude/altitude de mudanças na temperatura atmosférica.

A informação das digitais se comprovou particularmente útil para separar as influências climáticas das atividades humanas, solares e vulcânicas.

“O padrão de mudanças de temperaturas que foi observado no sentido vertical na atmosfera, desde o nível do chão até a estratosfera, se ajusta ao que era esperado da atividade humana de emissão de gases de efeito estufa. O mesmo padrão entra em conflito com o que seria de se esperar de outras explicações, tais como flutuações na emissão de radiações pelo Sol”, explica Santer.

Outra pesquisadora do LLNL, co-autora do artigo, Celine Bonfils, observa que grandes erupções vulcânicas também podem perturbar profundamente a estrutura vertical da temperatura atmosférica. “Durante o período de recuperação de tais erupções, também acontecem o aquecimento da troposfera e o resfriamento da estratosfera”, diz ela. “Porém, de forma diferente das influências vulcânicas, as mudanças de temperaturas atmosféricas causadas pela atividade humana afetam todas as latitudes e duram mais tempo. Isto sugere que as recentes mudanças de temperaturas não são uma simples recuperação de eventos vulcânicos passados”.

Os outros cientistas do Livermore incluem Jeff Painter, Peter Gleckler, Charles Doutriaux e Karl Taylor. A equipe de pesquisadores contou ainda com cientistas do Remote Sensing Systems (Carl Mears e Frank Wentz), do Massachusetts Institute of Technology (Susan Solomon), da Universidade de Adelaide, Austrália (Tom Wigley), do NASA/Goddard Institute of Space Studies (Gavin Schmidt), do Canadian Centre for Climate Modelling and Analysis (Nathan Gillett) e do Nansen Environmental and Remote Sensing Center, Noruega (Peter Thorne).

Primeira medição experimental da carga fraca do próton

Carga Fraca do Proton é Medida pela Primeira Vez

O Q-weak do Jefferson Lab mediu a carga fraca do próton.

NEWPORT NEWS, Virgínia, 17 de setembro de 2013 — Pesquisadores realizaram a primeira medição experimental da carga fraca do próton em uma pesquisa realizada na Instalação Nacional do Acelerador de Partículas Thomas Jefferson do Departamento de Energia do Governo dos EUA (Jefferson Lab).

Os resultados, aceitos para publicação em Physical Review Letters, também inclui medições da carga fraca do nêutron e dos quarks up e down. Essas medições foram feitas mediante a combinação dos novos dados obtidos com dados publicados por outros experimentos. Embora estas medições preliminares sejam as medições mais precisas até hoje feitas, elas foram obtidas a partir da análise de apenas 4% do total dos dados coletados pelo experimento; a análise completa dos dados deverá levar mais um ano para ser completada.

A força fraca é uma das quatro forças fundamentais do nosso universo, junto com a gravidade, o eletromagnetismo e a força forte. Muito embora a força fraca só atue no nível subatômico, seus efeitos podem ser observados em nosso mundo do dia a dia. A força fraca desempenha um papel fundamentas nas reações nucleares que ocorrem dentro das estrela e são responsáveis por grande parte da radiação natural existente no universo.

O experimento Q-weak foi projetado por um grupo internacional de físicos nucleares que se reuniram há mais de uma década para propor uma nova medição no Jefferson Lab. Eles propuseram a primeira medição direta da carga fraca do próton, denotada pelo símbolo  – ou seja, a intensidade do puxão exercido pela força fraca dentro do próton, ou, em outras palavras, o quanto o próton interage através da força fraca. Uma vez que a carga fraca do próton é uma quantidade precisamente prevista pelo Modelo Padrão – o arcabouço teórico (porém bem testado) que descreve as partículas elementares e detalha como elas interagem – ela se torna um parâmetro ideal para medir experimentalmente a exatidão do Modelo Padrão.

– ou seja, a intensidade do puxão exercido pela força fraca dentro do próton, ou, em outras palavras, o quanto o próton interage através da força fraca. Uma vez que a carga fraca do próton é uma quantidade precisamente prevista pelo Modelo Padrão – o arcabouço teórico (porém bem testado) que descreve as partículas elementares e detalha como elas interagem – ela se torna um parâmetro ideal para medir experimentalmente a exatidão do Modelo Padrão.

Para realizar o experimento, os cientistas direcionaram um feixe muito intenso de elétrons para dentro de um contentor de hidrogênio líquido. Os elétrons foram polarizados longitudinalmente (girando ao longo ou em sentido contrário de seu movimento). Os elétrons que apenas resvalavam nos prótons (dispersão elástica, onde o próton permanece intacto), emergiam em pequenos ângulos e eram defletidos por poderosos eletromagnetos em oito detectores simetricamente dispostos.

A força fraca é muito mais fraca do que a eletromagnética. Em termos clássicos, se pode pensar nisso como para cada milhão de elétrons que interajam com os prótons através da força eletromagnética, apenas um vai interagir através da força fraca. Os físicos mediram essas poucas interações fracas, explorando uma importante diferença entre as duas forças – a força fraca viola um tipo de simetria conhecido como paridade, pela qual nosso universo “destro”, mediante a rotação de todas as direções espaciais, se torna “canhoto”. Em um mundo de paridade oposta, os elétrons que giram com seus eixos ao longo da direção de seu movimento, interagem como os prótons através da força eletromagnética, com a mesma intensidade. Quando a interação é através da força fraca, os elétrons com spin “destrógiro” interagem de forma diferente dos “levógiros”. Quando se mantém todos os demais parâmetros do experimento inalterados e somente a polarização do feixe de elétrons é revertida, os cientistas podem usar a diferença, ou “assimetria” das medições entre as duas polarizações para isolar o efeito da interação fraca. A meta é medir esta diferença, na faixa de ~200 partes por bilhão, tão precisamente como possível. Essa precisão é equivalente a medir a espessura de uma folha de papel no alto da Torre Eifel.

A análise inicial dos dados da experiência Q-weak deram um valor para  que está bem de acordo com a previsão do Modelo Padrão. No entanto, a colaboração dispõe de 25 vezes mais dados do que os usados nessa medição inicial. O resultado final deverá fornecer um rigoroso teste experimental para o Modelo Padrão, fornecendo novas restrições para a nova física nas escalas de energia que estão sendo exploradas no LHC do CERN.

que está bem de acordo com a previsão do Modelo Padrão. No entanto, a colaboração dispõe de 25 vezes mais dados do que os usados nessa medição inicial. O resultado final deverá fornecer um rigoroso teste experimental para o Modelo Padrão, fornecendo novas restrições para a nova física nas escalas de energia que estão sendo exploradas no LHC do CERN.

“Os leitores devem encarar esses resultados primeiramente como uma medição da carga fraca do próton. Nossa publicação definitiva será focalizada nas implicações a respeito de potenciais novidades na física”, diz Roger Carlini, um cientista do staff do Jefferson e porta-voz da colaboração Q-weak.

O experimento Q-weak foi originalmente aprovado em janeiro de 2002. Um período de instalação de quase um ano, começou em 2009, seguido por um período de dois anos de coleta de dados de 2010 a 2012.

Várias conquistas técnicas na década passada tornaram este experimento possível. Estas incluem o feixe de elétrons de alta corrente, alta polarização e extremamente estável produzido pelo Acelerador Contínuo de Feixe de Elétrons do Jefferson Lab; o alvo de hidrogênico criogênico com a maior potência no mundo; detectores Cerenkov com extrema resistência à radiação; circuitos eletrônicos com ruído ultra baixo para a leitura dos sinais e medição precisa da corrente do feixe; e um sistema que mede a polarização do feixe com uma precisão melhor que 1%, usando um laser backscatter. Estas inovações técnicas permitiram a obtenção de uma incerteza assombrosamente pequena de 47 partes por bilhão para os dados divulgados até agora.

A colaboração Q-weak consiste de 97 pesquisadores de 23 instituições nos EUA, Canadá e Europa. O experimento foi financiado pelo Escritório de Ciências do Departamento de Energia do governo dos EUA, pela Fundação Nacional de Ciências dos EUA e pelo Conselho de Pesquisas de Ciências Naturais e Engenharia do Canadá. Também contribuíram as seguintes universidades: The College of William and Mary, Virginia Tech, George Washington University e Louisiana Tech University. Apoio técnico de TRIUMF, MIT/Bates e Jefferson Lab.

Os resultados serão publicados na edição de 13 de outubro (online) e 18 de outubro (impressa) da Physical Review Letters.

Qual será o formato do Universo?

Dados deixam em aberto a possibilidade de um Universo curvo

Crédito da imagem: NASA

Indícios dos ecos do Big Bang podem sugerir um universo em forma de sela.

11 de setembro de 2013

Original em inglês por: Charles Q. Choi, Contribuidor do ISNS Contributor

Charles Q. Choi é um escritor independente da cidade de Nova York que já escreveu para The New York Times, Scientific American, Wired, Science, Nature e vários outros noticiosos.

Armazenar energia “verde” compensa?

Cientistas de Stanford calculam a energia necessária para armazenar energia eólica e solar na rede

As baterias de armazenamento convencionais são boas para “fazendas” de energia solar (em larga escala), mas são necessários aperfeiçoamentos tecnológicos para o armazenamento da energia eólica, dizem os cientistas de Stanford.

Original (em inglês) por MARK SHWARTZ

A energia de fontes renováveis é a grande esperança para que se torne possível reduzir as emissões de dióxido de carbono. Mas há ocasiões onde as “fazendas” solares e eólicas geram mais energia do que a demanda requer. Armazenar essa energia excedente para futuro emprego parece uma solução óbvia, porém um novo estudo da Universidade Stanford sugere que essa solução nem sempre se aplica.

“Examinamos as baterias e outras tecnologias promissoras para o armazenamento da energia solar e eólica na rede elétrica”, explica Charles Barnhart, o principal autor do estudo e doutor-pesquisador no projeto da Stanford Global Climate and Energy Project (GCEP).

“Nossa meta principal foi calcular o custo energético total – ou seja, a quantidade total de combustível e eletricidade necessários para construir e fazer funcionar essas tecnologias de armazenamento. Descobrimos que, quando se computa os custos energéticos, baterias em escala de rede só fazem sentido para armazenar energia solar excedente, mas não a eólica”.

O estudo, financiado pelo GCEP, foi publicado na edição online de Energy and Environmental Science.

Mudanças climáticas e energia renovável

A maior parte da energia elétrica nos Estados Unidos é gerada em usinas que funcionam a base de carvão e gás natural – combustíveis fósseis que contribuem de maneira significativa para o aquecimento global através da emissão de grandes quantidades de dióxido de carbono. As energias solar e eólica não geram emissões e são fontes renováveis, mas são dependentes da luz solar e dos ventos para funcionarem.

“Para que a rede funcione eficientemente, a geração de energia precisa se adequar à demanda sempre, porém, no caso das fontes renováveis, nem sempre é o caso”, prossegue Barnhart. “Por exemplo, as fazendas de ventos algumas vezes produzem eletricidade demais à noite, quando a demanda é pequena. Este excesso de energia tem que ser armazenado ou usado em outro lugar, senão, será desperdiçado. No entanto, a rede de energia dos Estados Unidos tem uma capacidade de armazenagem muito limitada”.

Uma grande variedade de tecnologias está sendo desenvolvida para resolver essa deficiência de capacidade de armazenagem de energia na rede. A equipe de Stanford avaliou várias tecnologias emergentes, inclusive cinco tipos de baterias – ácido-chumbo, íon de lítio, sódio-enxofre, vanádio-redox e zinco-bromo.

Em um estudo anterior, Barnhart calculou o custo energético para a construção e manutenção de cada um dos cinco sistemas de baterias para armazenagem em escala da rede. Ele descobriu que as baterias ácido-chumbo eram as de maior custo energético, enquanto as de íon de lítio eram as de menor.

“Calculamos quanta energia é empregada ao longo de todo o ciclo de vida da bateria – desde a mineração das matérias primas, até a instalação do dispositivo pronto”, explica Barnhart. “As baterias com maior custo energético são aquelas são as que mais consumem combustíveis fósseis e, portanto, são responsáveis pelas maiores emissões de dióxido de carbono ao longo de seu tempo de vida. Se o custo energético de uma bateria for alto demais, sua contribuição para o aquecimento global pode neutralizar os benefícios que a fazenda solar ou eólica – cujo funcionamento ela deveria apoiar – possam gerar”.

Para o presente estudo, ele e seus colegas calcularam o custo energético de células solares fotovoltáicas e turbinas elólicas na escala da rede.

“Tanto as turbinas eólicas quanto as células fotovoltaicas produzem mais energia que o necessário para construí-las e mantê-las”, diz o doutor-pesquisador do GCEP Michael Dale, um co-autor do estudo. “No entanto, nossos cálculos mostraram que o custo energético global das turbinas eólicas é muito menor do que o dos painéis solares convencionais, os quais requerem uma grande quantidade de energia, fundamentalmente de combustíveis fósseis, para o processamento do silício e a fabricação de outros componentes”.

É melhor armazenar ou desligar?

A seguir, os cientistas examinaram os custos energéticos do desligamento dos painéis solares e turbinas eólicas para não permitir a geração de um excesso de energia para a rede.

“O desligamento de fontes de energia renovável parece um desperdício”, diz Barnhart. “Porém os operadores da rede rotineiramente desligam turbinas eólicas para evitar um excesso súbito e inesperado de geração de eletricidade que poderia causar uma sobrecarga nas linhas de transmissão e causar apagões. A frequência desses desligamentos nos EUA provavelmente vai aumentar, na medida em que as fontes de energia renováveis se tornem mais participantes”.

Desligar uma fonte de energia limpa pode parecer contra-intuitivo, mas será que armazenar o excesso de energia em baterias é uma alternativa prática?

Para descobrir, os pesquisadores compararam o custo energético do desligamento dos geradores solares e eólicos com o custo energético do armazenamento em grande escala na rede. Seus cálculos se basearam em uma fórmula conhecida como “retorno em energia sobre o investimento” – a quantidade de energia produzida por uma tecnologia, dividida pela quantidade de energia necessária para construir e manter essa tecnologia.

Usando esta formula, os pesquisadores calcularam que a quantidade de energia necessária para criar uma fazenda solar é comparável à energia usada para construir cada uma das cinco diferentes tecnologias de baterias de armazenamento. “O uso de bateria para armazenar energia solar durante os períodos de baixa demanda seria, portanto, favorável em termos energéticos”, afirma Dale.

Os resultados foram bem diferentes para as fazendas de ventos. Os cientistas descobriram que o desligamento das turbinas eólicas reduz o retorno do investimento em energia em apenas 10%. Porém o armazenamento dos eventuais excessos de energia elétrica gerada por turbinas eólicas resulta em reduções ainda maiores – desde cerca de 20% com baterias de íon de lítio, até mais de 50% com baterias de ácido-chumbo.

“Idealmente, o custo energético do deligamento de um sistema deveria ser ao menos igual ao custo de armazenagem”, explica Dale. “Este é o caso com as células fotovoltaicas, porém no caso das fazendas de ventos, o custo energético do desligamento é muito menor do que o de armazenagem com baterias. Assim, o desligamento de uma turbina eólica é mais eficiente em termos de economia de energia do que o custo de armazenagem de excessos”.

Ele faz a comparação com um cofre: “Não compensa gastar $100 em um cofre para guardar um relógio de $10”, diz ele. “Da mesma forma, não é sensato montar baterias energeticamente caras para armazenar uma energia cujo custo de produção é barato como o vento, embora faça sentido para sistemas de células fotovoltaicas que demandam muita energia em sua produção”.

Barnhart aduz que a maneira mais eficaz de melhorar o desempenho energético de uma bateria, seria aumentar sua vida útil. Baterias de íon de lítio convencionais duram cerca de quatro anos, ou 6.000 ciclos de carga-descarga. As baterias de ácido-chumbo duram apenas 700 ciclos. Para armazenar de maneira eficiente a energia para a rede, as baterias deveriam suportar entre 10.000 e 18.000 ciclos, segundo ele.

“Armazenar energia consome energia e desligar a fonte é um desperdício”, conclui Barnhart. “Em ambos os casos há uma redução no total do retorno energético do investimento”.

Outras opções

Além das baterias, os pesquisadores consideraram outras tecnologias para armazenamento de energia de fontes renováveis, tais como armazenamento por bombeamento para hidroeléticas, que usa a energia elétrica excedente para bombear água para um reservatório de uma barragem. Mais tarde, quando a demanda por energia crescer, a água armazenada é liberada através das turbinas da barragem para gerar eletricidade.

“O bombeamento de água é usado em 99% do armazenamento para a rede atualmente”, diz Barnhart. “Funciona incrivelmente bem, de um ponto de vista energético, tanto para energia solar como eólica. O retorno do investimento em energia é 10 vezes melhor do que o das baterias convencionais. Mas existem restrições geológicas e ambientais para o armazenamento da água bombeada”.

O armazenamento não é a única maneira de melhorar a confiabilidade da rede. “A energia que seria perdida em caso de excesso de produção, pode ser usada para bombear água para irrigação, ou para recarregar uma frota de veículos elétricos, por exemplo”, sugere Dale.

Barnhart acrescenta que é importante que a sociedade tenha consciência de como economizar energia, notadamente quanto à implementação de novas tecnologias. “Investidores e aqueles que tomam as decisões políticas precisam também considerar os custos energéticos, além dos financeiros, das novas tecnologias”, afirma ele. “Se a economia for o único fator considerado, as tecnologias mais baratas que necessitam significativas quantidades de energia para sua manufatura, manutenção e substituição, podem sair vencedoras – mesmo que elas ao fim e ao cabo aumentem as emissões de gases de efeito estufa e acabem por jogar fora todos os benefícios de longo prazo da implementação da geração de eletricidade por energia solar e eólica”.

“Nossa meta é compreender o que é necessário para construir um sistema energético com baixo rastro de carbono”, diz a co-autora Sally Benson, diretora do GCEP e professora de engenharia de recursos energéticos. “O retorno do investimento em energia é uma dessas métricas que alertam sobre prováveis obstáculos a frente. Temos esperança que este estudo forneça um padrão para desempenho que guie futuras pesquisas de armazenamento de energia em escala para a rede”.

Adam Brandt, um professor assistente de engenharia de recursos energéticos da Escola de Ciências da Terra em Stanford, também assina o estudo como co-autor.

Mark Shwartz escreve sobre ciências e tecnologias da energia para o Precourt Institute for Energy na Universidade Stanford.