A gravidade estica o tempo e limita os efeitos quânticos em escalas maiores.

(Inside Science) — O mundo se torna um lugar nebuloso e surreal em seus níveis mais elementares, de acordo com a física quântica. Tem sido um mistério o motivo pelo qual os estranhos comportamentos quânticos não são observados nas escalas maiores do cotidiano. Agora pequisadores acreditam que o modo como a Terra distorce o tempo pode explicar essa divisão.

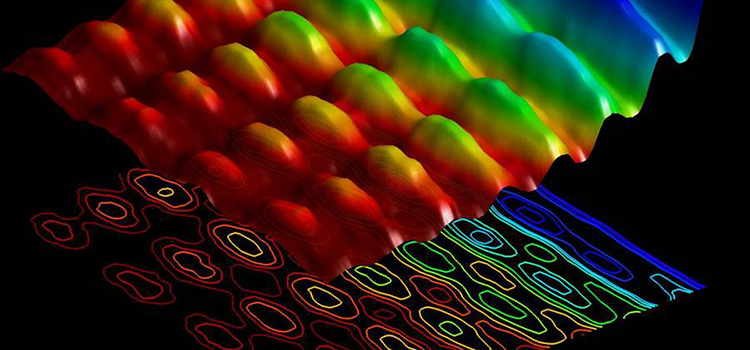

Uma das consequências desconcertantes da física quântica é que átomos e partículas subatômicas podem realmente existir em estados conhecidos como “superposições”, o que, por exemplo, significa que elas podem literalmente estar em dois ou mais lugares ao mesmo tempo, até que sejam “observadas” — ou seja, até que interajam com partículas em seu entorno de alguma forma. Este conceito é frequentemente ilustrado com uma analogia chamada de “Gato de Schrödinger“, no qual um gato está tanto vivo quanto morto, até que se verifique.

As superposições são extremamente frágeis. Uma vez que elas sejam perturbadas de alguma maneira, elas colapsam ou “perdem a coerência” para um único dos estados possíveis. Sendo assim, elas frequentemente envolvem apenas um máximo de umas poucas partículas — quanto maior for um objeto em estados superpostos, mais difícil será mantê-lo sem perturbações. No entanto, em qual escala termina o reino da física quântica e começa o da física clássica, e, mais ainda, por que existe esta fronteira, ainda é um mistério.

Agora pesquisadores sugerem que a teoria de espaço-tempo de Einstein pode ajudar essa mudança de física quântica para clássica, Os cientistas detalharam suas descobertas na edição online de 15 de junho da Nature Physics.

Há um século, a Teoria da Relatividade de Einstein explicou que a graviade decorre da curvatura do espaço-tempo provocada pela massa. Se visualizarmos várias bolas sobre uma folha de borracha, quanto mais massiva for uma bola, mais ela afunda a borracha e puxa as outras bolas para perto.

Uma consequência curiosa da Teoria da Relatividade é a dilatação do tempo, ou seja: o tempo passa mais devagar quanto mais próximo estivermos de um objeto massivo. Embora esse efeito na Terra seja pequeno, ainda é mensurável. “Se você vive no andar de cima de uma casa de dois andares, você vai envelhecer mais rápido que seu vizinho do térreo em cerca de 10 nanosegundos a cada ano”, diz o físico quântico Igor Pikovski do Centro de Astrofísica Harvard-Smithsonian. “Esse minúsculo efeito foi realmente confirmado em várias experiências com relógios muito precisos”.

Pikovski e seus colegas calcularam que, uma vez que os pequenos blocos de construção que compõem objetos maiores – tais como moléculas e, eventualmente, micróbios e partículas de poeira – se agrupem para formar tais objetos maiores, a dilatação do tempo experimentada no campor gravitacional da superfície da Terra pode suprimir as superposições. “Foi muito entusiasmante descobrir que a dilatação do tempo de Einstein pode ter influência”, declarou Pikovski.

A energia de um objeto o faz vibrar. De acordo com as leis da física quântica, quando um objeto está em superposição, todas as partes dele vibram em sincronia. No entando, a dilatação do tempo fará com que partes deste objeto que estejam em altitudes ligeiramente maiores, vibrem em frequências diferentes daqueles em menor altitude, da mesma forma como seu vizinho do andar de baixo vai envelhecer mais devagar que você. Quanto maior for a diferença de altutude entre as partes, maior será a defasagem. Para qualquer objeto suficientemente grande, essa defasagem será capaz de romper todas as superposições.

“Acho encantador ver novas ideias sobre a influência da gravidade em objetos quânticos” declarou o físico experimentar Holger Müller da Universidade da Califórnia em Berkeley, que não participou da pesquisa.

Para provar que este efeito ocorre, os cientistas precisam criar grandes objetos superpostos nos quais tenham suprimido todas as outras possíveis fontes de decoerência, tais como calor. Se a dilatação do tempo pode fazr colapsar as superposições, o limite de tamanho de um objeto superposto na Terra deve ser de cerca de um milímetro.

Müller declarou que a criação de um objeto superposto tão grande é pouqíssimo provável, uma vez que existem várias fontes potenciais para a decoerência, além da dilatação do tempo.

Pikovski foi mais otimístico: “Em princípio, deve ser possível superar essas limitações”, argumentou ele. “É apenas uma questão de tecnologia”. Ele sublinhou o fato de que, graças aos avanços tencológicos na criação de objetos em superposiçãos, os cientistas agora podem criar superposições em objetos do tamanho de milhares de átomos.

Tais descobertas sugerem que, fora do campo gravitacional da Terra, os cientistas sejam capazes de encontrar supeposições em objetos até maiores do que um milímetor, “Até agora, não encontramos nenhuma boa razão para crer que a teoria quântica seja quebrada”, afirma Pikovski.

Charles Q. Choi é um escritor de ciências freelance da cidade de Nova York que já escreveu artigos para The New York Times, Scientific American, Wired, Science, Nature e várias outras publicações. Ele tuíta em @cqchoi.

Nota do Tradutor

Estou “vendendo o peixe pelo preço que comprei”. Em outras palavras, por mais fascinante que a “explicação” proposta seja, eu vejo com muita reserva um efeito de dilatação temporal relativística na escala quântica, já que até o efeito da atração gravitacional é imperceptível nessa escala.

Pesquisadores e membros da colaboração CAST instalam seus equipamentos para alinhar o telescópio com a posição do Sol.

Pesquisadores e membros da colaboração CAST instalam seus equipamentos para alinhar o telescópio com a posição do Sol.