Energia eólica: limpa, mas nem tanto…

Traduzido de: Scientists Find Night-Warming Effect Over Large Wind Farms in Texas

![]()

As turbinas eólicas interagem com a camada limítrofe da atmosfera próxima à superfície

Em várias partes do Texas as “fazendas de vento” são numerosas; os cientistas relatam novos resultados sobre seus efeitos.

|

29 de abril de 2012

Grandes fazendas de ventos em certas áreas dos Estados Unidos parecem estar afetando as temperaturas de superfície locais, de acordo com um artigo publicado hoje em Nature Climate Change.

O estudo, liderado por Liming Zhou, um cientista atmosférico na State University of New York (SUNY) -Albany, fornece novos dados acerca dos possíveis efeitos das fazendas de ventos.

|

|

Localizações de centros de fazendas de ventos no Texas, até o ano de 2010. |

Os resultados podem ser importantes para o desenvolvimento de estratégias eficientes de adaptação e gerenciamento, para assegurar a sustentabilidade a longo prazo da energia eólica.

“Este estudo indica que as temperaturas de superfície aumentaram nas vizinhanças das grandes fazendas de ventos no centro-oeste do Texas, especialmente durante as noites”, declara Anjuli Bamzai, diretor de programa da Divisão de Ciências Atmosféricas e Geoespaciais da Fundação Nacional de Ciências (National Science Foundation = NSF), que financiou a pesquisa.

“As observações e análises se referem a um período de tempo relativamente curto, mas levantam importantes questões que merecem atenção, na medida em que nos dirigimos a uma era de rápido crescimento das fazendas de ventos em nossa busca por fontes alternativas de energia”.

Extensas pesquisas ligaram a produção de dióxido de carbono produzido pela queima de combustíveis fósseis com o aumento global das temperaturas.

|

|

Fazendas de ventos pontilham o horizonte do condado de Lubbock County e outras áreas do Texas. |

Em consequência, muitas nações estão dando preferência a fontes mais limpas de energia renovável, tais como turbinas eólicas. A energia eólica para geração de energia elétrica não cria emissões, não usa água e é considerada “verde”.

“Precisamos compreender melhor o sistema através de observações para poder descrever e criar modelos dos complexos processos envolvidos, para prever como as fazendas de ventos podem afetar futuramente as temperaturas e o clima”, disse Zhou.

O número de estudos sobre os efeitos das fazendas de ventos sobre o tempo e o clima vem crescendo, empregando principalmente modelos numéricos, devido á ausência de observações sobre as fazendas de ventos.

|

|

Um novo tipo de fazenda no Texas – uma fazenda de ventos. |

Uma vez que os modelos numéricos exigem grandes esforços de computação e apresentam incertezas na representação de tempo e clima locais, explicou Zhou, o sensoreamento remoto é provavelmente a maneira mais eficiente e eficaz para estudar os efeitos das fazendas de ventos em escalas espaciais e temporais maiores.

Para compreender o impacto potencial das fazendas de ventos nos tempo e clima locais, a equipe de Zhou analisou as temperaturas de superfície medidas pelos satélites em torno das grandes fazendas de ventos do Texas ao longo do período de 2003 a 2011.

Os pesquisadores encontraram um efeito de aquecimento noturno nas áreas de fazendas de ventos da ordem de 0.72°C por década, ao longo do período de 9 anos de coleta de dados.

Uma vez que o padrão do aquecimento espelha a distribuição geográfica das turbinas eólicas, os cientistas atribuem esse aquecimento diretamente às fazendas de ventos.

|

|

Uma fazenda de ventos no Texas partilha o espaço com cactos e outros habitantes do deserto. |

A medição anual da temperatura de superfície sobre as fazendas de ventos mostra uma tendência persistente de aquecimento de 2003 até 2011, consistente com o aumento do número de turbinas eólicas em funcionamento ao longo do período.

“Este efeito de aquecimento provavelmente é causado pelo rastro de turbulência das turbinas agindo como um ventilador para sugar para baixo o ar mais quente de altitudes maiores à noite”, explica Somnath Baidya Roy da Universidade de Illinois em Urbana-Champaign, um co-autor do artigo.

Embora o efeito de aquecimento relatado seja local e pequeno, comparado com a forte variação anual da temperatura de solo de fundo, os autores acreditam que este trabalho chama a atenção para uma importante questão científica que merece maiores investigações.

|

|

Diferenças nas temperaturas noturnas da superfície , próximo a fazendas de ventos, entre 2010 e 2013. |

“A tendência de aquecimento estimada se aplica somente à região estudada e ao período do estudo, não devendo, portanto, ser interpolada para outras regiões de maneira global ou por períodos mais extensos”, esclarece Zhou. “Para uma dada fazenda de ventos, uma vez que não haja a instalação de novas turbinas eólicas, o efeito de aquecimento pode chegar a um patamar de estabilidade”.

O estudo representa um primeiro passo para a exploração de dados de satélites para quantificar os possíveis efeitos do desenvolvimento de grandes fazendas de ventos sobre o tempo e o clima, declara Chris Thorncroft da SUNY-Albany, um co-autor do artigo.

“Estamos expandindo esse enfoque para outras fazendas de ventos”, diz Thorncroft, “e criando modelos para compreender os processos e mecanismos físicos que regem as interações das turbinas eólicas e a camada atmosférica de fronteira próxima à superfície”.

Os outros autores do artigo são Lance Bosart da SUNY-Albany, Yuhong Tian da NOAA e Yuanlong Hu do Terra-Gen Power LLC em San Diego, Califórnia.

-NSF-

Não seja enganado por baboseiras quânticas

Eu sou místico. Eu acredito em magia, em espíritos e em outras coisas absurdas. A meu favor, só posso dizer que não faço a menor ideia do porquê isso funciona; apenas acho que funciona. Se isso é uma prova de que meu raciocínio é tendencioso e baseado em auto-sugestão, problema meu… E, diga-se de passagem, não faço proselitismo de minhas crenças porque acho que isso é uma questão de convicção pessoal.

Este post foi motivado por uma dessas asneiras pseudo-científicas que, infelizmente, vêm sendo repetidamente utilizadas por gente que ouviu cantar um galo, mas não sabe onde, e – o que é mais deplorável ainda – gente que por sua própria formação acadêmica, deveria ter mais cuidado em não tentar impingir suas crenças não fundamentadas com argumentos fantasiosos baseados em sua lamentável ignorância de outro ramo das ciências que não é o seu.

A asneira em particular foi uma argumentação em defesa da homeopatia, publicada na Scientific American, Edição Brasileira (e já fartamente repudiada pela editoria da Scientific American, Matriz). A passagem é esta:

A homeopatia é conhecida como tratamento alternativo para os seres humanos, mas poucos conhecem sua utilização em animais, plantas, solo e águas. Essa técnica é alvo de críticas quanto aos resultados e eficácia. Uma delas diz respeito ao “efeito placebo” de seus remédios, que não contêm nenhum traço da matéria-prima utilizada em sua confecção. Para responder a essa abordagem é necessário um esclarecimento: a homeopatia não se relaciona com a química, mas com a física quântica, pois trabalha com energia, não com elementos químicos que podem ser qualificados e quantificados. (o grifo é meu. JC)

Essa “pérola” é atribuída a “Nina Ximenes, bióloga, […] pós-graduada em educação ambiental” e foi publicada na página 17 da edição brasileira de abril de 2012 da Scientific American. E – faça-se justiça – já foi publicamente repudiada pela Editora-Chefe da Scientific American, Matriz, Mariette DiChristina. É profundamente lamentável que o senhor Ulisses Capozolli, Editor-chefe da edição brasileira da SciAm, tenha “cochilado” e dado o respaldo de uma revista científica respeitada a tamanho non-sequitur.

Então, vamos ao que realmente interessa. Que diabos é essa tal “física quântica”?

O nome já começa por ser infeliz e induzir ao erro. O conceito de quanta (singular: quantum) de energia surgiu com as experiências de Max Planck sobre a energia que corpos aquecidos emitem. Ele descobriu (vou poupá-los dos detalhes técnicos) que a energia era sempre absorvida e emitida em “pacotes discretos”. Se você bombardeasse um alvo com luz de um determinado comprimento de onda, obteria uma radiação com outro comprimento de onda; sempre os mesmos. Se você aumentasse a intensidade da luz, produziria mais radiação, mas sempre com o mesmo comprimento de onda, não com um comprimento de onda maior. Da velha nomenclatura da química (especialmente a bioquímica) veio o termo quantum (= quantidade).

Disso, se deduziu (e, posteriormente, se comprovou fartamente) que no nível subatômico, a energia é absorvida e emitida sempre nesses “pacotes”; sem valores intermediários.

Parece algo sem paralelo em nosso mundo “macro” cotidiano, né?… Nem tanto… Pense na gravidade da Terra; para um objeto se livrar da atração da gravidade terrestre e ser lançado ao espaço (se você pensou em satélites e naves espaciais, acertou!) é preciso que ele alcance uma velocidade de escape de 11,2 km/s. Uma velocidade ligeiramente menor e o objeto cai de volta; se a velocidade for ligeiramente maior, tanto faz: o objeto escapa da atração da Terra.

Isso independe da massa do objeto; a velocidade de escape é sempre a mesma. É claro que, para que um objeto com maior massa (“mais pesado”), você vai precisar de uma energia total bem maior para obter a mesma velocidade de escape.

Nas interações entre as partículas que compõem os átomos, assim como entre os átomos que compõem uma molécula e da mesma forma entre átomos de moléculas próximas (e é isso que chamamos de “química”), tudo é feito com base nessas quantidades mínimas de energia (ou quanta), de modo que qualquer “pacote” de energia pode ser tratado como uma “partícula”.

E os físicos chegaram à conclusão (após longos e tediosos estudos) que só existem quatro tipos de interações entre as partículas subatômicas: as conhecidas gravitacionais e eletromagnéticas, que se manifestam claramente neste universo “macro” onde vivemos, e duas que só funcionam no âmbito restrito dos átomos e principalmente seus núcleos: a forte e a fraca. A fraca tem alguma semelhança com a eletromagnética, só que as partículas portadoras dessa força têm massa e, portanto, não chegam muito longe: não saem de dentro do diâmetro de um núcleo atômico dos pequenos… E a forte ganhou esse nome porque é muito mais forte do que a repulsão eletromagnética e consegue manter juntas duas partículas de cargas iguais (e ainda bem que ela existe, senão este universo nem existiria).

O grande problema em estudar o comportamento das “coisas” no “mundo subatômico” é que o simples ato de observar uma partícula altera essa partícula. Quer um paralelo ‘macro”?… Pense em uma pilha de pratos – uma meia dúzia deles – onde só um tem uma marca no centro (e você não pode olhar por cima da pilha). Para saber qual deles é o prato marcado, você tem que tirar os pratos que estão por cima e, quando chegar no prato marcado, ele já não será mais um “prato no meio da pilha”. Para uma partícula subatômica, seu “lugar na pilha” é extremamente importante (acredite em mim… senão a gente não chega ao fim da estória).

Para agravar o problema citado acima, é extremamente difícil (para não dizer “impossível”) obter algo como “um único fóton” (“fóton” é a partícula de força eletromagnética, da qual a luz visível é apenas uma faixa extremamente estreita – mas guarde isto: todo e qualquer fóton se move à “velocidade da luz”, o “limite de velocidade” no universo) e – como se isso não bastasse – qualquer “partícula”, enquanto não produzir um efeito mensurável, é uma “onda” e se comporta como tal. Quer outra analogia “macro”?… Uma onda do mar que bate contra uma parede de cais. Se você dotar a parde de sensores que meçam a força exercida por cada onda que bate nela, você pode calcular a quantidade de água (e coisas dissolvidas nela) e a velocidade de cada onda (e eis sua “partícula” de mar…)

E mais uma coisa que confunde os “leigos”: isso tudo acontece no “mundo subatômico” em uma velocidade inimaginável e em quantidades de perder o fôlego. Lembra da onda do mar que eu fiz bater no cais no parágrafo acima?… Sabe como se dá esse “choque”?… Interação eletromagnética! Cada um dos elétrons dos átomos de água (e coisas dissolvidas nela) interage com os elétrons dos átomos dos materiais que compõem a parede, trocando “brazilhões” de “fótons virtuais” a cada “pentelhésimo” de segundo, e se repelem!

OK! E o que isso tem a ver com a homeopatia e os remédios em geral?

Exatamente o que você já pensou: nada! As reações químicas são uma “manifestação” da velha força eletromagnética que junta os átomos em moléculas, com os núcleos positivos atraindo os elétrons negativos dos outros átomos e estes puxam o núcleo do átomo “roubado” mais para perto do átomo “ladrão” de elétrons. E, se surgir uma molécula com capacidade de atrair mais o átomo “ladrão”, ou o átomo “roubado”, ela “rouba” o lugar da outra e cria uma (ou mais) moléculas novas, Isso é uma “reação química”.

Enquanto isso, as interações nucleares fortes e fracas continuam a acontecer dentro dos núcleos dos átomos – “brazilhões” de vezes por fração de segundo – e isso não muda chongas na reação química!

Para você ter o efeito de um átomo de flúor – o elemento químico mais reativo que se conhece – você precisa da presença de um bendito átomo de flúor! Se o átomo de flúor for reagir em outra freguesia, a molécula abandonada passa a se comportar como se ele nunca tivesse estado lá! E, se você tiver “brazilhões” de átomos de, por exemplo, hidrogênio e um só átomo de flúor, só vai conseguir uma única molécula de ácido fluorídrico, coisa que, em um organismo vivo, não faz a menor diferença.

Já perceberam onde eu quero chegar, né?.. Quanto maior a diluição, menor o efeito, até não haver efeito algum.

E a física quântica não pode fazer nada a respeito, porque ela continua agindo da mesmíssima forma por todo o universo conhecido e nem por isso você é capaz de atravessar uma porta fechada – embora um nêutron seja capaz de escapar de repente de um núcleo atômico (“Radiatividade”).

Então, quando vierem com um papo furado de querer explicar magia, homeopatia, reiki, passes do caboclo ou as preces da rezadeira com a “física quântica”, caia fora!

Como eu disse lá em cima, eu acredito em magia… mas sei que a física não tem coisa alguma a ver!

Para alguma coisa os neutrinos servem: transmissão de mensagens

Pesquisadores enviam mensagem “sem fio” usando neutrinos (através de rocha sólida)

Um grupo de cientistas, liderados por pesquisadores das Universidades de Rochester e Estadual da Carolina do Norte, enviaram, pela primeira vez, uma mensagem utilizando um feixe de neutrinos – aquelas partículas quase sem massa e que viajam quase à velocidade da luz. A mensagem foi enviada através de 240 metros de rocha e dizia simplesmente: “neutrino”.

“Com o uso de neutrinos, seria possível a comunicação entre quaisquer dois pontos da Terra sem o uso de satélites ou cabos”, diz Dan Stancil, professor de engenharia elétrica e de computação da NC State e autor principal de um artigo que descreve a pesquisa. “Os sistemas de comunicações por neutrinos teriam que ser muito mais complexos do que os atuais, mas podem ter importantes usos estratégicos”.

Diversas pessoas já teorizaram acerca da possibilidade de empregar os neutrinos em comunicações por causa de uma propriedade particularmente valiosa destes: eles podem atravessar quase qualquer coisa que esteja em seu caminho.

Se essa tecnologia fosse aplicada a submarinos, por exemplo, eles poderiam se comunicar por longas distâncias, mesmo submersos, o que é muito difícil, para não dizer impossível, com a atual tecnologia. E, se quiséssemos nos comunicar com algo no espaço exterior que estivesse no lado oculto da Lua ou de outro planeta, nossa mensagem poderia ser enviada diretamente através do corpo celeste sem qualquer impedimento.

“É evidente que nossa atual tecnologia faz uso de enormes equipamentos de alta tecnologia para enviar uma mensagem por meio de neutrinos, de forma que ainda não é algo prático”, diz Kevin McFarland, um professor de física da Universidade de Rochester que não esteve envolvido na experiência. “Mas o primeiro passo na direção de algum dia empregar neutrinos para comunicação de forma prática, é uma demonstração que se valha da tecnologia existente”.

A equipe de cientistas que demonstraram que isso é possível, realizou seus testes no Fermi National Accelerator Lab (conhecido como Fermilab), nas cercanias de Chicago. O grupo apresentou suas descobertas à publicação Modern Physics Letters A.

No Fermilab os pesquisadores têm acesso a dois componentes cruciais. O primeiro é um dos mais poderosos aceleradores de partículas do mundo que cria feixes de neutrinos de alta intensidade, acelerando prótons em redor de uma circunferência de 2,5 milhas e os fazendo colidir com um alvo de carbono. O segundo é um detector de muitas toneladas chamado MINERvA, localizado em uma caverna a 100 metros abaixo do solo..

O fato de um aparato tão gigantesco ser necessário para a comunicação por meio de neutrinos, significa que ainda é necessário muito trabalho, antes que a tecnologia possa assumir uma forma de uso prático.

O teste de comunicações foi realizado durante um período de duas horas quando o acelerador estava funcionando a meia potência, devido a um período de desligamento programado. Os dados de interação regularmente detectados por MINERvA foram coletados ao mesmo tempo que o teste de comunicação era realizado.

Atualmente, a maior parte das comunicações é realizada pelo envio e recepção de ondas eletro-magnéticas. É assim que nossos rádios, celulares e televisões funcionam. No entanto, as ondas eletro-magnéticas não atravessam facilmente a maior parte da matéria. Elas são bloqueadas pela água, pelas montanhas e vários outros líquidos e sólidos. Por outro lado, os neutrinos atravessam regularmente os planetas sem serem perturbados.

Por causa de sua carga eletromagnética neutra e massa quase nula, os neutrinos não estão sujeitos à atração magnética e não sofrem uma influência significativa da gravidade, de forma que se movem virtualmente sem impedimentos.

A mensagem que os cientistas enviaram com o uso de neutrinos foi em código binário. Em outras palavras, a palavra “neutrino” foi representada por uma série de 1’s e 0’s; os 1’s correspondendo a um grupo de neutrinos disparados e os 0’s à ausência de neutrinos. Os neutrinos foram disparados em enormes grupos porque, mesmo com um detector de várias toneladas, eles são tão elusivos que apenas um em cada dez bilhões de neutrinos são detectados. Depois que os neutrinos eram detectados, um computador na outra extremidade traduzia o código binário de volta ao inglês e a palavra “neutrino” foi recebida com sucesso.

“Os neutrinos tem se constituído em uma ferramenta excepcional para nos ajudar a aprender acerca do funcionamento do núcleo [atômico] e do universo”, disse Deborah Harris, gerente do projeto Minerva, “mas a comunicação por meio de neutrinos ainda tem um longo caminho pela frente até ser eficaz”.

Minerva é uma colaboração internacional de físicos nucleares e de partículas de 21 instituições que estudam o comportamento dos neutrinos, usando um detector localizado no Fermilab, perto de Chicago. Esta foi a primeira experiência no mundo a usar um feixe de alta intensidade para estudar as reações dos neutrinos com núcleos de cinco diferentes tipos de material alvo, criando, pela primeira vez, uma comparação lado a lado dessas interações. Isso auxiliará a completar o quadro dos neutrinos e permitir que os dados seja interpretados de maneira mais clara em experiências correntes e futuras.

Neutrinos mais rápidos do que a luz?… (2)

Atualização rapidinha: Phil Plait, em seu blog Bad Astronomy, fala de uma notícia não confirmada de que os tais 60 nanossegundos de diferença medidos nos neutrinos emitidos pelo LHC e captados no Gran Sasso podem ser resultado de uma má conexão no cabo de fibra óptica que envia os dados do receptor do GPS para um circuito do computador… Link para o original (em inglês): Unconfirmed rumor: FTL neutrinos may be due to a faulty GPS connection.

Nada de dobra, Senhor Sulu!…

2012 – O último Carnaval?

Pode muito bem ser… Já que o negócio é aproveitar qualquer deixa para vaticinar um Apocalipse, um suposto “fim-do-mundo” com base em uma conta-de-chegar feita a partir de um calendário Maia, é tão bom quanto qualquer algaravia extraída de uma exegese de uma centúria de Nostradamus…

Então, a partir de agosto (mes sabidamente aziago), as oscilações das anomalias do campo magnético da Terra vão começar a se intensificar, acompanhadas de um recrudescimento na atividade tectônica, com amplo fornecimento de terremotos, tsunamis e erupções vulcânicas. Afora os efeitos sobre as condições climáticas locais (que serão acompanhadas de intenso debate sobre se esses fenômenos são decorrentes das “mudanças climáticas” antropogênicas, ou, ao contrário: se as mudanças climáticas tidas como antropogências são uma mera manifestação das forças telúricas), o subito “endoidamento” das declinações magnéticas vai causar efeitos devastadores nas espécies que se pautam pela magnetosfera terrestre para suas migrações sazonais.

As grandes navegações serão muito menos afetadas, porque se pautam mais pelo Sistema de Posicionamento Global (GPS) do que pelas obsoletas bússolas (que os tradutores de programas “científicos” insistirão em chamar de “compassos”, enganados pelo falso-cognato), até que…

Com o campo magnético da Terra instável e enfraquecido, o Sol resolve fazer gracinha: uma inusitada Ejeção de Massa Coronal de proporções épicas é expelida bem na direção do terceiro planeta.

A chuva de parículas altamente energéticas encontra uma magnetosfera enfraquecida e provoca imediatamente um caos nas linhas de transmissão de energia elétrica, causando “apagões” em cascata, desligando usinas geradoras e colocando fora de combate toda a comunicação por fios, inclusive e principalmente a internet. Pior ainda: as redes de satélites de comunicações, GPS e outros monitoramentos (principalmente os satélites meteorológicos) literalmente “vão para o espaço”…

Sem redes de transmissão de eletricidade, sem comuinicações em tempo real, com a indústria pesada (o que inclui as refinarias de petróleo) fora de combate, as redes de transporte público funcionando precariamente (enquanto os estoques de combustível durarem), o mundo subitamente estará devolvido à tecnologia do início do século XX… mas com uma população de século XXI.

Ironicamente, as populações dos rincões mais atrasados do planeta serão as menos afetadas inicialmente. Os ianomâmis não vão sentir imediatamente os efeitos do caos em Wall Street e os habitantes do Sudão do Sul vão continuar morrendo como moscas por causa da fome e de condições sub-humanas de vida, mas nada vai ficar imediatamente “pior” para eles.

Por outro lado, as epidemias vão demorar mais a se transformar em pandemias, em face da quase paralisação do transporte aeronáutico (a essa altura, resumido aos voos militares). Mas os surtos locais vão ser bem mais graves, por conta da dificuldade do acesso a medicamentos e das restrições ao reforço das equipes de agentes da saúde locais.

Para culminar a desgraça, a rede NEAT foi uma das mais prejudicadas na nova atribuição de prioridades e, justamente agora, um asteróide rasante resolveu “rasar” demais e, apesar de ter sido detectado com alguma antecedência pelos telescópios em terra, seu ponto de impacto não pode ser calculado porque o tempo de computação necessário estava empenhado pela FEMA e o a realocação dos recursos ficou parada na Câmara dos Deputados dos EUA por conta de uma feroz oposição do Tea Party a qualquer iniciativa do governo, em um ano eleitoral.

O fato do meteorito ter atingido o Oriente Médio (causando, entre outras coisas, a destrução de Jerusalém) foi interpretado por muitos como “uma demonstração da cólera divina”, com as vertentes religiosas trocando acusações, insultos e atentados terroristas, por conta da “blasfêmia” alheia. No entando, os efeitos sísmicos do impacto causaram danos bem mais permanentes, notadamente nos campos petrolíferos da região (… realmente uma pena o que aconteceu com os arranha-céus de Dubai, mas fazer o que?…)

A coincidência do meteorito ter caido no dia 22 de dezembro de 2012 foi aclamada como a realização da “Profecia Maia” (apesar do suposto calendário Maia apontar o dia 21…), mas o fim-do-mundo não foi o que geralmente se esperava… Na verdade, o mundo não acabou (e precisava muito mais do que isso para realmente acabar com a Terra…): apenas a humanidade ficou em uma merda bem maior do que já estava.

Mas pensam que alguém se emendou?… Ledo engano d’alma!… As dicussões sobre a conservação do meio ambiente foram devidamente arquivadas por conta do “esforço de recuperação”, as preocupações com poluição descartadas em favor da “retomada da normalidade” e as mudanças climáticas foram de volta para a prateleira, com o argumento de que “em face das súbitas mudanças, há que recalcular tudo novamente” (tese adiantada pelo Heartland Institute e rapidamente encampada pelos cacos de midia remanescentes).

Mas 2012 não foi o último Carnaval: em 2013 minha escola, Acadêmicos do Salgueiro, saiu com o enredo: “Os Orixás salvaram a Bahia da urucubaca dos Maias”…

Em uma extinção global, para que a pressa?

Traduzido de Global Extinction: Gradual Doom as Bad as Abrupt

![]()

Na “Grande Extinção”, há 250 milhões de anos, o fim chegou devagar

|

|

A geologia do Arroio Griesbach no Ártico conta uma antiga história de extinção lenta. |

3 de fevereiro de 2012

A mais mortífera das extinções em massa de todas levou um longo tempo para matar 90% da vida marinha da Terra – e o fez por estágios – conforme um relatório recentemente publicado.

Isso mostra que extinções em massa não precisam ser eventos súbitos.

Thomas Algeo, um geólogo da Universidade de Cincinnati, e 13 colegas produziram uma análise em alta resolução da geologia de uma seção da fronteira Permiano-Triássica na Ilha Ellesmere no Ártico Canadense.

Sua análise, publicada na edição de 3 de fevereiro no Geological Society of America Bulletin, apresenta fortes indícios de que a maior extinção em massa da Terra ocorreu ao longo de centenas de milhares de anos.

|

|

Paleogeografia durante a fronteira da extinção Permiano-Triássica, há 252 milhões de anos. |

Há cerca de 252 milhões de anos, no fim do período Permiano, a Terra tinha se transformado em um planeta quase sem vida. Cerca de 90% de todas as espécies vivas desapareceu, naquilo que os cientistas chamam de “A Grande Extinção”.

Algeo e seus colegas levaram a maior parte da última década investigando os indícios químicos encrustados nas rochas que se formaram durante essa maciça extinção.

O mundo revelado por esta pesquisa é uma paisagem devastada, sem vegetação e abrasada pela erosão por chuvas ácidas, enormes “zonas mortas” nos oceanos e um aquecimento de efeito estufa desenfreado que causou temperaturas escaldantes.

Os indícios colhidos por Algeo e seus colegas apontam para um intenso vulcanismo na Sibéria como um fator preponderante.

“Os cientistas relacionam esta extinção às erupções vulcânicas nos Trapps Siberianos¹ que provavelmente oafetaram primeiro a vida boreal com gases tóxicos e cinzas”, disse H. Richard Lane, diretor de programa na Divisão de Ciências da Terra na Fundação Nacional de Ciências (NSF) que financiou a pesquisa.

|

|

A árida paisagem ártica da Ilha Ellesmere foi o local das pesquisas dos cientistas. |

Os Trapps Siberianos formam uma grande região de rochas vulcânicas na Sibéria. O grande evento eruptivo que formou os trapps, um dos maiores eventos de vulcanismo dos últimos 500 milhões de anos da história geológica da Terra, durou um milhão de anos e se estendeu pela fronteira Permiano-Triássica.

O termo “trapps” deriva da palavra sueca para “escada” – trappa ou trapp – e se refere às elevações em degraus que formam a paisagem da região.Uma vasta parte da Sibéria Ocidental revela depósitos vulcânicos com até 5 km de espessura que cobrem uma área equivalente ao Brasil. A lava fluiu por onde a vida já estava mais ameaçada, através de um grande depósito de carvão.

“A erupção liberou grande quantidade de metano quando queimou pelo carvão”, diz Algeo. “E o metano é 30 vezes mais eficaz como gás de efeito estufa do que o dióxido de carbono”.”Não temos certeza sobre quanto durou o efeito estufa, mas parece que foram de dezenas a centenas de milhares de anos”.

Grande parte dos indícios foi dissolvida no oceano e Algeo e seus colegas procuraram por eles no meio dos depósitos de fósseis marinhos.As investigações anteriores se focalizaram em depósitos criados pelo desaparecido Oceano de Tetis, um antepassado do Oceano Índico. Esses depósitos, particularmente no Sul da China, registram uma súbita extinção no fim do Permiano.

“Nos depósitos marinhos de águas rasas, a última extinção em massa do Permiano foi, em geral, abrupta”, explica Algeo. “Com base nessas observações, foi largamente inferido que a extinção foi um evento globalmente sincronizado”.

|

|

Foto do Platô Putorana, que contem 500 milhões de anos de história (Patrimônio da Humanidade – UNESCO). |

Estudos recentes estão começando a desafiar essa versão.Algeo e seus co-autores se focalizaram nas camadas de rochas do Fiord Blind de Oeste na Ilha Ellesmere no Ártico Canadense.Esse local, no fim do Permiano, ficava muito mais próximo dos vulcões siberianos do que o Sul da China.

As camadas da rocha sedimentar canadense tem 24 metros de espessura e atravessam a fronteira Permiano-Triássica, inclusive o horizonte da última extinção em massa do Permiano.Os investigadores examinaram como o tipo de rocha se modificou de baixo para cima, assim como a composição química das rochas e os fósseis nelas contidos.

|

|

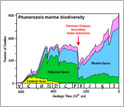

A biodiversidade marinha mudou de maneira significativa em centenas de milhões de anos da história da Terra. |

Eles descobriram uma extinção total de espongiários silicosos ocorrida cerca de 100.000 anos antes da extinção em massa marinha observada nos sítios tetianos.O que parece ter acontecido, segundo Algeo e seus colegas, é que os efeitos do início da atividade vulcânica siberiana, tais como gases tóxicos e cinzas, ficaram confinados às latitudes do Norte.Somente depois que as erupções estavam em pleno curso é que os efeitos alcançaram as latitudes tropicais do Oceano de Tetis.

A pesquisa foi patrocinada pelo Conselho Canadense de Pesquisas em Ciências Naturais e Engenharia e pelo Programa de Exobiologia da NASA.Além da Algeo, os co-autores do estudo são: Charles Henderson, Universidade de Calgary; Brooks Ellwood, Universidade Estadual de Louisiana; Harry Rowe, Universidade do Texas em Arlington; Erika Elswick, Universidade de Indiana, Bloomington; Steven Bates e Timothy Lyons, Universidade da California, Riverside; James Hower, Universidade de Kentucky; Christina Smith e Barry Maynard, Universidade de Cincinnati; Lindsay Hays e Roger Summons, Massachusetts Institute of Technology; James Fulton, Woods Hole Oceanographic Institution; e Katherine Freeman, Universidade Estadual de Pennsylvania.

Nota do Tradutor:1 – Tenho visto por aí traduzirem do inglês “Siberian Traps” por “Armadilhas Siberianas”. Só que “Trapp” em geologia não tem nada a ver com “trap” = “armadilha”. O termo geológico deriva do sueco (e não do sânscrito, como consta na WikiPedia em português) e significa “em forma de degraus”). A “armadilha” real é para os tradutores… E só para deixar a ideia bem longe das “armadilhas”, eu inventei de dar um gênero masculino (associando a “os degraus”) ao termo “trapp”.

Acharam a “Partícula de Deus”?… Ainda não…

Físicos de partículas relatam “indícios promissores” do Bóson de Higgs

Ainda não foi detectada a partícula, há tanto tempo procurada, mas os pesquisadores podem ter encontrado seu esconderijo

13 de dezembro de 2011

Por Ben P. Stein

Inside Science News Service

(ISNS) — Os físicos europeus relataram hoje possíveis indícios do bóson de Higgs, a peça que falta no quebra-cabeças da física de partículas. Teoricamente, essa partícula deve ser a responsável pela massa de todas as partículas fundamentais, tais como elétrons e quarks.

Ao relatar as últimas análises dos escombros das colisões de partículas no maior acelerador de partículas existente, os pesquisadores ainda não dispõem de dados suficientes para declarar uma descoberta – uma nova série de colisões de partículas a ser realizada no ano que vem deve produzir mais respostas – mas anunciaram uma faixa de massa provável para o Higgs, caso ele realmente exista. Os pesquisadores apresentaram seus resultados através de um webcast e um seminário, acompanhado por um grande público, a partir do CERN, o Centro Europeu de Pesquisas Nucleares em Genebra, Suiça.

“O entusiasmo é palpável e há um número incrível de pessoas competentes e brilhantes examinando os dados”, escreveu Drew Baden, um professor de física da Universidade de Maryland, em um email ao Inside Science . “Se o Higgs existir mesmo, logo saberemos com certeza. Só que não vai ser [nesta] terça-feira”, escreveu Baden que pertence a uma das equipes de detectores que apresenta hoje seus resultados.

As partículas criariam um Campo de Higgs que permearia todo o espaço. Outras partículas, ao passarem por esse campo, interagiriam com ele em diferentes graus e seria dessa forma que elas ganhariam suas massas. A massa pode ser considerada uma medida da inércia, ou resistência ao movimento. Um elétron reagiria de modo relativamente fraco com o Campo de Higgs e, por isso, não apresentaria uma grande resistência ao movimento. Já um quark interagiria com o campo mais intensamente e seu movimento sofreria uma resistência maior em seu deslocamento através do espaço. Os fótons, as partículas de luz, não interagiriam com o campo e por isso não tem massa.

Enterrado a dezenas de metros abaixo do solo na fronteira franco-suíça, o LHC (Large Hadron Collider = Grande Colisor de Hádrons) no CERN acelera prótons até as mais altas energias obtidas até hoje. Os físicos produziram um enorme número de colisões próton-próton nessas energias recordes desde maio de 2010. Quando os prótons se estraçalham contra outros prótons, a colisão cria uma bola de energia da qual se formam outras partículas novas, o que deveria incluir o Bóson de Higgs. A famosa equação de Einstein, E=mc2, mostra que matéria e energia são intercambiáveis, de modo que, a partir da energia da colisão, podem ser criadas novas partículas maciças.

A massa do Bóson de Higgs, caso ele exista, é maior do que tudo o que os aceleradores de partículas tinham conseguido criar até recentemente. Os atuais resultados no LHC e outros anteriores do acelerador Tevatron no Laboratório Nacional Fermi no Illinois, descartam a existência do Higgs em certas faixas de massas.

Os pesquisadores de dois detectores do LHC, conhecidos como ATLAS e CMS, apresentaram novos dados no longamente aguardado seminário de hoje. Fabiola Giannoti, chefe da experiência ATLAS, relatou um excedente de eventos gerados pelas colisões que podem indicar a geração e o decaimento do Higgs.

Giannoti relatou que os dados de sua equipe sugerem que a região de massas mais provável para o Higgs fica na faixa de cerca de 116 a 130 gigaelectron-volts (GeV), o que corresponde a aproximadamente de 116 a 130 vezes a massa do átomo de Hidrogênio. Ela relatou, mais exatamente, um excedente de eventos de colisão no entorno dos 126 GeV, mas não pode declarar uma descoberta conclusiva. Guido Tonelli, porta-voz da experiência CMS, também relatou o que ele chamou de “indícios intrigantes e tantalizantes” da existência da partícula. A equipe dele relatou que a provável faixa de massas para o Higgs fica entre 115 e 127 GeV, sendo que seus resultados eram mais compatíveis com uma massa de 124 GeV. Ambas as equipes não possuem dados estatisticamente significativos para poder anunciar uma descoberta.

No conjunto, esses dois grupos encontraram, independentemente, intrigantes eventos de colisão entre os 124 e os 126 GeV, o que sugere que o Higgs pode ter sido produzido no LHC.

“Eu acho que é significativo que as duas colaborações, analizando independentemente os dados obtidos de seus detectores tão diferentes, ambas encontraram eventos similares ao Higgs na mesma faixa de massas”, declarou o físico de partículas teórico da Universidade de Maryland, Raman Sundrum, que não faz parte de nenhuma das duas equipes, logo após o encerramento do seminário ao Inside Science. “Se isso for constatado, eu penso que será uma monumental descoberta científica e o resultado de um esforço hercúleo e brilhante”.

Entretanto, todos os pesquisadores enfatizaram que, no atual ponto, ainda há uma chance de que partículas já conhecidas – o que os físicos chamam de “ruído de fundo” – possam ser as responsáveis pelos sinais. Cada grupo enfatizou ter encontrado um número relativamente pequeno de eventos interessantes nas faixas de massas relatadas. Em termos estatísticos, ainda há muitas chances em cada mil de que os resultados sejam um mero falso indício errático. A detecção de mais eventos de colisão semelhantes pode reduzir as probabilidades até o ponto onde os pesquisadores possam concluir seguramente ter descoberto os rastros da verdadeira partícula.

A partícula foi batizada em honra a Peter Higgs, um dos teóricos que postularam sua existência em 1964 para impedir a falência do Modelo Padrão da física de partículas. O Modelo Padrão é uma das teorias de maior sucesso na história da ciência e descreve três da forças fundamentais – eletromagnetismo e as forças nucleares forte e fraca – assim como todo o “zoológico” das partículas conhecidas no universo, desde querks e elétrons a fótons e neutrinos. Sem o Higgs, o modelo seria incapaz de explicar importantes diferenças entre as forças e por que certas partículas tem massa e outras não.

Mesmo assim, os físicos encaram uma detecção definitiva do Higgs apenas como um começo, não o fim, de uma era de descobertas. Da mesma forma que a Teoria da Relatividade Geral de Einstein incorporou todas as previsões da Teoria da Gravidade de Newton, mas permitiu a previsão da existência de novas coisas assim como os buracos negros, o Modelo Padrão, fortificado pela comprovação da existência de um Bóson de Higgs, pode levar a teorias ainda mais avançadas, assim como uma física totalmente nova

“Ainda não sabemos onde um futuro estudo cuidadoso do Higgs pode conduzir”, escreveu Sundrum. “Bós estamos ainda no início da jornada”.

Uma teoria mais abrangente, chamada supersimetria, exige a existência de “partículas-espelho” para todas as partículas já conhecidas. A Teoria das Cordas, uma descrição ainda mais elaborada do universo, afirma que os elementos de construção do cosmos não são partículas, tais como os elétrons, mas sim que até os elétrons resultam de vibrações de cordas e outros objetos, tais como membranas, que são tão pequenos que não podem ser detectados pelos atuais instrumentos científicos.

Ainda assim, Sundrum alerta contra enxergar demais nos resultados divulgados hoje. Ele afirma que as notícias não excluem a possibilidade do Bóson de Higgs ser, na verdad, uma classe de partículas. E que estes resultados não são uma validação de outras teorias, tais como o modelo da supersimetria.

“A melhor prova para a supersimetrias seria a detecção das próprias super-partículas”, acautela Sundrum.

Depois dos anúncios de hoje, os físicos estão mantendo reserva em seu julgamento, afirmando que os dados estão apenas estreitando as áreas onde pode ser que o Higgs esteja.

Um maior número de colisões provavelmente porá um fim às questões.

“Nada de conclusivo se pode afirmar por enquanto”, alerta Baden. “Se tudo correr bem, provavelmente teremos resultados conclusivos no final do ano que vem”.

Ben P. Stein é o gerente editorial do serviço Inside Science do Instituto Americano de Física (AIP)

Neutrinos mais rápidos do que a luz?

Tem havido muito frisson sobre um resultado de medições dos neutrinos emitidos pelo Large Hadron Collider (LHC) – o Grande Colisor de Hárdrons, o maior acelerador de partículas já construído – do CERN e detectados no Laboratori Nazionali del Gran Sasso (LNGS) do Instituto Nazionale di Fisica Nucleare (Itália).

Segundo os dados obtidos no LNGS – publicados aqui no ariXiv – os neutrinos oriundos do LHC estão chegando aos sensores do LNGS mais rápido do que se fossem fótons (isso se os fótons pudessem atravessar a Terra, do mesmo modo que os neutrinos o fazem).

Um dos pilares da física – a Teoria da Relatividade (de Einstein) – postula que nada pode viajar mais rápido do que a velocidade da luz no vácuo (o termo “c”, na famosa equação E = mc²) e os fótons (as partículas fundamentais da Força Eletromagnética(EM) e a luz visível é apenas uma estreita faixa da radiação EM) só conseguem esta proeza porque não tem massa.

Ora, supõe-se que os neutrinos tenham uma massa – muito pequena, é certo, mas tem – o que tornaria impossível que eles viajassem, mesmo no vácuo – e, para eles, a Terra e o vácuo são praticamente a mesma coisa – a uma velocidade sequer igual a “c”, quanto mais a uma velocidade superior.

Então, alguma coisa certamente está errada!

Ou temos (mais provável) algum erro desconhecido nas leituras, ou temos que refinar o arcabouço da física teórica para acomodar um novo fenômeno. (Mas, seja como for, dificilmente estaremos próximos de uma “viagem no tempo”, como sugeria um subtítulo de manchete do habitualmente sóbrio The Guardian).

Para dar as notícias de uma fonte menos bombástica, apresento a tradução da notícia divulgada no Inside Science News Service, da Associação Americana de Física.

Físicos relatam indícios de uma partícula mais rápida do que a luz

Mas adiem a revolução: os resultados precisam ser confirmados e podem não alterar radicalmente a física.

23 de setembro de 2011

Por Ben P. Stein

Inside Science News Service

|

|

Imagem ampliada. Crédito: Colaboração OPERA |

(ISNS) – No que pode vir a representar a maior descoberta em física do século até agora, caso confirmada, pesquisadores anunciaram terem medido partículas se deslocando a uma velocidade superior à da luz, o que – ao menos até agora – era considerado o limite máximo de velocidade para qualquer coisa no universo.

Pesquisadores do projeto OPERA (Oscillation Project with Emulsion-tRacking Apparatus) apresentaram seus resultados na última sexta em um seminário no CERN, o Centro Europeu de Pesquisas Nucleares (a sigla é em francês), em seguida à publicação antecipada de um relatório no site arXiv (vide link acima)

Porém os pesquisadores do OPERA são os primeiros a enfatizar que é cedo demais para especular sobre possíveis implicações. Embora a colaboração OPERA tenha realizado uma análise compreensiva de suas medições, os pesquisadores reconhecem a possibilidade de haver um erro que passou despercebido, ou mesmo que tenha uma causa ainda desconhecida, que pode ter causado um desvio nos resultados. Eles declaram que estão apresentando seus resultados à comunidade da física de forma a que outros possam verificar esses resultados e tentem duplicar suas experiências.

O OPERA mediu o tempo de trânsito de partículas conhecidas como neutrinos em seu deslocamento de aproximadamente 732 km entre o acelerador do CERN na Suíça e o Laboratório do Gran Sasso na Itália. Ao medir o instante de chegada de mais de 15.000 neutrinos no Gran Sasso, eles descobriram de maneira inesperada que as partículas chegavam 60 nanossegundos (bilionésimos de segundo) mais rápido do que a luz teria chegado. Isso representa uma velocidade 0,002% mais rápida do que a luz que viaja a cerca de 300.000km/seg.

“É algo bem simples; é uma medição clássica”, declarou Dario Autiero do Instituto de Física Nuclear em Lyon e membro da equipe OPERA, durante o seminário da sexta-feira.

Para determinar a velocidade, a equipe dividiu a distância percorrida pelos neutrinos pelo tempo que eles levaram para completar sua viagem de mão unica. A equipe computou uma precisão geral do tempo de percurso dentro de 10 nanossegundos. Eles dispunham de um sistema de medição de tempo sofisticado que recebia sinais de satélites GP`S, os quais, por sua vez, contam com relógios atômicos.

As partículas que sacodem o mundo da física

Através de suas medições, a equipe OPERA conhecia a distância do percurso de 732 km com uma precisão de ± 20 cm, aproximadamente. Em sua viagem, os neutrinos atravessas quase que unicamente rocha sólida. No Gran Sasso eles se encontravam com um detector que consiste de vários “tijolos” de filme fotográfico dentro de folhas de chumbo. Uma pequena fração de neutrinos interagia com os alvos, produzindo fótons, os quais eram observados com foto-detectores sensíveis.

“Não importa o quão bom seja a experiência, eu vou continuar cético até que seja confirmado por outra experiência independente, porque se trata de um resultado muito revolucionário”, declarou V. Alan Kostelecky, um físico teórico da Universidade de Indiana. “Afirmações extraordinárias requerem provas extraordinárias. Elas precisam de comparações cruzadas, verificações cruzadas e experiências independentes. Eu ficaria muito feliz se [uma partícula mais rápida do que a luz] fosse encontrada. Eu realmente quero ter certeza de que o efeito existe e só vou ficar convencido se ele for detectado de diversas maneiras”.

Os neutrinos acrescentam outra camada de mistérios

Os neutrinos são uma das partículas mais comuns no universo, porém também são das mais difíceis de detectar. Eles são invisíveis e raramente interagem com o resto da matéria. Foram previstos pelo físico Wolfgang Pauli em 1930 como explicação para onde ia a “energia faltante” em reações nucleares e foram finalmente detectados em experiências com feixes de partículas subatômicas em 1956 nos Estados Unidos por Frederick Reines e Clyde Cowan. São conhecidos três tipos de neutrinos: de elétron, de múon e de taon. Sabe-se que eles transportam até 99% da energia quando uma estrela explode.

“A velocidade dos neutrinos nunca foi bem caracterizada”, argumenta Alan Chodos da Sociedade Americana de Física, que, juntamente com Kostelecky e Avi Hauser, então na Universidade Yale, publicaram uma série de artigos teóricos que começou em 1985, apresentando a hipótese dos neutrinos serem “táquions” – ou seja: partículas que se movem acima da velocidade da luz.

Uma estrela supernova que explodiu em 1987 ofereceu pistas em potencial para a velocidade dos neutrinos. Ela emitiu um jato de neutrinos de elétron que chegaram à Terra antes da luz da explosão, mas Chodos pondera que outros efeitos, tais como a luz ter ficado cativa dentro da estrela que explodiu, poderia explicar essa diferença. Os neutrinos – menos sociáveis – podem ter passado de passagem [enquanto a luz ficava presa]. No entanto, a análise da supernova descobriu que a velocidade dos neutrinos estava próxima da velocidade da luz em uma parte por bilhão – um resultado 50 vezes menos significativo do que o que está sendo relatado atualmente e que era consistente com uma velocidade não superior à da luz.

Mais recentemente, a experiência MINOS (Main Injector Neutrino Oscillation Search) nos Estados Unidos relatou em 2007 indícios de deslocamentos mais rápidos do que a luz para neutrinos de muon; no entanto a qualidade dos dados estatísticos não era do mesmo nível dos resultados do OPERA.

Durante o seminário de sexta-feira, as perguntas mais frequentes de outros cientistas na audiência eram se a equipe OPERA tinha re-verificado a distência exata entre o CERN e o Gran Sasso, e se eles tinham levado totalmente em conta efeitos tais como o efeito de maré e Autiero respondeu que eles haviam realizado várias medições independentes das distâncias.

As notícias sobre “uma revolução na física” podem ser grandemente exageradas

Caso confirmada sua existência, partículas mais rápidas do que a luz poderão causar, no mínimo, uma revisão da física moderna que se apoia em uma fundação que inclui a velocidade da luz como limite cósmico de velocidade. Embora o conceito de velocidades ainda mais altas abra as portas para toda uma pletora de questões possivelmente complicadas, uma partícula mais rápida que a luz não destrói as noções correntes de causa e efeito. Quando mais não seja, observou Chodos, se ocorre apenas com neutrinos, estes não tem um efeito notável em nossa vida diária.

A violação da causalidade, acrescenta Kostelecky, requer que a observação de uma cadeia de eventos em um referencial seja invertido em um segundo referencial e isso não ocorre necessariamente se os neutrinos tiverem interações especiais com o meio por onde passam. De acordo com Kostelecky, uma classe de teorias, conhecida como Extensões do Modelo Padrão, permite a existência de partículas mais rápidas que a luz, as quais incluiriam novos fenômenos, mas não precisariam que as leis conhecidas da física fossem radicalmente re-escritas.

Ben P. Stein é o gerente editorial de Inside Science

Planetas solitários

![]()

![]()

Traduzido de: Common Jupiters?

![]()

Nova pesquisa mostra que planetas solitários do tipo Júpiter podem ser mais comuns do que estrelas

|

|

Solitário no espaço: os astrônomos descobriram um novo tipo de planeta. |

O escritor Robert Brault faz esta metáfora sobre o céu noturno: “Um trilhão de asteriscos e nenhuma explicação”. Pois a Fundação Nacional de Ciência, ao financiar os astrônomos, ajuda a conseguir algumas explicações. E um recente estudo financiado pela NSF e pela NASA conseguiu mais algumas.

Os astrônomos descobriram uma nova população de planetas classe Júpiter que flutuam solitários na escuridão do espaço, longe da luz de uma estrela. De acordo com os cientistas, esses mundos solitários provavelmente foram ejetados de sistemas planetários em fase de nascimento.

A descoberta se baseia em uma pesquisa conjunta Japão – Nova Zelândia, a Microlensing

Observations in Astrophysics (MOA) [Observação de Micro-lentes em Astrofísica], que escaneia o centro de nossa Via Láctea a cada ano. Empregando dados coletados entre 2006 e 2007, esses pesquisadores descobriram indícios do que parecem ser 10 planetas solitários com a massa aproximadamente igual à de Júpiter.

Chamados por alguns de “planetas órfãos”, esses mundos isolados foram por muito tempo assunto de teorias científicas e ficção científica, mas sua real existência continuava incerta, até agora.

As novas descobertas não só demonstram que os planetas livres existem no espaço, como também sugere que eles são razoavelmente comuns. Segundo os pesquisadores, para cada estrela em nossa galáxia, devem existir dois planetas tipo Júpiter isolados e possivelmente um número ainda maior de planetas de massa tipo Terra, embora planetas pequenos assim ainda não tenham sido detectados.

“Existem centenas de bilhões de estrelas em nossa galáxia”, diz David Bennett, co-autor deste estudo, da Universidade Notre Dame, em South Bend, Indiana. “Pensamos que planetas gigantes isolados sejam, no mínimo, tão numerosos quanto os planetas que orbitam estrelas e mais comuns do que estrelas. Esta pesquisa atual não é capaz de detectar planetas com massa menor que as de Júpiter ou Saturno, mas as teorias sugerem que planetas com massas menores, tais como a Terra, devem ser ejetados para longe de suas estrelas mães mais frequentemente e sejam, portanto, mais comuns”.

Os detalhes de suas descobertas serão publicados na edição de 19 de maio da Nature. O autor principal é Takahiro Sumi, presentemente na Universidade de Osaka University no Japão.

Observações anteriores tinham detectado objetos semelhantes a planetas em aglomerados formadores de estrelas, com massas cerca de três vezes a de Júpiter. Os cientistas ainda debatem se esses corpos gasosos se formam como estrelas ou como planetas. Estrelas pequenas e apagadiças, chamadas anãs-marrons, se formam como estrelas, a partir do colapso de bolas de poeira e gases, mas elas não tem a massa necessária para causar a ignição do combustível nuclear e brilharem como as demais estrelas. É possível que as anãs-marrons sejam pequenas como planetas.

Também é possível que planetas sejam “chutados” para fora de sistemas solares em formação, um período turbulento no qual os planetas em crescimento podem ser ejetados de suas órbitas devido a interações gravitacionais próximas com outros planetas ou mesmo outras estrelas. Sem uma estrela para orbitar, esses planetas irão se movimentar pela galáxia da mesma forma que nosso Sol e outras estrelas fazem: em órbitas estáveis em torno do centro da galáxia. O fato da presente pesquisa ter encontrado 10 “Júpiteres” isolados indica o cenário de “ejeção”, embora seja possível que ambos os mecanismos atuem ao mesmo tempo.

“Se os planetas isolados se formassem como estrelas, seria de se esperar que descobríssemos 1 ou 2 deles em nossa pesquisa, em vez de 10”, diz Bennett. “Os resultados indicam que os sistemas planetários frequentemente se tornam instáveis, com planetas sendo expulsos de seus locais de nascimento”.

A pesquisa – MOA –usa um telescópio de 1,8 m no Observatório Universitário do Monte John na Nova Zelândia para escanear regularmente as numerosas estrelas no centro de nossa galáxia em busca do que se chama de eventos de micro-lentes gravitacionais.

Esses eventos ocorrem quando algo, tal como uma estrela ou planeta, passa na frente de outra estrela mais distante. A gravidade do corpo que passa entorta a luz da estrela de fundo, fazendo com que essa fique mais brilhante e ampliada.

Corpos transeuntes com mais massa, tais como grandes estrelas, entortarão mais a luz da estrela de fundo, resultando em eventos que podem durar semanas. Corpos menores, do tipo planetas, causarão uma distorção menor e tornarão uma estrela mais brilhante por poucos dias ou menos.

A equipe de astrônomos descobriu cerca de 10 eventos de micro-lentes que indicam a presença de planetas isolados de massa aproximadamente igual à de Júpiter. Eles explicam que que não podem afirmar que alguns desses planetas não possam estar em órbitas extremamente distantes de suas estrelas, porém outras pesquisas indicam que planetas tipo Júpiter em órbitas tão distantes são raros.

De acordo com os modelos de como as estrelas são comuns em nossa galáxia, essa nova população de Júpiteres-isolados tem o dobro do número das estrelas em nossa galáxia. Da mesma forma, os pesquisadores dizem que planetas isolados podem ser expulsos de seus sistemas solares em números tão grandes que devem ser ao menos tantos quantos os planetas como o nosso, em órbita de uma estrela. .

Com base nessas predições, nossa galáxia pode abrigar centenas de bilhões de mundos solitários. A nova pesquisa é como um censo populacional: mediante a amostragem de uma parte da galáxia e com o conhecimento das limitações da pesquisa, os pesquisadores podem estimar um número de planetas isolados.

Um segundo grupo de observação de micro-lentes, o Optical Gravitational Lensing Experiment (OGLE), contribuiu para esta descoberta. O grupo OGLE também observou vários desses eventos de micro-lentes e suas observações confirmaram, de forma independente, as análises do Grupo MOA. O falecido Bohdan Paczynski foi uma peça-chave ao instigar a cooperação entre o OGLE e outros grupos a partilharem seus dados assim que obtidos. Isso foi importante para a descoberta de muitos fenômenos de micro-lentes e, em grande parte, foi um dos motivos para que o MOA entrasse em contato com o OGLE para confirmar os resultados e escreverem um artigo em conjunto.

Veja o vídeo:

Um planeta solitário sob uma lente de aumento cósmica

.

![]()

|

Essa animação ilustra a técnica usada para descobrir os planetas isolados classe Júpiter, no espaço. Os astrônomos descobriram indícios de 10 desses mundos que se pensa terem sido ejetados de seus sistemas planetários durante a formação dos mesmos. . A animação tem início mostrando a agitada região central de nossa Via Láctea, onde os planetas foram encontrados com um telescópio com base em terra. Então, dá um zoom em uma estrela que fica mais brilhante. Esse brilho aumentado é causado pela passagem de um planeta isolado não visível (e foi grandemente exagerado na animação). Quando acontece de um planeta passar na frente de uma estrela mais distante, sua gravidade faz com que a luz da estrela entorte e esse entortamento resulta em um brilho maior da estrela, observado pelo telescópio. Neste efeito, chamado de micro-lente gravitacional, a gravidade do planeta funciona como uma lente de aumento. A próxima parte da animação mostra como o fenômeno de micro-lente de uma estrela pareceria se pudesse ser observado com uma resolução ainda maior. O ponto azul é o planeta (ampliado para ficar visível). O ponto brilhante do centro é a estrela, mostrado no meio de outras estrelas menores em vermelho e amarelo. Quando o planeta passa, sua gravidade faz com que a luz das estrelas se divida em várias imagens, espelhadas e reversas. Quando o planeta não está diretamente na frente da estrela principal, as várias imagens dela são retorcidas em arcos. O resultado geral é um aumento temporário do brilho da estrela. Os astrônomos se referem ao formato circular que pode ser visto quando planeta passa pelas estrelas de “Anel de Einstein”. Quandoum planeta fica diretamente na frente de uma estrela, ele faz com que a luz da estrela se dobre em um completo Anel de Einstein. Quando o planeta se aproxima da estrela, faz com que a imagem da estrela pareçam distorcidas para longe do anel, ou invertidas dentro do anel. A duração do evento de micro-lente revela a massa aproximada do corpo passante. Objetos tipo Júpiter fazem com que a estrela aumente o brilho mais rapidamente, por um ou dois dias apenas. Uma estrela que passasse faria com que o brilho da estrela mais distante aumentasse por um período de semanas. A densidade geral das estrelas, assim como a luminosidade de suas imagens invertidas dentro dos anéis de Einstein, foi exagerada nesta animação para ajudar a mostrar os efeitos das lentes gravitacionais. É muito raro que um planeta passante distorça a luz de várias estrelas ao mesmo tempo. A animação termina com uma concepção do artista sobre como deve se parecer um mundo tipo Júpiter-isolado. O efeito de micro-lente gravitacional mostrado tem como base dados de simulação criados por M. Freeman (Universidade de Auckland, Nova Zelândia). Crédito: NASA/JPL-Caltech |

Sonda de Gravidade B: Einstein (como sempre) está certo

|

|

Concepção artística da espaçonave Gravity Probe B em órbita polar em torno da Terra. Crédito da Imagem: Stanford. |

Traduzido de: NASA’s Gravity Probe B Confirms Two Einstein Space-Time Theories

A missão da NASA Gravity Probe B (GP-B = Sonda de Gravidade B) confirmou duas previsões chave derivadas da Teoria da Relatividade Geral de Albert Einstein, cuja comprovação era exatamente a missão da espaçonave.

O experimento, lançado em 2004, empregou quatro giroscópios ultra-precisos para medir o hipotético efeito geodésico: a deformação do espaço-tempo no entorno de um corpo com gravidade e o arrasto de referenciais, a quantidade de deformação causada por um objeto giratório com massa na estrutura do espaço-tempo em seu entorno.

A GP-B estabeleceu os valores de ambos os efeitos com uma precisão sem precedentes, apontando para uma estrela solitária, IM Pegasi, enquanto descrevia uma órbita polar ao redor da Terra. Se a gravidade não afetasse o espaço-tempo, os giroscópios da GP-B apontariam na mesma direção para sempre enquanto estivessem em órbita. Mas, confirmando as teorias de Einstein, os giroscópios sofreram minúsculas, porém mensuráveis, mudanças de direção em sua rotação, causadas pela atração da gravidade da Terra.

A descoberta está publicada na versão online de Physical Review Letters.

“Imaginem a Terra como se ela estivesse imersa em mel. Na medida em que o planeta girar, o mel em torno dele vai se deformar e a mesma coisa acontece com o espaço-tempo”, declara Francis Everitt, o principal investigador da GP-B na Universidades Stanford. “A GP-B confirmou duas das previsões mais profundas do universo de Einstein que tem profundas implicações na pesquisa astrofísica. Igualmente, as décadas de inovação tecnológica por trás da missão vão deixar uma duradoura marca na Terra e no Espaço”.

A GP-B é uma das missões mais compridas da história da NASA, remontando o envolvimento da agência com o experimento ao segundo semestre de 1963 com as primeiras verbas para o desenvolvimento de um experimento com giroscópios relativísticos. Nas décadas seguintes o desenvolvimento levou a tecnologias revolucionárias para controlar as perturbações ambientes na espaçonave, tais como o arrasto aerodinâmico, campos magnéticos e variações térmicas. O colimador de estrelas e os giroscópios empregados foram os mais precisos que já foram um dia projetados e produzidos.

A GP-B completou sua coleta de dados e foi descomissionada em dezembro de 2010.

“Os resultados da missão terão um impacto de longa duração sobre o trabalho dos físicos teóricos”, afirma Bill Danchi, astrofísico senior e um dos cientistas do programa no quartel-general da NASA em Washington. “Qualquer refutação futura da Teoria da Relatividade Geral de Einstein terá que buscar medições ainda mais precisas do que o notável trabalho realizado pela GP-B”.

Essas inovações criadas para a GP-B foram empregadas nas tecnologias GPS que permitem que aeronaves pousem sem auxílio de (outros) instrumentos. Outras tecnologias desenvolvidas para a GP-B foram aplicadas na missão da NASA para a exploração do Fundo Cósmico de Micro-ondas que estabeleceu com precisão a radiação de fundo do universo. Essa medição foi o melhor ponto de apoio para a teoria do Big Bang e levou a um prêmio Nobel para o físico da NASA John Mather.

O conceito de satélite sem arrasto, cujo modelo pioneiro foi a GP-B, tornou possíveis vários satélites de observação da Terra inclusive o Gravity Recovery

and Climate Experiment (Recuperação de [Dados sobre a] Gravidade e Experiência Climática) da NASA e o Gravity field and

steady-state Ocean Circulation Explorer (Explorador do Campo Gravitacional e Circulação em Estado Estacionário dos Oceanos) da Agência Espacial Européia. Esses satélites fornecem as mais precisas medições do formato da Terra, um dado crítico para a precisa navegação em terra ou no mar, e a compreensão do relacionamento entre a circulação oceânica e os padrões climáticos.

A GP-B também ampliou as fronteiras do conhecimento e forneceu um campo de treinamento prático para 100 estudantes de doutorado e 15 de mestrado em diversas universidades dos Estados Unidos. Mais de 350 estudantes universitários e mais de quatro dúzias de estudantes secundaristas também trabalharam no projeto junto com cientistas de ponta e engenheiros aero-espaciais da indústria civil e do governo. Uma das estudantes universitárias que trabalhou na GP-B se tornou a primeira mulher astronauta, Sally Ride. Outro foi Eric

Cornell que recebeu o Premio Nobel de Física em 2001.

“A GP-B fez acréscimos à base de conhecimentos sobre a relatividade de modo importante e seu impacto positivo será sentido nas carreiras dos estudantes cujas educações foram enriquecidas pelo projeto”, declarou Ed Weiler, administrador associado do Diretório de Missões Científicas do quartel-general da NASA.

O Centro de Voo Espacial Marshall em Huntsville, Alabama, ferenciou o programa Gravity Probe-B para a agência. A Universidade Stanford, principal contratado da NASA para a missão, concebeu o experimento e foi responsável pelo projeto e integração da instrumentação científica, operação da missão e análise dos dados. A Lockheed Martin Corp. de

Huntsville projetou, integrou e testou o veículo espacial e alguns de seus componentes principais.