(Inside Science) – O Prêmio Nobel de Física de 2015 foi concedido a dois físicos, um japonês e outro canadense, pela descoberta de que as abundantes partículas subatômicas, conhecidas como neutrinos, podem mudar suas identidades, um processo que requer que as pasrtículas – antes tidas como sem massa de repouso, como o fóton – realmente tenham uma massa.

O prêmio foi concedido conjuntamente a Takaaki Kajita da Universidade de Tóquio no Japão e a Arthur B. McDonald da Queen’s University em Kingston, Canadá “pela descoberta da oscilação de neutrinos que demonstra que os neutrinos têm massas”. Os dois agraciados lideraram dois dos principais observatórios subterrâneos em lados opostos do mundo. Kajita fazia parte da colaboração Super-Kamiokande no Japão e McDonald liderava um grupo no Observatório de Neutrinos Sudbury (Sudbury Neutrino Observatory, ou SNO) no Canadá.

“Os neutrinos são um enigma e o Prêmio Nobel de Física deste ano honra um passo fundamental para descobrir a natureza do neutrino”, declarou Olga Botner, membro do Comitê para Física no Nobel e professora de física na Universidade de Uppsala na Suécia.

“Esta foi uma grande premiação”, declarou o físico Michael Turner, diretor do Instituto Kavli de Física Cosmológica da Universidade de Chicago, que observou que este é o quarto Prêmio Nobel atribuído à pesquisa sobre neutrinos,desde 1988 até 2015.

O anúncio de hoje foi “duplamente maravilhoso”, comemorou Gene Beier, professor de física na Universidade da Pennsylvania, também um porta-voz do experimento SNOt. Beier também já trabalhou na experiência Kamiokande II, a predecessora do Super-Kamiokande.

Ambos experimentos deram grandes respostas.

“Os neutrinos são partículas fundamentais”, explicou McDonald pelo telefone, durante o anúncio desta manhã do Nobel na Suécia.

“O neutrino tem uma massa e esta é mais de um milhão de vezes menor que a do elétron”, disse Botner.

“Os neutrinos têm um ‘golpe’ acima de seu peso. Eles contribuem com tanta massa quanto as estrelas”, disse Turner.

Eles são um dos tipos conhecidos mais abundantes no universo, perdendo apenas para os fótons, as partículas de luz. Ainda assim, eles são elusivos e misteriosos. Ainda que, segundo as estimativas, bilhões deles passem através das pessoas a cada segundo, eles “atravessam nosso corpo sem que sintamos ou percebamos”, acrescenta Botner.

Na década de 1930, o físico teórico Wolfgang Pauli propôs inicialmente sua existência para explicar a energia que faltava em um tipo de reação nuclear, conhecida como “decaimento beta“. Em uma carta datada de 1930, o físico, então com 30 anos, saudava seus colegas como “Caros Senhoras e Senhores Radiativos” (em alemão). Ele depois se desculpou, chamando (segundo relatos) sua proposta de “uma coisa terrível. Eu postulei uma partícula que não pode ser detctada”. O neutrino não irradiaria qualquer forma de luz ou campo eletromagnético. Acreditava-se que o neutrino seria eletricamente neutro – o que o tornaria ainda mais difícil de detectar.

O físico Enrico Fermi deu a essa partícula o nome “neutrino”, ou “coisinha neutra” em italiano. Acreditava-se que eles viajassem perto de ou na própria velocidade da luz.

Os físicos vieram a aceitar a ideia que os neutrinos foram produzidos em abundância no início do universo, em reações nucleares no interior das estrelas e em colisões entre raios cósmicos e a atmosfera. A maioria dos neutrinos passa por dentro da Terra sem serem detectados. Ocasionalmente eles colidem com algo e podem ser detectados.

Foi somente em 1956 que os primeiros sinais de neutrinos foram detectados em reações nucleares em experiências realizadas pelos físicos Frederick Reines e Clyde Cowan nos EUA. Cowan morreu em 1974, mas Reines foi honrado com um Prêmio Nobel (compartilhado) em 1995 pela detecção do neutrino.

No entanto, muito sobre o neutrino permanecia desconhecido.

Nos anos 1960, o físico Ray Davis conduziu experiências estudando os neutrinos vindos do Sol. Na Terra, os pesquisadores detectaram apenas um terço dos neutrinos que se esperava que emanassem do Sol. Será que os cientistas não conheciam com exatidão o Sol, ou estava acontecendo alguma coisa com os neutrinos? Davis compartilhou o Prêmio Nobel de Física em 2002 pela detecção de neutrinos cósmicos, juntamente com o físico jaopnês Masatoshi Koshiba que ajudou a projetar o experimento Kamiokande no Japão para confirmar os resultados de Davis.

Os físicos trabalharam ao longo de décadas para resolver o mistério dos neutrinos que faltavam. De acordo com o [atual] Modelo Padrão da física de partículas, existem três tipos de neutrinos, conhecidos como neutrinos de elétron, neutrinos de muon e neutrinos de tauon que acompanham as partículas com carga conhecidas como elétron, muon e tauon. O Sol produz apenas neutrinos de elétron. Alguns físicos sugeriram que alguns neutrinos de elétron se transformavam nos outros tipos de neutrinos em seu caminho para a Terra.

Mas antes de resolver este problema, os cientistas precisavam construir detectores suficientemente bons. Estes teriam que ser construídos dentro de rocha sólida para bloquear os outros tipos de partículas que abafariam os sinais dos neutrinos .

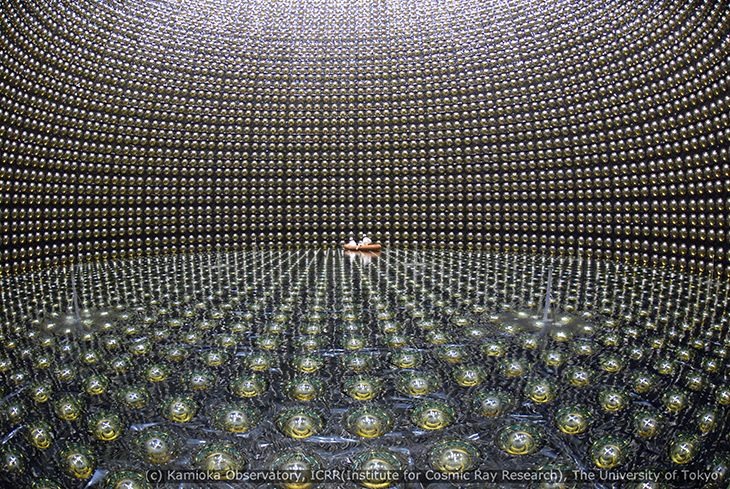

Em 1996, o detector Super-Kamiokande começou a funcionar no Japão. O Super-K foi construído em uma antiga mina de zinco, debaixo de 1.000 metros de rocha sólida. Contendo 50.000 toneladas de água, o Super-K foi projetado para detectar neutrinos de muon vindos das atmosfera, tanto da atmosfera logo acima, como aqueles que tivessem transpassado todo o globo. Ocasionalmente os neutrinos colidiriam com um elétron ou com um núcleo atômico em uma molécula d’água, e assim geraria uma centelha de luz. Esse poderoso detector subterrâneo só encontrou rastros de 5.000 neutrinos em seus primeiros dois anos de funcionamento.

Anallisando os dados, os pesquisadores descobriram uma diferença entre os neutrinos de muon detectados vindos de logo acima e aqueles que tinham atravessado a Terra. Então concluiram que os neutrinos de muon que atravessavam o globo se transformavam em um tipo diferente de neutrino.

Enquanto isso, o Observatório de Neutrinos Sudbury no Canadá, se empenhava em estudar os neutrinos vindos do Sol. De maneira análoga ao Super-K, ele se localizava em uma mina de níquel. No entanto ele ficava ainda mais enterrado, debaixo de 2.000 metros de rocha. Ele detectou ainda menos neutrinos vindos do Sol – cerca de três por dia em seus primeiros dois anos.

Seu tanque era preenchido com 1.000 toneladas de água pesada. Uma molécula d’água comum contém dois átomos de hidrogênio e um átomo de oxigênio. Na água pesada os hidrogênios são substituídos pelo seu primo mais pesado, o deutério que tem um nêutron extra. Vários tipos de colisões podem ocorrer na água pesada, onde os neutrinos de elétron produzem reações diferentes dos outros tipos de neutrino, o que permitia aos pesquisadores distinguí-los. Eles descobriram os dois terços dos neutrinos que passaram despercebidos nas experiências anteriores e também descobriram indícios que alguns neutrinos de elétron estavam se transformando nos outros tipos.

“Sim, foi mesmo um momento ‘eureka’. Nós conseguimos ver que os neutrinos pareciam estar se transformando de um tipo para outro”, disse McDonald hoje, durante o anúncio do Nobel.

O físico Peter Wittich, atualmente na Universidade Cornell, escreveu sua tese de Ph.D. sobre os resultados do SNO, como relata Beier, porém teve que aguardar até que os pesquisadores verificassem tudo para eliminar possíveis fontes de erro em seu experimento. Ele escondeu sua tese do público durante um ano enquanto o SNO confirmava os resultados.

O que o público pode não perceber é que essa é “a parte dura de qualquer experiência”, diz Beier, sobre a eliminação das fontes de erros. “Obter uma resposta é mais fácil do que se assegurar que ela está correta”, acrescenta ele.

Se os neutrinos estavam se transformando, como se confirmou posteriormente, isto tinha enormes implicações. Os físicos não sabiam se os neutrinos tinhas massa nula, como os fótons, ou tinham uma pequena massa. A teoria Padrão sugeria que eles não tinham qualquer massa. Turner observa: “Segundo o [então] Modelo Padrão, eles deveriam ter massa nula”. Entretanto, se os neutrinos estavam mudando de tipo do jeito que os cientistas estavam constatando, eles teriam que ter massa…

Isto “deu os indícios de uma física além do [então] Modelo Padrão”, reconta Turner, e mostrava “que ainda havia algo mais a compreender sobre partículas e forças”.

Então os neutrinos podiam ter a chave para a expansão de nossa compreensão da matéria. Como os físicos sabem que eles têm massa, ao contrário do que previa o [então vigente] Modelo Padrão de física de partículas?

A física quântica sugere que qualquer objeto, tal como um elétron, pode agir tanto como uma partícula sólida, quanto como uma onda. Neutrinos também. Vindos do Sol, os neutrinos podem agir como ondas e possuir características de todos os três tipos de neutrinos. Quando são detectados em um experimento, eles são registrados como partículas e têm que assumir a identidade de um dos três tipos. As quantidades relativas dos três tipos de neutrinos que são detectados, depende das diferenças de massas entre os três tipos. O fato dos neutrinos poderem ir de um tipo para o outro e serem registrados em quantidades diferentes, sugere que eles têm massas ligeiramente diferentes.

Desde então, segundo Beier, outros importantes experimentos sobre neutrino vêm sendo feitos. O KamLAND começou um pouco depois. Este confirmou que o SNO estava detectando oscilações de neutrinos.

“Nós ficamos muito satisfeitos em termos sido capoazes de adicionar ao conhecimento mundial em um nível muito fundamental”, declarou hoje McDonald durante o anúncio do Nobel.

A descoberta das oscilações dos neutrinos levanta um pouco mais o véu que encobre o misterioso neutrino e, ao mesmo tempo, abre todo um novo campo de questões ainda sem resposta.

Ben P. Stein, diretor do Inside Science, vem cobrindo a física como escritor de ciências e deitor desde 1991. Seu Twitter é @bensteinscience.

Pesquisadores e membros da colaboração CAST instalam seus equipamentos para alinhar o telescópio com a posição do Sol.

Pesquisadores e membros da colaboração CAST instalam seus equipamentos para alinhar o telescópio com a posição do Sol.