Mais uma teoria sobre a Matéria Escura

Uma teoria simples pode explicar a misteriosa matéria escura

Crédito: Michael Smeltzer, Vanderbilt University |

||||

A maior parte da matéria do universo pode ser feita de partículas que possuem um incomum campo eletromagnético em forma de anel, chamado anapolo.

Esta proposta, que dota as partículas de matéria escura com uma forma rara de eletromagnetismo, foi reforçada por uma análise detalhada realizada por um par de físicos teóricos da Universidade Vanderbilt: o Professor Robert Scherrer e o doutor-associado Chiu Man Ho. Um artigo sobre a pesquisa foi publicado online no mês passado por Physics Letters B.

“Existem muitas teorias diferentes acerca da natureza da matéria escura. O que eu gosto nesta teoria é sua simplicidade, singeleza e o fato de que pode ser testada”, disse Scherrer.

No artigo, intitulado “Anapole Dark Matter,” os físicos propõem que a matéria escura – um tipo invisível de matéria que perfaz 85% de toda a matéria do universo – pode ser constituída de um tipo básico de partícula chamado Férmion de Majorana. A existência desta partícula foi prevista em 1930, mas ela tem teimosamente resistido a ser detectada.

Um bom número de físicos sugeriu que a matéria escura seja feita de Férmions de Majorana, porém Scherrer e Ho realizaram cálculos detalhados que demonstram que essas partículas são particularmente adequadas a possuir um tipo raro de campo eletro-magnético em forma de anel, chamado um anapolo. Este campo lhes conferiria propriedades diferentes das partículas que possuem campos mais comuns, do tipo com dois polos (norte e sul, positivo e negativo) e explica por que elas são tão difíceis de detectar.

“A maioria dos modelos para a matéria escura supõe que ela interaja por meio de forças exóticas que não encontramos no dia-a-dia. A matéria escura anapolar usa o mesmo eletromagnetismo que aprendemos na escola – a mesma força que faz com que os imãs grudem em sua geladeira ou fazem com que um balão de ar esfregado nos cabelos grude no teto”, explica Scherrer. “Além disso, o modelo faz predições muito específicas acerca das quantidades que deverão ser detectadas nos enormes detectores de matéria escura enterrados no chão por todo o mundo. Tais predições mostram que a existência da matéria escura anapolar deve ser comprovada ou descartada em breve por tais experimentos”.

Férmions são partículas como o elétron e o quark, que são os componentes básicos da matéria. Sua existência foi predita por Paul Dirac em 1928. Des anos depois, pouco antes de desaparecer misteriosamente no mar, o físico italiano Ettore Majorana produziu uma variante da fórmula de Dirac que prevê a existência de um férmion eletricamente neutro. Desde então, os físicos vêm buscando os Férmions de Majorana. O candidato inicial foi o neutrino, porém os cientistas não conseguiram determinar a natureza dessa partícula elusiva.

A existência da matéria escura foi também inicialmente proposta nos anos 1930 para explicar as discrepâncias nas velocidades de rotação dos aglomerados galáticos. Subsequentemente, os astrônomos descobriram que a rotação das estrelas em torno das galáxias individuais também estava fora de sincronia. As observações detalhadas mostraram que as estrelas afastadas do centro das galáxias estão girando em velocidades muito mais altas do que poderia ser explicado pela quantidade de matéria visível que as galáxias contêm. Presumir que elas contenham uma grande quantidade de matéria “escura” invisível é a conclusão mais lógica para explicar tais discrepâncias.

Os cientistas hipotetizaram que a matéria escura não pode ser vista pelos telescópios porque ela não interage de maneira forte com a luz e outras radiações eletromagnéticas. Com efeito, as observações astronômicas basicamente descartaram a possibilidade de que as partículas de matéria escura tenham cargas elétricas.

Entretanto, mais recentemente, vários cientistas consideraram partículas de matéria escura que não teham cargas elétricas, mas têm dipolos elétricos ou magnéticos. O único problema é que, mesmo que esses modelos complicados são descartáveis em favor de partículas de Majorana. Esta é uma das razões pelas quais Ho e Scherrer examinaram mais de perto a versão de matéria escura com um momento magnético anapolar.

“Embora os Férmions de Majorana sejam eletricamente neutros, as simetrias fundamentais da natureza os proíbem de adquirir quaisquer propriedades eletromagnéticas, exceto se foram anapolares”, diz Ho. A existência de um anapolo magnético foi previsto pelo físico soviético Yakov Zel’dovich em 1958. Desde então, isso foi observado na estrutura magnética dos núcleos dos átomos do césio-133 e do itérbio-174.

Partículas com os familiares dipolos elétrico e magnético interagem com campos eletromagnéticos até quando estão estacionárias. As partículas com anapolos, não. Estas precisam estar em movimento antes que possam interagir e quanto mais rápido se moverem, mais forte será a interação. Em função disto, as partículas anapolares teriam sido muito mais interativas durante os estágios iniciais do universo e teriam se tornado cada vez menos interativas na medida em que o universo se expandiu e esfriou.

As partículas de matéria escura anapolar sugeridas por Ho e Scherrer teriam se aniquilado no universo primitivo tal como quaisquer outras partículas de matéria escura propostas, e as partículas remanescentes deste processo formariam a matéria escura que vemos hoje [NT: ou não vemos…]. Porém, como a matéria escura está se movendo muito mais devagar no presente e porque as interações anapolares dependem de quão depressa elas se movem, essas partículas teriam escapado da detecção até agora, porém por muito pouco.

Um novo segredo gelado

Mistério derretido: H2O revela um novo segredo

|

Imagem cortesia do Oak Ridge National Laboratory |

||||

Washington, D.C.— Empregando novas técnicas revolucionárias, uma equipe liderada por Malcolm Guthrie da Carnegie fez uma chocante descoberta sobre como o gelo se comporta sob pressão, modificando ideias que vigiam a quase 50 anos. Suas descobertas podem modificar nossa compreensão sobre como a molécula de água responde a condições encontradas nas profundezas dos planetas e pode ter outras implicações nas ciências de energia. Este trabalho foi publicado em Proceedings of the National Academy of Sciences.

Quando a água se torna gelo, suas moléculas são reunidas em uma estrutura cristalina através das pontes de hidrogênio. As pontes de hidrogênio são muito versáteis e, em função disto, os cristais de gelo podem apresentar uma chocante diversidade com ao menos 16 tipos de estrutura diferentes.

Em todas essas formas de gelo, a simples molécula de H2O é o elemento básico de construção. Entretanto, em 1964 foi previsto que, sob pressão suficiente, as pontes de hidrogênio pode se reforçar ao ponto onde elas podem mesmo romper as moléculas. A possibilidade de observar diretamente uma molécula de água dissociada se provou uma isca fascinante para os cientistas e foi objeto de contínuas pesquisas pelos últimos 50 anos. Nos meados da década de 1990, várias equipes, inclusive uma da Carnegie, observou a transição por meio de técnicas de espectroscopia. Porém estas técnicas eram indiretas e somente conseguiam uma parte do quadro.

Um dos métodos preferidos é “ver” diretamente os átomos de hidrogênio – melhor dizendo, os prótons. Isso pode ser feito quicando nêutrons no gelo e medindo cuidadosamente sua dispersão. Porém a aplicação desta técnica em altas pressões para ver a molécula se dissociar simplesmente não era possível até agora. Guthrie explica: “só se consegue chegar a essas pressões extremas se suas amostras de gelo forem realmente pequenas. Infelizmente, isso torna os átomos de hidrogênio muito difíceis de enxergar”.

A Fonte de Espalação de Nêutrons (Spallation Neutron Source = SNS) foi aberta no Laboratório Nacional de Oak Ridge no Tennessee em 2006, para fornecer um novo e extremamente brilhante suprimento de nêutrons. Tendo projetado uma nova classe de ferramentas, otimizadas para explorar esse fluxo sem precedentes de nêutrons, Guthrie e sua equipe – Russell Hemley, Reinhard Boehler e Kuo Li, da Carnegie, juntamente com Chris Tulk, Jamie Molaison e António dos Santos do Laboratório Nacional de Oak Ridge –conseguiram obter os primeiros vislumbres dos próprios átomos de hidrogênio no gelo a pressões sem precedentes, da ordem de 500.000 vezes a pressão atmosférica.

“Os nêutrons nos dizem o que outras técnicas não conseguiam”, diz Hemley, diretor do Laboratório de Geofísica da Carnegie. “Os resultados indicam que a dissociação das moléculas de água segue dois mecanismos diferentes. Algumas moléculas começam a se dissociar a pressões bem mais baixas e por um caminho diferente do previsto no clássico artigo de 1964”.

“Nossos dados pintam um quadro totalmente novo acerca do gelo”, comenta Guthrie. “Os resultados têm não só amplas consequências para a compreensão das ligações na H2O; as observações também podem apoiar uma teoria anteriormente proposta de que os prótons no gelo do interior dos planetas podem ser móveis, mesmo que o gelo continue sólido”.

E esta surpreendente descoberta pode se provar apenas o início de descobertas científicas. Tulk enfatiza que “conseguir ‘enxergar’ o hidrogênio com nêutrons não é importante só para os estudos do gelo. Isso pode se revelar uma descoberta capaz de mudar todo o jogo na técnica. As aplicações poderiam se estender a sistemas críticos para desafios socialmente críticos, tais como o campo da energia. Por exemplo, a técnica pode levar a uma compreensão melhor de hidratos de clatrato contendo metano e até de materiais para armazenagem de hidrogênio que podem, um dia, abastecer automóveis”.

Formação de Planetas: uma possível dica

‘Armadilha de Poeira’ em torno de uma estrela distante pode ser a solução para o mistério da formação de planetas

Com base no baú de tesouros das recentes descobertas, os astrônomos agora sabem que os planetas são algo muito comum em nossa galáxia e podem ser comuns em todo o universo. Embora os planetas pareçam se formar prontamente, o real processo de sua formação permanece um mistério e os astrônomos continuam buscando as peças que faltam para este quebra-cabeças cósmico.

Uma equipe internacional de astrônomos, usando o novo telescópio Atacama Large Millimeter/ submillimeter Array (ALMA) descobriu uma intrigante pista que pode ajudar a explicar como os planetas rochosos são capazes de evoluir em um turbilhonante disco de poeira e gases.

Imageando as regiões externas de um jovem sistema solar conhecido como Oph IRS 48, que fica a 390 anos-luz da Terra aproximadamente na constelação Ofiúco (Ophiuchus – o Serpentário), os astrônomos descobriram uma formação em forma de crescente, conhecida como “armadilha de poeira”. Os pesquisadores especulam que essa característica recém-descoberta é verdadeiramente um casulo protetor onde podem acontecer os primeiros passos para a formação de planetas, asteroides e cometas.

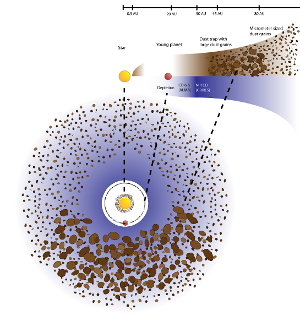

Quando os astrônomos tentaram modelar a evolução dos grãos de poeira em corpos proto-planetários, tais como cascalhos e pedregulhos, eles encontraram um problema. Assim que os grãos de poeira se aglomeravam acima de um certo tamanho, eles tendiam a se auto-destruir, ou pela colisão com outros aglomerados, ou por serem atraídos pela estrela-mãe. Para conseguirem vencer esse irritante limite de tamanho, os astrônomos teorizaram que redemoinhos rodopiantes que se formassem no disco, poderiam criar as armadilhas de poeira, regiões que permitiriam que as partículas de poeira se aglomerassem, preparando eventualmente o palco para a formação de objetos cada vez maiores.

“Existe um importante obstáculo na longa cadeia de eventos que vai de pequenos grãos de poeira até objetos do tamanho de planetas”, conta Til Birnstiel, um pesquisador do Centro de Astrofísica Harrvard-Smithsonian em Cambridge, Massachusetts e co-autor do artigo publicado na Science. “Nos modelos de computador da formação de planetas, os grãos de poeira têm que crescer de objetos menores que um mícron até objetos com dez vezes as massa da Terra em poucos milhões de anos. Porém, assim que as partículas ficam suficientemente grandes, elas ganham velocidade e ou colidem entre si, o que as manda de volta à primeira casa, ou lentamente derivam para dentro, o que acaba com qualquer crescimento ulterior”.

Para salvar os grãos de poeira desse destino, os astrônomos propuseram que um vórtex, essencialmente uma corcova no disco, produziria uma área de alta pressão e protegeria os aglomerados de poeira em crescimento.

Entretanto, a criação de uma armadilha de poeira requer a mão amiga de um objeto muito grande, tal como um planeta gigante gasoso, ou uma estrela companheira. Na medida em que esse objeto secundário atravessa o disco, ele cria uma trilha limpa em torno da estrela e produz os vórtices e rodamoinhos essenciais em sua esteira.

Estudos anteriores de Oph IRS 48 tinham revelado um anel muito uniforme de monóxido de carbono e pequenos grãos de poeira em torno da estrela, sem qualquer vestígio de uma teórica armadilha de poeira. Entretanto, eles também detectaram uma grande falha entre as porções interna e externa do disco, o que seria um provável rastro de um planeta muito massivo, na ordem de 10 massas de Júpiter, ou uma estrela companheira. Um tal objeto poderia produzir as condições necessárias para uma armadilha de poeira.

Usando o ALMA, os pesquisadores conseguiram observar simultaneamente o gás e os grãos de poeira muito maiores, revelando algo que outros telescópios não podiam: uma protuberância na parte externa do disco.

“No início o formato da poeira nas imagens foi uma completa surpresa para nós”, diz Nienke van der Marel, um estudante de doutorado no Observatório Leiden na Holanda e principal autor do artigo. “No lugar de um anel que esperávamos ver, encontramos um formato, bem claro, de uma castanha de cajú. Nós tivemos que nos convencer de que a característica era real, mas a força do sinal e a precisão das observações do ALMA não deixaram qualquer dúvida acerca da estrutura”.

Embora as observações do ALMA só tenham revelado a estrutura externa do disco, que fica a mais de 50 vezes a distância da Terra ao sol, o princípio ainda seria o mesmo mais perto da estrela onde se formariam os planetas rochosos. “Esta estrutura que vemos com o ALMA poderia ser reduzida em escala para representar o que pode estar acontecendo no sistema solar interior, onde os planetas mais parecidos com a Terra iriam se formar”, diz Birnstiel. “No caso destas observações, entretanto, podemos estar vendo algo análogo à formação do Cinturão de Kuiper ou da Nuvem de Oort Cloud, regiões de nosso Sistema Solar onde se acredita que os cometas se originam”.

Estas observações foram realizadas com apenas uma parte das 66 antenas que o ALMA deve vir a ter. Quando o sistema completo estiver em funcionamento no fim deste ano, o ALMA terá a visão mais acurada de qualquer observatório astronômico e será uma importante ferramenta para a compreensão do processo de formação de planetas.

O ALMA é uma instalação astronômica internacional, uma parceria entre a Europa, a America do Norte e a Ásia Oriental, em cooperação com a República do Chile. A construção e a operação do ALMA são lideradas pelo Observatório Europeu do Sul (ESO), pelo National Radio Astronomy Observatory (NRAO) dos EUA e pelo Observatório Astronômico do Japão.

###

Aquecimento Global – CO2 ou CFC? [2]

Não foi a toa que eu recomendei ao leitor que absorvesse o post anterior – traduzido de um press-release da Universidade de Waterloo (Canadá), divulgado por meio do EurekAlert, o noticioso da American Association for the Advancement of Science (AAAS) – com mais do que uma pitada de sal. O próprio site do EurekAlert tem (lá escondidinho no rodapé) um link para o seguinte disclaimer:

AAAS disclaims responsibility for the accuracy of material posted to EurekAlert! by contributing institutions and for the use of any information obtained through EurekAlert!. Support from sponsors does not influence content or policy.

Em português;

A AAAS não se responsabiliza pela precisão do material postado no EurekAlert! pelas instituições contribuintes e pelo uso de qualquer informação obtida através do EurekAlert! O apoio de patrocinadores não tem qualquer influência sobre o conteúdo ou as políticas.

Ou seja: vendemos o peixe pelo mesmo preço que compramos…

Claro que é de se supor que uma Universidade tem um nome a zelar e não vai publicar um press-release bombástico se não for uma notícia com um mínimo de credibilidade científica, né?… Errado!

Uma primeira coisa que se verifica ao seguir o EurekAlert é que certas descobertas, feitas por equipes compostas por pesquisadores de várias universidades, são livremente apregoadas por cada uma delas como se, sem elas, o resto do mundo continuaria na ignorância.

Outra é que a maioria dos trabalhos ditos “revolucionários” não o são… Uma boa rule of thumb para detectar bullshit é o título: se nele aparecerem os termos “sheds a new light” e/ou “groundbreaking” provavelmente é algo insignificante. Outro indício é o emprego do termo “the Holy Grail of (whatever)”.

Neste caso, em particular, o perpetrador autor do press-release não usou nenhum desses termos. Só exagerou um pouco na fanfarra… e eu caí como um patinho…

O site SkepticalScience publicou uma contestação do trabalho do Professor Lu: Lu Blames Global Warming on CFCs (Curve Fitting Correlations) que denuncia a total falta de rigor científico do novo trabalho de Lu. Entre outras coisas, a principal acusação é que Lu simplesmente desprezou todos os dados que associam o aumento das concentrações de CO2 na atmosfera ao aquecimento global e se concentrou apenas nos que serviam como argumento para sua tese sobre os CFCs. E de uma certa desonestidade científica, ao considerar apenas as temperaturas de superfície como indicadores – notadamente se lembrarmos que a maior parte da superfície terrestre é coberta por oceanos e a temperatura média destes tem aumentado constantemente, coisa que Lu simplesmente deixa de lado.

Quibando do post do SkepticalScience:

No entanto, um desequilíbrio global de energia não tem impacto apenas sobre as temperaturas da superfície. Na verdade, somente cerca de 2% do aquecimento global é gasto em aquecer a atmosfera, enquanto 90% aquece os oceanos. Ao longo da última década, o aquecimento dos oceanos e geral da terra continuaram a aumentar rapidamente, acumulando o equivalente à detonação de 4 bombas nucleares de Hiroshima por segundo (Figura 1).

Figura 1: Aquecimento terrestre, atmosférico e das calotas de gelo (vermelho); aumento do Conteúdo de Calor Oceânico (OHC) de 0 a 700m (azul claro); e aumento do Conteúdo de Calor Oceânico de 700 a 2.000 metros (azul escuro). Fonte: Nuccitelli et al. (2012).

A refutação continua, se perguntando por que uma Universidade como Waterloo teria difundido um press-release bombástico assim, mesmo considerando que o artigo de Lu foi aceito por uma publicação “de baixo impacto” (para ser bem claro: pouco confiável). O SkepticalScience é cavalheiresco o suficiente para não tirar conclusões… mas só o fato de que esse press-release foi imediatamente saudado pelos órgãos da imprensa porta-vozes dos maiores interessados em desmentir o aquecimento global (exemplo: o colunista Lawrence Solomon do Financial Post, que chama Lu de “uma estrela ascendente”) me leva à triste conclusão de que a Universidade de Waterloo anda atrás de um recurso escasso atualmente… (não… “bom-senso” sempre foi escasso… eu estou falando de grana, mesmo!…)

Aquecimento global – CO2 ou CFC?

O aquecimento global é causado pelos CFCs, não pelo dióxido de carbono, diz novo estudo

Clique aqui para créditos e imagem ampliada. |

||||

WATERLOO, Ontário, Canadá. (quinta-feira, 30 de maio de 2013) — Os clorofuorcarbonetos (CFCs) são os responsáveis pelo aquecimento global desde a década de 1970 e não o dióxido de carbono, de acordo com uma nova pesquisa da Universidade de Waterloo publicada na edição desta semana de International Journal of Modern Physics B.

Já se sabia que os CFCs destruíam a camada de ozônio da atmosfera, porém uma análise estatística profunda mostra agora que os CFCs são também os componentes chave das mudanças climáticas globais e não as emissões de dióxido de carbono (CO2).

“O modo de pensar tradicional diz que a emissão pela atividade humana de gases diferentes dos CFCs, tais como o dióxido de carbono, são os principais causadores do aquecimento. Porém nós observamos os dados até a Revolução Industrial que mostram que essa compreensão convencional está errada”, afirma Qing-Bin Lu, professor de física e astronomia, biologia e química na Faculdade de Ciências de Waterloo. “De fato, os dados mostram que os CFCs, em conspiração com os raios cósmicos, causaram tanto o buraco polar na camada de ozônio, como o aquecimento global”.

“As teorias mais convencionais preveem que as temperaturas globais continuem a aumentar no passo em que os níveis de CO2 levels continuem aumentando, como têm feito desde o entorno de 1850. O que é chocante é que as temperaturas globais, desde 2002, na verdade diminuíram – coincidindo com um declínio dos CFCs na atmosfera”, explica o Professor Lu. “Meus cálculos do efeito estufa dos CFCs mostram um aquecimento global de cerca de 0,6 °C de 1950 a 2002, no entanto a Terra na verdade esfriou a partir de 2002. A tendência de resfriamento deve continuar pelos próximos 50-70 anos, na medida em que a quantidade de CFCs na atmosfera continuar a diminuir”.

As descobertas têm como base uma análise estatística profunda dos dados observados desde 1850 até os dias de hoje, A teoria de reação dos elétrons aos raios cósmicos do Professor Lu (cosmic-ray-driven electron-reaction = CRE) da depleção do ozônio e sua pesquisa anterior sobre a depleção de ozônio sobre a Antártica e temperaturas da superfície global.

Clique aqui para créditos e imagem ampliada. |

||||

“A ideia geralmente aceita por duas décadas é que a camada de ozônio era depletada pela destruição dos CFCs na atmosfera pela luz ultravioleta do Sol”, prossegue ele. “Em contraste, a teoria CRE diz que os raios cósmicos – partículas de energia originárias do espaço – exercem o papel dominante na ruptura das moléculas que causam a depleção do ozônio e, então, do próprio ozônio”.

A teoria de Lu vem sendo confirmada pelos dados das observações correntes de raios cósmicos, CFCs, ozônio e da temperatura da estratosfera, ao longo de vários ciclos solares de 11 anos. “A CRE é a única teoria que nos fornece uma excelente reprodução das variações em ciclos de 11 anos, tanto das perdas de ozônio polares, como do esfriamento da estratosfera”, afirma o Professor Lu. “Depois de remover o efeito natural dos raios cósmicos, meu novo artigo demonstra uma pronunciada recuperação de ~20% do buraco de ozônio sobre a Antártica, consistente com o declínio dos CFCs na estratosfera polar”.

Comprovando a ligação entre os CFCs, a depleção do ozônio e as mudanças das temperaturas na Antártica, o Professor Lu foi capaz de obter uma relação quase perfeita entre as elevações das temperaturas de superfície globais e os CFCs na atmosfera.

“O clima na estratosfera Antártica foi completamente controlado pelos CFCs e raios cósmicos, sem qualquer impacto do CO2. A mudança na temperatura de superfície global, depois da remoção do efeito solar, não mostrou qualquer relação com o CO2, mas, sim, uma relação linear quase perfeita com os CFCs – um coeficiente de correlação alto como 0,97.”

Dados colhidos de 1850 a 1970, anteriores a qualquer emissão significativa de CFCs, mostram que os níveis de CO2 aumentaram significativamente, como resultado da Revolução Industrial, porém a temperatura global, excluído o efeito solar, se manteve quase constante. O modelo de aquecimento convencional de CO2, sugere que as temperaturas deveriam ter aumentado de 0,6°C ao longo deste período, similar ao período de 1970-2002.

As análises indicam da dominância da teoria CRE de Lu e o sucesso do Protocolo de Montreal sobre Substâncias que Depletam a Camada de Ozônio.

Clique aqui para créditos e imagem ampliada. |

||||

“Já sabíamos há algum tempo que os CFCs tinham um efeito realmente danoso em nossa atmosfera e tomamos as medidas para reduzir suas emissões”, diz o Professor Lu. “Agoras sabemos que esforços internacionais, tais como o Protocolo de Montreal, também tiveram um efeito profundo sobre o aquecimento global, porém estas devem ter uma base científica mais sólida”.

“Este estudo sublinha a importância da compreensão da ciência básica subjacente a depleção da camada de ozônio e a mudança climática global”, declarou Terry McMahon, decano da Faculdade de Ciênicas. “Esta pesquisa é de particular importância não só para a comunidade de pesquisas, como também para os responsáveis pelas políticas e o público em geral, na medida em que envisionamos o futuro de nosso clima”.

O artigo do professor Lu, Cosmic-Ray-Driven Reaction and Greenhouse Effect of Halogenated Molecules: Culprits for Atmospheric Ozone Depletion and Global Climate Change, também prevê que o nível global dos mares continuará a subir por alguns anos, na medida em que a camada de ozônio se recupera, e o aumento no derretimento das calotas polares.

“Somente quando o efeito da recuperação da temperatura global obtiver o domínio sobre o da recuperação dos buracos de ozônio polares, tanto as temperaturas, como o derretimento das calotas polares cirão conjuntamente”, afirma Lu.

O artigo, revisto por pares, publicado nesta semana, fornece não só novas compreensões fundamentais sobre os buracos de ozônio e as mudanças climáticas globais, como tem uma capacidade de predição superior em comparação com os modelos convencionais de depleção de ozônio pela luz solar e aquecimento causado pelo aumento do CO2.

Referencia do artigo:

Cosmic-Ray-Driven Reaction and Greenhouse Effect of Halogenated Molecules: Culprits for Atmospheric Ozone Depletion and

Global Climate Change

Qing-Bin Lu, University of Waterloo

Publicado em 30 de maio em International Journal of Modern Physics B Vol. 27 (2013) 1350073 (38 páginas).

O artigo está disponível online em: http://www.worldscientific.com/doi/abs/10.1142/S0217979213500732

Nota do Tradutor:

Publico este post, recomendando sua absorção com mais do que uma pitada de sal… Primeiro porque as credenciais do Professor Lu são as de um homem-dos-sete-instrumentos. Segundo porque nenhuma agência noticiosa repercutiu ainda uma novidade tão bombástica.

Ver para crer…

Novo fenômeno observado em um Magnetar

Uma estrela de nêutrons é o núcleo esmagado de uma estrela massiva que extinguiu seu combustível, colapsou sob seu próprio peso e explodiu como uma supernova. Uma estrela de nêutrons pode girar tão rápido quanto 43.000 rotações por minuto e exibir um campo magnético um trilhão de vezes mais forte do que o da Terra. A matéria de uma estrela de nêutrons é tão densa que uma colher de chá dessa matéria pesaria cerca de um bilhão de toneladas na Terra.

Crédito: Centro de Voo Espacial Goddard da NASA

›Imagem ampliada

Esta estrela de nêutrons, 1E 2259+586, fica a cerca de 10.000 anos-luz da Terra, na direção da constelação Cassiopeia. Ela é uma das cercas de duas dúzias de estrelas de nêutrons chamadas magnetares, que têm poderosos campos magnéticos e ocasionalmente produzem explosões ou pulsos de alta energia.

As observações dos pulsos de Raios-X da 1E 2259+586, de julho de 2011 até meados de abril de 2012, indicavam que a rotação do magnetar estava diminuindo gradualmente, desde uma vez a cada sete segundos, ou seja: cerca de oito revoluções por minuto. Em 28 de abril de 2012, os dados mostraram que a taxa de rotação caiu abruptamente em 2,2 milionésimos de segundo e que o magnetar estava freando sua rotação mais rapidamente.

Crédito: ESA/XMM-Newton/M. Sasaki et al.

› Imagem ampliada

O astrônomos batizaram o evento de “anti-glitch”, segundo o co-autor Neil Gehrels, principal investigador da missão Swift no Centro de Voo Espacial Goddard da NASA em Greenbelt, Maryland. “Ele afetou o magnetar de maneira exatamente oposta a qualquer outro glitch claramente identificado em qualquer outra estrela de nêutrons já visto”.

Esta descoberta tem importantes implicações para a compreensão das extremas condições físicas presentes dentro das estrelas de nêutrons, onde a matéria é comprimida até densidades várias vezes maiores do que em um núcleo atômico. Nenhum laboratório na Terra consegue duplicar essas condições.

Um relatório das descobertas será publicado na edição de 30 de maio da Nature.

Crédito: Centro de Voo Espacial Goddard da NASA

› Imagem ampliada

A estrutura interna das estrelas de nêutrons é um quebra-cabeças há muito tempo. A teoria corrente mantém que uma estrela de nêutrons tem uma crosta feita de elétrons e íons; um interior que contém extravagâncias que incluem um superfluido de nêutrons, que é um bizarro estado da matéria sem fricção; e uma superfície que acelera correntes de partículas de alta energia através do intenso campo magnético da estrela.

As partículas das correntes drenam a energia da crosta. A crosta perde rotação, porém o fluido no interior resiste a essa frenagem. Esta tensão fratura a crosta. Quando isso acontece, ocorre um a glitch. Acontece uma emissão de raios-X e a estrela ganha um impulso na rotação de seu interior que está girando mais rápido.

Um processo que leve a uma súbita frenagem na rotação constituí um novo desafio teórico.

Em 21 de abril de 2012, apenas uma semana antes do Swift observar o anti-glitch, a 1E 2259+586 produziu uma emissão breve porém intensa de raios-X, detectada pelo Monitor de Raios-X a bordo do Telescópio Espacial de Raios Gama Fermi da NASA. Os cientistas pensam que esta erupção de luz de alta energia de 36 milissegundos provavelmente assinalou as mudanças que causaram a frenagem do magnetar.

“O que é realmente digno de nota neste evento é a combinação da frenagem abrupta do magnetar, a emissão de raios-X e o fato de que agora observamos a estrela girando cada vez mais devagar”, diz o principal autor, Robert Archibald, estudante de pós-graduação na McGill.

O Centro Goddard gerencia o Swift, lançado em novembro de 2004. O telescópio é operado em colaboração com a Universidade do Estado da Pennsylvania em University Park, o Laboratório Nacional de Los Alamos no Novo México e a Orbital Sciences Corp. em Dulles, Virgínia. Os colaboradores internacionais são o Reino Unido e a Itália e a missão conta com contribuições da Alemanha e do Japão.

# # #

Fonte: NASA’s Swift Reveals New Phenomenon in a Neutron Star

A maioria dos cientistas concorda: as atividades humanas estão causando mudanças climáticas

|

|

|

Poluição atmosférica. Imagem da WikiPedia Commons |

De vez em quando, eu recebo de um amigo um daqueles emails que circulam anonimamente pela web denunciando “a farsa do aquecimento global”, sempre supostamente assinado por “um importante grupo de cientistas”, cheios de títulos de PhD para cima. Outros, me mandam links para a entrevista do Doutor Ricardo Augusto Felício no Programa do Jô. Sem contar os que acreditam piamente nos “estudos” financiados e divulgados pelo The Heartland Institute (financiado, por sua vez, por companhias “idôneas” como a Phllip Morris e as “sete irmãs“)

O bordão é sempre o mesmo: “não há um verdadeiro consenso de que estejam realmente acontecendo mudanças climáticas e, mesmo que estejam, não há consenso que elas sejam causadas pela atividade humana”.

Pois bem, pessoal!… Para desfazer esse engano que a mídia adora alimentar quando está sem assunto, um grupo de cientistas de verdade (da Austrália, do Canada, do Reino Unido, da Finlândia, dos Estados Unidos e da Alemanha) resolveu verificar tudo o que foi publicado – em termos de artigos científicos submetidos à revisão pelos pares (“peer reviewed”) – entre 1991 e 2011.

Uma das participantes desse grupo, a professora Sarah Green, catedrática de química da Universidade Tecnológica do Michigan, tornou públicas as contagens de artigos que afirmam e que negam que as mudanças climáticas não só estão em curso, como são resultado da ação humana.

“Modestos” 97% (faço questão de dizer por extenso: noventa e sete por cento) dos cientistas concordam que as mudanças climáticas estão em curso e são antropogênicas!

Entre outros comentários, Green disse: “Achei fascinante ver o conjunto de implicações das mudanças climáticas identificados nos extratos dos artigos — muito além daquilo que costumamos ouvir sobre o assunto. Nesses artigos, tudo foi examinado, o que inclui: a produção de chá no Sri Lanka, as listras das salamandras, desnutrição infantil, frequência de queda de raios, a distribuição da espécie de cactos opuntia (e de pinheiros, bosques de kelp, javalis selvagens, pinguins, peixes árticos, leishmaniose canina e diversas outras espécies), atividade mitocondrial de transporte de elétrons em mariscos, absorção de cobre por peixinhos dourados, nevascas de efeito-lago, a velocidade de rotação da Terra e a prevalência de raposas peladas na Islândia”.

Green diz também ter encontrado vários artigos que tratavam sobre a mitigação dos efeitos das mudanças climáticas.

Os resultados dessa pesquisa estão no artigo publicado hoje em Environmental Research Letters (Quantifying the consensus on anthropogenic global warming in the scientific literature. John Cook, Dana Nuccitelli, Sarah A Green, Mark Richardson, Bärbel Winkler, Rob Painting, Robert Way, Peter Jacobs e Andrew Skuce).

Então, quando alguém afirmar que não há consenso entre os cientistas sobre a existência de mudanças climáticas e que elas são causadas pela atividade humana, lembre-se que 97% (noventa e sete por cento) dos cientistas concordam; apenas 3% discordam… E esses 3% são o mesmo tipo de “cientista” que diz que cigarros não causam câncer (ou um eminente geógrafo e climatologista brasileiro).

(Via Eurekalert)

O “Planeta de Einstein”

Harvard-Smithsonian Center for Astrophysics

Novo processo de procura por planetas faz sua primeira descoberta

|

||||

Detectar exoplanetas é um grande desafio, uma vez que eles são pequenos, tênues e próximos de estrelas. As duas técnicas mais prolíficas para descobrir exoplanetas são a velocidade radial (procurar por estrelas oscilantes) e trânsitos (procurar por estrelas cujo brilho fica, de vez em quando, atenuado). Uma equipe da Universidade de Tel Aviv e o Centro de Astrofísica Harvard-Smithsonian (Center for Astrophysics = CfA) acaba de descobrir um exoplaneta usando um novo método que se baseia na Teoria da Relatividade Restrita de Einstein.

“Nós procuramos por efeitos muito sutis. Precisávamos de medições de alta qualidade do brilho estelar, com uma precisão de poucas partes por milhão” disse o membro da equipe David Latham do CfA.

“Isso só foi possível por conta dos refinados dados que a NASA vem coletando com a sonda Kepler”, acrescenta o autor principal Simchon Faigler da Universidade de Tel Aviv, Israel.

Muito embora a Kepler tenha sido projetada para descobrir planetas em trânsito, este planeta não foi identificado por meio do processo de trânsito. Em lugar disto, ele foi descoberto com o emprego de uma técnica inicialmente proposta por Avi Loeb do CfA e seu coelga Scott Gaudi (agora na Universidade do Estado de Ohio) em 2003. (Coincidentemente, eles desenvolveram sua teoria enquanto visitavam o Instituto de Estudos Avançados em Princeton, onde Einstein trabalhou).

O novo processo procura por três pequenos efeitos que ocorrem simultaneamente quando um planeta orbita uma estrela. O efeito de “farol relativístico” de Einstein que faz que a estrela brilhe mais quando se move em nossa direção (como o sinal luminoso de um farol), puxada pelo planeta e se atenue quando se move para longe. Essa luminosidade maior resulta do acúmulo de energia dos fótons e do fato de ficar focalizada na direção do movimento da estrela devido a efeitos relativísiticos.

“Esta é a primeira vez que este aspecto da Teoria da Relatividade de Einstein foi usado para descobrir um planeta”, diz o co-autor Tsevi Mazeh da Universidade de Tel Aviv.

A equipe também procurou indícios de que a estrela se deformasse por conta das marés gravitacionais do planeta em órbita. A estrela pareceria mais brilhante quando observada ao longo do eixo maior do “ovoide”, por conta da maior área de superfície exposta, e mais tênue quando vista “de ponta”. O terceiro pequeno efeito é devido à luz estelar refletida pelo próprio planeta.

Uma vez identificado o novo planeta, isto foi confirmado por Latham, usando as observações de velocidade radial obtidas pelo espectrógrafo TRES do Observatório Whipple no Arizona e por Lev Tal-Or (Universidade de Tel Aviv), usando o espectrógrafo SOPHIE no Observatório de Haute-Provence na França. Uma olhada mais cuidadosa nos dados do Kepler também mostrou o planeta em trânsito diante de sua estrela, uma confirmação adicional.

O “Planeta de Einstein” – formalmente conhecido como Kepler-76b, é um “Júpiter quente” que orbita sua estrela a cada 1,5 dias. Seu diâmetro é cerca de 25% maior que o de Júpiter e sua massa e duas vezes maior. Ele orbita uma estrela tipo F, localizada a cerca de 2.000 anos-luz da Terra na constelação de Cygnus (Cisne).

O planeta está em rotação sincronizada com sua estrela, mostrando sempre a mesma face para ela, do mesmo jeito que a Lua com a Terra. Por causa disso, Kepler-76b assa a uma temperatura de cerca de 2.000°C.

Curiosamente, a equipe encontrou fortes indícios de que o planeta tenha ventos de “corrente de jato” extremamente rápidos que transportam o calor por toda sua superfície. Por conta disto, o ponto mais quente de Kepler-76b não fica exatamente no “meio dia” (o ponto mais próximo da estrela), mas em uma posição a cerca de 20.000 km. Este efeito só tinha sido observado antes em HD 189733b e somente na faixa do infravermelho do Telescópio Espacial Spitzer. Esta foi a primeira vez que observações na faixa da luz visível mostram indícios de correntes de jato em um exoplaneta.

Embora o novo processo não seja capaz de encontrar planetas do tamanho da Terra com a tecnologia atual, permite aos astrônomos uma oportunidade ímpar para novas descobertas. Diferentemente das buscas por velocidade radial, ele não precisa de espectros de alta precisão. Diferentemente do processo de trânsitos, não precisa de um alinhamento preciso entre estrela e planeta quando vistos da Terra.

“Cada técnica de caça aos planetas tem suas virtudes e seus defeitos. E cada nova técnica que acrescentamos ao arsenal, nos permite sondar por planetas em situações diferentes”, diz Avi Loeb do CfA.

O Kepler-76b foi identificado pelo algoritmo BEER, acrônimo de [relativistic] BEaming, Ellipsoidal, and Reflection/emission modulations (modulações de farol relativístico, elipsoidais e de reflexão/emissão), desenvolvido pelo Professor Tsevi Mazeh e seu estudante Simchon Faigler na Universidade de Tel Aviv, Israel.

Diamantes com defeito?… Perfeito!

DOE/Lawrence Berkeley National Laboratory

Diamantes defeituosos prometem sensibilidade perfeita

Pesquisadores do Laboratório Berkeley e seus colegas estendem o spin dos elétrons nos diamantes para fazer detectores magnéticos incrivelmente pequenos

|

||||

Desde o cérebro, passando pelo coração e chegando ao estômago, os corpos dos animais geram campos magnéticos fracos que um detector ultra sensível poderia usar para descobrir doenças, rastrear drogas – e, quem sabe?… até ler mentes. Sensores do tamanho da unha do polegar poderiam mapear depósitos de gás no subsolo, analisar substâncias químicas e descobrir explosivos que poderiam se esconder de outras sondas.

Agora os cientistas do Laboratório Nacional Lawrence Berkeley (Berkeley Lab) do Departamento de Energia e da Universidade da California em Berkeley, em conjunto com seus colegas da Universidade Harvard, conseguiram aumentar o desempenho de um dos sensores mais potentes possíveis de campos magnéticos em nanoescala – um defeito em um diamante do tamanho de um par de átomos, chamado um “centro de vacância de nitrogênio” (nitrogen vacancy = NV center).

As descobertas da equipe de pesquisadores pode eventualmente permitir a fabricação de relógios menores que um chip de computador e, ainda assim, precisos até uns poucos quatrilhões de segundo, ou sensores de movimentoa mais rápidos e com maior tolerância a temperaturas extremas do que os giroscópios em smartphones. Não demora muito e um chip barato de diamante pode ser capaz de nuclear um computador quântico. A equipe relata seus resultados em Nature Communications.

Um sensor feito de diamante

Centros de vacância de nitrogênio são um dos defeitos mais comuns em diamantes. Quando um átomo de nitrogênio substitui um átomo de carbono no cristal de diamante e fica emparelhado com um espaço vazio (onde falta um átomo de carbono que devia estar lá), neste centro fica um número de elétrons, soltos dos átomos de carbono que deveriam estar naqueles lugares.

Os estados dos spins dos elétrons são bem definidos e muito sensíveis a campos magnéticos, campos elétricos e luz*, de forma que podem ser facilmente dispostos, ajustados e lidos por lasers.

“Os estados de spin dos centros NV são estáveis ao longo de um amplo espectro de temperaturas, de muito quente a muito frio”, diz Dmitry Budker da Divisão de Ciência Nuclear do Berkeley Lab, que também é professor de física da UC Berkeley. Mesmo pequenas lascas de diamante que custam centavos por grama, podem ser usadas como sensores, porque, como afirma Budker, “nós podemos controlar o número de centros NV no diamante apenas os irradiando ou assando”, ou seja, dando-lhes têmpera.

O desafio é manter a informação inerente nos estados de spin do centro NV, uma vez que esta tenha sido lá codificada, sem deixá-la vazar antes que se possa realizar medições: nos centros NV, isso requer a extensão do que é chamado de tempo de “coerência” dos spins dos elétrons, ou seja, o tempo que os spins permanecem sincronizados entre si.

Recentemente Budker trabalhou com Ronald Walsworth de Harvard em uma equipe que incluía Nir Bar-Gill de Harvard e Andrey Jarmola pesquisador pós-doutorado da UC Berkley. Eles conseguiram estender o tempo de coerência de um conjunto de spins de elétrons de um centro NV por mais de duas ordens de magnitude acima das experiências anteriores.

“Para mim, o aspecto mais entusiasmante deste resultado é a possibilidade de estudar as mudanças nas formas com que os centros NV interagem entre si”, diz Bar-Gill, autor principal do artigo e que estará indo para a Universidade Hebraica em Jerusalém no segundo semestre deste ano. “Isto é possível porque os tempos de coerência são muito mais longos do que aquele necessário para as interações entre os centros NV”.

E Bar-Gill acrescenta: “Agora podemos imaginar a engenharia de amostras de diamantes para realizar arquiteturas de computação quântica”. Os centros NV interativos fazem o papel dos bits em computadores quânticos, chamados qubits. Onde um dígito binário (bit) representa um 0 ou 1, um qubit representa 1 e 0 superpostos, um estado tipo “Gato-de-Schrödinger” simultâneo que persiste enquanto os estados forem coerentes, até que uma medição seja feita e faça colapsar todos os qubits emaranhados de uma só vez.

“Nós empregamos alguns truques para nos livrarmos de fontes de descoerência”, diz Budker. “Um deles foi usar amostras de diamante especialmente preparadas para serem feitas apenas de puro carbono-12”. Os diamantes naturais incluem uma pequena quantidade do isótopo carbono-13, cujo spin nuclear acelera a descoerência dos spins dos elétrons dos centros NV. O carbono-12 tem um spin nuclear zero.

“O outro truque foi baixar a temperatura até a do nitrogênio líquido”, diz Budker. A descoerência foi reduzida pelo resfriamento das amostras a 77°K, abaixo da temperatura ambiente, mas facilmente obtenível.

Trabalhando em conjunto no laboratório de Budker, os membros da equipe montaram os diamantes dentro de um criostato. Um feixe de laser atravessando o diamante, conjugado com um campo magnético, ajustou os spins dos elétrons no centro NV e os fez emitir fluorescência. O brilho fluorescente foi a medida da coerência dos estados de spin.

“Controlar o spin é essencial”, explica Budker, “de forma que pegamos emprestada uma ideia da ressonância magnética nuclear” – a base de procedimentos familiares como o Imageamento por Ressonância Magnética (MRI) nos hospitais.

Embora seja diferente do spin nuclear, a coerência dos spins dos elétrons pode ser estendida com técnicas semelhantes. Assim, quando os estados dos spins nos centros NV chegavam à beira da descoerência, os pesquisadores chacoalhavam o diamante com uma série de até 10.000 curtos pulsos de micro-ondas. Os pulsos invertiam os spins dos elétrons quando começavam a perder o sincronismo mútuo, produzindo “ecos” nos quais os spins invertidos se auto-ajustavam. A coerência era re-estabelecida.

Eventualmente os pesquisadores conseguiram tempos de coerência de spin de mais de meio segundo. “Nossos resultados são realmente brilhantes para o sensoreamento de campos magnéticos e informação quântica”, brinca Bar-Gill.

Longos tempos de coerência de spin se soma às vantagens que os diamantes já têm, colocando os NVs de diamantes na vanguarda dos potenciais candidatos para computadores quânticos práticos – uma busca favorita dos pesquisadores de Harvard. O que o grupo de Budker acredita ser uma perspectiva ainda mais interessante é o potencial que os longos tempos de coerência apresentam no sensoreamento de campos magnéticos, com aplicações que vão da biofísica à defesa.

“Solid-state electronic spin coherence time approaching one second”, por Nir Bar-Gill, Linh M. Pham, Andrey Jarmola, Dmitry Budker e Ronald L. Walsworth,será publicado na edição de 23 de abril de 2013 da Nature Communications, online em http://www.nature.com/ncomms/journal/v4/n4/full/ncomms2771.html.

Nota do tradutor: [*] Considerando que os fótons – as partículas de luz, não só a visível, mas todas as frequências – são portadores dos campos elétricos e magnéticos, é claro que se algo é sensível aos campos elétricos e magnéticos terá que ser sensível à luz… Enfim…

Telescópio Hubble encontra “lixo” planetário em estrelas mortas

O Hubble descobre estrelas mortas “poluídas” com escombros de planetas

Clique aqui para mais informações.

|

||||

As estrelas, conhecidas como anãs brancas — pequenos e tênues remanescentes de estrelas que já foram como nosso Sol — residem a 150 anos-luz de distância no Aglomerado das Híades na constelação de Taurus (Touro). O aglomerado é relativamente jovem, com apenas 625 milhões de anos.

Os astrônomos acreditam que todas as estrelas se formaram em aglomerados. No entanto, a busca por planetas nesses aglomerados se provou infrutífera — dos cerca de 800 exoplanetas conhecidos, apenas 4 orbitam estrelas de um aglomerado. Essa escassez pode ser devida à natureza dos aglomerados estelares, jovens e ativos, produzindo clarões estelares e outras erupções que tornam difícil estudá-los em detalhes.

Um recente estudo, liderado por Jay Farihi da Universidade de Cambridge, voltou seus olhos para estrelas “aposentadas” em aglomerados para procurar por indícios de formação de planetas [1].

As observações espectroscópicas do Hubble identificaram silício nas atmosferas de duas anãs brancas e o silício é um dos principais ingredientes do material rochoso que forma a Terra e outros planetas rochosos do Sistema Solar. Esse silício pode ter vindo de asteroides que foram estraçalhados pela gravidade da anã branca quando passaram perto demais das estrelas. Os escombros rochosos provavelmente formaram um anel em torno das estrelas mortas e esse anel, por sua vez, atraiu o material para dentro.

Os escombros que foram detectados girando em torno das anãs brancas sugerem que planetas semelhantes á Terra se formaram quando essas estrelas nasceram. Depois que as estrelas colapsaram em anãs brancas, eventuais planetas do tipo gigante gasoso que tenham sobrevivido, podem ter atraído pela gravidade quaisquer sobras de cinturões de asteroides até órbitas bem próximas das estrelas [2].

“Encontramos os indícios químicos dos blocos de construção de planetas rochosos”, diz Farihi. “Quando essas estrelas nasceram, formaram planetas e há uma boa chance de que ainda retenham alguns deles. Os rastros de escombros rochosos que estamos vendo são um indício disto — eles são pelo menos tão rochosos como os mais primitivos corpos terrestres de nosso Sistema Solar”.

Além de encontrar silício nas atmosferas das estrelas das Híades, o Hubble também detectou baixos níveis de carbono. Isto é um outro sinal da natureza rochosa dos escombros, já que os astrônomos sabem que os níveis de carbono devem ser muito baixos em material rochoso semelhante ao da Terra. A descoberta dessa tênue assinatura química precisou do poder de resolução do Espectrógrafo de Origens Cósmicas (Cosmic Origins Spectrograph = COS) do Hubble, porque as “digitais” do carbono só podem ser detectadas em luz ultravioleta que não pode ser observada por telescópios com base em terra.

“Uma coisa que esta técnica de detecção de poluição em anãs brancas nos dá e que nenhuma outra técnica de detecção de planetas pode dar, é a química de planetas sólidos”, continua Farihi. “Com base na proporção silício-carbono em nosso estudo, por exemplo, nós realmente podemos afirmar que esse material é basicamente similar ao da Terra”.

Este novo estudo sugere que asteróides com menos de 160 km de diâmetro [3] foram rompidos pela forte força de marés das anãs brancas, antes de eventualmente caírem sobre as estrelas mortas [4].

A equipe planeja analisar mais anãs brancas com a mesma técnica, não só para identificar a composição das rochas, como também dos corpos que as geraram. “A beleza desta técnica é que, seja o que for que o Universo esteja fazendo, seremos capazes de medir isto”, afirma Farihi. “Nós temos usado o Sistema Solar como uma espécie de mapa, mas não sabemos o que o resto do Universo faz. Esperamos que, com o Hubble e seu poderoso COS em ultravioleta e nos futuros telescópios com base em terra de 30 e 40 metros, possamos contar mais sobre essa saga”.

Notas

1] As duas estrelas anãs brancas “poluídas” das Híades fazem parte de uma pesquisa por escombros planetários em torno de mais de 100 anãs brancas, liderada por Boris Gänsicke da Universidade de Warwick, Reino Unido. Usando modelos computacionais das atmosferas de anãs brancas, Detlev Koester da Universidade de Kiel na Alemanha está determinando as abundâncias de vários elementos que podem ser rastreados até planetas nos dados do COS.

[2] A observação de indícios de asteroides aponta a possibilidade da existência de planetas do tamanho da Terra no mesmo sistema. Os asteroides são os blocos de construção dos planetas maiores. Os processos de formação de planetas é de baixa eficiência e gera muito mais vezes corpos pequenos do que corpos grandes — no entanto, uma vez que os embriões rochosos do tamanho de asteroides se formem, certamente haverá a formação de planetas.

[3] A equipe estimou o tamanho dos asteroides cadentes, medindo a quantidade de poeira sendo engolida pelas estrelas — cerca de 10 milhões de gramas por segundo, o que equivale ao fluxo de um rio pequeno. E então compararam os dados com as medições de material cadente em outras anãs brancas.

[4] O estudo das Híades proporciona um vislumbre sobre o que vai acontecer com nosso Sistema Solar quando o Sol se extinguir, daqui a uns cinco bilhões de anos.

Notas para editores

O Telescópio Espacial Hubble é um projeto de cooperação internacional entre a ESA e a NASA.

[1] A equipe internacional de astrônomos neste estudo compreende J. Farihi (Universidade de Cambridge, Reino Unido), B. T. Gänsicke (Universidade de Warwick, Reino Unido), D. Koester (Universidade de Kiel, Alemanha).

[2] Este novo estudo será publicado em Monthly Notices of the Royal Astronomical Society.

Links

- Imagens do Hubble: http://www.spacetelescope.org/images/archive/category/spacecraft/

- Artigo da pesquisa:

- http://www.spacetelescope.org/static/archives/releases/science_papers/heic1309.pdf

;

;