O telescópio Spitzer está se aquecendo para uma nova carreira

[ RELEASE

:

09-099 NASA’s Spitzer Telescope Warms Up to New Career ]

Por Whitney Clavin

Jet Propulsion Laboratory, Pasadena, Califónia.

O fim do refrigerante marcará o início de uma nova era para o Spitzer. O telescópio vai começar sua missão “quente” com dois canais de um instrumento ainda funcionando em plena capacidade. Algumas linhas científicas que um Spitzer mais quente vai explorar serão as mesmas e outras serão inteiramente novas.

Robert Wilson, o gerente do projeto do Spitzer no Laboratório de Propulsão a Jato da NASA em Passadena, diz: “Nós gostamos de pensar que o Spitzer está renascendo. O Spitzer

teve uma vida incrível, com um desempenho acima e além de seu dever. Sua missão primária pode estar se encerrando, mas ele vai empreender novas pesquisas científicas e novas descobertas, com certeza, vão aparecer”.

O Spitzer é o último dos Grandes Observatórios da NASA, um conjunto de telescópios projetados para enxergar as cores visíveis e invisíveis do universo. O conjunto inclui também os Telescópios Espaciais Hubble e Chandra da NASA. O Spitzer explorou, com uma sensibilidade sem precedentes, o lado infravermelho do cosmo, onde se escondem os objetos escuros, empoeirados e distantes.

Para que um telescópio possa detectar a luz infravermelha – essencialmente calor – vinda de frios objetos cósmicos, ele deve ter um calor próprio muito pequeno. Durante os últimos cinco anos, o hélio líquido correu pelas “veias” do Spitzer, mantendo seus instrumentos resfriados a -271°

Celsius, ou seja, menos de 3 graus acima do zero absoluto, a mais baixa temperatura teoricamente atingível. A criogenia foi projetada para durar apenas dois anos e meio, mas o projeto eficiente e a cuidadosa operação do Spitzer permitiram que ele durasse por mais de cinco anos e meio.

A nova temperatura de funcionamento “quente” do Spitzer é ainda bem congelante: -242°C, muito mais frio do que um dia de inverno na Antártica quando as temperaturas algumas vezes atingem -59°C. Esse aumento de temperatura significa que dois dos instrumentos a bordo do Spitzer – seu fotômetro imageador multifrequência de ondas mais longas e seu espectrógrafo infravermelho – não estarão mais frios o suficiente para poder detectar objetos frios no espaço.

No entanto, os dois detectores de comprimentos de onda mais curtos no dispositivo de câmera infravermelha do telescópio continuarão a funcionar perfeitamente. Eles ainda vão conseguir captar o brilho de vários objetos: asteríides em nosso sistema solar, estrelas em nuvens de poeira, discos de formação de planetas, planetas gigantes gasosos e galáxias distantes. Além disso, o Spitzer ainda será capaz de enxergar através da poeira que permeia nossa galáxia e bloqueia observações na faixa da luz visível.

Michael Werner, cientista do Projeto Spitzer do JPL que trabalha com o Spitzer há mais de 30 anos, declarou: “Nós faremos pesquisas excitantes e importantes com esses dois canais infravermelhos. Nosso novo programa de pesquisas tira vantagem do que esses canais podem fazer de melhor. Vamos nos focalizar em aspectos do cosmo sobre os quais ainda temos muito o que aprender”.

Desde seu lançamento de Cabo Canaveral em 25 de agosto de 2003, o Spitzer fez incontáveis descobertas na astronomia. Observações de cometas, próximos e distantes, mostrou que o material de cometas e planetas é similar por toda a galáxia. Fotos de tirar o fôlego de berçários estelares de poeira levaram a novas percepções sobre como nascem as estrelas. E o olho do Spitzer apontado para o universo mais distante, a bilhões de anos-luz, revelou centenas de buracos negros gigantes espreitando na escuridão.

Talvez as descobertas mais revolucionárias e surpreendentes do Spitzer envolvam os planetas que orbitam outras estrelas – os chamados exoplanetas. Os exoplanetas são, em quase todos os casos, próximos demais a suas estrelas-mãe para poderem ser vistos de nosso ponto de vista na Terra.

Não obstante, os caçadores de planetas continuam a descobrílos, buscando mudanças nas estrelas-mãe. Antes do Spitzer, tudo o que sabíamos acerca dos exoplanetas vinha desse tipo de observação indireta.

Em 2005, o Spitzer detectou os primeiros fótons vindos diretamente de um exoplaneta. Por meio de uma engenhosa técnica, agora conhecida como método do eclipse secundário, o Spitzer foi capaz de coletar a luz de um exoplaneta quente e gasoso e aprender sobre sua temperatura. Estudos espectroscópicos posteriores, mais detalhados, revelaram mais sobre a atmosfera (ou o “clima”) em planetas semelhantes. Mais recentemente, o Spitzer testemunhou as mudanças no clima de um exoplaneta gasoso altamente excêntrico – uma tempestade de proporções colossais que nascia em uma questão de horas, antes de se dissipar rapidamente.

“Ninguém tinha qualquer ideia se o Spitzer seria capaz de estudar diretamente os exoplanetas quando o projetamos”, disse Werner. “Quando os astrônomos planejaram as primeiras observações, não tinhamos ideia se iam funcionar. Para nosso espanto e deleite, elas funcionaram”.

Estas são algumas poucas das realizações do Spitzer nos últimos cinco anos e meio. Os dados desse telescópio são citados em mais de 1.500 artigos científicos. E os cientistas e engenheiros esperam que as recompensas ainda continuem a surgir desses anos dourados do Spitzer.

Algumas das novas linhas de pesquisa do Spitzer incluem o refinamento das estimativas da Constante de Hubble, a taxa de expansão do universo; a procura de galáxias na borda do universo observável; avaliação dos asteróides potencialmente perigosos para a Terra, medindo o tamanho dos asteróides; e a caracterização das atmosferas de planetas gigantes gasosos cuja descoberta é prevista para breve pela missão Kepler da NASA. Assim como foi na época da missão “fria” do Spitzer, esses e outros programas são selecionados através de uma competição para a qual são chamados a participar cientistas de todo o mundo.

O JPL gerencia a missão Spitzer para a Diretoria de Missões Científicas da NASA em Washington. As operações científicas são conduzidas no Centro de Ciências Spitzer no Instituto de Tecnologia da Califórnia (CalTech) em Pasadena. A missão e as operações científicas são apoiadas pela

Lockheed Martin Space Systems em Denver e pela Ball Aerospace &

Technology Corp. em Boulder, Colorado. O dispositivo de câmeras infravermelhas do Spitzer foi construído pelo Centro de Voo Espacial Goddard da NASA em Greenbelt, Maryland; o principal pesquisador dos instrumentos é Giovanni Fazio do Centro de Astrofísica Harvard-Smithsonian em Cambridge, Massachusetts. A Ball Aerospace & Technology Corp.

construiu o espectrógrafo infravermelho do Spitzer; seu principal pesquisador é Jim Houck da Universidade Cornell em Ithaca, N.Y. A Ball Aerospace &

Technology Corp. e a Universidade do Arizona em Tucson, construíram o fotômetro imageador mutibandas para o Spitzer; e seu principal pesquisador é George Rieke da Universidade do Arizona.

Para mais informações sobre o Spitzer, visite:

e

http://www.spitzer.caltech.edu/spitzer

Cientistas marinhos voltam de expedição a um vulcão submarino em erupção

![]()

Press Release 09-090 Marine Scientists Return From Expedition to Erupting Undersea Volcano

![]()

Descobertos um enorme cone vulcânico e novas espécies animais das profundezas

|

A lava irrompe sobre o fundo do mar no NW Rota-1, criando uma pluma esfumaçada e extremamente ácida.

Crédito e imagem ampliada |

5 de maio de 2009

Os cientistas que acabam de retornar de uma expedição a um vulcão submarino em erupção próximo da Ilha de Guam, relatam que o vulcão parece ser continuamente ativo, tendo crescido consideravelmente nos últimos três anos e que sua atividade sustenta uma comunidade biológica única que se expande a despeito das erupções.

|

|

|

Esta vista tridimensional mostra o vulcão NW Rota-1, local da recente expedição.

Crédito e imagem ampliada |

Uma equipe internacional de cientistas nesta expedição, financiada pela Fundação Nacional de Ciências (National Science Foundation = NSF), obteve novas informações importantes sobre a atividade eruptiva do NW Rota-1.

“Essa pesquisa nos permite, pela primeira vez, estudar vulcões submarinos em detalhes e de perto”, disse Barbara Ransom, diretora do programa na Divisão de Ciências Oceânicas da NSF, que financiou a pesquisa. “O NW Rota-1 continua sendo o único lugar na Terra onde se pode observar diretamente a erupção de um vulcão submarino”.

Os cientistas observaram já tinham observado erupções no NW Rota-1, primeiro em 2004 e de novo em 2006, segundo Bill Chadwick, vulcanólogo da Universidade do Estado de Oregon (OSU) e investigador-chefe desta expedição. Entretanto, desta vez descobriram que o vulcão tinha criado um novo cone com 40 metros de altura e 300 de largura.

“Isso tem a altura de um prédio de 12 andares e a largura de todo um quarteirão”, prossegue Chadwick. “Da mesma forma que o cone cresceu, observamos um significativo aumento na população animal que vive por cima do vulcão. Estamos tentando estabelecer se há uma conexão direta entre o aumento da atividade vucânica e o aumento da população”.

|

|

|

O vulcão submarino NW Rota-1 fica ao Norte da Ilha de Guam. |

Os animais nesse ecossistema desusado incluem camarões, caranguejos, caramujos e cracas, alguns dos quais são espécies totalmente novas.

“Eles são especialmente adaptados a seu ambiente”, explica Chadwick, “e estão prosperando nas hostis condições químicas que seriam tóxicas para a vida marinha normal”.

“A vida aqui é, na verdade, alimentada pelo vulcão em erupção”.

Verena Tunnicliffe, uma bióloga da Universidade de Victoria, disse que a maior parte dos animais são dependentes das fumarolas hidrotermais difusas que provêem o alimento básico na forma de filamentos de bactérias que revestem as rochas.

“Parece que, desde 2006, as fumarolas difusas se espalharam e, com elas, os animais das fumarolas”, explica Tunnicliffe. “Agora existe uma biomassa muito grande de camarões no vulcão e duas espécies são capazes de suportar as condições vulcânicas”.

|

|

|

Duas espécies únicas de camarão foram descobertas no NW Rota-1. |

Os camarões revelam uma intrigante adaptação à vida no vulcão.

“O camarão ‘Loihi’ se adaptou a pastar os filamentos bacterianos com pequenas pinças semelhantes a tesouras de jardinagem”, prossegue Tunnicliffe. “O segundo camarão é uma nova espécie – eles também pastam durante a infância, mas quando se tornam adultos, suas pinças crescem e eles se tornam predadores”.

O camarão Loihi já era conhecido apenas em um pequeno vulcão ativo próximo do Hawaii — a uma grande distância. Ele sobrevive das bactérias de rápido crescmento e tenta evitar os perigos das erupções vulcânicas. Nuvens desses camarões foram vistas fugindo de jatos do vulcão.

As outras espécies atacam o camarão Loihi e predam a vida marinha que se aventura muito perto das plumas vulcânicas e morrem. “Nós vimos peixes, lulas, etc, mortos chovendo sobre o monte submarino, onde eles eram assaltados pelos camarões vulcânicos — uma linda adaptação à exploração dos efeitos nocivos do vulcão”, relata Tunnicliffe.

|

|

|

O Jason é içado do mar apos um mergulho. |

Os novos estudos são importantes porque o NW Rota-1 é um laboratório natural, único no gênero, para a investigação da atividade vulcânica submarina e sua relação com ecossistemas com base nas substâncias químicas encontradas em fumarolas hidrotermais, onde a vida na Terra pode se ter originado.

“É raro que um vulcão seja continuamente ativo, mesmo em terra”, sublinha Chadwick.

“Isso nos apresenta uma oportunidade fantástica para aprender sobre processos que nunca pudemos observar diretamente antes. Quando os vulcões entram em erupção em águas rasas, eles podem ser extremamente perigosos, criando grandes explosões e até tsunamis. Porém aqui podemos observar seguramente uma erupção no oceano profundo e aprender lições valiosas sobre como interagem a lava quente e a água do mar”.

Chadwick diz que as plumas vulcânicas se comportam comportam de maneira totalmente diferente debaixo d’água e em terra, onde a nuvem da erupção é cheia de vapor e cinzas, e os outros gases ficam inisíveis.

|

|

|

O veículo de controle remoto Jason pronto para um mergulho. |

“No oceano, qualquer vapor se condensa imediatamente e desaparece, e o que fica visível são claras bolhas de dióxido de carbono e uma densa nuvem feita de pequenas gotículas de enxofre derretido que se formam quando o dióxido de enxofre se mistura com a água do mar”, explica Chadwick. “Esses gases vulcânicos tornam a nuvem da erupção extremamente ácida — pior do que os ácidos estomacais — o que é outro desafio para as comunidades biológicas que vivem nas proximidades”.

A acidificação dos oceanos é uma séria preocupação por causa da acumulação de dióxido de carbono na atmosfera, causada pela atividade humana. Chadwick diz: “Os vulcões submarinos são locais onde podemos estudar como os animais se adaptaram a condições ambientes muito ácidas”.

Durante a expedição de abril de 2009, a bordo do R/V Thompson da universidade de Washington, os cientistas realizaram mergulhos com o Jason, um veículo de controle remoto (remotely operated vehicle = ROV) operado pela Instituição Oceanográfica Woods Hole.

|

|

|

Cientistas acompanham o progresso do Jason no fundo do mar de uma sala de controle a bordo do navio. |

Chadwick disse que “era interessante ver o quanto o Jason podia chegar perto das fumarolas em erupção porque a pressão a uma profundidade de 520 metros no oceano impede que a energia liberada pelo vulcão fique explosiva demais”. Algumas das observações mais intrigantes aconteceram quando o vulcão lentamente expelia lava pelas fumarolas.

“Quando isso estava acontecendo, o chão a nossa frente balançava e tremia, e grandes blocos eram empurrados para fora, de modo a abrir caminho para a lava que emergia das fumarolas”, descreve Chadwick.

Parte dos indícios de que o vulcão está em um constante estado de erupção, vem de um microfone submarino – ou hidrofone – que foi instalado no ano passado pelo geólogo da OSU Bob Dziak.

|

|

|

O braço do Jason colhe amostras no NW Rota-1. As rochas escuras são lava. |

O hidrofone monitorou os sons da atividade vulcânica. Os dados por ele recolhidos mostram claramente que o vulcão ficou ativo pelo ano inteiro antes dessa última expedição. Outro hidrofone e outros instumentos irão monitorar o vulcão no ano vindouro.

A equipe internacional incluiu cientistas dos Universidade do Estado do Oregon, Universidade de Washington,

Universidade de Victoria, Universidade de Oregon, Laboratório Ambiental Marítimo do Pacífico da NOAA, Nova Zelãndia e Japão.

Décimo aniversário da Clínica Virtual da NASA

[ NASA Celebrates 10th Anniversary of the Virtual Collaborative Clinic ]

|

|

|

Concebida e desenvolvida no Centro de Bioinformática de Ames, uma equipe chefiada por Muriel Ross desenvolveu a Clínica Virtual. Foto da NASA |

O que têm em comum uma avó Navajo e um astronauta da NASA? Ambos vivem em locais remotos e desolados, seja no deserto do Novo México, seja na Estação Espacial Internacional, e ambos terão dificuldades em obter tratamento médico ou ser levado para um hospital, caso necessário.

A NASA percebeu bem cedo que poderiam haver ocasiões nas quais os astronautas se veriam em apuros e necessitariam de assistência médica de emergência, estivessem eles em plena viagem espacial ou vivendo na Estação Espacial Internacional. Para resolver esse problema, o Centro de Pesquisas Ames da NASA desenvolveu uma “clínica virtual”, há dez anos, que também tem auxiliado populações mal servidas de saúde em alguns dos lugares mais remotos da Terra.

Celebrando seu décimo aniversário neste mês, essa “clínica virtual”, chamada Clínica Colaborativa Virtual (Virtual Collaborative Clinic = VCC), tem apresentado inovações médicas avançadas desde sua criação. Quando o Centro Ames criou essa “telemedicina” sofisticada, isso representou um grande passo para os serviços de saúde.

“Em uma época onde a presença virtual era só um sonho, os pensadores inovativos no Centro Ames demonstraram que as pessoas em vários locais diferentes podiam trabalhar em conjunto em tempo real, partilhar suas habilidades, informações e conhecimentos para melhorar o serviço de saúde para comunidades nas áreas mais remotas do mundo”, declarou Steve Zornetzer, Diretor Associado do Centro e antigo Diretor de Tecnologia da Informação no Ames.

A Clínica Colaborativa Virtual

Concebida e desenvolvida no Centro de Bioinformática no Ames, uma equipe de projeto, liderada por Muriel Ross, criou três ferramentas de software para auxílio de diagnóstico e planejamento de tratamento médico nos ambientes mais hostis. Essas ferramentas combinam imageamento médico avançado com comunicação em rede de banda larga de alto desempenho para dar aos médicos imagens coloridas de alta definição em tempo real.

O primeiro programa, “mesher,” gera visualizações estereoscópicas de alta fidelidade dos dadosde cada paciente. Usando informações obtidas a partir de microscopia eletrônica, tomografia computadorizada ou ressonância magnética, os engenheiros de software desenvolveram visualizações dos osso, tecidos e órgãos dos pacientes.

Uma vez feitas essas imagens, uma segunda ferramenta de software, chamada “Bisturi Cibernético” (“CyberScalpel”), permite que os médicos, administradoers e técnicos em diferentes localizações, vejam e avaliem o problema ou ferimento do pacientes e discutam o procedimento médico mais adequado para o tratamento. Girando e manipulando a imagem, os médicos podem praticar os procedimentos cirúrgicos em ambiente virtual, reduzindo o tempo de realização da cirurgia e aumentando as chances de sucesso.

|

|

|

Médicos fazem a imagem em 3-D girar e discutem o caso em tempo real. Imagem da NASA |

Os médicos podem realizar incisões em imagens virtuais e até remover tecidos ou ossos. As sessões são colaborativas: qualquer participante, local ou remoto, pode girar a imagem para vê-la de diferentes perspectivas, enquanto outros participantes observam a mesma imagem e apresentam suas opiniões discordantes em uma atmosfera realmente interativa.

A rede

A terceira ferramenta é um aplicativo multicanal que permite o compartilhamento simultâneo das informações em vários lugares. O software regula

a informação recebida e enviada por roteadores, minimizando os atrasos na transmissão para fornecer os dados quase que em tempo real, sincronizando as imagens grandes em 3-D nos terminais e acomodando as redes por satélite e terrestres operadas em plataformas diferentes. Para resolver esse problema, a firma Cisco Systems

contribuiu para o projeto do software multicanal na internet.

Além disso, para que as interações entre os sítios sejam feitas com sucesso, o sistema de rede precisava de largura de banda, progressividade, confiabilidade e capacidade multicanal. A NASA precisava de uma solução de rede com base nos IP. Essas redes — a Rede de Pesquisa e Educação da NASA (NASA Research and Education Network = NREN), o Serviço de Backbone de Rede de Alt[issima Performance da Fundação Nacional de Ciências (vBNS), em Abilene, Novo México, e a Rede de Pesquisa e Educação da Califórnia (CalREN2) — conectam os sítios participantes com o servidor do aplicativo em Ames.

Para o componente de satélite, a NASA usou um aplicativo de banda muito larga que fornece o acesso em alta velocidade à internet. Essa solução de rede permitiu à NASA se conectar com cinco instalações principais: o Hospital Memorial de Salinas Valley da Universidade da Califórnia em Santa

Cruz, o Centro Médico da Universidade Stanford na Califórnia, o Centro Médico Navajo do Norte no Novo México a Clínica Cleveland no Centro de Pesquisas Glenn da NASA e o Centro de Pesquisa Ames da NASA — com uma rede de grande área de alto desempenho que se estende por todos os Estados Unidos.

Um conceito se torna realidade

Com todos os sistemas prontos, a VCC foi lançada em 4 de maio de 1999. Pela primeira vez na história, especialistas médicos de cinco locais diferentes tiveram a oportunidade de discutir casos reais, enquanto observavam complexas visualizações para a cirurgia em tempo real. Usando ligações terrestres e transmissões por satélite através da VCC, os médicos discutiram casos e, em uma ocasião, realizaram uma cirurgia virtual. No dia da demonstração, a UC Santa Cruz também montou um auditório para que qualquer um pudesse observar o que acontecia na VCC.

A equipe da Clínica de Cleveland discutiu um caso onde um paciente sofria de um coração hipertrofiado. A equipede Salinas tratou o coração de uma criança com arritmia e os hospitais dos Navajo, Cleveland e Salinas apresentaram resultados de cirurgias cardíacas.

Zornetzer declarou: “A Dra. Muriel Ross e seus companheiros do setor privado, a indústria da saúde e as clínicas particulares, conceberam, implementaram e demonstraram a utilidade da Clínica Colaborativa Virtual. A NASA é conhecida por sua liderança nas capacidades técnicas e o projeto da VCC demonstrou, há mais de uma década, o que só hoje está se tornando uma realidade mais comum”.

Novos desenvolvimentos

Atualmente a VCC é usada para auto-transplante, correção de lábios leporinos, cirurgia de reconstrução facial e de reconstrução de coxas. Michael Stephanides, um médico pesquisador no Centro Médico da Universidade Stanford, relembra três projetos que surgiram da clínica virtual de 1999. Os projetos incluiarm software para uma cirurgia para a reconstrução da face de uma mulher (nariz e bochecha); um simulador para treinamento de microcirurgia que resultou em um protótipo, e uma ferramenta de medição em 3-D que criava maxilas a partir de ossos das pernas para pacientes com câncer.

O Dr. Stephen A. Schendel, antigo pesquisador no Centro Médico da Universidade Stanford na Califórnia, disse: “Os avanços na computação nos últimos dez anos melhoraram rapidamente o imageamento e as simulações para os serviços de saúde. Em Stanford, nós conseguimos desenvolver um sistema de simulação para o planejamento de cirurgia crânio-facial. Essa tecnologia representa uma significativa vantagem para o ensino e planejamento de cirurgia, o que pode aumentar a segurança e melhorar o prognóstico para os pacientes”.

Os médicos dizem que as cirurgias simuladas poupam tempo e melhoram as cirurgias reais, e a VCC lhes permite realizar simulações de procedimentos cirúrgicos. O objetivo de longo prazo da NASA é que a VCC assegure a saúde dos astronautas, na medida em que eles se aventuram mais longe pelo espaço. Mas as tecnologias avançadas de rede da clínica também tornam o serviço de saúde “universal” uma realidade, oferecendo a mesma qualidade de serviços existentes em nas instituiçoes mais conhecidas, a pacientes em localidades remotas.

Os profissionais médicos envolvidos na Clínica Colaborativa Virtual gostariam de reconhecer as contribuições feitas pelos Dr. Bruce Finke e Dr. Mark Carroll, do Serviço Médico Indígena.

(Por Ruth Dasso Marlaire

Ames Research Center, Moffett Field, Califórnia)

Na manufatura industrial, quanto mais tecnologia, menos eficiência

[In Industrial Manufacturing, Efficiency Falls as Technology Advances]

![]()

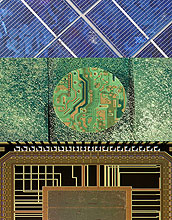

Um estudo compreensivo sobre velhos e novos processos de manufatura, da usinagem de metais à frabricação de nano-fibras de carbono, mostra que as tecnologias mais avançadas são menos eficientes no uso de energia e matérias primas por quilo de produto comercial

|

Tecnologias avançadas são menos eficientes no uso de energia e material por quilograma de produto final |

1 de maio de 2009

No século passado, a manufatura industrial foi dominada por processos em larga escala, devoradores de energia, tais como a fusão de minérios e a usinagem de metais. Atualmente, o cenário industrial apresenta um conjunto de técnicas modernas que funcionam em escalas muito menores, produzindo chips de computador, nano-fibras de carbono e outros produtos sofisticados. Essa evolução no sentido de uma manufatura mais avançada em tecnologia ocorreu ao custo de uma acentuada queda na eficiência — é o que mostra um novo estudo. Os processos mais hi-tech podem consumir até um milhão de vezes mais energia e matérias primas para uma dada quantidade de produtos finais do que os processos industriais tradicionais — uma tendência que pode fazer fracassarem os esforços para construir uma economia industrial mais consciente no emprego da energia que use matriais e tecnologias de ponta.

Qualquer processo de manufatura usa energia para transformar as matérias primas em um produto desejado. Porém, algo das matérias primas geralmente irá para o lixo e a energia nem sempre é usada de maneira tão eficiente quanto podia ser. Para compreender melhor essas perdas, Timothy Gutowski do Instituto de Tecnologia de Massachusetts (MIT) em Cambridge, Mass., e seus colegas desenvolveram um modelo, com base nas leis da termodinâmica, que rastreia tanto as transformações energéticas, como as físicas ou químicas dos materiais, na medida em que passam pelas fases de um processo industrial.

Os cientistas pesquisaram 20 técnicas de manufatura. Os processos tradicionais incluíram a fusão e a fundição de metais, moagem e usinagem, e a moldagem por injeção de plásticos, juntamente com inovações mais recentes tais como o uso de lasers e jatos d’água para a modelagem de materiais. Completando a lista de técnicas, aparece a vasta gama de processos usados no setor de micro-eletrônica, tais como a deposição química por vapor e sputtering (pulverização catódica), bem como a produção de nano-fibras de carbono.

Com exceção dos métodos que envolvem a fusão de metais, as demandas de energia para cada processo foram surpreendentemente similares, variando entre 5 a 50 kilowatts de eletricidade. Por outro lado, as quantidades de material processadas variava enormemente, indo de centenas de quilogramas por hora ou mais, para os processos mais antigos, até umas poucas miligramas por hora para as duas técnicas mais recentes. Uma tendência espantosa começou a aparecer: na medida em que os processos se tornavam mais sofisticados tecnologicamente, tendiam a manipular quantidades cada vez menores de material em ritmos cada vez mais lentos, mas, como o consumo de energia por processo continuava a ser quase o mesmo, a quantidade de energia necessária para gerar uma dada quantidade de produto acabado crescia rapidamente.

Gutowski e seus colegas concedem que um processo ineficiente, funcionando sobre uma pequena quantidade de material, pode não ser muito importante quando comparado a todo o consumo de energia pela indústria. Entretanto, eles observam que o mundo produz atualmente mais de 20.000 toneladas de silício com pureza para a indústria eletrônica por ano, consumindo cerca de 50 bilhões de quilowatts-hora de eletricidade nesse processo. A produção de fibras de carbono, cuja utilização é frequentemente proposta para aplicações em larga escala, fica na mesma faixa em termos de energia usada por quilograma de produto. Ambas as indústrias envolvem processos que caem nas faixas inferior e média de eficiência descobertas pelos pesquisadores do MIT, de forma que a falta de atenção para o uso mais eficiente de energia pode ter consequências significativas.

As modernas técnicas industriais frequentemente requerem materiais e processos elaborados cujos custos energéticos e de matéria prima não são diretamente incorporados no produto. Por exemplo, gases altamente reagentes podem ser empregados para a limpeza de equipamentos de produção de chips de silício, em preparação para etapas subsequentes, e esses gases podem ter que ser quimicamente tratados depois do uso por questões de segurança ou de controle de poluição. Esses elementos marginais, porém essenciais, de um processo de manufatura hi-tech podem reduzir enormemente seu “grau de perfeição” — a razão entre o valor termodinâmico do produto e o valor termodinâmico de tudo o que é necessário para fazê-lo. Quanto mais “ideal” for um processo, mais essa razão se será de um para um. Na verdade, os processos podem variar significativamente em seus graus de perfeição. Por exemplo, a equipe do MIT calculou que uma fornalha elétrica que derrete sucata e outros tipos de ferro para gerar um produto metálico refinado, pode ter um grau de perfeição de 0,79. Em comparação, um processo de deposição química de vapor, usado pela indústria de semicondutores para produzir finas camadas de dióxido de silício, pode ter um grau de perfeição menor um pouco do que 4 milionésimos (0,000004).

No projeto de processos que transformam materiais caros em pequenas quantidades de produtos hi-tech, os fabricantes se focalizaram em diversas questões tais como tamanho e qualidade, mas, como diz Gutowski, “não tiveram fortes incentivos para reduzir o consumo de energia”. Mas isso pode estar mudando. Fabricantes de painíes solares, por exemplo, estão bem conscientizados do processo gastador de energia que usam, e o incluem nas estimativas do prazo de auto-compensação — em termos tanto de energia, quanto de dinheiro — dos produtos que fabricam. Para ser realmente “verde”, em outras palavras, um painel solar deve produzir uma quantidade substancialmente maior de energia, durante sua vida útil, do que a consumida para produzí-lo.

Este tipo de racicínio ainda não tomou pé em outras áreas, tais como a dos nano-materiais, acrescenta Gutowsk, onde os custos energéticos da manufatura não são amplamente conhecidos. Quanto mais as apliações desses materiais ganhar atenção, especialmente no contexo da tecnologia “verde”, “terá que ocorrer uma negociação mais séria com relação aos custos energéticos. Apresentando um modelo analítico compreensivo que pode contabilizar tanto o material quanto a energia usados na manufatura industrial, o estudo do MIT disponibiliza uma linguagem na qual essa negociação pode ser conduzida.

| — | David Lindley |

Investigadores

Timothy Gutowski

Instituições/Organizações Relacionadas

Massachusetts Institute of Technology

Super-sensores do NIST medirão a “assinatura” do universo inflacionário

O que aconteceu no primeiro trilionésimo de trilionésimo de trilionésimo de segundo após o Big Bang?

Detectores de micro-ondas super-sensíveis, construídos no National Institute of Standards and Technology (NIST), podem ajudar os cientistas a descobrir em breve.

Os novos sensores, descritos hoje no encontro da Sociedade Americana de Física (American Physical Society = APS) em Denver, foram fabricados para uma experiência potencialmente revolucionária – a Busca pelo Modo-B em Atacama, Atacama B-mode Search (ABS) – realizada por uma colaboração que envolve o NIST, a Universidade de Princeton, a Universidade do Colorado em Boulder e a Universidade de Chicago.

Embora o NIST seja mais conhecido por suas medições na Terra, um projeto já antigo que funciona no campus de Boulder desempenha um papel de relevo no estudo do Fundo Cósmico de Micro-ondas (cosmic microwave background = CMB) — o apagado resquício da luminosidade do Big Bang que ainda permeia o universo. Esse projeto construiu anteriormente amplificadores super-condutivos e câmeras para experiências com o CMB no Polo Sul, em observatórios a bordo de balões, e no Planalto de Atacama no

Chile.

A nova experiência vai começar em aproximadamente um ano no deserto chileno e consistirá da colocação de um grande dispositivo de sensores do NIST em um telescópio montado em um contêiner de carga adaptado.

Os detectores vão procurar por pequenas “impressões digitais” sutís no CMB, causados por ondas gravitacionais primevas — ondulações na tessitura do espaço-tempo nascidas do parto violento do universo, há mais de 13 bilhões de anos. Acredita-se que essas ondas tenham deixado uma marca, tênue porém inconfundível, na direção do campo elétrico do CMB, chamadas de “polarização modo-B”. Essas ondas — cuja existência jamais foi confirmada por meio de medições — ainda são potencialmente detectáveis, contanto que se empregue equipamento suficientemente sensível.

“Este é um dos grandes desafios de medição que confrontam a comunidade científica nos próximos 20 anos e também um dos mais excitantes”, disse Kent Irwin, o físico do NIST encarregado do projeto.

Caso descobertas, essas ondas seriam o indício mais claro já encontrado em apoio à “teoria da inflação”, que propõe que todo o universo atualmente observável se expandiu rapidamente a partir de um volume subatômico, deixando um rastro de ondas gravitacionais no fundo cósmico de micro-ondas.

“A polarização em modo-B é a mais significativa peça de indícios a ser observada em todos os tempos”, declarou Ki Won Yoon, pós-graduado do NIST, encarregado de apresentar o projeto na reunião da APS. “A detecção de ondas gravitacionais primordiais através da polarização do CMB seria um enorme passo para colocar a teoria da inflação sobre bases sólidas”.

Os dados também podem dar aos cientistas novas perspectivas sobre diferentes modelos de teoria das cordas para o universo e outras teorias “unificadas” da física.

Esse tipo de experiência só pode ser realizado se estudarmos o universo como um todo, já que as partículas e os campos eletromagnéticos, no início da era inflacionária, eram aproximadamente 10 bilhões de vezes mais quentes do que as energias alcançáveis pelo mais poderoso colisor de partículas existente na Terra. Nessa escala de energia, é previsto que as forças fundamentais, atualmente identificadas como coisas distintas, se unifiquem.

Irwin disse: “O universo é um laboratório de física: se olharmos para longe, na verdade estaremos olhando para trás no tempo, podendo observar interações que aconteceram em níveis de energias que estão para sempre fora do alcance das experiências terrestres”.

Estudos recentes sobre o CMB vinham se focalizando na medição de ligeiras variações espaciais na temperatura ou na energia existentes cerca de 380.000 anos após o Big Bang. Esses padrões de radiação permitem aos cientistas caracterizar as primeiras distribuições de matéria e energia que evoluíram para formar as estrelas e galáxias que vemos hoje.

Comparando as medições realizadas às previsões feitas pelas várias teorias, os cientistas tornam cada vez mais precisa a história do universo, por exemplo, estreitando sua possível idade (hoje estimada em 13,7 bilhões de anos).

Em contraste, os novos detectores do NIST são projetados para medir não só a temperatura, mas também a polarização. Os sinais da polarização em modo-B podem ser mais de um milhão de vezes mais tênues do que os sinais da temperatura.

Para conseguir detectar padrões tão sutís, os detectores do NIST vão coletar significativas quantidades de radiação de modo eficiente e não terão partes móveis e outras fontes tradicionais de erros sistemáticos, tais como vibrações e interferência magnética, segundo Irwin. Além disso, serão necessários um avançado sistema de processamento de sinais e controle de erros.

Os novos sensores são protótipos para dispositivos polarímetros do NIST que aumentarão grandemente a sensibilidade de experiências futuras, com a construção de milhares de detectores em unidades monolíticas que podem ser instalados em câmeras de telescópio criogênicas. Os novos detectores do NIST também podem ter aplicações mais domésticas, tais como a redução do clarão em sistemas de imageamento da faixa dos terahertz para a detecção de armas e outros contrabandos.

Estudo confirma: ameríndios descendem do mesmo grupo étnico

Universidade da Califórnia em Davis

|

|

| Uma distinta assintaura de DNA foi encontrada em todas, menos uma, as populações indicadas nos pontos 32 a 53 neste mapa. (A tribo Fox, ponto 48, foi a exceção. Mas somente duas amostras do DNA do povo Fox foram testadas, poucas demais para um resultado válido). A assinatura estava ausente de todos os grupos asiáticos amostrados, pontos 1-32. (Kari Britt Schroeder/UC Davis) |

Por duas décadas, os pesquisadores vêm usando um volume crescente de dados genéticos para alimentar o debate sobre se os ancestrais dos ameríndios emigraram para o Novo Mundo em uma onda só, ou em ondas sucessivas, ou se são originários de uma população asiática ancestral ou de várias delas.

Agora, após comparar cuidadosamente amostras de DNA de povos em dúzias de grupos de ameríndios e eurasianos dos dias atuais, uma equipe internacional de cientistas acredita que pode trazer uma resposta definitiva. Quase que sem exceções, os novos indícios apoiam a teoria de uma única população ancestral.

A autora principal do artigo que relata o estudo, Kari Britt Schroeder, da Universidade da Califórnia em Davis, declarou: “Nosso trabalho fornece fortes indícios de que, em geral, os ameríndios são mais aparentados entre si do que com qualquer outra população asiática existente, com a exceção daquelas que residem bem na margem do Estreito de Bering”.

“Embora estudos anteriores já apoiassem essa conclusão, a diferença é que nosso trabalho apresenta os primeiros dados confiáveis que não podem ser reconciliados com a hipótese de muitas populações ancestrais”, explica Schroeder, que realizou a pesquisa quando estudava para o grau de Ph.D. em antropologia na Universidade.

O estudo será publicado na edição de maio da revista Molecular Biology and Evolution.

O trabalho da equipe prossegue outros estudos anteriores, realizados por vários de seus membros, que encontraram uma variante única (um alelo) de um marcador genético no DNA dos atuais ameríndios. Chamado de “alelo 9-repeat”, a variante (que não tem função biológica) estava presente em todas as 41 populações pesquisadas, desde o Alaska até o extremo Sul do Chile, bem como nos Inuit da Groenlândia e os povos Chukchi e Koryak do lado asiático (Oeste) do Estreito de Bering. No entanto, este alelo estava ausente em todos os 54 grupos de eurasianos, africanos e da Oceania estudados.

No total, dentre os 908 povos pertencentes aos 44 grupos onde o alelo foi encontrado, mais de um em cada três tinha essa variante.

Nos estudos anteriores, os pesquisadores concluiram que a explicação mais plausível para a distribuição do aleo “9-repeat” era que todos os ameríndios, groenlandeses e beringuianos do Oeste fossem descendentes de uma população ancestral comum. Além disso, o fato de que esse alelo estava ausente em outras populações asiáticas, provavelmente significava que os antepassados dos ameríndios ficaram isolados do resto da Ásia por milhares de anos, antes de se mudarem para o Novo Mundo; ou seja: por um período de tempo suficientemente grande para que o alelo surgisse e se espalhasse pela população isolada.

Embora os indícios fossem muito fortes, não eram, entretanto, a toda prova. Havia duas outras explicações plausíveis para a grande difusão do alelo pelas Américas.

Se o alelo “9-repeat” tivesse surgido como uma mutação diversas vezes, sua presença através das Américas não indicaria uma ancestralidade comum. Por outro lado, se houvesse dois ou mais grupos ancestrais diferentes e somente um deles portasse o alelo “9-repeat”, certas circunstências poderiam ter feito com que esse tivesse se misturado ao outro grupo e se tornasse difundido. Digamos que existisse um segundo alelo — um situado bem próximo do alelo “9-repeat” na cadeia do DNA — que conferisse uma forte vantagem para os humanos que o tivessem. A seleção natural levaria esse alelo para novas populações e, por causa dos mecanismos de herança genética, grandes pedaços da cadeia de DNA em torno dele, inclusive o alelo inoperante “9-repeat”, seriam levados em conjunto com o alelo benéfico.

Para eliminar essas possiblidades, a equipe de pesquisa, chefiada por Noah Rosenberg da Universidade de Michigan, escrutinou amostras de DNA de pessoas de 31 populações asiáticas. 19 de ameríndios, uma groenlandesa e duas beringuianas do Oeste, todas atuais.

Eles descobriram que em cada amostra que continha o alelo “9-repeat”, pequenos pedaços de DNA de cada lado dele eram caracterizados por um padrão distinto de pares básicos, um padrão que eles raramente observaram em pessoas sem o alelo. “Se a seleção natural tivesse promovido a disseminação de um alelo vizinho vantajoso, nós poderíamos esperar encontrar pedaços maiores de DNA do que esse com o padrão distinto”, explica Schroeder. “E também deveríamos ver um padrão com alta frequencia, mesmo entre pessoas que não são portadoras do alelo ‘9-repeat”. De forma que podemos considerar a possibilidade de seleção positiva improvável”.

Os resultados também descartaram a hipótese de muitas migrações. Se fosse esse o caso, haveriam milhares de padrões de DNA diferentes em torno do alelo, em lugar da “assinatura” característica descoberta pela equipe.

“Existem vários artigos bem fundamentados, com base no DNA mitocondrial — transmitido de mãe para filha — e DNA de cromossomo-Y — transmitido de pai para filho — que também apoiavam a tese de uma única população ancestral”, concede Schroeder. “Porém, este é o primeiro indício definitivo que temos e que vem do DNA de ambos os sexos”.

Os demais autores do estudo são: David G. Smith, professor de antropologia na UC Davis; Mattias Jacobsson, Universidade de Michigan e Universidade de Uppsala na Suécia; Michael H. Crawford, Universidade de Kansas; Theodore Schurr, Universidade da Pennsylvania; Simina Boca, Universidade Johns

Hopkins; Donald F. Conrad e Jonathan Pritchard, Universidade de Chicago; Raul Tito e Ripan Malhi, Universiade de Illinois,

Urbana-Champaign; Ludmilla Osipova, Academia Russa de Ciências,

Novosibirsk; Larissa Tarskaia, Academia Russa de Ciências, Moscou;

Sergey Zhadanov, Universidade de Pennsylvania e Academia Russa de Ciências, Novosibirsk; e Jeffrey D. Wall, Uinversidade da Califórnia em San Francisco.

Sedimentos do fundo do mar revelam 53 milhões de anos da história do clima

![]()

Press Release 09-089 Sea-floor Sediments Illuminate 53 Million Years of Climate History

![]()

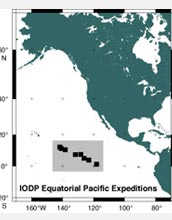

Navio-sonda JOIDES Resolution completa a primeira expedição como navio remodelado

|

Duas expedições consecutivas de perfuração do leito oceânico estudarão os sedimentos do fundo do mar e mudanças climáticas. |

1 de maio de 2009

O navio-sonda JOIDES Resolution

do Programa Integrado de Sondagem do Oceano (Integrated Ocean Drilling Program = IODP) está retornando ao porto em Honolulu nesta semana após uma viagem de dois meses para cartografar uma história detalhada do Oceano Pacífico Equatorial. A expedição foi a primeira de duas viagens sucessivas de um projeto chamado Transecto Cronológico do Pacífico Equatorial (Pacific Equatorial Age Transect = PEAT). Foi a primeira expedição científica internacional de sondagem depois que o JOIDES Resolution passou por uma reforma que durou vários anos, para transformá-lo em um laboratório científico flutuante do século XXI.

As expedições do PEAT estão recolhendo uma série de registros históricos de sedimentos em várias localizações geográficas diferentes sob o Oceano Pacífico Equatorial. O primeiro esforço de pesquisa, intitulado Expedição 320, teve lugar de 5 de março a 4 de maio de 2009; a Expedição 321 acontecerá de 5 de maio a 5 de julho de 2009.

A parte científica da Expedição 320 foi co-chefiada por Heiko Palike da Universidade de Southampton, Reino Unido, e Hiroshi Nishi da Universidade de Hokkaido, no Japão. Na Expedição 320, os cientista obtiveram registros que remontam desde a época presente até o mais quente dos períodos de “estufa” na Terra, que aconteceu em torno de 53 milhões de anos atrás.

Os estudos realizados ainda a bordo revelaram que as mudanças na acidificação do oceano ligadas às mudanças climáticas têm um impacto grande e global sobre os organismos marinhos.

“Os sedimentos coletados durante esta expedição proporcionam um vislumbre sem precedentes sobre a evolução do Pacífico tropical, uma das regiões oceânicas maiores e mais importantes em termos climáticos na Terra”, declarou Julie Morris, diretora da Divisão de Ciências Oceânicas da Fundação Nacional de Ciências (NSF).

“Ao focalizar um período que inclui alguns dos melhores similares para bruscas mudanças no clima, eventos climáticos extremos, acidificação do oceano e mundos ‘estufa’, os resultados nos dão perspectivas acerca dos impactos em potencial vindos de mudanças climáticas futuras”.

As mudanças ambientais ficam registradas nas conchas de pequenos micro-fósseis que constituem os sedimentos do mar profundo.

“Nós podemos usar os micro-fósseis e as camadas desse ‘arquivo’ sedimentar como referência para medir a idade geológica”, declarou Hiroshi Nishi.

“Isso nos permitirá estabelecer os ritmos de mudanças ambientais, tais como a primeira expansão rápida das calotas polares na Antártica, a 33,8 milhões de anos. Esse processo polar tem um impacto profundo sobre o fitoplâncton até no Equador”.

“Conseguimos retirar vários registros dessa importante transição climática”.

Heiko Pälike declarou que “é realmente notável ver 53 milhões de anos de história serem trazidos à superfície sobre o convés do navio-sonda, passados por nossas mãos e passarem adiante. Nós vimos em primeira-mão os efeitos da máquina climática da Terra em ação”.

Para a subsequente Expedição 321, os co-chefes científicos serão Mitch Lyle da Universidade Texas A&M, dos EUA, e Isabella Raffi da Universita “G. D’Annunzio” da Itália.

Pás de turbina “inteligentes” para aumentar a energia eólica

|

|

||||

WEST LAFAYETTE, Indiana – Pesquisadores desenvolveram uma nova técnica que emprega sensores e software para monitorar constantemente as forças incidentes sobre as pás das turbinas eólicas, um passo para o aumento da eficiência por meio da rápida adaptação às condições dos ventos constantemente variáveis.

A pesquisa, realizada por engenheiros da Universidade Purdue e do Laboratório Nacional Sandia faz parte de um esforço para o desenvolvimento de uma estrutura mais versátil de turbina eólica.

“A meta maior é alimentar um sistema de controle ativo com dados vindos de sensores para ajustar os componentes de forma a otimizar a eficiência”, diz o estudante de pós-doutorado Jonathan White, da Purdue, que está conduzindo a pesquisa em conjunto com Douglas Adams, um professor de engenharia mecânica e diretor do Centro de Integridade de Sistemas da Purdue.

O sistema também pode ajudar a melhorar a confiabilidade das turbinas eólicas, alimentando o sistema de controle com informações em tempo-real, de forma a impedir danos catastróficos causados por ventos fortes incidentes.

“A energia eólica tem um papel cada vez mais importante para a geração de energia elétrica”, diz Adams. “Os Estados Unidos são, agora, o maior usuário de energia eólica no mundo. A questão é: o que pode ser feito para as turbinas eólicas que as tornem mais eficientes, mais econômicas e mais confiáveis?”

Os engenheiros instalaram sensores – chamados acelerômetros uniaxial e triaxial – no interior de uma pá de turbina, durante sua construção. A pá está agora sendo testada em uma turbina eólica de pesquisa no laboratório do Serviço de Pesquisas do Departamento de Agricultura dos EUA em Bushland,

Texas. Pessoal do Sandia e do Departamento de Agricultura operam as turbinas de pesquisa nessa instalação no Texas.

Esses sensores podem ser funcionais em futuras pás de turbina que tenha, “superfícies de controle” e flapes simples como os das asas dos aviões para modificar as características aerodinâmicas das pás para um melhor controle. Uma vez que esses flapes teriam que ser acionados em tempo-real para responder às mudanças no regime de ventos, dados constantes vindos de sensores serão críticos.

“Este é um exemplo perfeito de parceria entre um Laboratório Nacional e uma instituição acadêmica para o desenvolvimento de inovações, usando os conhecimentos de ambos para alavancar as pesquisas”, declarou Jose R.

Zayas, gerente do Departamento de Tecnologia de Energia Eólica do Sandia.

As descobertas da pesquisa mostram que o emprego de um trio de sensores e o software de controle desenvolvido por White, revelam com precisão quanta força está sendo aplicada nas pás. Purdue e Sandia registraram uma patente provisória da técnica.

As descobertas são detalhadas em um artigo que será publicado em 4 de maio, durante a Conferência & Exibição de Energia Eólica 2009 em Chicago. O artigo foi redigido por White, Adams e os engenheiros do Sandia, Mark A. Rumsey e Zayas. A conferência de 4 dias, organizada pela Associação Americana de Energia Eólica, atrai milhares de participantes e é dirigida principalmente às indústrias.

“A indústria está muito interessada em identificar as cargas, ou forças, exercidas sobre as pás das turbinas e predizer a fadiga, e esse trabalho é um passo no sentido de conseguir isto”, disse White.

Os principais componentes de uma turbina eólica incluem as pás giratórias, uma caixa de engrenagens e o gerador. As pás de turbina eólica são feitas principalmente de fibra de vidro e madeira balsa, e são, ocasionalmente, enrijecidas com fibra de carbono.

“A meta é que o gerador e a turbina funcionem do modo mais eficiente, porém isso é difícil porque a velocidade do vento é flutuante”, explica Adams. “O desejável é ser capaz de controlar o gerador ou o passo das pás para otimizar a captura da energia, reduzindo os esforços sobre os componentes da turbina eólica durante ventos excessivamente fortes e aumentar essas cargas durante ventos fracos. Além de aumentar a eficiência, isso deve ajudar a aumentar a confiabilidade As torres das turbinas eólicas podem ter 60 metros ou mais de altura, de forma que a manutenção e a reparação de componentes danificados são muito caras”.

Sonda MESSENGER descobre um Mercúrio mais ativo que o esperado

[MESSENGER Spacecraft Reveals a Very Dynamic Planet Mercury]

WASHINGTON

— Uma sonda da NASA que sobrevoou a superfície de Mercúrio, revelou que a atmosfera do planeta, a interação de seu campo magnético com o vento solar e seu passado geológico mostram um nível de atividade muito maior do que os cientistas suspeitavam até agora. A mesma sonda descobriu também uma grande cratera de impacto, até então desconhecida, com cerca de 690 km de diâmetro — a mesma distância de Washington a Boston.

As análises dessas novas descobertas e mais, são relatadas em quatro artigos publicados na edição de 1 de maio da revista Science. Os dados vêm da espaçonave MErcury Surface, Space ENvironment, GEochemistry and Ranging = MESSENGER (Superfície, Ambiente Espacial, Geoquímica e Plotagem de Mercúrio). Em 6 de outubro de 2008, a sonda sobrevoou Mercúrio pela segunda vez, captando mais de 1.200 imagens coloridas em alta definição do planeta. A sonda revelou outros 30% da superfície do planeta que nunca tinham sido avistados por qualquer espaçonave anterior, coletando dados essenciais para o planejamento do restante da missão.

Sean Solomon, da Instituição Carnegie de Washington, o principal investigador dessa missão, disse: “Este segundo sobrevoo de Mercúrio nos proporcionou uma série de descobertas. Uma das maiores surpresas foi a variação da dinâmica da interação do campo magnético do planta com o vento solar, comaparada à observada no primeiro sobrevoo de Mercúrio em janeiro de 2008. A descoberta de uma bacia de impacto grande e surpreendentemente bem conservada mostra uma atividade vulcânica concentrada e atividade tectônica”.

A espaçonave também detectou, pela primeira vez, a presença de magnésio na fina atmosfera de Mercúrio, conhecida como uma exosfera. Esta observação e outros dados confirmam que o magnésio é um componente importante dos materiais da superfície de Mercúrio.

O instrumento Espectrômetro de Composição da Atmosfera e Superfície de Mercúrio na sonda, detectou o magnésio. A descoberta de magnésio não foi surpreendente para os cientistas, mas a quantidade e a distribuição eram bem maiores que o esperado. O mesmo instrumento também mediu outros componentes da exosfera, inclusive cálcio e sódio.

“Isto é um exemplo do tipo de descobertas individuais que a equipe de ciências vai reunir para nos dar um novo quadro sobre como o planeta se formou e evoluiu”, declarou William McClintock, co-investigador e autor principal de um dos quatro artigos. McClintock, que é do Laboratório de Física Atmosférica e Espacial da Universidade de Colorado em Boulder, suspeita que outros elementos metálicos da superfície, incluindo alumínio, ferro e silício, também contribuem para a exosfera.

A variabilidade que a espaçonave observou na magnetosfera de Mercúrio, o volume de espaço dominado pelo campo magnético do planeta, até agora apoia a hipótese de que as grandes mudanças diárias na atmosfera de Mercúrio podem ser resultantes de modificações na blindagem proporcionada pela magnetosfera.

“A espaçonave observou uma magnetosfera radicalmente diferente em Mercúrio durante o segundo sobrevoo, em comparação com o prévio encontro em 14 de janeiro”, declarou James Slavin do Centro de Voo Espacial Goddard da NASA em Greenbelt,

Maryland. Slavin é também um co-investigador na missão e autor principal de um dos artigos. “Durante o primeiro sobrevoo, foram realizadas importantes descobertas, porém os cientistas não detectaram quaisquer características dinâmicas. O segundo sobrevoo testemunhou uma situação completamente diferente”.

A descoberta da bacia de impacto, chamada de Rembrandt, marca a primeira vez que os cientistas observam o solo bem exposto em uma grande bacia de impacto em Mercúrio. As formações do solo, tais como essas reveladas no chão de Rembrandt, usualmente ficam cobertas por fluxos vulcânicos.

“Essa bacia se formou a cerca de 3,9 bilhões de anos, perto do fim do período de bombardeamento pesado no sistema solar interior”, explicou Thomas

Watters do Instituto Smithsonian em Washington, um dos cientistas participantes e autor principal de um dos artigos. “Embora antiga, a bacia Rembrandt é mais jovem do que a maioria das outras bacias de impacto conhecidas em Mercúrio”.

Metade de Mercúrio era desconhecida até pouco mais de um ano atrás. Os globos que representavam o planeta ficavam com um lado em branco. As imagens colhidas por espaço- naves permitiram que os cientistas vissem 90% da superfície do planeta em alta definição. A nova cobertura por imagens da superfície, após esse segundo sobrevoo, permite aos cientistas uma nova compreensão de como a crosta do planeta se formou.

“Depois de mapear a superfície, vemos que aproximadamente 40% é coberta por planícies suaves”, disse Brett Denevi da Universidade do Estado do Arizona em Tempe, membro da equipe e autor principal de um dos artigos. “Muitas dessas planícies suaves são tidas como sendo de origem vulcânica e ficam distribuídas por todo o planeta. Grande parte da crosta de Mercúrio pode ter-se formado através de repetidas erupções vulcânicas de modo muito mais semelhante à crosta de Marte do que à da Lua”.

Os cientistas continuam a examinar os dados dos dois primeiros sobrevoos e estão se preparando para recolher mais informações de um terceiro sobrevoo em 29 de setembro.

“O terceiro sobrevoo de Mercúrio é o ensaio geral final para o principal ato de nossa missão: a colocação da sonda na órbita de Mercúrio no entorno de março de 2011”, disse Solomon. “A fase orbital será como se realizássemos dois sobrevoos por dia e permitirá a coleta contínua de informações acerca do planeta e seu ambiente por um ano. Mercúrio tem-se mos- trado tímido em revelar seus segredos até agora, mas em menos de dois anos o planeta mais interior terá se tornado um velho conhecido”.

O projeto MESSENGER é o sétimo do Programa Discovery da NASA de missões científicas de baixo custo. O Laboratório de Física Aplicada da Universidade Johns Hopkins em Laurel, Maryland., projetou, construiu e opera a espaçonave e gerencia a missão para o Diretório de Missões Científicas da NASA em Washington. Os instrumentos científicos fo- ram construídos pelo Laboratório de Física Aplicada; Centro Goddard; Universidade de Michigan em Ann Arbor;e Universidade do Colorado em Boulder. GenCorp Aerojet de Sacramento, Califórnia e Composite Optics Inc. de San Diego forneceram o sistema de propulsão e a estrutura composta.

Gripe suína H1N1: algumas dicas

Eu tentei me manter afastado do assunto, uma vez que não sou médico, nem biólogo, muito menos versado em saúde pública. Mas, na qualidade de cidadão interessado — e preocupado, já que não sou diferente de ninguém — e como tenho acompanhado tanto o noticiário na grande mídia, como fontes mais – digamos – “especializadas” (blogs de ciências e noticiário direto do Centers for Disease Control and Prevention = CDC), me sinto no direito de dar meus palpites sobre essa ameaça de pandemia.

Essa gripe vai chegar ao Brasil?

Provavelmente, sim! Aliás, eu me arriscaria a dizer que “com certeza, sim!” Vigiar portos e aeroportos é muito bom e uma providência indispensável. Mas não é suficiente… O Brasil tem uma enorme (e pouquíssimo vigiada) “fronteira seca” com todos os países hispânicos da América do Sul, à excessão de Chile e Equador. Por mais que se vigie os portos e areoportos, mais cedo ou mais tarde essa epidemia acaba entrando pelo interior de um desses países que, sem demérito implícito algum, têm muito menos recursos de saúde pública que o Brasil.

O governo pode tomar alguma providência para impedir?

Claro que não! Os Estados Unidos não puderam evitar que cruzasse a fornteira do Rio Grande, muito menos o governo brasileiro poderá evitar…

Já que não dá para impedir, dá para reduzir os efeitos?

Dar, dá… E, pelo que eu vejo, as providências cabíveis já estão sendo tomadas. O maior problema é que os dados disponíveis sobre a doença ainda são poucos, e as tais “providências cabíveis” são muito genéricas: vigiar portos e aeroportos, isolar casos suspeitos, aumentar os estoques de medicação, mobilizar os recursos da saúde pública, entre outras.

E essas providências serão suficientes?

A resposta mais honesta é: “Ninguém sabe!” Na verdade, sempre que há uma pandemia, depois que ela passa, fica muito fácil descobrir o que poderia ter sido feito, mas não foi… A julgar pelos dados mais recentes, a situação parece sob controle. Desde que o alerta foi emitido, o mundo registrou vários casos isolados em (até agora) 17 países. O lugar onde apareceu o maior número de infectados foi em Nova York, com 50 casos registrados e nenhuma morte até agora.

Os dados iniciais vindos do México — que falam de óbitos de 1 em cada 10 casos — ainda não estão confirmados oficialmente. Isso quer dizer que podem estar acontecendo três coisas, isoladamente ou em conjunto:

1. Nem todos os casos de gripe H1N1 no México foram registrados. Pode ter havido um número bem maior de casos (o governo mexicano só informou oficialmente à OMS 26 casos com 7 mortes). Os jornais falam de milhares de casos e dezenas de mortes.

2. A população atingida no México pode ser mais vulnerável do que a média mundial. É um dado que, se for verdadeiro, vai demorar muito para aparecer, se é que um dia vai…

3. A contaminação direta, dos porcos para as pessoas, é muito mais letal do que aquela de pessoa para pessoa. Antes que alguém pense que eu pirei, é só lembrar do vírus H5N1 aviário: mortal quando transmitido das aves para as pessoas, mas nem chegou a se tornar transmissível de pessoa a pessoa; faltou uma mutação… Talvez a mutação que torna esse H1N1 transmissível de pessoa a pessoa, enfraqueça o vírus de alguma forma.

Mas esse vírus não é igual ao da “Gripe Espanhola”?

Não! Ele é do mesmo tipo, H1N1, mas não é o mesmo. Este atual parece ser um cruzamento de duas espécies “suínas”, mais uma “aviária”, parentes da “Espanhola”. E é sempre bom lembrar: não estamos mais no primeiro quartel do século XX — os recursos de saúde pública são muito melhores agora, inclusive e principalmente a comunicação! Tanto que a OMS emitiu uma alerta fase 5, antes que a gripe matasse alguém fora do México!

Que providências cada brasileiro deve tomar agora para se proteger?

Em primeiro lugar, não vá ao México! Se for possível, evite qualquer outro país onde foi relatado um caso. Mas se lembre que, por exemplo, foram relatados dois casos em Israel. E, se você tiver que ir a Israel, corre muito mais risco de ser detonado por um homem-bomba do que de pegar a gripe suína… Então, nada de frescura!

No caso de (ou seja: quando) a gripe chegar ao Brasil, com força de epidemia (é sempre bom lembrar), as precauções são as mesmas para qualquer gripe… Desta vez, as precauções vão ser mais levadas a sério, por conta da gravidade das consequências.

Não enriqueça desnecessariamente o dono da farmácia! Não saia comprando um lote de Tamiflu (“que nada!… Esse aqui é muito melhor e sai pela metade do preço!” — e tome um encalhe!…), não faça um estoque de máscaras, daquelas “de hospital”, nem se tranque em casa com medo. Se a situação ficar realmente grave, o governo vai divulgar as providências que devem ser tomadas. (para os que “não confiam no governo”: “eles” são quem mais sofre — no bolso! — os efeitos de uma pandemia).

E se lembre: quando for para entrar em pânico, pode deixar que eu aviso! (A internet funciona de qualquer lugar do mundo… só que o vírus também…)

Atualizando em 1 de maio:

O Ministro da Saúde concorda comigo em duas coisas: a gripe vai chegar ao Brasil; e que é besteira sair fazendo estoques de medicamentos e máscaras (essas máscaras vendidas na farmácia não protegem você: protegem os outros de seus perdigotos…) Vide notícia do G-1: Temporão diz que chegada de vírus é inevitável, mas sem motivo para pânico.